Fiziksel AI sistemlerinin gelişimiyle birlikte, zengin etiketlenmiş veri setlerine olan talep, gerçek dünyada manuel olarak elde edebileceğimizin ötesine geçiyor. Dünya Temel Modelleri (WFM’ler), gerçek dünya ortamlarının dinamiklerine dayanarak gelecekteki dünya durumlarını simüle etme, tahmin etme ve akıl yürütme yeteneğine sahip olan üretken AI modelleridir. Bu gelişmeler, veri zorluğunun üstesinden gelmemize yardımcı olabilir.

NVIDIA Cosmos, fiziksel AI için WFM geliştirme platformudur ve robotik ile otonom araçlar gibi uygulamalara yöneliktir. Cosmos WFMs, belirli uygulamalar için yeniden eğitim edilebilen üç model türü içerir: Cosmos Predict, Cosmos Transfer ve Cosmos Reason.

Cosmos Predict, görüntü, video ve metin istemlerinden “gelecek dünya durumlarını” video olarak üretirken, Cosmos Transfer 2D girdilerden ve metin istemlerinden fotorealist stil transferleri yapılmasını sağlar. Cosmos Reason, üretilen veriyi düzenleyip etiketleyebilen bir akıl yürütme modelidir ve ayrıca robot görme-dil-eğilim (VLA) modeli olarak işlev görmek için yeniden eğitim edilebilir. Bu veriler, fiziksel AI ve endüstriyel görme AI’sını uzamsal farkındalık, hareket yoluyla planlama ve karmaşık görevler gerçekleştirme için eğitmek amacıyla kullanılır.

Cosmos WFMs ve Çalışma Akışları

Bu yazı, NVIDIA Robotics Research and Development Digest (R2D2) kapsamında Cosmos WFMs ve çalışma akışlarını inceleyerek sentetik veri üretimi (SDG) ve fiziksel AI uygulamaları için veri düzenlemede önemli bir rol oynadığını vurgulamaktadır:

- Cosmos Predict

- Otonom araçlar için Single2MultiView

- Cosmos-Drive-Dreams

- NVIDIA Isaac GR00T-Dreams

- DiffusionRenderer

- Hızlandırılmış video üretimi

- Cosmos Transfer

- Otonom araçlar için Cosmos Transfer

- Kenarda model damıtma

- Cosmos Reason

Cosmos Predict: Gelecek Simülasyon Modelleri

Cosmos Predict modelleri, fiziksel AI uygulamaları için yeniden eğitim edilebilir. Girdi olarak metin, görüntü veya video alarak tutarlı ve fiziksel olarak doğru gelecek kareler üretir. Bu, karmaşık fiziksel görevler gerçekleştirecek AI modellerinin eğitimini hızlandırmada yardımcı olur. İşte bazı yeniden eğitim örnekleri.

Cosmos Predict Yeniden Eğitim Uygulamaları

Single2MultiView, yalnızca bir ön gözü olan otonom bir sürüş videosundan çoklu, tutarlı kamera perspektifleri üretir. Sonuç olarak, otonom araç (AV) geliştirme için senkronize çoklu görünüm kamera görüntüleri sağlar.

Tek görünüm girişi ile yapılan bir çıkarım örneği:

CUDA_HOME=$CONDA_PREFIX PYTHONPATH=$(pwd) python cosmos_predict1/diffusion/inference/video2world_view_extend_multiview.py

--checkpoint_dir checkpoints

--diffusion_transformer_dir

Cosmos-Predict1-7B-Video2World-Sample-AV-Single2MultiView/t2w_model.pt

--view_condition_video assets/diffusion/sv2mv_input_view.mp4

--num_input_frames 1

--condition_location "first_cam"

--prompt "${PROMPT}"

--prompt_left "${PROMPT_LEFT}"

--prompt_right "${PROMPT_RIGHT}"

--prompt_back "${PROMPT_BACK}"

--prompt_back_left "${PROMPT_BACK_LEFT}"

--prompt_back_right "${PROMPT_BACK_RIGHT}"

--video_save_name diffusion-single2multiview

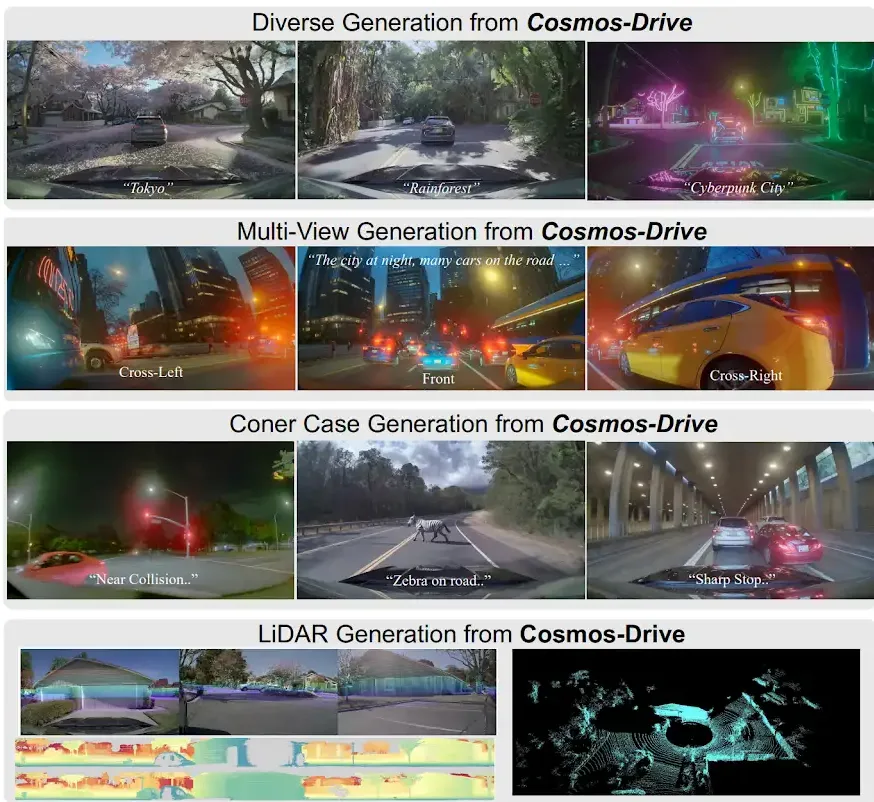

- Cosmos-Drive-Dreams, otonom araçlar için zorlu sürüş koşulları yaratmayı amaçlayan bir çalışma akışıdır. Cosmos Drive modelleri, sürüş verilerini çoklu görünüm, yüksek doğruluklu ve spatiotemporally tutarlı bir şekilde üretmek için yeniden eğitim edilmiştir. Üretilen çoklu görünüm verileri, 3D şerit algılama, 3D nesne algılama ve sürüş politika öğrenimi gibi görevler için odaklanmayı artırmak üzere yeniden eğitim edilen Cosmos Transfer modeli ile zenginleştirilmiştir.

- Isaac GR00T-Dreams, büyük ölçekli sentetik trajektori veri üretimi için bir plan olarak geliştirilmiştir. GR00T-Dreams, robotların görevler gerçekleştirdiği çeşitli, fotorealist videolar oluşturur. Bunu, görsel ve metin istemlerinden verileri kullanarak yapar ve robot politikaları için eğitim amacıyla eylem verisi, yani sinirsel trajektöriler çıkarır. Bu, robotların yeni beceriler öğrenmesine ve farklı ortamlara insan müdahalesi olmadan uyum sağlamasına yardımcı olur.

GR00T üzerinde GR1 verisi ile yapılan yeniden eğitim örneği:

EXP=predict2_video2world_training_2b_groot_gr1_480

torchrun --nproc_per_node=8 --master_port=12341 -m scripts.train --config=cosmos_predict2/configs/base/config.py -- experiment=${EXP}

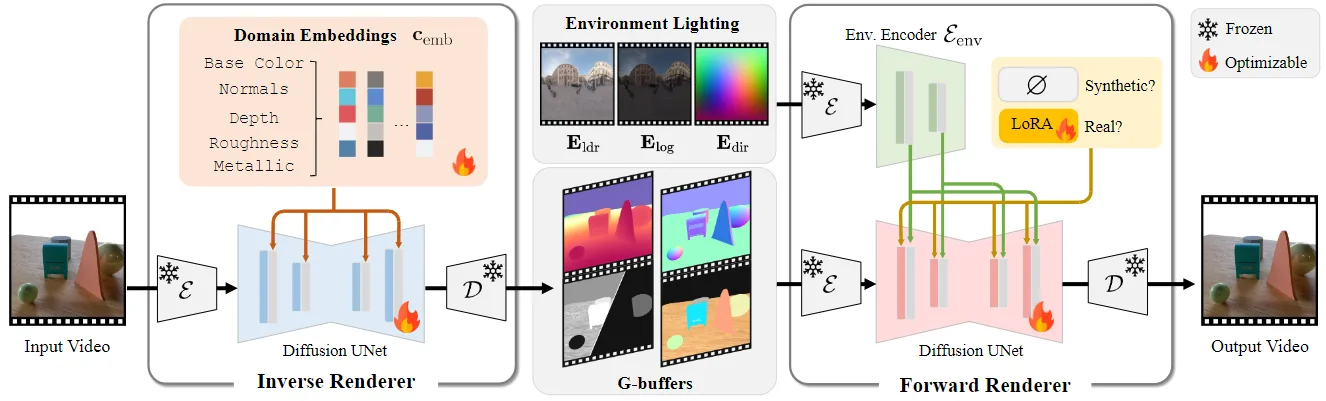

- DiffusionRenderer, fotorealist yeniden aydınlatma, malzeme düzenleme ve nesne ekleme gibi işlemleri bir video girdisinden, açık 3D geometri ya da aydınlatma verisi gerektirmeden gerçekleştiren bir çerçevedir. Video yayılma modellerini kullanarak sahne özelliklerini tahmin edip gerçekçi yeni görüntüler üretir. Cosmos Predict’in yayılma modelini kullanarak DiffusionRenderer’ın aydınlatma kabiliyetinin kalitesi artırılmıştır; bu, fiziksel AI simülasyonları için sahne düzenlemesini daha verimli ve kontrollü hale getirir.

Video yenileme için örnek bir komut. Bu, ters renderer’den alınan çerçevelere yeni aydınlatma uygulayarak yeniden aydınlatılmış video çerçeveleri üretir:

CUDA_HOME=$CONDA_PREFIX PYTHONPATH=$(pwd) python cosmos_predict1/diffusion/inference/inference_forward_renderer.py

--checkpoint_dir checkpoints

--diffusion_transformer_dir Diffusion_Renderer_Forward_Cosmos_7B

--dataset_path=asset/example_results/video_delighting/gbuffer_frames

--num_video_frames 57

--envlight_ind 0 1 2 3

--use_custom_envmap=True

--video_save_folder=asset/example_results/video_relighting/

- Hızlandırılmış video üretimi Cosmos-Predict2, artık Neighborhood Attention (NATTEN) kullanıyor ve inceleme süresini önemli ölçüde azaltıyor. Bu dikkat sistemi, küme adaptif olup parçalar arasında gerekli olan tüm alanlara odaklanır. NATTEN’ın verimliliği ayrıca NVIDIA donanımına özgü optimize edilmiş arka uç kodu ile artırılmıştır. Bu sebeple, video çıkarımı, NVIDIA H100 ve NVIDIA B200 gibi yüksek performanslı GPU’lar üzerinde 2 ila 2.5 kat daha hızlı hale gelmiştir.

Cosmos Transfer: Kontrol Edilen Sentetik Veri Üretimi

Cosmos Transfer, farklı kontrol girdi türlerine dayalı olarak dünya simülasyonları üreten modellerdir. Segmentasyon haritaları, derinlik, kenar haritaları, lidar taramaları, anahtar noktalar ve HD haritalar gibi çeşitli modaliteler kullanılarak sahne bileşimi kontrol edilebilir. Amaç, büyük görsel çeşitlilik ile sentetik veri setlerini zenginleştirmek ve robotik ve otonom sürüş uygulamalarında genel sim-to-real transferini geliştirmektir.

Cosmos Transfer Uygulamaları

Şimdi, Cosmos Transfer kullanan bazı çalışma akışlarına bakalım:

- Otonom Araçlar için Cosmos Transfer, tek bir sürüş senaryosundan yeni koşullar, hava durumu, aydınlatma ve zemin gibi alternatifler üretir. Farklı metin istemlerini kullanarak veri varyasyonunu artırır; bu, AV eğitim veri setlerini oluştururken faydalıdır.

RGB video üretmek için Cosmos Transfer kullanarak bir örnek komut:

export CUDA_VISIBLE_DEVICES="${CUDA_VISIBLE_DEVICES:=0}"

export CHECKPOINT_DIR="${CHECKPOINT_DIR:=./checkpoints}"

export NUM_GPU="${NUM_GPU:=1}"

PYTHONPATH=$(pwd) torchrun --nproc_per_node=$NUM_GPU --nnodes=1 --node_rank=0 cosmos_transfer1/diffusion/inference/transfer.py

--checkpoint_dir $CHECKPOINT_DIR

--video_save_folder outputs/example1_single_control_edge_distilled

--controlnet_specs assets/inference_cosmos_transfer1_single_control_edge.json

--offload_text_encoder_model

--offload_guardrail_models

--num_gpus $NUM_GPU

--use_distilled

- Kenarda model damıtma Cosmos Transfer versiyonunun iyileştirilmiş bir versiyonudur. Orijinal modelin video üretmesi için gereken 70 geçiş, büyük hesaplama maliyetlerine yol açıyordu. Kenar modalitesi için damıtılmış daha küçük bir model, aynı görevi tek bir adımda, orijinal modelin kalitesini yakalayarak yerine getirmektedir. Diğer kontrol modaliteleri de benzer şekilde damıtılabilir, bu da daha hızlı ve daha uygun maliyetli bir video üretimi sağlar.

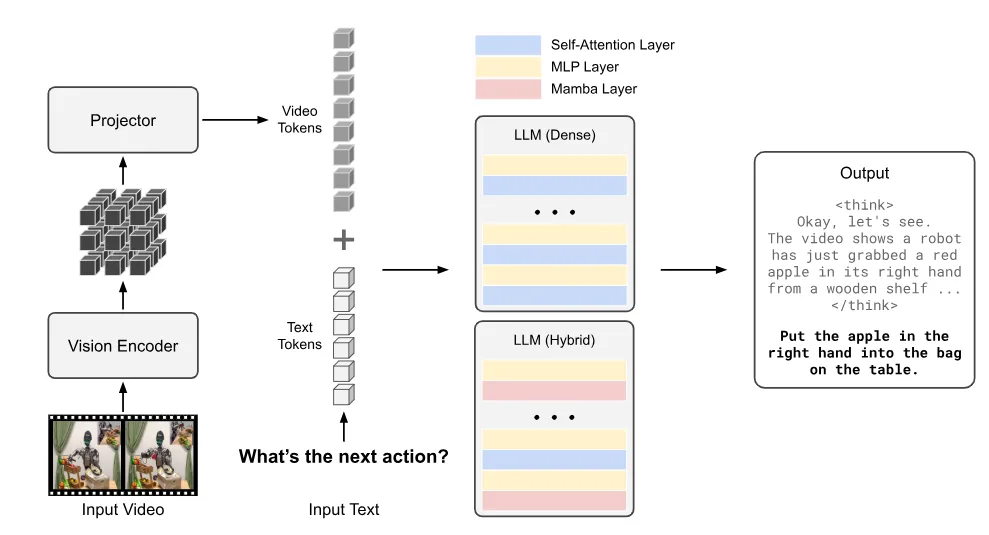

Cosmos Reason: Uzun Süreli Akıl Yürütme

Cosmos Reason, fiziksel AI için akıl yürütme üzerine odaklanmış bir dünya temeli modelidir. Fiziksel mantığı anlar ve uzun düşünce zincirleriyle uygun eylemler üretir. Bu, SDG esnasında yüksek kaliteli eğitim verisi oluşturmak için kullanılır; çünkü Cosmos Reason, hareket dizilerini ve gerçek dünya kısıtlamalarını anlamaktadır. Model, iki aşamada eğitim almıştır: denetimli ince ayar (SFT) ve güçlendirme öğrenimi.

SFT eğitimi, Reason modelinin belirli görevlerdeki performansını geliştirebilir. Örneğin, robovqa veri seti ile eğitim almak, robotik görsel soru cevaplama görevlerinde performansı artırabilir. İşte SFT eğitimini başlatmak için örnek bir komut:

cosmos-rl --config configs/cosmos-reason1-7b-fsdp2-sft.toml

./tools/dataset/cosmos_sft.py

Nasıl Başlanır?

Aşağıdaki kaynakları inceleyerek daha fazla bilgi edinebilirsiniz:

- Cosmos Predict2: Proje Web Sitesi, GitHub, Hugging Face, Makale

- Cosmos Transfer1: Proje Web Sitesi, GitHub, Hugging Face, Makale

- Cosmos Reason1: Proje Web Sitesi, GitHub, Hugging Face, Makale

- Isaac GR00T-Dreams: GitHub, Makale

- Cosmos-Drive-Dreams: Proje Web Sitesi, GitHub, Makale, Veri Seti

- DiffusionRenderer: Proje Web Sitesi, GitHub, Makale, Hugging Face

NVIDIA SIGGRAPH 2025 etkinliğinde, dünya temel modelleri ile ilgili en son gelişmeleri deneyimleme fırsatını kaçırmayın:

- Pazartesi, 11 Ağustos’ta, NVIDIA AI araştırma liderleri Sanja Fidler, Aaron Lefohn ve Ming-Yu Liu ile bilgisayar grafikleri ve fiziksel AI’da bir sonraki sınırı keşfedecek özel bir oturum düzenlenecek.

- Uygulamalı: NVIDIA Cosmos‘u kullanmayı öğrenin; bu, fiziksel AI eğitimi için veri ve senaryolar üretmeye yönelik bir üretken dünya modelidir.

Bu yazı, NVIDIA Robotics Research and Development Digest (R2D2) kapsamında, NVIDIA Research’ın fiziksel AI ve robotik uygulamaları alanında en son atılımlarını geliştiricilere tanıtmak amacıyla hazırlanmıştır.

Açık kaynaklardan haberdar kalmak için bültenimize abone olabilir ve NVIDIA Robotics’i YouTube, Discord ve geliştirici forumlarıında takip edebilirsiniz.

Yazılım yolculuğunuza başlamak için NVIDIA Robotik Temel Kursları‘na kayıt olmayı unutmayın.

Teşekkürler

Bu yazıda bahsedilen araştırmalara yaptığı katkılardan dolayı aşağıdaki isimlere özel teşekkürler:Niket Agarwal, Arslan Ali, Mousavian Arsalan, Alisson Azzolini, Yogesh Balaji, Hannah Brandon, Tiffany Cai, Tianshi Cao, Prithvijit Chattopadhyay, Mike Chen, Yongxin Chen, Yin Cui, Ying Cui, Yifan Ding, Daniel Dworakowski, Francesco Ferroni, Sanja Fidler, Dieter Fox, Ruiyuan Gao, Songwei Ge, Rama Govindaraju, Siddharth Gururani, Zekun Hao, Ali Hassani, Ethan He, Fengyuan Hu, Shengyu Huang, Spencer Huang, Michael Isaev, Pooya Jannaty, Brendan Johnson, Alexander Keller, Rizwan Khan, Seung Wook Kim, Gergely Klár, Grace Lam, Shiyi Lan, Elena Lantz, Tobias Lasser, Nayeon Lee, Anqi Li, Zhaoshuo Li, Chen-Hsuan Lin, Tsung-Yi Lin, Zhi-Hao Lin, Zongyu Lin, Ming-Yu Liu, Xian Liu, Xiangyu Lu, Yifan Lu, Alice Luo, Ajay Mandlekar, Hanzi Mao, Andrew Mathau, Seungjun Nah, Avnish Narayan, Yun Ni, Sriprasad Niverty, Despoina Paschalidou, Tobias Pfaff, Wei Ping, Morteza Ramezanali, Fabio Ramos, Fitsum Reda, Zheng Ruiyuan, Amirmojtaba Sabour, Ed Schmerling, Tianchang Shen, Stella Shi, Misha Smelyanskiy, Shuran Song, Bartosz Stefaniak, Steven Sun, Xinglong Sun, Shitao Tang, Przemek Tredak, Wei-Cheng Tseng, Nandita Vijaykumar, Andrew Z. Wang, Guanzhi Wang, Ting-Chun Wang, Zian Wang, Fangyin Wei, Xinyue Wei, Wen Xiao, Stella Xu, Yao Xu, Yinzhen Xu, Dinghao Yang, Xiaodong Yang, Zhuolin Yang, Seonghyeon Ye, Yuchong Ye, Xiaohui Zeng, Yuxuan Zhang, Zhe Zhang, Ruijie Zheng, Yuke Zhu, Artur Zolkowski.