Yapay zeka modellerinin hızlı gelişimi, daha verimli ve ölçeklenebilir çıkarım çözümlerine olan ihtiyacı artırmıştır. Organizasyonlar, AI’nin gücünden faydalanmak için çaba sarf ederken, AI çıkarım iş yüklerini dağıtma, yönetme ve ölçeklendirme konularında zorluklarla karşılaşmaktadırlar. NVIDIA NIM ve Google Kubernetes Engine (GKE) bir araya gelerek bu zorlukları aşmak için güçlü bir çözüm sunmaktadır. NVIDIA, Google Cloud ile işbirliği içinde, NVIDIA NIM’i GKE üzerinde sunarak güvenli, güvenilir ve yüksek performanslı çıkarım imkanı sağlamaktadır. Ayrıca, Google Cloud Marketplace üzerinden basit bir şekilde dağıtım yapma olanağı sunmaktadır.

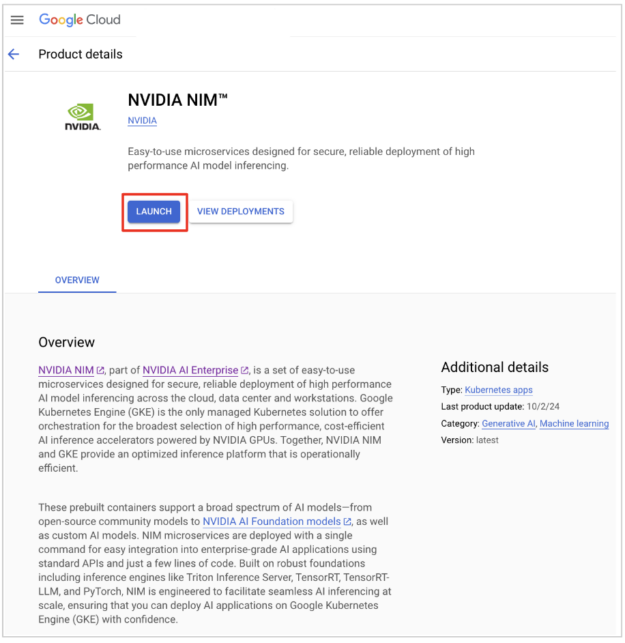

NVIDIA NIM, Google Cloud Marketplace üzerinde bulunan NVIDIA AI Enterprise yazılım platformunun bir parçasıdır. Bu platform, yüksek performanslı AI model çıkarımı için güvenli ve güvenilir bir dağıtım sağlamak amacıyla kullanılan mikro hizmetler setidir. NIM artık, Google Cloud altyapısını kullanarak konteynerleştirilmiş uygulamaların ölçeklenerek dağıtımını ve işletilmesini sağlayan yönetilen bir Kubernetes hizmeti olan GKE ile entegre edilmiştir.

Bu yazıda, NIM’in GKE ile birlikte AI çıkarım iş yüklerinin dağıtımını ve yönetimini nasıl kolaylaştırdığı açıklanmaktadır. Bu güçlü ve esnek çözüm, GKE’nin sağlam yeteneklerinden ve NVIDIA’nın tam yığın AI platformundan yararlanmaktadır.

Performans Optimizasyonu Sağlayan Kolay Dağıtım

NVIDIA NIM ve GKE entegrasyonu, AI çıkarımını hızlandırmak isteyen organizasyonlar için birkaç önemli fayda sunmaktadır:

- Kolay dağıtım: NVIDIA NIM’in Google Cloud Marketplace üzerinden tek tıklama ile dağıtım özelliği, AI çıkarım iş yüklerini kurmayı ve yönetmeyi kolaylaştırmaktadır.

- Esnek model desteği: Açık kaynak modeller, NVIDIA AI temel modelleri ve özel modeller dahil geniş bir AI model yelpazesini destekleyerek, organizasyonların uygulamalarına en uygun modelleri kullanmasına olanak tanır.

- Verimli performans: NVIDIA Triton Inference Server, NVIDIA TensorRT ve PyTorch gibi sektör standartları üzerinde inşa edilen bu platform, yüksek performanslı AI çıkarımı sağlamakta ve büyük veri hacimlerini hızlı ve verimli bir şekilde işlemenize olanak tanımaktadır.

- Hızlandırılmış hesaplama: NVIDIA H100, A100 ve L4 dahil olmak üzere Google Cloud üzerinde bir dizi NVIDIA GPU örneğine erişim sağlamak, geniş bir maliyet ve performans ihtiyaç setini karşılamaktadır.

- Kesintisiz entegrasyon: Standart API’ler ile uyumluluk ve minimal kodlama gereksinimi, mevcut AI uygulamalarının kolayca entegrasyonunu mümkün kılar.

- Kurumsal düzeyde özellikler: Güvenlik, güvenilirlik ve ölçeklenebilirlik özellikleri, AI çıkarım iş yüklerinin korunmasını sağlarken, değişen talep seviyelerini karşılamaktadır.

- Basit satın alma süreci: Google Cloud Marketplace üzerinden erişilebilirlik, platformun hızlı bir şekilde edinilmesi ve dağıtım sürecini kolaylaştırmaktadır.

NVIDIA NIM ile GKE Üzerinden Başlamak

NIM’i GKE üzerinde kullanmaya başlamak için aşağıdaki adımları izleyin.

Adım 1: Google Cloud konsolunda GKE üzerindeki NVIDIA NIM’i erişin ve dağıtım sürecini başlatın. Başlat düğmesine tıklayın, ardından dağıtım detayları sayfası açılacaktır.

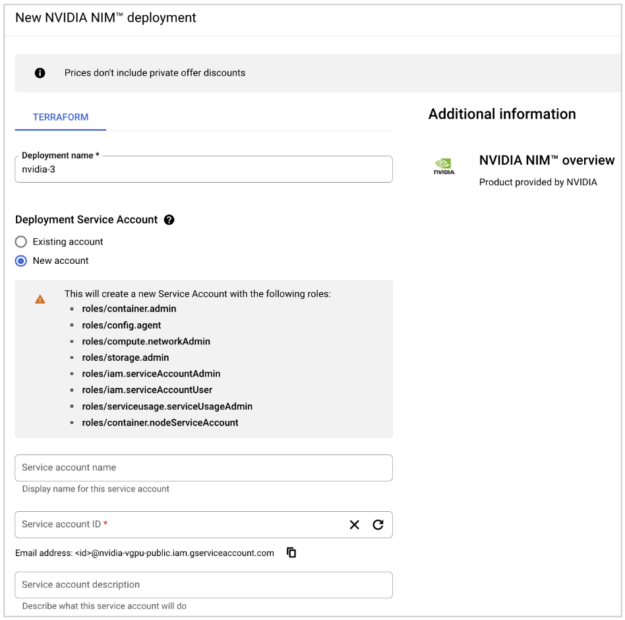

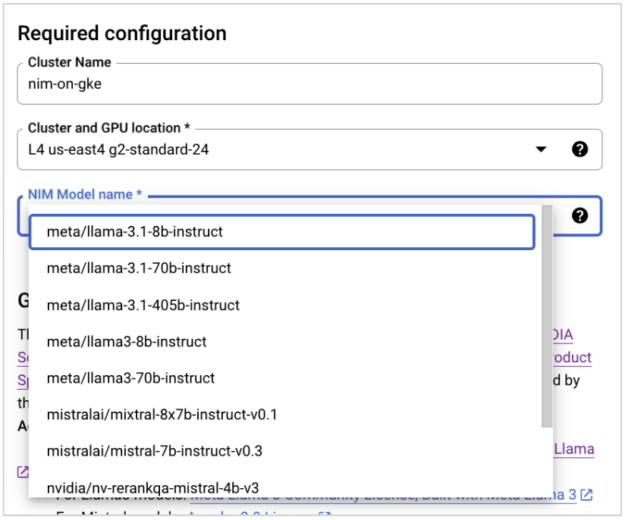

Adım 2: platformunuzu belirli AI çıkarım gereksinimlerine göre yapılandırın, istenen AI modellerini seçin ve dağıtım parametrelerini ayarlayın. Bir dağıtım adı girin. Mevcut bir Servis Hesabı kullanabilir ya da yeni bir tane oluşturabilirsiniz.

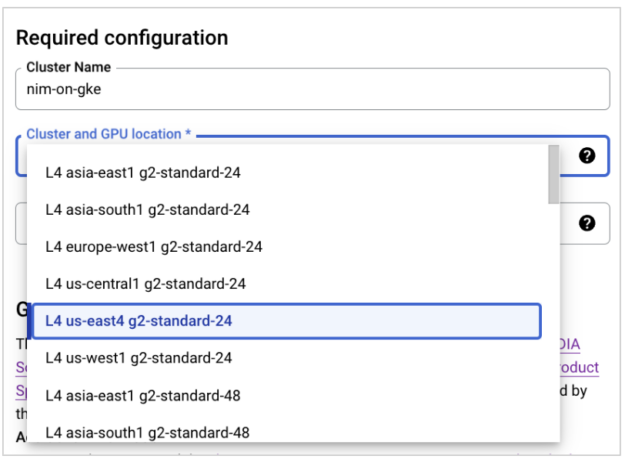

Ardından, açılır menüden örnek türüne karşılık gelen belirli bir bölgede uygun GPU’yu seçin.

Adım 3: Açılır menüden NIM’inizi seçin.

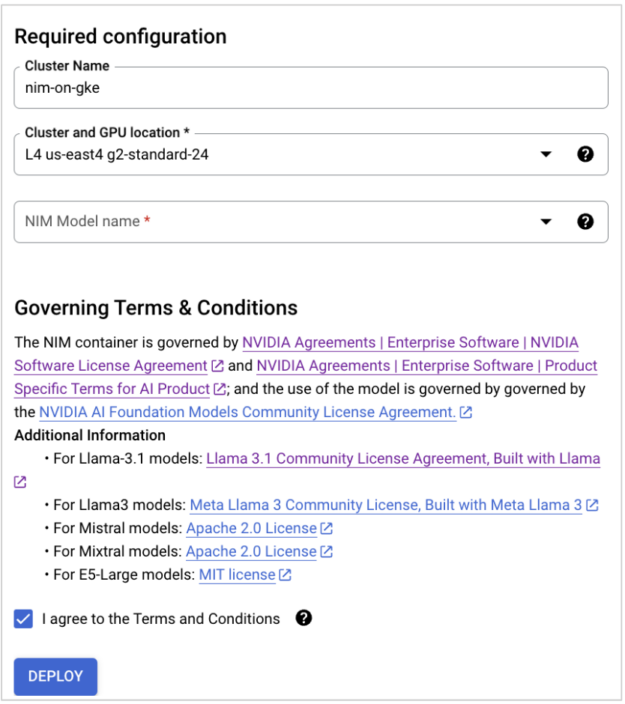

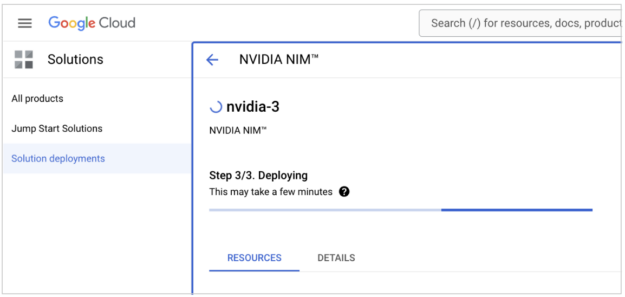

Adım 4: EULA’yı okuyun ve kabul edin, ardından Dağıtım’a tıklayın. Dağıtım işlemi, seçtiğiniz NIM ve küme parametrelerine bağlı olarak yaklaşık 15-20 dakika sürmektedir.

Adım 5: Oluşturulan GKE kümesi için kimlik bilgilerini alın. Yeni kümenizi bulmak için Google Cloud konsoluna gidin. Ardından Seçenek menüsünden → Bağlan seçeneğine tıklayarak kimlik bilgilerini alın.

gcloud container clusters get-credentials $CLUSTER --region $REGION --project $PROJECT

Küme çalışmaya başladıktan sonra, NIM konteynerine port yönlendirme ayarlayarak çıkarım işlemini gerçekleştirin:

kubectl -n nim port-forward service/my-nim-nim-llm 8000:8000 &

Daha sonra aşağıdaki curl komutlarıyla NIM uç noktasına çıkarım isteği gönderin:

curl -X GET 'http://localhost:8000/v1/health/ready'

curl -X GET 'http://localhost:8000/v1/models'

curl -X 'POST'

'http://localhost:8000/v1/chat/completions'

-H 'accept: application/json'

-H 'Content-Type: application/json'

-d '{

"messages": [

{

"content": "Siz insanlara tatil planlamasında yardımcı olan nazik ve saygılı bir sohbet botsusunuz.",

"role": "system"

},

{

"content": "İspanya'da 4 günlük tatil için ne yapmalıyım?",

"role": "user"

}

],

"model": "meta/llama-3.1-8b-instruct",

"max_tokens": 4096,

"top_p": 1,

"n": 1,

"stream": true,

"stop": "n",

"frequency_penalty": 0.0

}'

Model sıralaması için aşağıdaki çağrıyı kullanın:

# rerank-qa

curl -X 'POST'

'http://localhost:8000/v1/ranking'

-H 'accept: application/json'

-H 'Content-Type: application/json'

-d '{

"query": {"text": "hangi yöne gitmeliyim?"},

"model": "nvidia/nv-rerankqa-mistral-4b-v3",

"passages": [

{

"text": "iki yol bir sarı ormanda ayrıldı ve üzgünüm, ikisini de geçemem ve bir gezgin olamam, uzun süre durdum ve birini sonuna kadar gördüm ve altındaki kıvrılana kadar;"

},

{

"text": "sonra diğerini aldım, adil görünüşte, belki de daha iyi bir iddiaya sahipti çünkü çimenliydi ve giyilmedi, oysa bunun için geçenlerin ikisi de gerçekten hemen hemen aynıydı,"

},

{

"text": "ve her ikisi de o sabah eşit bir biçimde yapraklarla örtülüydü, hiç adım atmamıştı kararmış. ah, ilkini başka bir gün için işaretledim! ama hangi yolun hangi yolda gideceğini bilmemi sağlıyordu."

}

]

}'

Gömme modelleri için aşağıdaki çağrıyı kullanın:

# embed

curl -X "POST"

"http://localhost:8000/v1/embeddings"

-H 'accept: application/json'

-H 'Content-Type: application/json'

-d '{

"input": ["Merhaba dünya"],

"model": "nvidia/nv-embedqa-e5-v5",

"input_type": "query"

}'

Model parametresi altında belirtilen URL’nin doğruluğundan emin olun.

Ayrıca, dağıtılmış modelin performans metrikleri olan throughput ve latency’yi test etmek için NVIDIA GenAI-Perf aracını kullanabilirsiniz.

Kendi AI uygulamalarınızı ve modellerinizi NVIDIA NIM ile GKE üzerinde entegre ederek, standart API ve uyumluluk özelliklerinden yararlanarak kesintisiz bir operasyon sağlayabilirsiniz. AI çıkarım iş yüklerinizi gerektiği gibi ölçeklendirerek, platformun ölçeklenebilirlik özelliklerini kullanarak değişen talepleri karşılayabilirsiniz.

Özet

NVIDIA NIM, GKE üzerinde AI çıkarımını hızlandırmak için güçlü bir çözüm sunmakta, kullanım kolaylığı, geniş model desteği, sağlam temeller, kesintisiz uyumluluk ve kurumsal düzeyde güvenlik, güvenilirlik ve ölçeklenebilirlik özellikleri taşımaktadır. İşletmeler, AI yeteneklerini artırabilir, dağıtım süreçlerini kolaylaştırabilir ve yüksek performanslı AI çıkarımına ulaşabilirler. NVIDIA NIM, yenilikçi çözümler sunmak ve etkili AI çözümleri sağlamak için gereken araçlar ve altyapıyı sağlamaktadır. Daha fazla bilgi için, Google Cloud Marketplace’te NVIDIA NIM‘yi ziyaret edin.

Detaylı bilgi için NVIDIA NIM Mikroservisleri ile Optimize Edilmiş AI Modellerini Verimli Bir Şekilde Hizmet Edin yazısını okuyabilirsiniz.