Cerebras’ın yayınladığı videoda, AI sisteminin dünyanın en hızlı GPU bulutundan 75 kat daha hızlı kod yazabildiği gösterildi. Ayrıca, bu sistemde kullanılan dünyanın en büyük çipi, AWS’nin en hızlı GPU’suyla yapılan doğrudan karşılaştırmada üstünlük sağladı. Bu, Cerebras’ın sunduğu teknoloji ve performansın ne kadar etkileyici olduğunu ortaya koyuyor. AI’nın bu tür uygulamalar için sağladığı hız ve verimlilik, yazılım geliştirme süreçlerinde önemli bir avantaj sunabilir.

Cerebras, Meta’nın Llama 3.1 405B büyük dil modelini saniyede 969 token hızında çalıştırmayı başardı. Bu, Amazon Web Services’in en hızlı GPU hizmetinin hızından 75 kat daha hızlı bir performans sergiliyor.

Cerebras’ın Yenilikçi Teknolojisi

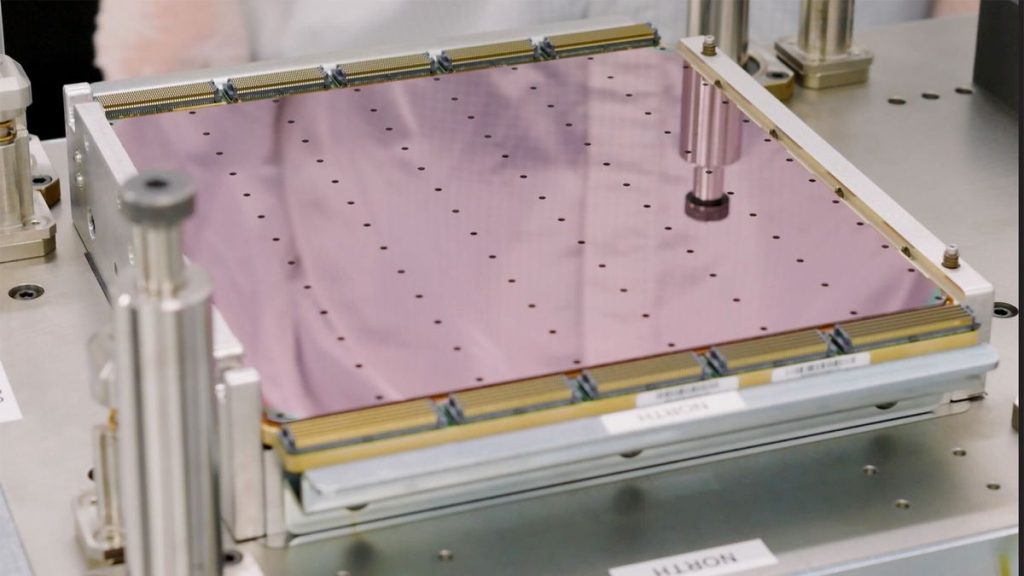

Cerebras Inference adı verilen bulut AI hizmeti, Nvidia veya AMD’nin GPU’ları yerine şirketin üçüncü nesil Wafer Scale Engine çiplerini kullanıyor. Cerebras, Inference hizmetinin token üretme konusunda her zaman en hızlı olduğunu iddia etti. İlk olarak Ağustos ayında tanıtıldığında, Llama 3.1 8B ve Llama 3.1 70B için Nvidia GPU’lara kıyasla yaklaşık 20 kat daha hızlı olduğu belirtilmişti.

Ağır Yükle Performans

Meta, Temmuz ayında 405 milyar parametreye sahip olan Llama 3.1 405B modelini sundu. Cerebras, bu ağır LLM’yi “anlık hızda” çalıştırabileceğini belirtiyor. Saniyede 969 token hızına ulaşırken, ilk token için geçen süre sadece 0.24 saniye. Bu, Cerebras’a göre sadece çipleri için değil, Llama 3.1 405B modeli için de bir dünya rekoru.

Nvidia GPU’larla AWS üzerinden yapılan karşılaştırmalarda, Cerebras Inference’in hızı 75 kat daha fazla olduğu belirtiliyor; ayrıca Wafer Scale Engine çipleri, bagaj sektörü tarafından gerçekleştirilen en hızlı Nvidia GPU uygulamasına kıyasla 12 kat daha hızlıydı. Cerebras’ın en yakın rakibi olan AI işlemci tasarımcısı SambaNova ile kıyaslandığında ise Cerebras Inference, rakibini 6 kat geride bıraktı.

Uygulama Hızı

Cerebras, Fireworks (en hızlı GPU bulut hizmeti) ve Inference ile bir satranç programı oluşturulması için bir test gerçekleştirdi. Cerebras Inference süreci yaklaşık üç saniye sürerken, Fireworks süreci 20 saniye sürdü.

Cerebras, “Llama 3.1 405B sayesinde dünyadaki en hızlı ileri modeliz – GPT-4o’dan 12 kat ve Claude 3.5 Sonnet’ten 18 kat daha hızlıyız” ifadelerinde bulundu. Meta’nın açık yaklaşımı ile Cerebras’ın çığır açan inference teknolojisi sayesinde, Llama 3.1-405B artık kapalı ileri modellerden 10 kat daha hızlı çalışıyor.

Yüksek Performans ve Başarılar

Cerebras, sorgu boyutunu 1,000 token’dan 100,000 token’a çıkardığında bile, Inference’nin saniyede 539 token ürettiğini belirtti. Bu işlem, bu yükü gerçekleştirebilen diğer beş hizmet arasında en hızlısıydı; en iyisi sadece 49 token/saniye hızına ulaşabildi.

Ayrıca, Cerebras’ın ikinci nesil Wafer Scale Engine’inin Frontier süper bilgisayarını 768 kat daha hızlı çalıştırdığı belirtildi. Frontier, geçtiğimiz günlerde El Capitan süper bilgisayarının tanıtılmasıyla birlikte dünyadaki en hızlı süper bilgisayardın unvanını kaybetti. Bu yeni süper bilgisayar, AMD’nin 9,472 Epyc CPU’sunu kullanıyor.

Süper bilgisayar Anton 3’ü %20 oranında geride bıraktıklarını belirten Cerebras, bu başarının önemli olduğunu vurguladı. Anton 3, moleküler dinamik simülasyonları için özel olarak tasarlanmıştı ve saniyede 1.1 milyon simülasyon adımı ile milyon simülasyon adımı barajını aşan ilk sistem oldu.