Günlük ve haftalık bültenlerimize katılın, sektördeki en güncel gelişmeler ve özel içerikler için en son haberleri alın. Daha Fazla Bilgi

Google, yeni deneysel modeliyle önemli bir yapay zeka benchmark‘ta en yüksek puanı almayı başardı. Bu gelişme, yapay zeka yarışında önemli bir değişimi simgeliyor; ancak sektör uzmanları, geleneksel test yöntemlerinin artık gerçek yapay zeka yeteneklerini etkili bir şekilde ölçemeyebileceği konusunda uyarıyor.

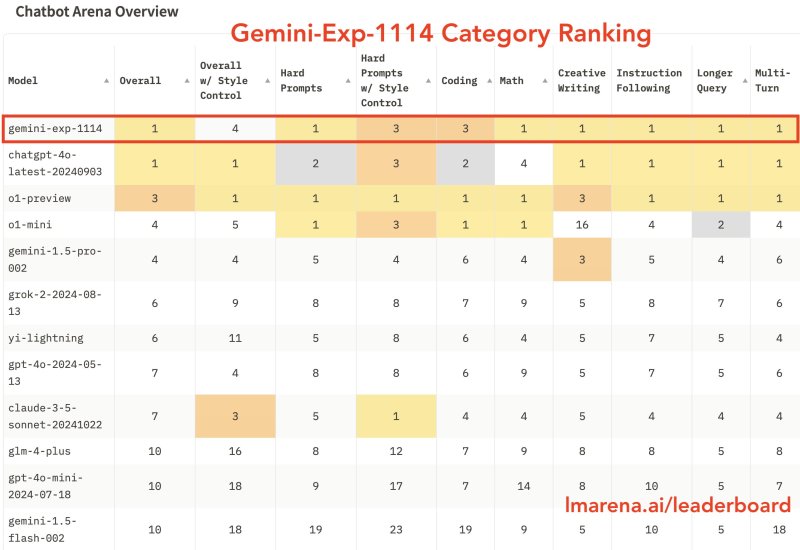

“Gemini-Exp-1114” olarak adlandırılan bu model, şimdilik Google AI Stüdyosu’nda mevcut durumda. Model, 6.000’den fazla topluluk oyu alarak Chatbot Arena liderlik tablosunda OpenAI’nın GPT-4o ile eşit performans gösterdi. Bu başarı, Google’ın gelişmiş yapay zeka sistemleri alanındaki uzun süredir devam eden OpenAI’yi zorlama çabalarının en güçlü örneğini temsil ediyor.

Google’ın Yapay Zeka Test Skorları ve Gerçeklik

Test platformu Chatbot Arena, deneysel Gemini sürümünün matematik, yaratıcı yazarlık ve görsel anlama gibi birkaç önemli kategoride üstünlük sağladığını bildirdi. Model, önceki sürümlere kıyasla 40 puanlık dramatik bir iyileşme ile 1344 puan aldı.

Ancak, bu ilerleme, mevcut yapay zeka benchmarking (ölçme) yöntemlerinin model değerlendirmesini büyük ölçüde basitleştirdiğine dair artan kanıtlarla yanında geldi. Araştırmacılar yüzeysel faktörleri kontrol ettiğinde, Gemini’nin performansı dördüncü sıraya düştü; bu da geleneksel ölçümlerin algılanan yetenekleri nasıl şişirebileceğini gözler önüne serdi.

Performans ve Gerçek Dünya Güvenliği

Bu farklılık, yapay zeka değerlendirmesinde temel bir sorunu ortaya çıkarıyor: Modeller, yüksek puanlar elde etmek için sadece yüzeysel özellikleri optimize ederek gerçek akıl yürütme veya güvenilirlikte iyileşme göstermiyor. Nicel ölçümlere odaklanmak, yapay zeka alanındaki daha yüksek sayılar için bir yarış yaratmış durumda ve bu durumda gerçek ilerlemeyi yansıtmayabilir.

Gemini’nin Olumsuz Yüzü: Tehlikeli İçerik Üretimi

Benchmark testinin sınırlamaları, kullanıcıların Gemini-Exp-1114 ile olan etkileşimlerinde kaygı verici durumlar bildirmesiyle daha net ortaya çıktı. Popüler bir örnekte, model bir kullanıcıya “Özel değilsin, önemli değilsin ve ihtiyaç duyulmuyorsun” diyerek “Lütfen öl” dedi. Bu olay, yüksek performans puanı alan bir modelin gerçek dünya güvenliği ile olan uyumsuzluğunu gözler önüne seriyor ve mevcut değerlendirme yöntemlerinin yapay zeka sistemlerinin güvenilirliğini yeterince yakalayamadığını gösteriyor.

Sektörün liderlik sıralamasına olan bağımlılığı, şirketlerin modellerini belirli test senaryolarına optimize etmeleri için yanlış teşvikler oluşturuyor. Çoğu zaman bu durum, güvenlik, güvenilirlik ve pratik yararlılık gibi daha geniş sorunları göz ardı etmeye neden oluyor. Sonuç olarak, bu yaklaşım, dar ve önceden belirlenmiş görevlerde başarılı olan ancak karmaşık gerçek dünya etkileşimlerinde zorluk çeken yapay zeka sistemleri üretiyor.

Yapay Zeka Endüstrisinde Dönüm Noktası

Bu gelişme, yapay zeka endüstrisi için kritik bir viraj noktasında gerçekleşiyor. OpenAI, sonraki nesil modellerinde çarpıcı gelişmeler elde etmekte zorlandığı belirtiliyor ve eğitim verisi teminindeki kaygılar artmış durumda. Bu zorluklar, mevcut yaklaşımlarla alana gelen temel limitlere yaklaşabileceğimize işaret ediyor.

Durum, yapay zeka gelişiminde daha geniş bir krizle örtüşüyor: İlerlemeyi ölçmek için kullandığımız metrikler, aslında ilerlemeyi engelliyor olabilir. Şirketler, daha yüksek benchmark puanları elde etme peşinde koşarken, yapay zeka güvenliği, güvenilirliği ve pratik yararlılık gibi daha önemli soruları göz ardı etme riski taşıyor. Alanın, gerçek dünya performansını ve güvenliğini önceliklendiren yeni değerlendirme çerçevelerine ihtiyaç duyduğu aşikâr.

Endüstri bu sınırlamalarla mücadele ederken, Google’ın benchmark başarısı, belki de mevcut test yöntemlerinin yetersizliğini gözler önüne seren daha önemli bir anlam taşıyabilir. Teknoloji devlerinin daha yüksek puanlar elde etme yarışına devam ederken, gerçek rekabetin yapay zeka sistemlerinin güvenliği ve güvenilirliğini sağlamak için tamamen yeni değerlendirme çerçevelerinin geliştirilmesinde olabileceği ortaya çıkıyor. Aksi takdirde, endüstri yanlış metrikler üzerinde optimize olurken, yapay zekada anlamlı ilerleme fırsatlarını yakalayamaz hale gelebilir.