Veri yükleme, derin öğrenme süreçlerinde kritik bir önem taşır. Hem eğitim hem de çıkarım aşamalarında, veri yüklemenin hızlı ve verimli olması gerekir. Ancak, bu noktada bir paradoks ortaya çıkar: Hem oldukça kullanışlı bir çözüm sağlamak hem de aynı zamanda özelleştirilebilir bir yapı sunmak oldukça zordur.

Bu sorunun geleneksel bir çözümü, işlevin kullanıcı tarafından yazılan kısmını ölçeklendirmek ve paralelleştirmek üzerine kuruludur. Bu yöntemle, kullanıcı özel bir algoritma oluştururken, sistem bu algoritmanın çok sayıda işçi arasında dağıtılarak çalışmasını sağlar. Bu noktada torch.DataLoader devreye girmektedir.

Bu yazıda, torch.DataLoader‘ı işlemlerden iptal ederek thread’lere geçirme üzerine yaptığımız bir deneyin sonuçlarını belgeleyerek, Python’un GIL’i kaldırma çabası sayesinde derin öğrenme iş akışlarında paralelizm üzerinde yeni optimizasyonlar keşfetme fırsatını ele alacağız.

torch.DataLoader Nedir ve Nasıl Çalışır?

torch.DataLoader, PyTorch’un derin öğrenme uygulamalarında veri yüklemeyi kolaylaştıran temel bir araçtır. Modeline veri akışını yönetme konusunda önemli bir rol oynar, böylece sürecin hem etkili hem de verimli olmasını sağlar.

torch.DataLoader‘ın en önemli özelliklerinden biri, büyük veri setleriyle çalışırken yükleme sürecini paralelleştirme yeteneğidir.

Bu paralelleştirme, genellikle birçok işçi işlemi oluşturarak gerçekleştirilir. Her bir işçi, verinin bir kısmını yüklemekten sorumludur ve bu işçiler paralel çalışarak, verilerin model eğitimine eş zamanlı bir şekilde yüklenip ön işlenmesini sağlar.

Paralellik, GPU’ya veri akışını sürekli hale getirerek, boş kalma süresini en aza indirmeye ve kaynak kullanımını maksimize etmeye yardımcı olur.

GIL Sorunu

torch.DataLoader, veri yükleme görevlerini paralelleştirmek için işlemleri kullanır ve bu yaklaşım doğrudan Python mimarisinin temel bir yönü olan global interpreter lock (GIL) ile ilişkilidir.

GIL, CPython’da, yani en yaygın kullanılan Python uygulamasında, birden fazla yerel thread’in aynı anda Python byte kodlarını çalıştırmasını engelleyen bir mutex’tir. Bu kilit, bellek yönetimini basitleştirmek ve birden fazla thread’in aynı anda Python nesnelerine erişmeye veya bunları değiştirmeye çalıştığında yarış koşullarını önlemek için getirilmiştir.

GIL, Python’un bellek yönetimini kolaylaştırmakta ve geliştiriciler için karmaşık eşzamanlılık hatalarının önüne geçmektedir; bu da Python’un popülaritesinin nedenlerinden biridir. Ancak, GIL, çoklu işlemci sistemlerinin tam olarak kullanılmasını engelleyerek CPU’yla sınırlı ve çok thread’li uygulamalarda dar boğaz yaratmaktadır.

İşlemlerden Thread’lere Geçiş

Son dönemlerde, GIL’in kaldırılması yönünde bazı geliştirilmeler yaşandı. Bu, Python uygulamalarında paralelizm için yeni olasılıkları beraberinde getiriyor.

Bize ilham veren temel fikir, torch.DataLoader‘da işlem tabanlı paralelliği, thread tabanlı paralellik ile değiştirmek oldu.

Thread’leri işlem yerine kullanmanın birkaç potansiyel avantajı bulunmaktadır. Thread’ler genellikle işlemden daha hafif yapıya sahip oldukları için daha hızlı bir bağlam değişimi ve daha düşük bellek kullanımı sağlarlar.

Ancak, threading’in kendi içinde bazı zorlukları da vardır; özellikle thread güvenliğini sağlamak ve deadlock gibi sorunlardan kaçınmak oldukça zordur.

Bu olasılıkları incelemek adına, thread tabanlı bir torch.DataLoader uygulaması gerçekleştirerek sonuçları değerlendirdik. Elde edilen sonuçlar ilgi çekici oldu ve belirli senaryolar için thread’lerin makul bir alternatif olabileceğini gösterdi.

Thread Tabanlı Veri Yüklemenin Sonuçları

İşlemleri thread’lerle değiştirdikten sonra torch.DataLoader‘ın performans etkisini değerlendirmek amacıyla farklı veri işleme senaryolarında bir dizi deney gerçekleştirdik. Bu deneyler thread tabanlı paralelliğin hem potansiyelini hem de sınırlamalarını gözler önüne serdi.

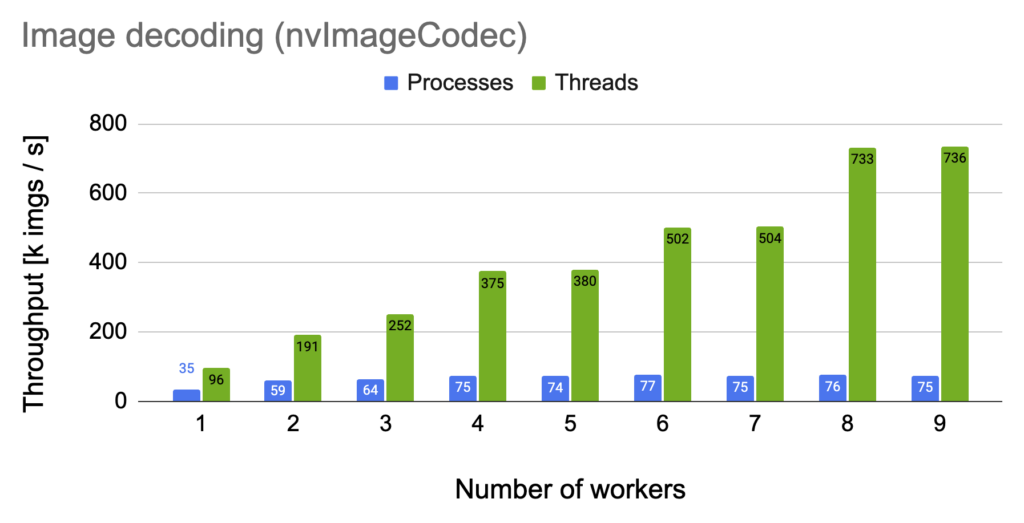

nvImageCodec ile Görüntü Decoding

Thread kullanmanın en etkileyici sonuçlarından biri, nvImageCodec kullanarak görüntü decoding senaryosunda ortaya çıktı. Bu senaryoda, thread kullanımının geleneksel işlem tabanlı yaklaşıma kıyasla önemli ölçüde hız kazandırdığı gözlemlendi.

Benchmark ayrıntıları: EPYC 9654 | H100 | Batch boyutu: 512 | Görüntü boyutu: 640 x 408 (JPEG)

Bu iyileşmenin ana nedeni, CUDA bağlam geçişlerinin azalmasıdır. İşlemler, bağlamı değiştirmek için daha fazla yük getirdiğinden, bu durum gecikmelere neden olabilir. Ancak thread’ler, bu yükü azaltarak daha hızlı ve verimli bir çalışma sağlıyor.

Pillow ile Görüntü Decoding

Bununla birlikte, yaygın olarak kullanılan bir Python görüntü kütüphanesi olan Pillow ile yapılan deneylerimizde, thread tabanlı yaklaşımın işlem tabanlı yöntemden biraz daha yavaş olduğu görüldü.

Benchmark ayrıntıları: EPYC 9654 | Batch boyutu: 512 | Görüntü boyutu: 640 x 408 (JPEG)

Burada temel fark, genel durumun nasıl yönetildiğiyle ilgilidir. Pillow’un işlemleri, sıklıkla paylaşılmış durum verilerine erişim gerektirmektedir. Birden fazla thread bu verilere aynı anda eriştiğinde, mevcut implementasyon atomikleri kullanarak bu işlemleri güvenli bir şekilde yönetmektedir.

Ancak atomikler rekabet altında bir dar boğaza dönüşebilir ve bu durum, her bir işçinin izolasyonunu sağladığı süreçlere kıyasla yavaş performansa neden olur.

Bu gözlemler doğrultusunda, discuss.python.org platformunda veri türlerinin dondurulması fikrini yeniden gözden geçirmeye başladık. Bu yaklaşım, daha verimli okuma erişimi sağlayarak pahalı atomik işlemlere duyulan ihtiyacı azaltabilir.

Birleşik Sonuçlar: nvImageCodec ve Pillow

Işlem ve thread tabanlı senaryoları daha iyi karşılaştırabilmek amacıyla, nvImageCodec ve Pillow sonuçlarını tek bir grafikte birleştirdik.

Benchmark ayrıntıları: EPYC 9654 | H100 | Batch boyutu: 512 | Görüntü boyutu: 640 x 408 (JPEG)

Bu karşılaştırma, iki yaklaşım arasındaki belirgin farkları net bir şekilde ortaya koymaktadır:

- nvImageCodec: Threads, işlemlere kıyasla belirgin bir şekilde daha yüksek performans göstererek, CUDA bağımlılığı olan GPU ağırlıklı görevlerde_thread yaklaşımının son derece avantajlı olduğunu göstermektedir.

- Pillow: İşlemler yine hafif bir avantaj sağlamakta, bu da paylaşılan durumla çalışan görevlerin threading’den çok fazla yararlanmaması gerektiğini vurgulamaktadır.

Bu bulgular, GIL’in kaldırılmasının GPU tabanlı senaryolarda önemli hız artışları sağlayabileceğini vurgulamaktadır. Ancak, Pythonun serbest iş parçacıklı evrimi sürecinde daha fazla çaba sarf ederek yeni araçlar ve kavramların geliştirilmesi gerekmektedir.

Thread Tabanlı torch.DataLoader’ın Avantajları ve Dezavantajları

Thread tabanlı torch.DataLoader‘ın belirli senaryolar açısından net avantajları olduğu görülmesine rağmen, bazı dezavantajlar da bulunmaktadır.

Avantajlar oldukça net:

- Daha düşük yük: Thread’ler, işlemden daha az kaynak harcayarak, bellek kullanımını azaltır ve daha hızlı bağlam değişimleri sağlar.

- Bazı senaryolar için daha iyi performans: nvImageCodec deneylerinde gösterildiği gibi, thread’ler senkronizasyon yükünü azaltarak genel performansı artırabilir.

Dezavantajlar ise şöyledir:

- Thread güvenirliği: Thread tabanlı uygulamanın güvenliğini sağlamak, karmaşık veri akışlarında zordur. Ayrıca, thread’ler deadlock riski taşımaktadır, bu da veri yükleme sürecinin durmasına yol açabilir.

- Kapsamlı senkronizasyon: Thread’ler genellikle daha sık senkronize edilmelidir. Thread tabanlı bir uygulama geliştirmek daha dikkatli bir süreç gerektirmektedir.

- Mevcut implementasyonları taşıma zorluğu: Serbest iş parçacıklı Python ekosistemi henüz geliştirme aşamasındadır. Derin öğrenme projelerinin bu değişime ayak uydurması zaman alacaktır.

Sonuç

GIL’in kaldırılması, Python’da derin öğrenme iş akışlarını optimize etme fırsatları sunmaktadır. Thread tabanlı torch.DataLoader‘ın araştırılmasının, GPU işleme içeren işçi uygulamaları için avantajlı bir yaklaşım olduğu görülmektedir.

Ancak CPU işlemleri için, veri yapılarına erişimdeki verimsizlik nedeniyle performansta dar boğazlar oluşabilmektedir. Gelecek dönemlerde bu durumun üstesinden gelinmesini umuyoruz.

Python’un gelişmeye devam etmesiyle, derin öğrenmede veri yükleme yöntemleri değişime girmektedir ve bu gelişmelerin öncüsü olmaktan heyecan duyuyoruz.

Serbest iş parçacıklı Python ile ilgili yaptığımız deneyler hakkında daha fazlasını öğrenmek istemeniz durumunda, serbest iş parçacıklı Docker ortamımız‘na göz atabilirsiniz. Sorularınızı sorun ve serbest iş parçacıklı Python’u kendi kullanım durumlarınızda denemekten çekinmeyin!