Son zamanlarda yaşanan üretilmiş yapay zeka ve görsel temel modellerdeki ilerlemelerle birlikte, Görsel-Lisan Modelleri (VLM’ler), görsel bilişimde devrim niteliği taşıyan bir dönemi temsil ediyor. Bu akıllı çözümler, XR ortamlarında anlamlı kavrayışı geliştirmek için umut verici bir yol sunuyor. VLM’lerin entegrasyonu, geliştiricilerin XR uygulamalarının kullanıcı eylemlerini nasıl yorumladığını ve etkileşimde bulunduğunu büyük ölçüde iyileştirerek daha yanıt veren ve sezgisel hale getirmelerini sağlıyor.

Bu yazıda, NVIDIA AI Blueprint for video search and summarization‘dan faydalanarak ses desteği ekleme sürecini adım adım inceleyeceğiz. Ortamın kurulmasından, gerçek zamanlı konuşma tanıma ve etkileşimlerin kesintisiz entegrasyonuna kadar olan süreci açıklayacağız.

XR Uygulamalarını Geliştirme

XR uygulamalarının konuşma tabanlı AI işlevsellikleri ile güçlendirilmesi, kullanıcıların daha etkileyici bir deneyim yaşamasını sağlıyor. XR ortamında Q&A yetenekleri sunan üretilmiş AI ajanları oluşturarak, kullanıcıların daha doğal bir şekilde etkileşimde bulunmalarını ve anında yardım alabilmelerini sağlamak mümkün. Bir multimodal AI ajanı, görsel verileri (XR kulaklık kaynakları gibi), konuşma, metin veya sensör akışları gibi birden fazla girdi modunu işleyerek, bağlama duyarlı kararlar alıp doğal ve etkileşimli yanıtlar üretir.

Bu entegrasyonun önemli etkilerini görebileceğimiz bazı kullanım alanları şunlardır:

- Yetenekli işgücü eğitimi: Gerçek ekipman kullanmanın daha tehlikeli olduğu sektörlerde, XR uygulamaları güvenli ve kontrol edilen ortamlar sunarak etkili eğitim sağlar. VLM’lerin sunduğu geliştirilmiş anlam anlayışı, daha gerçekçi ve etkili eğitim deneyimleri sunarak daha iyi beceri aktarımını ve güvenlik protokollerini destekler.

- Tasarım ve prototipleme: Mühendisler ve tasarımcılar, XR ortamlarını 3D modelleri görselleştirip manipüle etmek için kullanabilir. VLM’ler, sistemin el hareketlerini ve bağlamsal komutları anlamasını sağlar, bu da tasarım sürecini hızlandırır ve yeniliği teşvik eder.

- Eğitim ve öğrenim: XR uygulamaları, çeşitli konularda etkileyici eğitim deneyimleri oluşturabilir. Anlayışa yönelik sistem, öğrenimin etkileşimlerine göre uyum göstererek kişiselleştirilmiş içerik ve etkileşimli unsurlar sunabilir.

VLM’ler ve konuşma tabanlı AI yetenekleri ile XR uygulamalarının potansiyel kullanım alanlarını genişletmek mümkündür.

NVIDIA AI Blueprint for Video Search ve Özetleme

VLM’lerin XR uygulamalarında kullanımıyla ilgili ana zorluklardan biri, uzun videolar veya gerçek zamanlı akışları işlerken zamansal bağlamı etkili bir şekilde yakalamaktır. NVIDIA AI Blueprint for video search and summarization, VLM’lerin uzun video sürelerini ve gerçek zamanlı video akışlarını işleyebilmesini sağlıyor.

Video analitiği AI ajanlarını geliştirmeyi kolaylaştıran bu AI Blueprint, bir VLM ve bir LLM kullanarak kapsamlı video analitiği sağlar. VLM, video segmentleri için ayrıntılı alt yazılar üreterek bunları bir vektör veritabanında saklar; LLM ise bu alt yazıları özetleyerek kullanıcının sorularına son bir yanıt oluşturur. Daha fazla bilgi için NVIDIA AI Blueprint ile Video Arama ve Özetleme Ajanı Oluşturun.

AI Blueprint’un esnek tasarımı, kullanıcıların iş akışını uyarlayıp farklı ortamlara adapte etmelerini sağlar. Sanal gerçeklik (VR) ajanı oluşturma süreci, ilk olarak, VR verilerinin dinamik bir akışını sağlamakla başlar. Örneğin, VR kulaklığının ekranından VR ortamını doğrudan yakalamak için FFmpeg kullanılabilir. Ajanı etkileşimli hale getirmek için sesli iletişim olanaklarının sağlanması önceliklidir. Bir VR ajanı ile etkileşim kurmanın en iyi yolu, ona konuşmaktır.

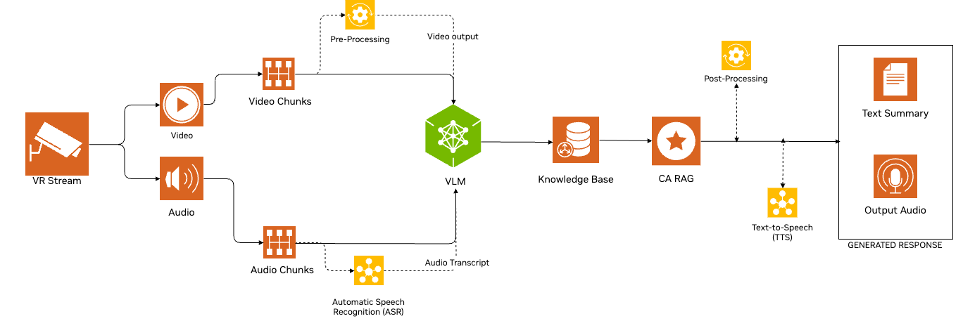

Audio ve görsel anlama süreçlerini XR ortamlarına entegre etmenin çeşitli yolları vardır. Bu yazıda, AI blueprint’ini her iki akışı da düzenli aralıklarla parçalara ayırarak, .mpg ve .wav dosyaları olarak kaydedecek şekilde değiştirdik. Video dosyaları (.mpg) VLM tarafından işlenirken, ses dosyaları (.wav) NVIDIA Riva NIM ASR aracılığıyla API çağrısı ile yazılı metne dönüştürülür. Riva ASR NIM API’leri, birden fazla dil için en son nesil otomatik konuşma tanıma (ASR) modellerine erişim sağlar. Transkripte edilen metin, uygun video ile birlikte VLM’ye gönderilir.

AI Blueprint for video search and summarization, uzun videolar veya canlı akışları anlayabilir. Ancak, bu ajanda yalnızca kullanıcı bir soru sorduğunda videonun belirli bölümlerini anlaması gerekiyor. Akış, bir ses transkripti olup olmadığını kontrol eder. Eğer bir transkript mevcutsa, VLM devreye girer. Eğer yoksa, akış, sürekli olarak tüm video çerçevelerini işlemek yerine ses girdisi bekler.

Bir transkript tespit edildiğinde, akış hem VLM hem de büyük dil modeli (LLM) çağrılarını gerçekleştirir ve üretilen yanıt, Riva NIM metinden sese (TTS) modelini kullanarak sesli yanıt olarak kullanıcıya iletilir. Şekil 1, bu sürecin detaylı adımlarını göstermektedir.

VR Ortamını Oluşturma

Başlamak için, Meta Quest 3‘ü Oculus Link masaüstü uygulaması ile bağlayın. Kulaklık bağlı olduktan sonra, VR’da bir ortam simüle edin. NVIDIA Omniverse, endüstriyel dijitalleşme ve fiziksel AI simülasyonlarına odaklanmış OpenUSD uygulamaları geliştirme platformudur. Bu yazı, önceden yapılmış UR10 Bin Stacking simülasyonu ile birlikte Omniverse tabanlı NVIDIA Isaac Sim uygulamasını kullanmaktadır.

Simülasyon çalıştığında, Isaac Sim’i Quest’e bağlamak için NVIDIA tarafından sunulan bir dizi Create XR eklentisi etkinleştirin. Etkinleştirilmesi gereken eklentiler şunlardır:

- Omniverse XR Telemetri

- OpenXR Giriş/Çıkış

- XR için Oynatma Uzantısı

- XR için Simülatör

- UI Sahne Görünüm Araçları

- VR Deneyimi

- XR Temel Altyapısı

- XR Profil Ortak

- XR UI Kodları Profil UI’leri Oluşturma için

- XR Görüntüleme UI Kodları

- XR UI Ortak

Bu eklentiler etkinleştirildiğinde, OpenXR’ı kullanarak VR modunu başlatmak için Start VR Mode butonuna tıklayın.

Daha sonra, Windows sisteminde VR ortamını yakalamak için RTSP akışını kurun. Aşağıdaki adımları izleyin:

- mediamtx-v1.8.4 için Windows sürümünü indirin.

- İndirilen dosyayı açın ve

cd mediamtx_v1.8.4_windows_amd64komutunu kullanarak ilgili dizine gidin. - Bir

mediamtx.ymlyapılandırma dosyası oluşturun ve aynı dizine yerleştirin. .mediamtx.exekomutuyla RTSP sunucusunu başlatın.- Windows için FFmpeg’i yükleyin.

- Kurulumunuza göre aşağıdaki komutlardan birini çalıştırın. Not: bazı parametreleri uyumlu hale getirmek ve optimal akış performansı için ayarlamanız gerekebilir.

Aşağıdaki komutu, hem ekranı hem de mikrofonu yakalamak için FFmpeg’i ayarlamak üzere çalıştırın.

ffmpeg -f gdigrab -framerate 10 -i desktop -f dshow -i audio="Microphone

(Realtek(R) Audio)" -vf scale=640:480 -c:v h264_nvenc -preset fast -b:v 1M

-maxrate 1M -bufsize 2M -rtbufsize 100M -c:a aac -ac 1 -b:a 16k -map 0:v -map

1:a -f rtsp -rtsp_transport tcp rtsp://localhost:8554/stream

Aşağıdaki komutu, ekranı yakalarken önceden kaydedilmiş bir ses dosyasını çalmak için ayarlayın. Bu komut, sesi sonsuz döngüde oynatır. Sesi sadece bir kez çalmak için --stream_loop parametresini kaldırın.

ffmpeg -f gdigrab -framerate 10 -i desktop -stream_loop -1 -i fourth_audio.wav

-vf scale=640:480 -c:v h264_nvenc -qp 0 -c:a aac -b:a 16k -f rtsp

-rtsp_transport tcp rtsp://localhost:8554/stream

Pipeline’a Ses Eklemek

Girdi ve çıktı ses işleme desteği sağlamak için, ekibimiz, video arama ve özetleme AI Blueprint’inin akışını sesle birlikte video girdi almak üzere değiştirdi. Bu özellik, gelecekte VSS tarafından yerel olarak desteklenecektir.

Bu yazı için, splitmuxsink kullanarak medya alım akışını değiştirdik. Ekibimiz, gelen ses akışını çözümleyip standart bir formata dönüştüren bir ses işleme akışı ayarladı. splitmuxsink öğesi, ses verilerini bölümlere ayrılmış .wav dosyalarına yazmak için kullanıldı, böylece yönetimi ve oynatımı kolaylaştırıldı. Bu entegrasyon, hem ses hem de video akışlarının AI blueprint’inin alım akışında eş zamanlı olarak işlenmesini sağlayarak kapsamlı medya yönetimini mümkün kılar.

Aşağıda, ses iş akışını artırmak için bir örnek metod gösterilmektedir:

caps = srcbin_src_pad.query_caps()

if "audio" in caps.to_string():

decodebin = Gst.ElementFactory.make("decodebin", "decoder")

audioconvert = Gst.ElementFactory.make("audioconvert", "audioconvert")

decodebin.connect("pad-added", on_pad_added_audio, audioconvert)

wavenc = Gst.ElementFactory.make("wavenc", "wav_encoder")

splitmuxsink = Gst.ElementFactory.make("splitmuxsink", "splitmuxsink")

splitmuxsink.set_property("location", self._output_file_prefix + "_%05d.wav")

splitmuxsink.set_property("muxer", wavenc)

splitmuxsink.set_property("max-size-time", 10000000000)

splitmuxsink.connect("format-location-full", cb_format_location_audio, self)

pipeline.add(decodebin)

pipeline.add(audioconvert)

pipeline.add(splitmuxsink)

srcbin.link(decodebin)

audioconvert.link(splitmuxsink)

pipeline.set_state(Gst.State.PLAYING)

Entegrasyon

Blueprint akışı, canlı RTSP akışından oluşan video parçalarını yönetmek için bir kuyruk kullanmaktadır. Bu video parçaları, önceden belirlenmiş bir metin istemi ile birlikte VLM’ye iletilir. Ek olarak, bu kuyruğun aynı şekilde, ses parçalarını Riva NIM ASR API’sine transkribe edilmek üzere göndermek için kullanılır. Elde edilen transkripler, VLM için metin istemi olarak kullanılır.

AI blueprint alım akışı, Build a Video Search and Summarization Agent with NVIDIA AI Blueprint‘da belirtildiği gibi, tüm video parçaları için aynı girdi istemi kullanmaktadır. Ancak, duyurulan transkriplerden gelen soruları kullanarak, akış işlemeyi belirli video segmentleri için bir VQA görevine kaydıracak şekilde güncellendi. Ayrıca, eğer karşılık gelen bir ses transkripti yoksa VLM çıkarımı için video parçasını atlayarak sistemi daha verimli hale getirdik.

VLM çıkarım çıktısı, bilgi sağlamak için Bilgi Tabanı’ndan alınan bilgilerle birleştirilir. Ardından, sonuçlar son cevabı oluşturmak için LLM’ye iletilir. VLM ve LLM çıkarımından sonra, üretilen yanıt yerine web arayüzünde göstermek yerine, metin Riva TTS API’sine gönderilerek bir ses dosyasına dönüştürülür. Bu dosya daha sonra yerel Windows sistemine gönderilerek, VR kurulumunda kullanıcıya çalınır.

NVIDIA AI Blueprint ile Başlayın

Kendi AI ajanınızı NVIDIA AI Blueprint for video search and summarization kullanarak mı oluşturmak istiyorsunuz? Erken Erişim Programı‘na başvurun.

Daha fazla bilgi edinmek için bu kaynakları kontrol edin:

- VLM’ler ve görsel AI ajanları hakkında daha fazla bilgi almak için Vision for All: Unlocking Video Analytics With AI Agents adlı çevrimiçi web seminerine kaydolun.

- Projelerinizi geliştirmenize yardımcı olacak diğer üretici AI akışlarını NVIDIA Metropolis NIM akışları ile keşfedin.

- NVIDIA GTC 2025‘e kaydolun ve AI Agents for Real-Time Video Understanding and Summarization başlıklı oturumu gözden geçirin.