Yapay zeka ve veri bilimi alanındaki hızlı gelişmelerle birlikte, ölçeklenebilir, verimli ve esnek bir altyapıya olan ihtiyaç hiç bu kadar yüksek olmamıştı. Geleneksel altyapılar, modern yapay zeka iş yüklerinin taleplerini karşılamakta çoğunlukla zorlanır; bu da gelişim ve dağıtım süreçlerinde darboğazlara yol açar. Kurumlar, yapay zeka modelleri ve veri yoğun uygulamaları ölçekli bir şekilde dağıtma çabası içindeyken, bulut tabanlı teknolojiler önemli bir çözüm sunmaktadır.

Kurumların yapay zeka uygulama geliştirme sürecinde yardımcı olmak amacıyla, NVIDIA NVIDIA Cloud Native Stack (CNS) adında, açık kaynaklı bir referans mimarisi geliştirmiş ve doğrulamıştır. Bu yapı, NVIDIA’nın desteklediği tüm yapay zeka yazılımlarını test edip sertifikalandırmak için kullanılır.

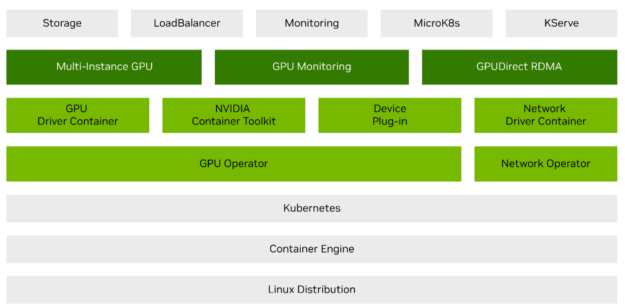

CNS, çoklu örnek GPU (MIG) ve GPUDirect RDMA gibi özelliklere kolay erişim sağlayarak, Kubernetes tarafından düzenlenen, konteynerleştirilmiş GPU hızlandırmalı uygulamaların çalıştırılmasını ve test edilmesini mümkün kılar. CNS, geliştirme ve test amaçlıdır; ancak CNS üzerinde geliştirilen uygulamalar daha sonra kurumsal Kubernetes tabanlı platformlarda üretim aşamasında çalıştırılabilir.

Bu yazı şu önemli başlıkları ele almaktadır:

- CNS’nin bileşenleri ve faydaları

- KServe ile CNS’nin yapay zeka modeli değerlendirme ve dağıtımını nasıl geliştirdiği

- Bu çözümlerle birlikte NVIDIA NIM’in AI altyapınıza entegrasyonu

CNS’nin Genel Görünümü

CNS, optimal çalışma için birlikte test edilmiş çeşitli sürümlere sahip yazılım bileşenlerini içeren bir referans mimarisi sunar. Bu bileşenler arasında şunlar bulunmaktadır:

- Kubernetes

- Helm

- Containerd

- NVIDIA GPU Operator

- NVIDIA Network Operator

NVIDIA GPU Operator, bulut tabanlı teknolojiler üzerinde yapay zeka iş yüklerinin çalıştırılmasını kolaylaştırarak, en yeni NVIDIA özelliklerinin kullanılmasını sağlar:

- Multi-Instance GPU (MIG)

- GPUDirect RDMA

- GPUDirect Storage

- GPU izleme yetenekleri

CNS ayrıca isteğe bağlı ek araçlar da içermektedir:

- microK8s

- Depolama

- LoadBalancer

- İzleme

- KServe

CNS, bu ortamların kurulumunu ve bakımını gerçekleştirmekteki karmaşıklıkların çoğunu ortadan kaldırarak, sizlerin AI uygulamalarını prototiplemeye ve test etmeye odaklanmanızı sağlar. CNS üzerinde geliştirilen uygulamalar, NVIDIA AI Enterprise tabanlı dağıtımlar ile uyumlu olacağından, geliştirme sürecinden üretime geçiş süreci de sorunsuz olacaktır. Ayrıca, bu yığın içindeki bileşenlerin belirlediği sürümlere uyumlu Kubernetes platformları, NVIDIA yapay zeka yazılımlarını desteklenen bir şekilde çalıştırma garanti altındadır.

CNS, fiziksel donanım, bulut veya sanal makine tabanlı ortamlarda dağıtılabilir. Manuel kurulumlar için Kurulum Kılavuzları ve otomasyona yönelik Ansible Oyun Kitapları mevcuttur. Daha fazla bilgi için Başlatma Kılavuzu sayfasına göz atabilirsiniz.

Ek araçlar varsayılan olarak devre dışıdır. Ek araçları etkinleştirme hakkında daha fazla bilgi için NVIDIA Cloud Native Stack Kurulumu sayfasını inceleyebilirsiniz.

Önceden yapılandırılmış bir CNS ortamında mı çalışmak istiyorsunuz? NVIDIA LaunchPad, hızlı bir başlangıç yapmak için önceden yapılandırılmış ortamlar sunmaktadır.

Yapay Zeka Model Değerlendirmesinin Geliştirilmesi

KServe, kuruluşların bulut tabanlı ortamda makine öğrenim modellerini etkin bir şekilde dağıtmasını sağlayan güçlü bir araçtır. KServe, Kubernetes’in sağladığı ölçeklenebilirlik, dayanıklılık ve esneklik sayesinde, karmaşık yapay zeka modelleri ve uygulamaların prototiplenmesi ve geliştirilmesini basit hale getirir.

CNS ile KServe, yapay zeka modeli eğitimi ve çıkarımıyla ilişkili karmaşık iş akışlarını yönetebilen Kubernetes kümelerinin dağıtımını sağlar.

KServe ile NVIDIA NIM Dağıtımı

NVIDIA NIM‘i KServe ile CNS üzerinde dağıtmak, geliştirme sürecini basitleştirirken, AI iş akışlarınızın ölçeklenebilir, dayanıklı ve yönetiminin kolay olmasını sağlar. Kubernetes ve KServe kullanarak, NVIDIA NIM’i diğer mikro hizmetlerle entegre edebilir, güçlü ve verimli bir yapay zeka uygulama geliştirme platformu oluşturabilirsiniz. Daha fazla bilgi için KServe Sağlayıcıları Bulutlar ve Veri Merkezlerinde NIMble Çıkarım Sunuyor yazısına göz atabilirsiniz.

KServe’nin küme üzerinde dağıtımını gerçekleştirmek için CNS ile KServe’yi etkinleştirme yönergelerini izleyin. KServe dağıtıldıktan sonra, dağıtılan modelin performansını izlemek ve hizmetleri gerektiği gibi ölçeklendirmek için depolama ve izleme seçeneklerini etkinleştirmenizi öneririz.

Daha sonra KServe Üzerinde NIM Dağıtımı için adımları takip edebilirsiniz. NIM’i farklı şekillerde dağıtma hakkında daha fazla bilgi için NIM-Deploy’u inceleyebilir, NIM’in KServe ve Helm grafiklerini kullanarak nasıl dağıtılabileceğine dair örnekler bulabilirsiniz.

Sonuç

CNS, geliştirme ve test amaçlı tasarlanmış bir referans mimarisidir. Bu yapı, üretici yapay zeka ve veri bilimi iş yüklerinin dağıtımında ve yönetiminde önemli bir ilerleme sunmaktadır çünkü CNS yazılım yığını, tamamen birlikte çalışabilmesi için test edilmiştir.

CNS, KServe ile birleştiğinde, yapay zeka model ve uygulama geliştirmeyi basit bir hale getirir. Bu doğrulanmış referans mimarisi ile altyapı yönetiminin karmaşıklıklarını aşabilir, yapay zeka girişimlerinizde yeniliği sürdürmek için odaklanabilirsiniz. Fiziksel donanım, bulut veya sanal makine tabanlı ortamlarda çalıştırma esnekliği; ölçeklenebilirlik ve kullanım kolaylığı, CNS’yi her boyuttaki kuruluş için ideal bir seçim haline getirir.

İster NIM mikro hizmetlerini dağıtıyor olun, ister KServe’yi model sunumu için kullanıyor olun, isterseniz gelişmiş GPU özelliklerini entegre ediyor olun, CNS, yapay zeka yeniliğini hızlandırmak ve güçlü çözümleri daha verimli ve kolay bir şekilde üretime geçirebilmek için gereken araçlar ve yetenekleri sunmaktadır.