Amazon Web Services (AWS) geliştiricileri ve çözüm mimarları, artık NVIDIA Dynamo‘nun NVIDIA GPU tabanlı Amazon EC2 üzerinde kullanılabileceğinden faydalanacaklar. Bu güncelleme, Amazon EC2 P6 NVIDIA Blackwell ile hızlandırılmış sunucularda, Amazon Simple Storage (S3) desteği ile birlikte mevcut Amazon Elastic Kubernetes Services (EKS) ve AWS Elastic Fabric Adapter (EFA) ile entegrasyon sağlıyor. Bu gelişme, büyük dil modellerinin (LLM’lerin) ölçekli olarak sunulmasında yeni bir performans, ölçeklenebilirlik ve maliyet verimliliği düzeyi açıyor.

NVIDIA Dynamo ile Generatif AI Sunumu

NVIDIA Dynamo, büyük ölçekli dağıtık ortamlar için özel olarak geliştirilmiş açık kaynaklı bir inferans sunum çerçevesidir. PyTorch, SGLang, TensorRT-LLM ve vLLM gibi tüm önde gelen inferans çerçevelerini desteklemektedir. Ayrıca, aşağıdaki gibi gelişmiş optimizasyon yetenekleri de sunmaktadır:

- Dağıtılmış Sunum: Önceki and decoding aşamalarını ayrı GPU’larda ayırarak verimliliği artırır.

- LLM-Farkındalıklı Yönlendirme: Talepleri yönlendirerek KV önbellek hit oranlarını maksimize eder ve yeniden hesaplama maliyetlerinden kaçınır.

- KV Önbellek Aşırı Yükleme: KV önbelleği, maliyet verimli bellek hiyerarşilerine aktararak inferans maliyetlerini azaltır.

Bu özellikler birlikte NVIDIA Dynamo‘nun büyük ölçekli, çok düğümlü LLM dağıtımları için en iyi inferans performansını ve maliyet verimliliğini sunmasını sağlar.

AWS Hizmetleri ile Sorunsuz Entegrasyon

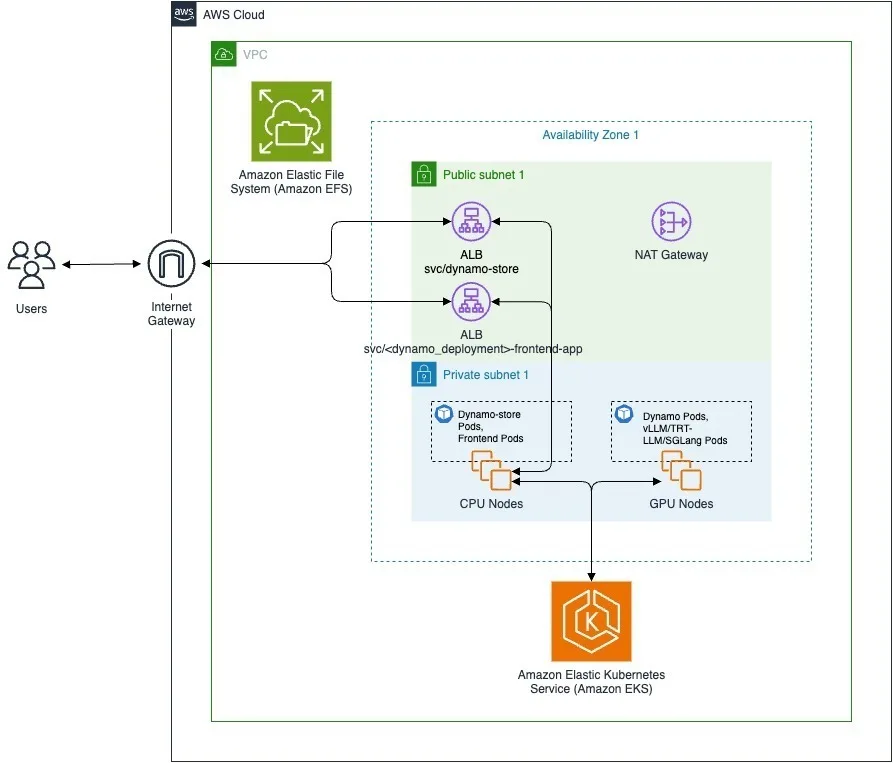

AWS bulutunda LLM sunan geliştiriciler ve çözüm mimarları için Dynamo, mevcut inferans mimarinize sorunsuz bir şekilde entegre olacaktır:

- Amazon S3: Dynamo NIXL, neredeyse sınırsız ölçeklenebilirlik, yüksek performans ve düşük maliyetler sunan bir nesne depolama hizmeti olan Amazon S3’yi destekliyor.

KV önbellek hesaplaması kaynak yoğun ve maliyetli olabilir. Önceden hesaplanan değerlerin yeniden kullanılmasının yaygın bir uygulama olduğunda, büyüyen AI iş yükleri ile birlikte kullanılacak KV önbellek miktarı hızla GPU ve ana hafızayı aşabilir. KV önbelleğini S3’e aktararak, geliştiriciler yeni talepleri sunmak için değerli GPU bellek alanı açabilir. Bu entegrasyon, geliştiricilerin özel eklentiler kurmaktan kurtararak KV önbelleğini S3’e aktarmayı kolaylaştırıyor ve toplam inferans maliyetlerini azaltıyor.

- Amazon EKS: Dynamo, Kubernetes altyapısını yönetmeden konteynerleştirilmiş uygulamaları çalıştırıp ölçeklendirebileceğiniz tam yönetilen bir hizmet olan Amazon EKS üzerinde çalışır.

LLM’lerin boyutu ve karmaşıklığı arttıkça, üretim inferans dağıtımı, LLM-farkındalıklı talep yönlendirme, dağıtılmış sunum ve KV önbelleği aşırı yükleme gibi gelişmiş bileşenler gerektirmektedir. Bu bileşenlerin sıkı entegrasyonu, Kubernetes ortamlarında dağıtımda karmaşıklık katmaktadır. Bu destek sayesinde, geliştiriciler Dynamo’yu EKS yönetimindeki Kubernetes kümelerine sorunsuz bir şekilde dağıtarak, inferans iş yükü artışlarını karşılamak için yeni Dynamo kopyalarını hızla hayata geçirebilirler.

- AWS Elastic Fabric Adapter (EFA): Dynamo’nun NIXL veri transfer kütüphanesi, Amazon EC2 örnekleri arasındaki düşük gecikmeli iletişim sağlayan bir ağ arayüzü olan Amazon EFA’yı destekler.

LLM’ler boyut olarak büyüdüğünde ve seyrek Uzmanlar Miktarı (Mixture of Experts) yapısını benimsediğinde, bunları birden fazla GPU’ya bölmek, verimliliği artırırken gecikmeyi düşürmektedir. Bu durumda, AWS üzerindeki işlemler için GPU düğümleri arasındaki inferans veri transferleri EFA aracılığıyla gerçekleşir. Dynamo’nun EFA desteği ile geliştiriciler, KV önbelleği düğümleri arasında, NIXL’nin ön yüz API’si aracılığıyla basit get, push, ve delete komutlarıyla hızlıca aktarım yapabilirler. Bu, geliştiricilerin özel eklentiler olmadan, dağıtılmış sunumu gibi Dynamo’nun gelişmiş özelliklerine erişimini sağlar ve AI uygulamalarının üretime geçiş süresini hızlandırır.

Blackwell Tabanlı Amazon P6 İle Inferansı Optimize Etme

Dynamo, her NVIDIA GPU hızlandırmalı AWS örneği ile uyumludur, ancak Amazon EC2 P6 örnekleri ile birleştirildiğinde, DeepSeek R1 ve en son Llama 4 gibi gelişmiş akıl yürütme modelleri için önemli bir performans artışı sağlar. Dynamo, dağıtılmış MoE model sunumunun karmaşıklıklarını yöneterek kritik görevleri otomatikleştirir. Bu görevler, prefill ve decode otomatik ölçeklendirmesini ve oran eşleştirmeyi içerir.

Öte yandan, Amazon P6-B200 örneği, beşinci nesil Tensor Cores, FP4 hızlandırma ve önceki nesile kıyasla iki kat daha fazla NVIDIA NVLink bant genişliği sunmaktadır. P6e-GB200 Ultra Sunucuları, NVIDIA’nın GB200 NVL72 ile güçlendirilmiş özgün ölçekleme mimarisi, MoE dağıtımlarında geniş uzman-paralel yenileme işlemleri için gerekli yoğun iletişim desenlerini hızlandırmak amacıyla 130 TBps toplu alışveriş bant genişliği sunmaktadır. Dynamo ve P6 güçlendirilmiş Blackwell örneklerinin birleşimi, GPU kullanımını artırarak, dolar başına talep verimliliğini artırmakta ve üretim ölçeğindeki AI iş yükleri için sürdürülebilir kar büyümesini teşvik etmektedir.

Dynamo ile Başlayın

Dynamo’nun AWS ile entegrasyonunu derinleştirmek, geliştiricilerin inferans iş yüklerini sorunsuz bir şekilde ölçeklendirmesine yardımcı olmaktadır.

NVIDIA Dynamo, her NVIDIA GPU hızlandırmalı AWS örneğinde çalışır. Inferans yığınızı optimize etmeye başlamak için NVIDIA Dynamo ile dağıtım yapmaya başlayın.