SemiAnalysis, InferenceMAX™ v1 adlı yeni andalık bir açık kaynak girişimini başlattı. Bu girişim, çıkarım donanım performansını değerlendirmek için kapsamlı bir metodoloji sunuyor. Yayınlanan sonuçlar, NVIDIA GPU’larının tüm iş yükleri arasında en yüksek çıkarım performansını sağladığını gösteriyor.

Veriler ne diyor? NVIDIA Blackwell, Hopper nesline göre %15 oranında bir performans artışı sundu ve bu, %15 oranında bir kazanç fırsatı oluşturdu (Şekil 1). Bu sektörde lider performans ve kârlılık, ekstrem donanım-yazılım birlikte tasarımına dayanıyor. Bu tasarım, NVFP4 düşük hassasiyet formatı için yerel destek, beşinci nesil NVIDIA NVLink ve TensorRT-LLM ile Dynamo çıkarım çerçevelerini içeriyor.

Şimdi açık kaynak olan InferenceMAX v1 ile, AI topluluğu NVIDIA’nın sektördeki performansını yeniden üretme fırsatına sahip. Müşterilerimizi, ortaklarımızı ve geniş ekosistemimizi, bu tarifleri kullanarak günlük AI çıkarım senaryolarında NVIDIA Blackwell’ın çok yönlülüğünü ve performans liderliğini doğrulamaya davet ediyoruz.

Bu bağımsız üçüncü taraf değerlendirmesi, NVIDIA çıkarım platformunun büyük ölçekli AI uygulamaları için sunduğu dünya standartlarındaki performansı bir kez daha gösteriyor.

InferenceMAX v1 Hakkında

InferenceMAX v1’in önemli bir farklılaştırıcı özelliği, sürekli otomatik testlerdir. Benchmark taramaları ile elde edilen sonuçlar, her gün yayınlanıyor ve SGLang, TensorRT-LLM ve vLLM gibi birden fazla çıkarım çerçevesinde gerçekleştirilerek son yazılım sürümlerinden elde edilen performans iyileştirmelerini yakalayacak şekilde testler yapılıyor.

Benchmarklar, ister tek düğüm ister çoklu düğüm geniş Uzman Paralelliği (EP) yapılandırmaları ile yapılsın, gerçek üretim ortamlarındaki çeşitli dağıtım senaryolarını yansıtacak şekilde kapsamlı sonuçlar sağlar. Modeler, hassasiyetler, girdi dizisi uzunlukları (ISL) ve çıktı dizisi uzunlukları (OSL) hakkında daha fazla bilgi içeren Tablo 1 bulunmaktadır. Değişken dizi uzunlukları kullanılarak, gerçek dünya uygulamalarının dinamik doğasını yansıtmak için %80-100 ISL/OSL kombinasyonu kullanılır.

| Model | Tip | Parametreler | Hassasiyetler | Sohbet (ISL/OSL) | Özetleme (ISL/OSL) | Derin Akıl yürütme (ISL/OSL) |

| DeepSeek-R1 | MoE | 671B (37B aktif) |

FP8, NVFP4 | 1K/1K | 8K/1K | 1K/8K |

| gpt-oss-120b | MoE | 117B (5.1B aktif) | FP8, MXFP4 | 1K/1K | 8K/1K | 1K/8K |

| Llama 3.3 70B | Yoğun | 70B | FP8, NVFP4 | 1K/1K | 8K/1K | 1K/8K |

InferenceMAX v1, akıl yürütme görevleri, belge işleme ve özetleme ile sohbet senaryolarını kapsayan gecikme, iş yükü, partiler ve çeşitli girdi/çıktı oranları gibi çoklu boyutlarda veri sunuyor.

NVIDIA Blackwell InferenceMAX v1’de Nasıl Performans Gösterdi?

InferenceMAX v1 benchmark verileri, NVIDIA’nın Hopper HGX H200 modelinden NVIDIA Blackwell DGX B200 ve NVIDIA GB200 NVL72 platformlarına geçişin etkinlik ve maliyet etkililiğinde kayda değer kazançlar sağladığını açıkça gösteriyor. Blackwell, yerel FP4 hızlandırmalı beşinci nesil Tensor Core’lar ile 1,800 GB/s NVLink bant genişliği sunmakta ve en güncel HBM3e belleğini kullanmaktadır.

Bu, watt başına hesaplama oranında ve bellek bant genişliğinde beş kat artış sağlamaktadır; bu da Hopper nesline göre çok daha iyi enerji verimliliği ve çok daha düşük milyon token başına maliyet sunmaktadır.

Bu yazı, bu sonuçların arkasındaki çarpıcı yenilikleri araştırmakta ve Blackwell mimarisinin bu kadar olağanüstü performansı nasıl sağladığını detaylandırmaktadır.

Sürekli Yazılım İyileştirmeleri Performansı Zamanla Artırıyor

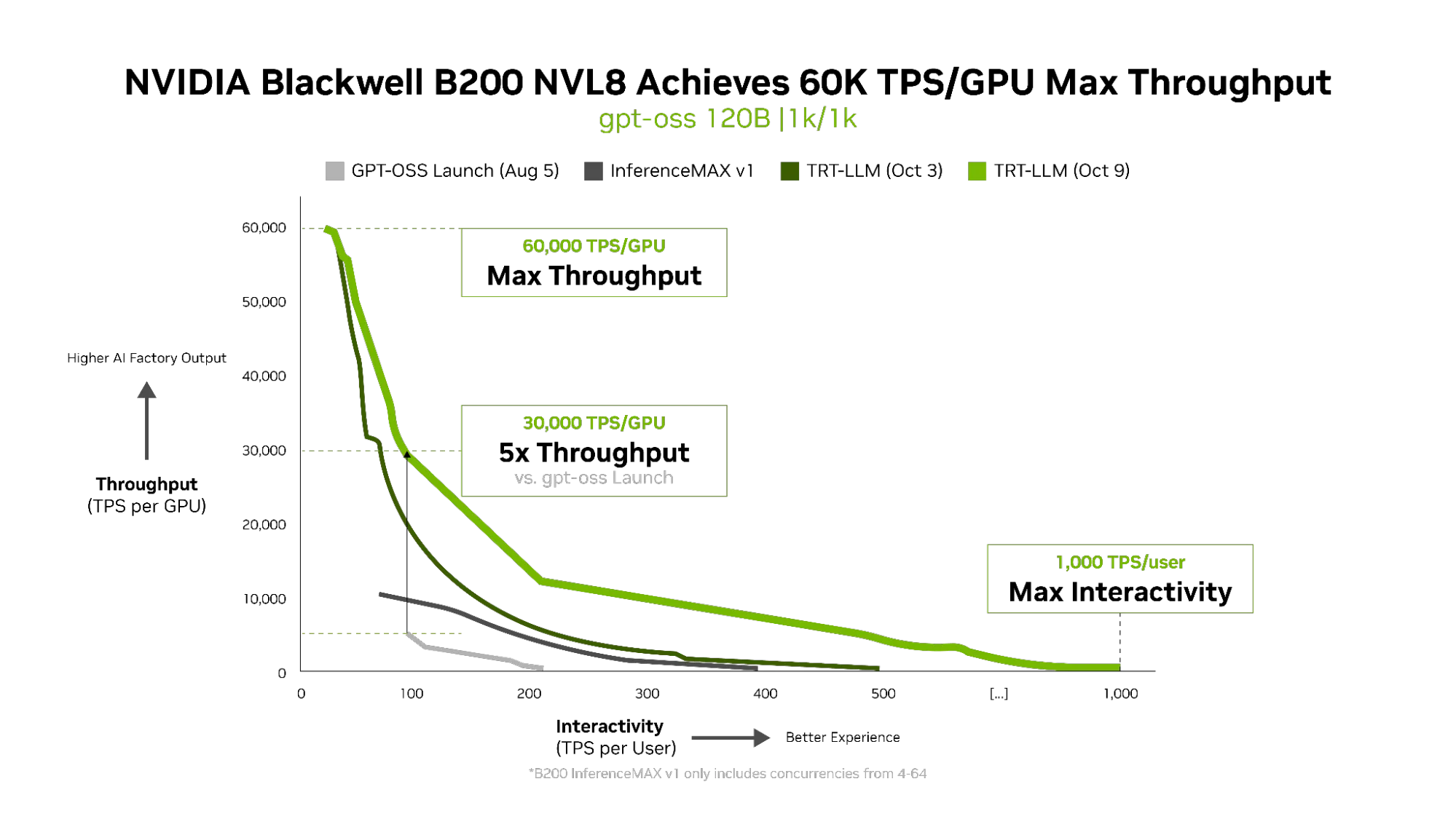

NVIDIA, donanım yeniliklerinin sürekli akışına ek olarak, yazılım iyileştirmeleri ile sürekli performans artışları sağlamaktadır. gpt-oss-120b modelinin ilk lansmanında Blackwell B200 ile TensorRT-LLM performansı oldukça iyi olmakla beraber, başlangıçtaki GPU başına throughput değerleri günümüzdeki en iyi değerlerin altında kalmıştır. Kısa bir süre içinde, NVIDIA mühendislik ekipleri ve daha geniş topluluk, açık kaynak LLM’ler için TensorRT-LLM yığını optimize etmek için yoğun çalışmalar yapmış ve belirgin bir performans artışı elde etmiştir (Şekil 2).

B200 InferenceMAX v1 yapılandırması, 5 Ağustos’ta gpt-oss’ın lansmanından bu yana elde edilen ilerlemeleri göstermektedir. Yaklaşık 100 TPS/kullanıcı değerinde, B200 InferenceMax v1 benchmarkında başlangıç gününe göre neredeyse iki kat daha iyi bir throughput elde etmiştir.

9 Ekim’de yayınlanan en son TensorRT-LLM sürümü, güçlü yeni özellikler ekleyerek 100 TPS/kullanıcıda maksimum throughput’unu başlangıçtaki 6K’dan 30K’ya kadar çıkarmaktadır. Bu, InferenceMAX şu anda yalnızca 4-64 arasında test yaptığı için elde edilen daha yüksek eşzamanlılıkların dikkate alınmasını zorunlu hale getirmektedir.

Ayrıca, DEP gibi paralellik yapılandırmaları, gpt-oss-120b’nin Dikkat ve MoE katmanlarını birden fazla GPU arasında dağıtarak yüksek throughput elde etmektedir. Bu hızlı, tüm yönlü iletişim, NVLink ve NVLink Switch’in 1,800 GB/s iki yönlü bant genişliği tarafından mümkün hale getirilmektedir. Sonuç olarak, elde edilen yüksek eşzamanlılık, sistemi tüm kullanıcılar için tam hızda birçok eşzamanlı çıkarım talebini karşılamayı sağlamakta ve donanımın tamamen kullanılmasını sağlamaktadır (Şekil 3).

Örneğin, tam DEP2 düzeninde, her talep için dikkati bir GPU üzerinde işlerken (KV önbelleği yerelleştirilmiştir) MoE katmanlarındaki uzman tokenleri dinamik olarak iki GPU arasında (her GPU başına 64 uzman) yönlendirilir ve işlenir. NVLink Switch yapısı, bu uzman tokenlerinin gecikme olmaksızın dağıtılmasını ve toplanmasını sağlamaktadır; bu da GPU’lar arasındaki anında ve doğrudan değiş tokuşları destekler.

Önemli bir başka gelişme ise, EAGLE-destekli spekülatif çözümlemenin gpt-oss-120b için etkinleştirilmesidir. EAGLE bu modelde, 100 TPS/kullanıcıda GPU başına throughput’u yayımlanan InferenceMAX v1 sonuçlarına göre üç kat artırarak 10K’…