NVIDIA’nın RTX AI platformu, Windows uygulama geliştirenler için binlerce açık kaynak modeli bir araya getiren zengin bir ekosistem sunmaktadır. Bu bağlamda, 2023 yılında piyasaya sürülen ve 65K’dan fazla GitHub yıldızına sahip olan llama.cpp, popüler bir araç olarak öne çıkmaktadır. Bu açık kaynaklı proje, çeşitli donanım platformlarında çalışabilen hafif ve verimli bir büyük dil modeli (LLM) çıkarımı için bir çerçeve sunmaktadır.

Bu yazıda, RTX PC’lerde llama.cpp kullanımının, LLM işlevselliği gerektiren çapraz platform veya Windows yerel uygulamaları geliştirmek için nasıl etkili bir çözüm sunduğunu açıklayacağız.

Llama.cpp Hakkında Genel Bilgi

Büyük dil modelleri, heyecan verici yeni kullanım alanlarının kapılarını aralasa da, büyük bellek ve hesaplama gücü gereksinimleri nedeniyle geliştiricilerin bunları üretim uygulamalarında kullanmasını zor hale getirmektedir. Bu sorunu aşmak için llama.cpp, model performansını optimize etmeye ve geniş bir donanım yelpazesinde etkili bir şekilde dağıtım yapmaya olanak tanıyan kapsamlı bir özellik seti sunmaktadır.

llama.cpp’nın temelinde, makine öğrenimi için geliştirilmiş olan ggml tensor kütüphanesi bulunmaktadır. Bu hafif yazılım yığını, llama.cpp’nın harici bağımlılıklar olmadan çapraz platformda kullanılmasını sağlar. Son derecede bellek verimli olan bu yapı, yerel cihazlarda çıkarım yapmak için ideal bir seçimdir. Model verileri, llama.cpp katkı sağlayıcıları tarafından özel olarak tasarlanmış ve uygulanmış GGUF adında özelleştirilmiş bir dosya formatında paketlenip dağıtılmaktadır.

llama.cpp ile projeler geliştiren geliştiriciler, yüksek kaliteli kuantizasyonları kapsayan binlerce önceden paketlenmiş model arasında seçim yapabilirler. Gelişen açık kaynak topluluğu, llama.cpp ve ggml projelerini aktif olarak geliştirmektedir.

NVIDIA RTX Üzerinde Llama.cpp Performansının Artırılması

NVIDIA, RTX GPU’lar üzerinde llama.cpp performansını ve geliştirici deneyimini iyileştirmek için iş birliği yapmaya devam etmektedir. Bu katkılar arasında şunlar yer almaktadır:

- Kernels arasında geçiş sürelerini azaltmak ve token’ler oluşturmak için CUDA Graphs uygulaması.

- ggml grafiklerini hazırlarken CPU üzerindeki yüklerin azaltılması.

En son katkılar hakkında daha fazla bilgi için CUDA Graphs ile Llama.cpp AI Çıkarımının Optimize Edilmesi adlı makaleye göz atabilirsiniz.

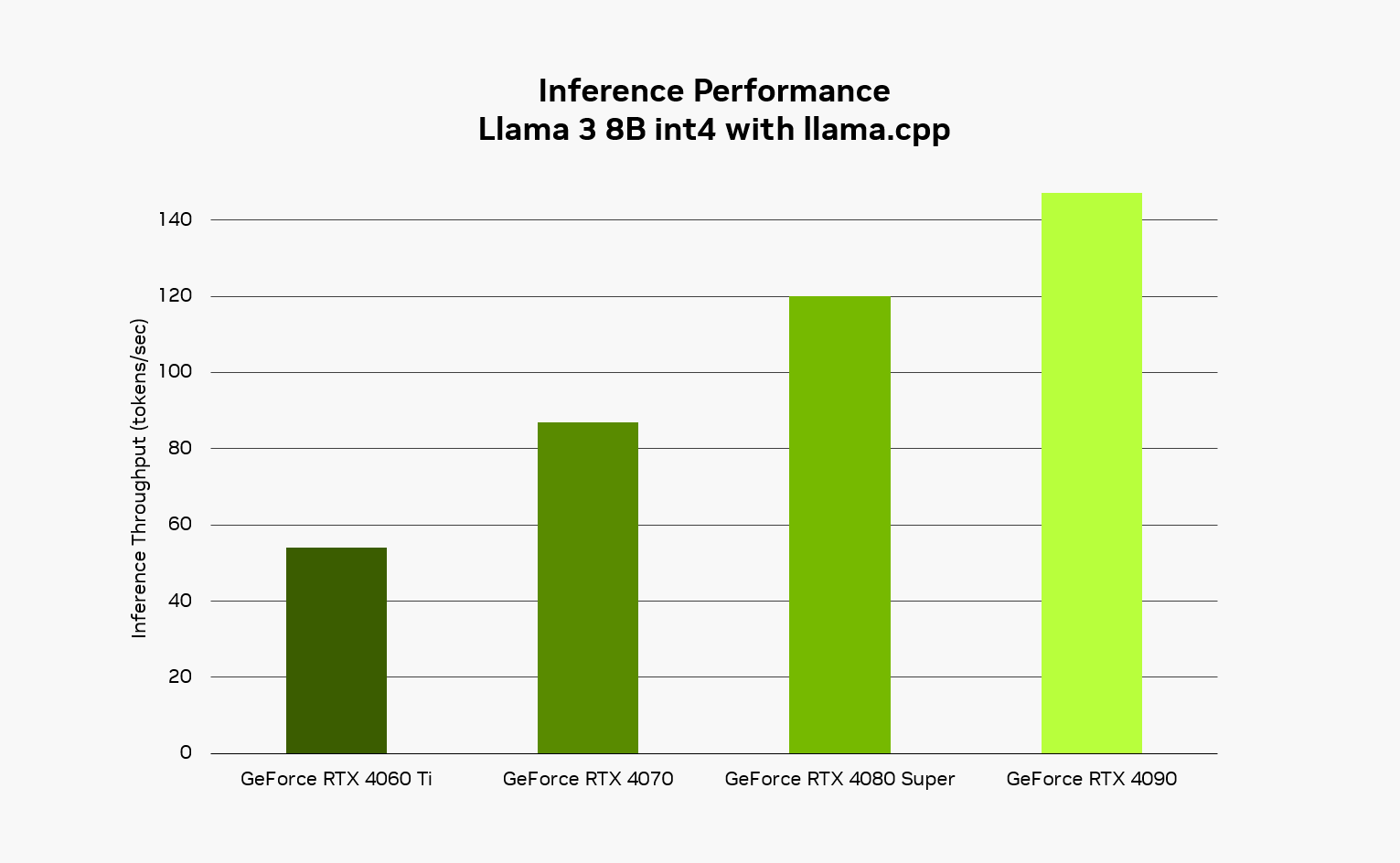

Şekil 1, NVIDIA iç ölçümleriyle, Llama 3 8B modelinin llama.cpp kullanılarak dört farklı NVIDIA GeForce RTX GPU’daki verimlilik performansını göstermektedir. NVIDIA RTX 4090 GPU üzerinde kullanıcılar, 100 token girişi ve 100 token çıkışıyla saniyede yaklaşık 150 token bekleyebilirler.

NVIDIA GPU optimizasyonları ile llama.cpp kütüphanesini oluşturmak için llama.cpp/docs adresini ziyaret edebilirsiniz.

Llama.cpp Kullanarak Geliştirici Ekosistemi

llama.cpp üzerine inşa edilmiş geniş bir geliştirici çerçeveleri ve soyutlamaları ekosistemi, uygulama geliştirme sürecini hızlandırmak için geliştiricilerin hizmetindedir. Ollama, Homebrew ve LMStudio gibi popüler geliştirici araçları, llama.cpp’nın işlevselliğini kullanarak soyutlanmış geliştirici deneyimleri sunmaktadır. Bu araçların bazı temel işlevleri arasında yapılandırma ve bağımlılık yönetimi, model ağırlıklarının paketlenmesi, soyutlanmış kullanıcı arayüzleri ve LLM için yerel bir API uç noktası oluşturma bulunmaktadır.

Ayrıca, RTX sistemlerinde kullanılmak üzere optimize edilmiş geniş bir model ekosistemi de bulunmaktadır. Bu kapsamda, Llama 3.2 en son GGUF kuantize versiyonları ile dikkat çekmektedir.

bunun yanı sıra, llama.cpp, NVIDIA RTX AI Toolkit kapsamında çıkarım dağıtım mekanizması olarak sunulmaktadır.

Llama.cpp ile Hızlandırılan Uygulamalar

Günümüzde, llama.cpp ile hızlandırılan 50’den fazla araç ve uygulama bulunmaktadır. Bunlar arasında şunlar yer alıyor:

- Backyard.ai: Kullanıcıların sevdikleri karakterlerle sanal ortamda etkileşim kurarak yaratıcılıklarını ortaya çıkarmalarını sağlayan bu platform, llama.cpp’yı kullanan RTX sistemlerinde LLM modellerini hızlandırmaktadır.

- Brave: Brave tarayıcısına entegre edilen Leo adlı akıllı AI asistanı sayesinde kullanıcılar, gizliliği koruyarak sorular sorabilir, sayfa ve PDF’leri özetleyebilir, kod yazabilir ve yeni metinler oluşturabilir. Leo, RTX sistemlerinde yerel LLM’lerle etkileşime geçebilmek için llama.cpp’dan yararlanan Ollama ile birlikte çalışmaktadır.

- Opera: Opera, geliştirici versiyonu olan Opera One ile kullanıcıların tarayıcı ihtiyaçlarını karşılamak üzere Yerel AI Modellerini entegre etmiştir. Aria adı verilen bu tarayıcı AI’sı, kullanıcıların web sayfaları hakkında özetler almak, metin ve resimler oluşturmak ve 50’den fazla dilde yanıtları sesli olarak okumak gibi yetenekler sunmaktadır.

- Sourcegraph: Sourcegraph Cody, en güncel LLM’leri destekleyen bir AI kod asistanıdır. Cody, yerel makine üzerindeki modellerle veya havalı alanlarda çalışabilir. Ollama’yı kullanarak llama.cpp ile yerel çıkarım desteği sağlar.

Başlamak İçin

RTX AI PC’lerde llama.cpp kullanmak, geliştiricilere AI iş yüklerini GPU’lar üzerinde hızlandırmak için çekici bir çözüm sunar. Llama.cpp ile geliştiriciler, hafif bir kurulum paketiyle LLM çıkarımı için C++ uygulamasından yararlanabilirler. Daha fazla bilgi almak ve başlamanın yollarını görmek için NVIDIA RTX AI Toolkit’e göz atabilirsiniz.

NVIDIA, RTX AI platformu üzerinde açık kaynak yazılımlara katkıda bulunma ve bu yazılımları hızlandırma taahhüdüne sahiptir.