Çeviri, şirketlerin uluslararası alanda büyümesine olanak tanıyan önemli bir süreçtir. Ancak, bu süreçte gereksinimler, ton, doğruluk ve teknik terminoloji yönetimi açısından önemli ölçüde farklılık gösterir. Sovereign AI kavramının ortaya çıkması, büyük dil modelleri (LLM’ler) açısından kritik zorlukları öne çıkardı ve bu modellerin İngilizce ağırlıklı çerçevelerin ötesindeki kültürel ve dilsel bağlamları yakalamada yaşadığı güçlükleri sergiledi. Küresel iletişim giderek karmaşıklaştıkça, organizasyonların teknolojik verimlilik ile kültürel duyarlılık ve dil hassasiyeti arasında bir denge sağlamak için çeviri çözümlerini dikkatlice değerlendirmesi gerekmektedir.

Bu yazıda, LLM’lerin İngilizce’den Geleneksel Çince’ye çeviri konusundaki iki farklı kullanım durumunu nasıl ele alabileceğini inceliyoruz:

Pazarlama içeriklerinin çevirisi

Teknik metni hassasiyetle çevirirken, doğal bir tanıtım tonu sağlamak.

Çevrimiçi eğitim kursları

Jupyter Notebooks gibi platformlarda kullanılan slayt metni ve markdown içeriğini çevirerek, teknik çevirinin yanı sıra başlıklar, bölümler ve bağlantı gibi uygun markdown formatlamasını sağlamak.

Bu kullanım durumları, genel çevirinin ötesinde, özel bir yaklaşım gerektirmektedir. Talep mühendisliği ile talimat-açıklıklı LLM’ler belirli bağlamları ele alabilse de, bu tür daha ince görevler genellikle beklentileri karşılamamaktadır. LoRA adaptörlerinin, her çeviri bağlamına özgü toplanmış veri setlerinde ayrı ayrı ince ayar yapılması burada esas bir ihtiyaç haline gelmektedir.

Özelleşmiş çeviri için LoRA adaptörlerini uygulamak

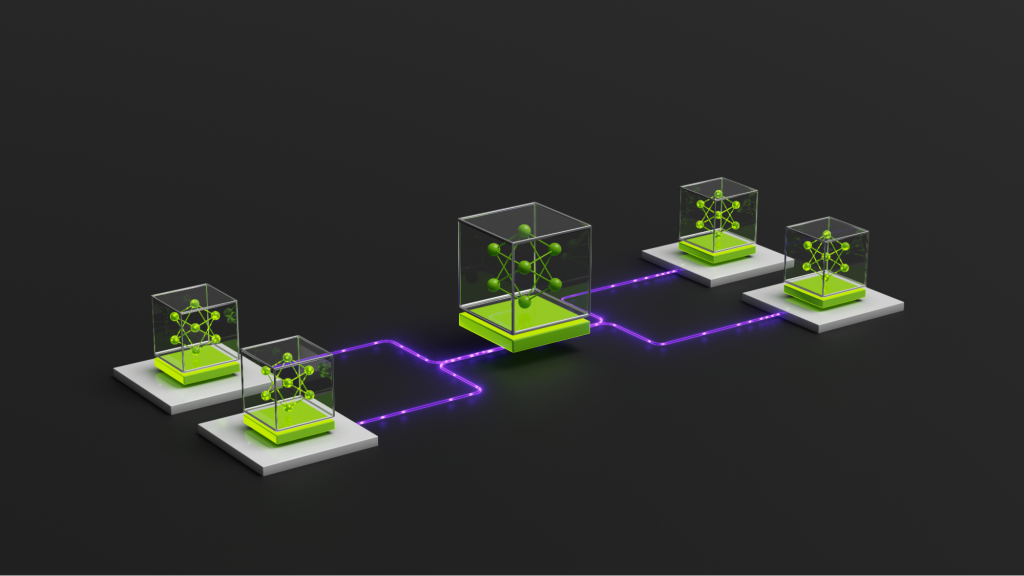

Bu projede, Llama 3.1 8B Instruct modelini önceden eğitilmiş model olarak kullanıyoruz ve NVIDIA NeMo Framework kullanarak iki LoRA adaptörü ile ince ayar yapılmış modeli uyguluyoruz. Bu adaptörler, birisi pazarlama web içerikleri, diğeri çevrimiçi eğitim kursları için olmak üzere alanlara özel veri setlerine göre eğitilmiştir. Aynı önceden eğitilmiş model üzerinde birden fazla LoRA adaptörünün eş zamanlı kullanımı için NVIDIA NIM kullanıyoruz.

LoRA adaptörleri, modelin parametrelerinin yalnızca bir kısmını ayarlayarak verimli ince ayar yapılmasına olanak tanıyan güçlü bir özelleştirme tekniğidir. Bu, gereken hesaplama kaynaklarını önemli ölçüde azaltır. LoRA, etkinliği ve verimliliği nedeniyle popüler hale gelmiştir. Tam parametre ince ayarının aksine, LoRA adaptör ağırlıkları daha küçüktür ve önceden eğitilmiş modelden ayrı olarak depolanabilir, bu da dağıtımda daha fazla esneklik sağlar.

NVIDIA NIM ile LLM dağıtımını optimize etmek

NVIDIA NIM, profesyonel LLM hizmetlerinin dağıtımında performans, güvenilirlik, çeviklik ve kontrol sağlamak için yeni bir düzey sunar. Farklı GPU türlerine uygun haltında oluşturulmuş konteynerler ve optimize edilmiş model motorları ile LLM’leri kolayca dağıtarak hizmet performansını artırabilirsiniz. LoRA çoklu adaptör mekanizması, aynı önceden eğitilmiş model üzerinde birden çok LoRA adaptörünü eş zamanlı olarak kullanmanıza imkan tanımaktadır. Bu özellik, NIM tarafından da desteklenmektedir.

Bu bölüm, çok amaçlı çeviri görevlerinde bu özelliklerin avantajlarını ve www.pazarına nasıl uygulanabileceğini göstermektedir.

NVIDIA LLM NIM ile LoRA ince ayar dağıtımının adım adım süreci

Bu bölüm, NVIDIA LLM NIM kullanarak LoRA ince ayar dağıtımı için izlenecek üç adımı açıklamaktadır:

Adım 1: NIM örneğini ve LoRA modellerini ayarlayın

Öncelikle, NVIDIA L40S GPU ile donatılmış bir hesaplama örneği başlatın. Ardından iki ince ayar yapılmış NeMo dosyasını bu ortama yükleyin. LoRA ince ayarı hakkında daha fazla bilgiye NVIDIA NeMo Framework resmi belgelerinden ulaşabilirsiniz.

Adım 2: NIM ve LoRA modellerini dağıtın

NIM konteynerini dağıtma işlemine geçin. Aşağıdaki komutları çalıştırmadan önce <NGC_API_KEY> kısmını gerçek NGC API anahtarınızla değiştirin:

$ export NGC_API_KEY=<NGC_API_KEY>

$ export LOCAL_PEFT_DIRECTORY=$(pwd)/loras

$ export NIM_PEFT_SOURCE=/home/nvs/loras

$ export CONTAINER_NAME=nim-llama-3.1-8b-instruct

$ export NIM_CACHE_PATH=$(pwd)/nim-cache

$ mkdir -p "$NIM_CACHE_PATH"

$ chmod -R 777 $NIM_CACHE_PATH

$ echo "$NGC_API_KEY" | docker login nvcr.io --username '$oauthtoken' --password-stdin

$ docker run -it --rm --name=$CONTAINER_NAME

--runtime=nvidia

--gpus all

--shm-size=16GB

-e NGC_API_KEY=$NGC_API_KEY

-e NIM_PEFT_SOURCE

-v $NIM_CACHE_PATH:/opt/nim/.cache

-v $LOCAL_PEFT_DIRECTORY:$NIM_PEFT_SOURCE

-p 8000:8000

nvcr.io/nim/meta/llama-3.1-8b-instruct:1.1.2

Adım 3: İnce ayar yapılmış LoRA modellerinin çeviri kalitesini değerlendirin

NIM çalışır duruma geldiğinde, İngilizce’den Geleneksel Çince çeviri yapmak için LoRA model ismimizi talep gövdesinde belirtmemiz gerekir.

İnce ayar sonuçları ve performans metrikleri

İki test veri setinin çeviri kalitesini, önceden eğitilmiş model ve iki LoRA ince ayar modelinin çıktıları olarak değerlendirdik. Bu değerlendirmeden elde edilen BLEU ve COMET skorları, çeviri kalitesinin belirgin bir ölçütüdür.

Bu sonuçlar, LoRA mekanizmasını kullanarak özel veri setlerinde ince ayarlamanın çeviri kalitesini artırdığını göstermektedir. Elde edilen sonuçların daha iyi olduğunu göstermek için aşağıdaki karşılaştırma yapılabilir:

LoRA modeli, web veri seti üzerinde ince ayar yapıldığında web ile ilgili çevirilerde daha belirgin bir iyileşme göstermiştir.

Daha Fazlasını Keşfedin: NVIDIA NIM ve LoRA İnce Ayarı

LoRA adaptörleri ile ayrı ayrı ince ayar yaparak, pazarlama içerikleri ve çevrimiçi eğitim kursu veri setleri üzerinden çeviri kalitesinin kayda değer şekilde arttığını görebilirsiniz. Bu süreç, alanlarına özel veri setlerinin, kendi LoRA modelleri ile eşleştirildiğinde daha iyi sonuçlar elde etmesine imkan tanır. Bu ince ayar yapılmış modelleri tek bir NVIDIA NIM örneğinde dağıtmak, çoklu özel görevleri aynı anda sunmak için GPU verimli bir çözüm sağlar.

Hazır mısınız? NVIDIA NIM mikro hizmetlerinin, LLM’leri belirli görevler için dağıtma ve ince ayar yapma konusunda nasıl yardımcı olabileceğini keşfedin. NVIDIA NeMo ile Llama 3, Mistral gibi popüler modelleri LoRA adaptörleri kullanarak ince ayarlayabilir ve uygulamalarınızın performansını artırabilirsiniz.