Bir çocuk cinsel istismarı mağduru, Apple’a, 2022’de iCloud’da depolanan çocuk cinsel istismarı materyallerini tarama planının iptal edilmesi üzerine dava açtı. Bu plan, daha önce 2021’de kullanıcıları korumak amacıyla duyurulmuştu.

Apple’ın Planı ve Geri Adımı

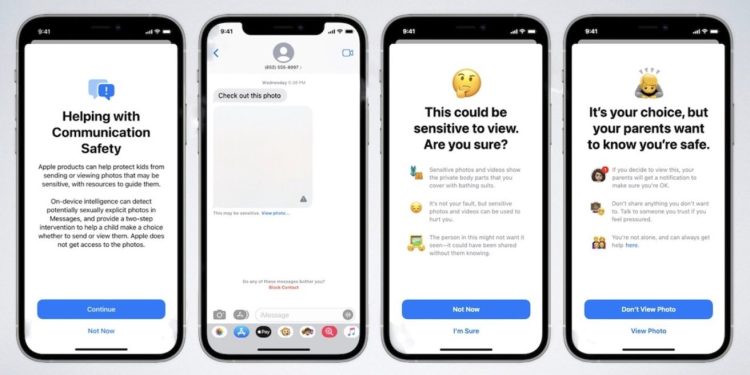

Apple, 2021 sonlarında çocuk cinsel istismarı materyalleri (CSAM) konusunda kullanıcıları korumak için, yüklenecek fotoğrafları bir hashtag sistemi kullanarak cihazda tarayacak bir plan geliştirmişti. Bu özellik, kullanıcıları algı ile tespit edilen çıplaklık konusunda uyarmayı da içeriyordu.

Ancak, bu nudity tarama sistemi hâlâ mevcutken, Apple planını iptal etti. Bu karar, gizlilik uzmanlarından, çocuk güvenliği gruplarından ve devletlerden gelen büyük bir tepkiden sonra alındı.

Mağdur Kadının Dava Açması

27 yaşındaki bir kadın, çocukken bir akrabası tarafından istismara uğramış bir mağdur olarak, Apple’a dava açtı. Dava açarken mahkemeden aldığı bir takma ad kullanıyor. Kadın, o özelliğin aktif olduğu dönemde, iCloud’da istismara ait görüntülerin saklandığına dair bir yasadışı olay bildirimi aldığını söylüyor.

Mahkemeye sunduğu belgelerle, Apple’ın çocuk cinsel istismarı mağdurlarını koruma vaadini yerine getirmediğini ve böylece istismar materyalinin geniş ölçüde paylaşılmasına olanak tanıdığını iddia ediyor.

Dava Süreci ve Olası Sonuçlar

Kadının davasında, Apple’ın uygulamalarında değişiklik yapılması ve 2,680 diğer uygun mağdur için tazminat talep ediliyor. Dava belgelerinde, Google ve Meta’nın Facebook platformlarının, Apple’ın anti-nudity özelliğinden çok daha fazla yasadışı materyali tespit ettiğine dikkat çekiliyor.

Mevcut yasalar, çocuk cinsel istismarı mağdurlarının en az 150,000 dolar kadar tazminat alma hakkına sahip olduğunu belirtiyor. Eğer davadaki tüm potansiyel davacılar tazminat kazanırsa, Apple’a yönelik tazminat miktarı 1.2 milyar doları geçebilir.

Dışarıdan Gelen Dava ve Cevaplar

Benzer bir davada, bir dokuz yaşındaki CSAM mağduru Apple’a Ağustos ayında Kuzey Carolina’da dava açtı. Bu durumda, kız çocuğu, yabancıların ona csam videoları gönderdiğini ve benzer videolar çekip yüklemesini teşvik ettiğini belirtmiştir.

Apple ise, Kuzey Carolina’daki davanın reddedilmesi için bir başvuru yaptı. Şirket, iCloud’a kullanıcılar tarafından yüklenen materyallerden dolayı işleyici sorumluluğu olmadığını savundu.

Apple, bu konuya yönelik olarak, çocuk cinsel istismarı materyalinin korkunç bir şey olduğunu belirtti ve kullanıcılarının güvenliği ve gizliliği konusunda yenilikler yapmak için çalıştığını ifade etti.