“`html

Gelişen AI Teknolojisi ve Maliyet Etkinliği

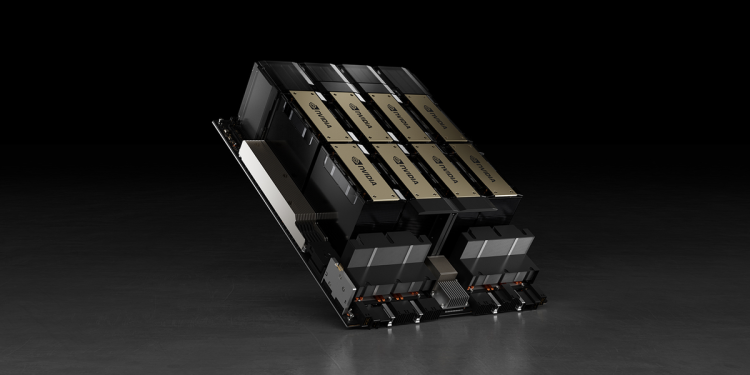

Çinli şirketler, Nvidia gibi firmaların sunduğu on binlerce gelişmiş AI GPUsuna erişim sağlayamadıkları için, bu ülkenin firmalarının ileri AI modellerini eğitmek için yenilik yapmaları gerekiyor. 01.ai’nin kurucusu ve yöneticisi Kai-Fu Lee, bu hafta yaptığı açıklamada, firma olarak 2.000 GPU ile sadece 3 milyon dolar harcayarak bir AI modeli eğittiklerini belirtti.

Başarıların Arkasındaki Strateji

Kai-Fu Lee, “Silicon Vadisindeki arkadaşlarımı en çok şaşırtan şey, sadece performansımız değil, modeli 3 milyon dolar ile eğitmemiz. GPT-4’ün eğitim maliyeti 80 ila 100 milyon dolar arasında.” ifadelerini kullanarak, böyle bir başarıyı elde etmenin dikkat çekici olduğunu vurguladı. “GPT-5’in eğitim maliyetinin ise yaklaşık 1 milyar dolar olduğu söyleniyor.” diye ekledi. Bununla birlikte, ABD regulasyonları nedeniyle GPU’lara erişimlerinin kısıtlı olduğunu da belirtti.

Optimize Edilmiş Maliyetlerle Yüksek Performans

OpenAI gibi rakiplerle karşılaştırıldığında, 01.ai, yüksek performanslı modelini yalnızca 3 milyon dolarlık bir bütçe ile eğitti. 01.ai’nin Yi-Lightning modeli, UC Berkeley’deki LMSIS ile yapılan ölçümlerde performans sıralamasında altıncı sırada yer alıyor. Bu durum, üst düzey AI yeteneklerinin her zaman büyük bütçelere ihtiyaç duymadığını gösteriyor; doğru mühendislik ve hedeflenmiş optimizasyonlarla benzer sonuçların çok daha düşük maliyetlerle elde edilebileceğinin altını çiziyor.

Göreceli Zorluklar ve Çözümler

OpenAI’nin GPT-3 modelini eğitmek için 10.000 Nvidia A100 GPU kullandığı tahmin edilmekteyken, GPT-4 ve GPT-4o modelleri için daha fazla H100 işlemcisi kullanıldığı bildirildi. 01.ai, Yi-Lightning modelini ise 2.000 belirtilmemiş GPU ile eğitti. Ancak, geçen yıl Kai-Fu Lee, firmalarının 1,5 yıl boyunca yol haritalarını uygulamak için yeterli GPU’ya sahip olduğunu söylemişti. Ancak sayılar birbirini tutmuyor; çünkü bir Nvidia H100 GPU’nun fiyatı yaklaşık 30.000 dolar, yani 2.000 tane böyle bir GPU 6 milyon dolara mal olur.

Verimliliği Artıran İnovasyonlar

01.ai, model performansını artırmak için sınırları olan inference (çıktı alma) sürecini optimize etti. Hesaplama taleplerini bellek odaklı görevlere dönüştürerek, çok katmanlı bir önbellek sistemi kurarak ve özel bir inference motoru tasarlayarak hız ve kaynak tahsisinde önemli iyileştirmeler gerçekleştirdi. Bunun sonucunda, ZeroOne.ai’nin inference maliyetleri, benzer modellere kıyasla milyon token başına 10 sent gibi, tipik oranların yaklaşık 1/30’u kadar düşük oldu.

Kai-Fu Lee, “2000 GPU’ya sahip olduğumuzda, ekibin bu kaynakları nasıl kullanacağını düşünmesi gerektiğini” belirtti. “Ben CEO olarak, önceliklendirilmesi gerekenleri belirlemek zorundayım ve eğitim sürecini hızlı hale getirmenin yanı sıra, inference sürecini de hızlandırmalıyız.” dedi. Sonuç olarak, yukarıda belirtilen mühendislik çözümleri ile birlikte inference maliyetleri önemli ölçüde azaltılmıştır.

Gelecek Vizyonu ve Zorluklar

Çinli şirketler genel olarak önemli zorluklarla karşı karşıya kalıyor. ABD’nin ihracat kısıtlamaları nedeniyle gelişmiş GPU’lara sınırlı erişimleri var. Ayrıca, Amerikan AI şirketlerine göre daha düşük bir değerleme ile karşılaştıkları için kaynak ve yatırım olanakları da kısıtlı. Bu durum, 01.ai gibi firmaların çözüm ve yenilik arayışlarını daha da zorlaştırıyor.

“`