Yapay zeka ajanları, iş süreçlerini otomatikleştirerek, karar alma süreçlerini optimize ederek ve eylemleri basitleştirerek iş operasyonlarını dönüştürüyor. Bu ajanların etkinliği, uzmanlaştığı mantıksal akıl yürütme yeteneklerine bağlı olarak, daha akıllı planlama ve verimli uygulama sağlamaktadır.

DeepSeek-R1 Modelinin Avantajları

Gelişmiş yapay zeka aklına sahip uygulamalar, DeepSeek-R1 gibi modellere fayda sağlayabilir. Sorun çözmede ileri düzey akıl yürütme becerilerine sahip olan DeepSeek-R1, 671 milyar parametreli bir karışık uzman modelidir. Doğru ve iyi yapılandırılmış akıl yürütme zincirlerini teşvik eden güçlendirmeli öğrenme teknikleri ile eğitilmiştir. Mantıksal çıkarım, çok aşamalı problem çözme ve yapılandırılmış analiz konularında mükemmeldir.

Derin Sorun Çözme ve Akıl Yürütme

DeepSeek-R1, karmaşık sorunları çok sayıda adımda zincirleme düşünme yöntemi ile parçalayarak, karmaşık soruları daha yüksek doğruluk ve derinlikle ele alabilmektedir. Bunu başarmak için, test zamanında ölçeklendirme adı verilen yeni bir ölçekleme yasası kullanır. Bu yasa, modelin yeteneklerini ve çıkarım güçlerini artırmak için çıkarım sırasında ek hesaplama kaynakları tahsis etmektedir.

Ancak, bu yapılandırılmış yapay zeka akıl yürütmesi, daha uzun çıkarım süreleri ile sonuçlanabilir. Model daha karmaşık sorunları işlerken, çıkarım süresi kısmen doğrusal bir şekilde artar, bu da gerçek zamanlı ve büyük ölçekli uygulamaları zorlaştırır. Uygulamanın optimize edilmesi, DeepSeek-R1’nin daha geniş bir benimseme için pratik olmasını sağlamak adına kritiktir.

DeepSeek-R1 NIM Mikroservisi ile Gelişim

Geliştiriciler, DeepSeek-R1 NIM mikroservisi aracılığıyla, özel olarak barındırılan uç noktalar kullanarak yapay zeka ajanlarına en son miting becerilerini kolayca entegre edebilirler. Bu entegrasyon, yapay zeka ajanlarının planlama, karar alma ve eylemleri konusunda önemli iyileşmeler sağlar. NVIDIA NIM mikroservisleri, endüstri standartı API’leri destekler ve bulut, veri merkezi, iş istasyonu ve PC gibi herhangi bir Kubernetes destekli GPU sisteminde ölçeklenerek uygulanmak üzere tasarlanmıştır.

NVIDIA NIM, modelin performansını artırarak kurumsal yapay zeka ajanlarının GPU destekli sistemlerde daha hızlı çalışmasını sağlar. Daha hızlı akıl yürütme, dinamik ortamlardaki birbirine bağımlı ajanlar arasında karar almayı hızlandırarak, ajans bazlı yapay zeka sistemlerinin performansını artırır.

NVIDIA NIM ile Ölçeklenebilir Performans

NVIDIA NIM, farklı NVIDIA GPU’ları arasında yüksek verimlilik ve düşük gecikme sunacak şekilde optimize edilmiştir. Veri Paralel Dikkati kullanarak, NVIDIA NIM, tek bir NVIDIA H200 Tensor Core GPU düğümünde kullanıcı desteklemeye ölçeklenebilir, bu da yüksek performans sağlar. Bu verim, NVIDIA Hopper mimarisi FP8 Transformasyon Motoru kullanılarak tüm katmanlarda gerçekleştirilir ve 900 GB/s NVLink bant genişliği, MoE iletişimini hızlandırarak pürüzsüz ölçeklenebilirlik sağlar.

DeepSeek-R1 modelinin gecikme ve verimliliği, NIM’e yeni optimizasyonlarımız eklenerek daha da geliştirilecektir.

Gerçek Dünya Uygulamaları için NVIDIA AI Blueprints

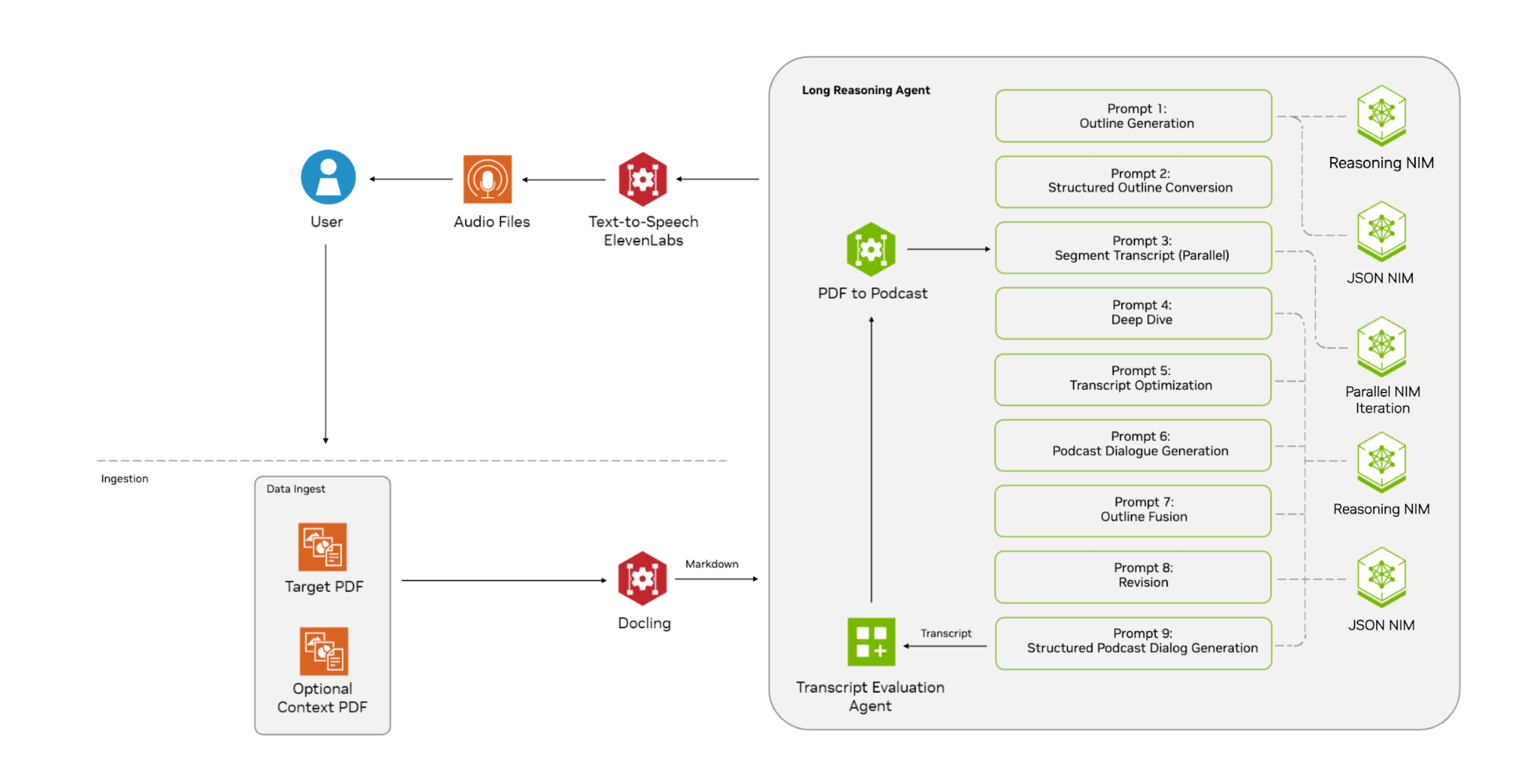

NVIDIA Blueprints, ajans bazlı ve üreteçli AI kullanım durumları için referans iş akışlarıdır. DeepSeek-R1 NIM’in özelliklerini bu blueprints ile hızlıca entegre edebilirsiniz. Örneğin, bu bölüm, NVIDIA AI Blueprint for PDF to podcast entegrasyonunu açıklamaktadır. Bu yapı, PDF’leri monolog veya diyalog biçiminde dinamik sesli içeriğe dönüştürmeyi sağlar.

Bu blueprints için genel iş akışı şu şekildedir:

- Kullanıcı, blueprints’e hedef PDF belgesini iletir. Bu belge, podcast için ana bilgi kaynağıdır. Kullanıcı, isteğe bağlı olarak birden fazla bağlam PDF belgesi ekleyebilir.

- Blueprint, hedef PDF’yi markdown formatına işler ve sonuçları uzun akıl yürütme ajanına iletir.

- Bu blueprint’in ajans iş akışı, belgeleri aşamalı olarak işlemek için birkaç LLM NIM uç noktası kullanır:

- Belge özetleme, ham taslak oluşturma ve diyalog sentezi için bir akıl yürütme NIM.

- Ham taslağı yapılandırılmış segmentlere dönüştürmek ve diyalogları yapılandırılmış konuşma formatına dönüştürmek için bir JSON NIM.

- Bölümleri transkripte dönüştürmek ve diyalogları bir araya getirerek bir bütün halinde sunmak için bir iterasyon NIM. Bu NIM birden fazla kez ve paralel olarak çağrılır.

Şekil 1, bu blueprint’in genel bir özetini göstermektedir; ayrıca NVIDIA-AI-Blueprints/pdf-to-podcast‘ta bulunmaktadır.

Kullanılan her tip işlem için NIM, kolayca uzaktan veya yerel olarak barındırılan NIM uç noktaları ile değiştirilebilir.

Blueprint Gereksinimleri

NVIDIA AI Blueprint for PDF to podcast, Ubuntu tabanlı makinelerde (v20.04 ve üzeri) yerel olarak yürütülebilir. Aşağıdaki minimum gereklilikler sohbetinize gereksinim duyulmaktadır:

- Docker motoru, NVIDIA Container Toolkit ve Docker Compose

- ElevenLabs Metinden Sese API’si için bir API anahtarı.

- NIM uç noktaları:

- DeepSeek-R1 NIM için NVIDIA barındırılan uç noktasını, bir API anahtarı almak için kayıt olarak NVIDIA API katalogundan kullanabilirsiniz.

- Yerel olarak barındırılan NIM uç noktaları için NVIDIA NIM for LLMs Getting Started‘a bakın. Unutmayın, DeepSeek-R1 dağıtım için 16 NVIDIA H100 Tensor Core GPU (veya sekiz NVIDIA H200 Tensor Core GPU) gerektirir. Uç noktaların çalışır durumda olduğundan emin olun (örneğin,

localhost:8000).

Daha fazla bilgi için, NVIDIA AI Blueprint for PDF to podcast belgelerine göz atabilirsiniz.

Blueprint Kurulumu

Lokalde blueprints’i kurmak için aşağıdaki komutları çalıştırın:

# Depoyu klonlayın

$ git clone https://github.com/NVIDIA-AI-Blueprints/pdf-to-podcast

$ cd pdf-to-podcast

# API anahtarlarını ayarlayın

$ echo "ELEVENLABS_API_KEY=your_key" >> .env

$ echo "NVIDIA_API_KEY=your_key" >> .env

# ElevenLabs API hız sınırlama sorunlarından kaçınmak için

$ echo "MAX_CONCURRENT_REQUESTS=1" >> .env

# Bağımlılıkları yükleyin

$ make uv

Model Seçimi

Farklı işlem aşamalarında kullanılacak temel modellerin belirlenmesi oldukça basittir ve bu, yerel deponuzdaki models.json dosyasını değiştirerek yapılabilir.

DeepSeek-R1’in akıl yürütme gücünden dolayı, bu modelin akıl yürütme NIM olarak kullanılmasını tercih edeceğiz, böylece podcast için daha derin analiz ve tartışma sağlanacaktır. Daha küçük modeller ise JSON ve iterasyon NIM mikroservisleri için kullanılacak böylece mantıksal olmayan süreç aşamaları çok daha hızlı olacaktır.

Aşağıdaki kod parçası, podcast için NVIDIA API katalogundan kullanılabilecek bazı modelleri göstermektedir:

{

"reasoning": {

"name": "deepseek-ai/deepseek-r1",

"api_base": "https://integrate.api.nvidia.com/v1"

},

"json": {

"name": "meta/llama-3.1-8b-instruct",

"api_base": "https://integrate.api.nvidia.com/v1"

},

"iteration": {

"name": "meta/llama-3.1-70b-instruct",

"api_base": "https://integrate.api.nvidia.com/v1"

}

}

Unutmayın ki, DeepSeek-R1 modelinin akıl yürütme ve test zamanında ölçeklendirme süreci sonucu genellikle birçok çıktı tokeni üretmektedir. Eğer harici barındırılan modeller veya NVIDIA API Kataloğundaki hizmetler gibi API’ler kullanıyorsanız, API kullanım kredi limitleri veya diğer maliyet ve kısıtlamalar konusunda dikkatli olmalısınız.

Modelleri belirledikten sonra podcast üretim ajanı hizmetlerini başlatmak için aşağıdaki komutu çalıştırabilirsiniz:

# Hizmetleri başlatın

$ make all-services

Bu komut, podcast üretimi için gerekli tüm hizmetleri aktif terminalde başlatır. Hizmetleri durdurmak için, sadece o terminalde CTRL + C tuşlarına basmanız yeterlidir.

Podcast Üretimi

Tüm ajan hizmetleri çalıştığında, podcast üretmeye başlayabilirsiniz. Depo, samples dizininde kullanılabilecek birkaç örnek belge sağlamaktadır. Kendi belgelerinizi de samples dizinine kopyalayarak kullanabilirsiniz.

Podcast üretmek için aşağıdaki komutu çalıştırın:

# `pdf-to-podcast` dizinindeyseniz:

# Sanal ortamı etkinleştirin

$ source .venv/bin/activate

# İki konuşmacı ile bir podcast üretmek için (diyalog formu):

$ python tests/test.py --target --context

# Tek konuşmacı ile bir podcast üretmek için (monolog formu):

$ python tests/test.py --target --context --monologue

Yukarıdaki komut çalıştıktan sonra, ortaya çıkan podcast tests dizininde bir MP3 dosyası olarak kaydedilecektir.

DeepSeek-R1 modelini akıl yürütme modeli olarak kullanıyorsanız, zaman aşımı sorunları veya API kullanım limitleri ile karşılaşmamak için podcast için deneylerinizi kısa belgeler (bir veya iki sayfa gibi) ile yapmanız önerilir.

Kişiselleştir ve Deneyin

Bu blueprints’de kullanılan temel modellerin davranışını kontrol edebilir ve bunları istediğiniz gibi özelleştirebilirsiniz. Her modelin çağrılması için kullanılan istemler, podcast_prompts.py dosyasında bulunmaktadır. Özellikle PODCAST_SUMMARY_PROMPT_STR, PODCAST_MULTI_PDF_OUTLINE_PROMPT_STR ve PODCAST_TRANSCRIPT_TO_DIALOGUE_PROMPT_STR tanımları, üretim sırasında akıl yürütme modelinin çağrılması için kullanılır. Bu istemleri ayarlayın ve blueprint ile deneyin.

DeepSeek-R1 NIM Mikroservisine Başlayın

DeepSeek-R1’in akıl yürütme gücünü NVIDIA NIM mikroservislerinin sağladığı esnek ve güvenli dağıtım ile birleştirerek, hızlı ve doğru akıl yürütme sunan yapay zeka ajanları oluşturabilirsiniz. Ayrıca, DeepSeek-R1 NIM’i farklı NVIDIA Blueprints‘te de kullanabilirsiniz.

DeepSeek-R1 NVIDIA NIM ile başlayın, NVIDIA barındırılan API’ye erişin veya NVIDIA platformunda indirip çalıştırın.