Sentetik Verinin Rolü

Sentetik veri, büyük dil modellerinin (LLM) son eğitim süreçlerinde standart bir parça haline geldi. Bir grup açık kaynak, ticari olarak kullanılabilir LLM’den elde edilen çok sayıda sentetik örnek kullanılarak, temel bir LLM, güçlendirilmiş eğitim ya da denetimli ince ayar ile yeniden eğitilerek talimat alma ve akıl yürütme becerilerini kazanıyor. Bu süreç, bir grup LLM öğretmeninden bir hedef LLM öğrencisine bilgi aktarımı olarak görülebilir.

NVIDIA’nın Yeni Veri Seti

NVIDIA, Llama-Nemotron post-training veri setini açık kaynak olarak yayınladı. Bu veri seti, matematik, kod, genel akıl yürütme, işlev çağırma ve talimat takibi yeteneklerinde iyileşmelere destek olan 30 milyon sentetik eğitim örneği içermektedir. Kanıt olarak, NVIDIA bu veri setini kullanarak üç model eğitti ve yayımladı:

Her bir model, ilgili ağırlık sınıflarında akıl yürütme ve görev alma konularında önde gelen bir doğruluk sunmaktadır.

Açık Veri ve Şeffaflık

Bu veri setinin yayınlanması, model geliştirme ve iyileştirme konusunda önemli bir adımı temsil ediyor. Eğitim setinin tamamını, eğitim tekniğini, araçları ve son model ağırlıklarını serbest bırakarak, NVIDIA, bu yaklaşımı yeniden oluşturma ve geliştirme imkanı sunuyor. Veri setleri, Hugging Face platformunda barındırılmaktadır.

Veri Kategorileri

Llama-Nemotron veri seti yaklaşık 30 milyon örnekten oluşmakta ve şu geniş kategorilere dağıtılmıştır:

| Kategori | Örnek Sayısı |

| Matematik | 19,840,970 (~1M eşsiz istem) |

| Kod | 9,612,677 |

| Bilim | 708,920 |

| Talimat takibi | 56,339 |

| Sohbet | 39,792 |

| Güvenlik | 31,426 |

Bu örnekler, açık kaynak, ticari olarak kullanılabilir modellerden toplanmıştır.

| Model | Örnek Sayısı |

| Llama-3.3-70B-Instruct | 420,021 |

| Llama-3.1-Nemotron-70B-Instruct | 31,218 |

| Llama-3.3-Nemotron-70B-Feedback/Edit/Select | 22,644 |

| Mixtral-8x22B-Instruct-v0.1 | 31,426 |

| DeepSeek-R1 | 1,212,994 |

| Qwen-2.5-Math-7B-Instruct | 19,840,970 |

| Qwen-2.5-Coder-32B-Instruct | 8,917,167 |

| Qwen-2.5-72B-Instruct | 464,658 |

| Qwen-2.5-32B-Instruct | 71,748 |

İstemler, ya halk arasındaki verilerden ya da sentetik olarak üretilmiştir. İstemler kalite ve karmaşıklık standartlarına uygun hale getirilmiştir. Bu filtremeler, tutarsız istemleri çıkarmak, tahmin edilmesi kolay yanıtlar içeren istemleri elemek ve yanlış sözdizimi içeren istemleri bertaraf etmeyi kapsamaktadır.

Sohbet Verileri ve Süreçleri

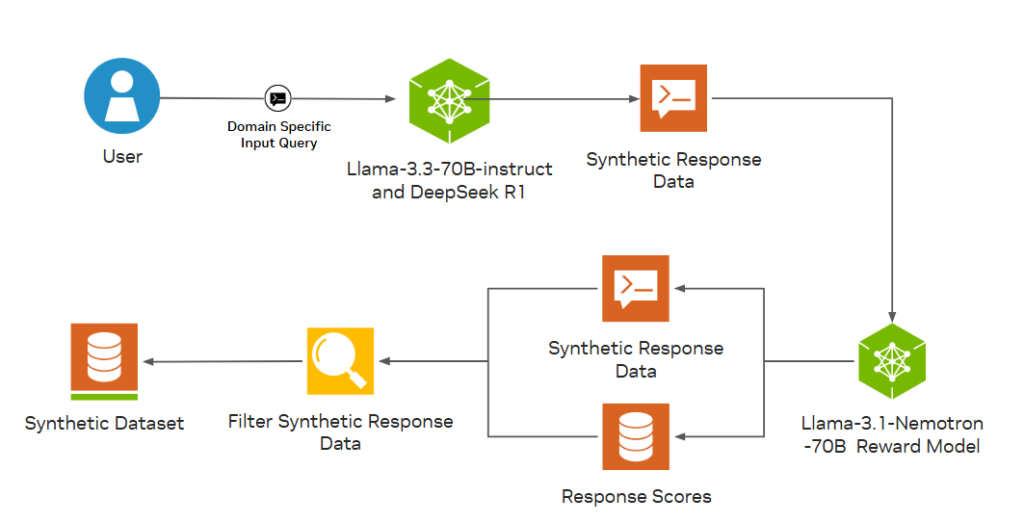

Sohbet verileri, kamuya açık gerçek kullanıcı etkileşimlerinden (wildchat) ve sentetik veri üretim şemasından elde edilmiştir. Sentetik istemler, açık QA, kapalı QA ve yaratıcı yazım gibi çeşitli görevleri kapsamaktadır. Her bir istem görevi için, LLM üretiminde farklı tema veya anahtar kelimelerle çeşitlendirilmiş bir set kullanılmıştır. Yanıtlar için, LLM’lere birden fazla üretim yaptırılmış ve sonra Llama-3.1-Nemotron-70B ödül modeli ile eleme yapılmıştır. Bu, yanıtların yüksek kalitede olmasını sağladı.

Llama-Nemotron 30M veri setini oluşturmak için, Llama-3.3-70B-instruct ve DeepSeek R1 modelleri yanıt üretici olarak kullanılmıştır (Şekil 1).

Bu sohbet veri toplama sürecini yeniden oluşturmak için /NVIDIA/NeMo-Curator eğitim not defterine başvurabilirsiniz.

Matematik Verilerini Oluşturma

Veri setinin matematik odaklı kısmını oluşturmak için Problem Çözme Sanatı forumlarından kapsamlı bir yöntem geliştirdik.

Bu yaklaşım birkaç aşamadan oluşmaktadır ve genellikle Qwen2.5-32B-Instruct modeli kullanılmaktadır:

- Problemlerin çıkarılması: İlk forum gönderilerinden tüm problemleri tanımlamak ve çıkarmak için bir LLM’den yardım aldık. Çoğu gönderide tek bir problem bulunmasına rağmen, bazıları birden fazla problem içerebilir.

- Problem sınıflandırması: Her çıkarılan problem, ispat veya ispat olmayan ve çoktan seçmeli ya da çoktan seçmeli olmayan kategorilere ayrıldı.

- Soru dönüştürme: İspat soruları, benzer problem çözme teknikleri gerektiren cevaplı sorulara dönüştürüldü. Çoktan seçmeli sorular, seçenekler kaldırılarak ve gerekirse yeniden formüle edilerek doğrudan cevap sorularına dönüştürüldü.

- Cevap çıkarma: İspat sorusu olmayanlar için, forum tartışmalarından son cevabı çıkarmaya çalıştık.

- Benchmark Temizleme: Popüler matematik standartlarında benzer soruları olanları kaldırarak, verilerin incelenmesinde adil bir değerlendirme sağladık.

- Çözüm Üretimi: Her soru için, birçok açık kaynak LLM kullanarak çoklu çözümler ürettik.

- Çözüm Validasyonu: Yalnızca doğruluğu kanıtlanmış ya da çoğunluk oylaması ile uyumlu olan çözümleri seçiyoruz.

Bu yöntem, /NVIDIA/NeMo-Skills altında uygulanmaktadır. Bu araç seti başlangıçta matematik problemlerini çözme yeteneğine odaklanmıştı, ancak şu anda herhangi bir LLM tabanlı sentetik veri üretim görevine destek sağlayabilir.

Kod Verileri İçin Süreç Geliştirmek

Kod üretimi için denetimli ince ayar veri setini oluşturmak amacıyla, kamuya açık programlama soruları CodeContests veri setinden alındı. Yaklaşımlarımız birkaç ana aşamadan oluşmaktadır:

- Benchmark Temizleme: Popüler kod standartlarına (HumanEval, MBPP, LiveCodeBench, BigCodeBench) yakın soruları kaldırdık.

- Yanıt Oluşturma: Programlama soruları için DeepSeek-R1 modelini kullandık ve her bir soru için 32-40 yanıt ürettik.

- Akıl Yürütme İzleri ve Çözüm Validasyonu: Tam akıl yürütme izlerini içeren yanıtlara öncelik verdik ve çözümleri sözdizimsel olarak doğruladık.

Matematik verileri gibi, kod verisi de /NVIDIA/NeMo-Skills kullanılarak hazırlanmıştır.

Modellerinizi Eğitmeye Başlayın

Llama-Nemotron veri setinin açık bırakılması, NVIDIA’nın açık kaynak yapay zeka geliştirme konusundaki kararlılığını pekiştiriyor. Açık kaynak topluluğunun bu yaklaşımı benimsemesini ve geliştirmesini umuyoruz. Gerekli eğitim veri setlerini Meta’nın Wildflower platformundan veya Hugging Face üzerinden indirerek, kendi akıl yürütme modellerinizi oluşturabilir ya da ince ayar yapabilirsiniz.

Bu süreçleri yeniden üreterek verileri kendi uygulamanız için küratör ile düzenleyebilir, ardından NeMo framework veya NeMo Özelleştirici mikro hizmeti ile modeli ince ayar yapabilirsiniz.