NVIDIA, Nemotron-CC Datasetini Duyurdu

NVIDIA, Nemotron-CC adıyla yeni bir 6.3 trilyon token içeren İngilizce dil veri setini duyurmaktan heyecan duyuyor. Bu veri seti, Common Crawl verilerine dayanarak, yüksek doğrulukta büyük dil modellerinin (LLM) ön eğitimini sağlamak amacıyla hazırlandı. Veri seti, 1.9 trilyon token değerinde sentetik veri içermektedir. Son dönemdeki başarılı LLM’lerin, örneğin Meta Llama serisi, 15 trilyon token veriden yararlandı.

Veri Setlerinin Kalitesi ve Önemi

Ancak bu 15 trilyon tokenın tam bileşimi hakkında pek az bilgi bulunmaktadır. Nemotron-CC, bu boşluğu doldurmayı ve daha geniş bir topluluğun yüksek doğrulukta LLM’ler eğitmesini sağlamayı hedefliyor. İnternet tarama verileri, genellikle Common Crawl gibi kaynaklardan elde edilen en büyük token kaynağıdır. Yeni açık Common Crawl veri setleri, FineWeb-Edu ve DCLM gibi, oldukça kısa token sürelerinde benchmark başarılarını önemli ölçüde artırma konusunda gösterdi. Bununla birlikte, bu başarı, %90’lık bir veri kaybına mal oldu ve bu da uzun token süreleri için uygunluğu sınırladı.

Nemotron-CC’nin Avantajları

Nemotron-CC, bu boşluğu doldurarak, Common Crawl verilerini daha kaliteli bir veri setine dönüştürme konusunda öncülük ediyor. Bu sayede, Llama 3.1 8B modelinden daha iyi eğitim yapılabiliyor; bunun arkasında yatan yöntemi ise, model tabanlı sınıflandırıcıların bir araya getirilmesi, sentetik verilerin yeniden ifade edilmesi ve sezgisel filtrelere olan bağımlılığın azaltılması olarak özetlemek mümkün.

Sonuçlar ve Başarılar

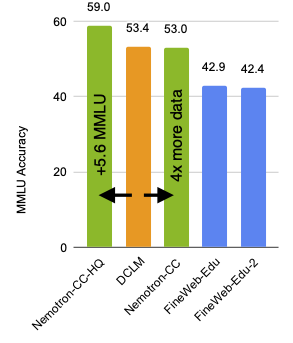

Şekil 1’de görülmekte olan sonuçlar, 1 trilyon token için 8B parametreli modellerin eğitilmesi esnasında elde edilen MMLU puanlarını göstermektedir. Eğitim verilerinin %73’ü İngilizce Common Crawl bölümünden alınmıştır. Yüksek kaliteli alt küme Nemotron-CC-HQ, lider açık İngilizce Common Crawl veri seti DCLM ile karşılaştırıldığında, >5.6 puan artışı sağlamıştır.

Ayrıca, toplam 6.3 trilyon token içeren veri seti, DCLM ile eşleşmekte, ancak dört kat daha fazla benzersiz gerçek token içermektedir. Bu durum, uzun token süreleri boyunca etkili eğitim imkanı sunmaktadır. Böylece, 7.2 trilyon token’ın Nemotron-CC verisinden geldiği, 15 trilyon token için eğitim alan bir 8B parametreli model, Llama 3.1 8B modelinden %5 daha iyi sonuçlar elde etmektedir.

Ana Fikirler ve Gelişmeler

Bu sonuçlara ulaşmamızı sağlayan bazı temel çıkarımlar ise şunlardır:

- Farklı model tabanlı sınıflayıcıların bir araya getirilmesi, yüksek kaliteli token setini daha fazla çeşitlilikle seçmemize yardımcı olabilir.

- Yeniden ifade etme işlemi, düşük kaliteli verilerdeki gürültü ve hataları azaltarak, yüksek kaliteli verilerden taze ve benzersiz token çeşitleri üretebilir.

- Geleneksel öğrenilmemiş sezgisel filtrelerin devre dışı bırakılması, yüksek kaliteli veri verimliliğini artırırken doğruluğu olumsuz etkilemeyebilir.

Veri Temizleme Aşamaları

NVIDIA NeMo Curator kullanarak, Common Crawl verilerinden veri çıkardık ve temizledik. Bu süreçte:

- Veriler yalnızca İngilizce dilde filtrelendi.

- Global bulanık tekrar önleme ve kesir altı tekrar önleme uygulandı.

- Kalite sınıflandırması için model tabanlı filtreler kullanıldı.

- Daha düşük kaliteli verileri kaldırmak için çeşitli sezgisel ve karmaşıklık filtreleri uygulandı.

Ayrıca, yaklaşık 2 trilyon token değerinde sentetik veri üretim süreçlerini de kullandık.

Sonuç ve Gelecek Planları

Nemotron-CC, açık, büyük ve yüksek kaliteli bir İngilizce Common Crawl veri setidir ve hem kısa hem de uzun token süreleri boyunca yüksek doğrulukta LLM’lerin ön eğitimine olanak tanır. Gelecekte, devlet-of-the-art LLM ön eğitimi için anahtar bileşen olan özel bir matematik veri seti gibi daha fazla veri seti yayınlamayı umuyoruz.

- Veri setini indirin.

- Kendi veri setlerinizi oluşturmak için NeMo Curator kullanın.

- Daha fazla teknik detayı öğrenmek için Nemotron-CC: Common Crawl’ın Arıttığı Uzun-Horizont Ön Eğitim Veri Setine Dönüşümü başlıklı makaleyi okuyabilirsiniz.

Teşekkürler

Datasetin barındırılmasında Common Crawl Foundation‘a teşekkür ederiz. Ayrıca, makalenin gelişiminde değerli geri bildirimleri için Pedro Ortiz Suarez‘a ve veri biçimlendirilmesi ile düzeni konusunda yardımcı olan Greg Lindahl‘a teşekkür ederiz.