Geleneksel görev ve hareket planlama (TAMP) sistemleri, robot manipülasyon uygulamalarında genellikle statik modellere dayanır ve bu modeller yeni ortamlarda başarısız olabilir. Perception (algılama) ile manipülasyonun birleştirilmesi bu sorunun üstesinden gelmek için bir çözüm sunar; bu sayede robotlar, uygulama sırasında planları güncelleyebilir ve dinamik senaryolara uyum sağlayabilir.

NVIDIA Robotics Araştırma ve Geliştirme Bülteni (R²D²) bu sayısında, algılamaya dayalı TAMP ve GPU hızlandırmalı TAMP’yi uzun-horizont manipülasyon için inceliyor. Ayrıca robot manipülasyon becerilerini geliştirmeye yönelik bir çerçeveye de göz atacağız. Görme ve dilin, pikselleri alt hedefler, yüceltiler ve farklılaştırılabilir kısıtlamalara nasıl çevirebileceğini göstereceğiz.

- Alt hedefler, robotu nihai hedefe adım adım yönlendiren daha küçük ara hedeflerdir.

- Yüceltiler, bir nesnenin veya çevrenin robotun gerçekleştirmesine olanak tanıyan eylemleri tanımlar. Örneğin, bir sap “kavrama”, bir düğme “basma” ve bir fincan “dökmek” eylemlerini mümkün kılar.

- Differansiyel kısıtlamalar, robot hareket planlamasında robotun hareketlerinin fiziksel sınırları (için eklem açıları, çarpışmalardan kaçınma veya uç efektör pozisyonları) karşıladığından emin olmasını sağlar; bu, öğrenim yoluyla üzerinde ayarlamalar yaparken bile mümkündür. Differansiyel oldukları için, GPU’lar eğitim sırasında veya gerçek zamanlı planlama sırasında bunları verimli bir şekilde hesaplayabilir ve geliştirebilirler.

Görev ve hareket planlaması, vizyon ve dili robot eylemine dönüştürür

TAMP, robotun ne yapacağına ve nasıl hareket edeceğine karar vermeyi içerir. Bu süreç, yüksek düzeyde görev planlama (hangi görevi yapacağı) ve düşük düzeyde hareket planlama (görevi yerine getirmek için nasıl hareket edeceği) kombinlemesini gerektirir.

Modern robotlar, karmaşık görevleri daha küçük adımlara, yani alt hedeflere ayırmak için hem vizyon hem de dili (resimler ve talimatlar gibi) kullanabilir. Bu alt hedefler, robotun ne yapması gerektiğini, hangi nesnelerle etkileşime geçeceğini ve nasıl güvenli bir şekilde hareket etmesi gerektiğini anlamasına yardımcı olur.

Bu süreç, görüntüleri ve yazılı talimatları, robotun gerçek dünya durumlarında takip edebileceği net planlara dönüştüren gelişmiş modeller kullanır. Uzun-horizon manipülasyonu, planlayıcının tatmin edebileceği yapılandırılmış niyetler gerektirir. OWL-TAMP, VLM-TAMP ve NOD-TAMP bu bağlamda nasıl yardımcı oluyor, inceleyelim:

- OWL-TAMP: Bu iş akışı, robotların “portakalı masanın üzerine koy” gibi doğal dilde tanımlanan karmaşık, uzun-horizon manipülasyon görevlerini yerine getirmelerine olanak tanır. OWL-TAMP, bir vizyon-dil modelini (VLM) TAMP ile entegre eden hibrit bir iş akışıdır. VLM, açık dünya dili (OWL) talimatlarını robot eylem alanında nasıl gerçekleştireceğine dair kısıtlamalar üretir. Bu kısıtlamalar, simülasyon geri bildirimi yoluyla fiziksel geçerliliği ve doğruluğu sağlamak için TAMP sistemine dahil edilir.

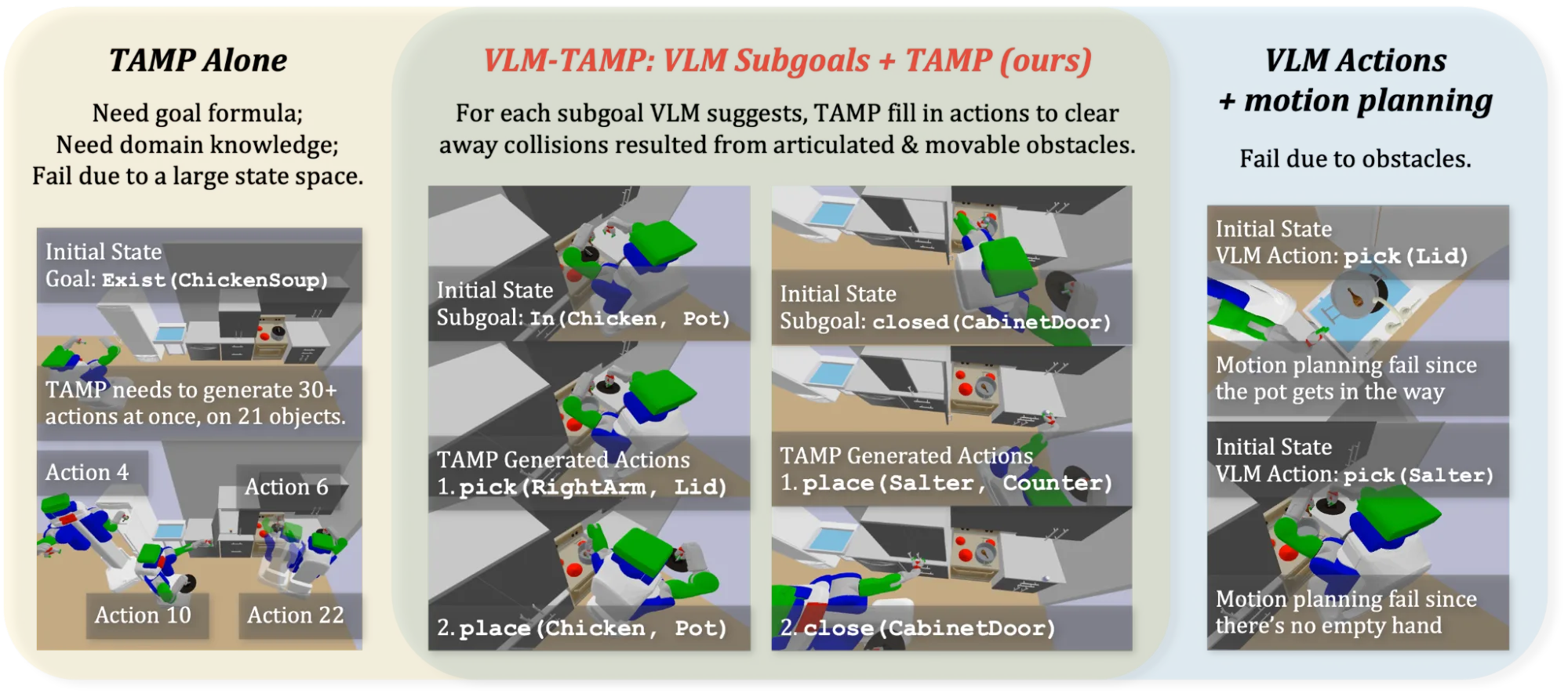

- VLM-TAMP: Görsel olarak zengin ortamlarda robotlar için çok aşamalı görevler planlamak üzere tasarlanmış bir iş akışıdır. VLM-TAMP, VLM’leri geleneksel TAMP ile birleşik olarak kullanarak gerçek dünya sahnelerinde eylem planları oluşturur ve inceler. Bir VLM, görüntüleri anlamak için kullanılır ve “tavuk çorbası yap” gibi görev tanımlarını temel alarak robot için yüksek düzeyde planlar geliştirir. Bu planlar, uygulanabilirliği kontrol etmek amacıyla simülasyon ve hareket planlamasıyla iteratif olarak geliştirilir. Bu hibrit model, 30 ile 50 ardışık eylem gerektiren mutfak görevlerinde hem VLM-only hem de TAMP-only baz alınanlardan daha iyi performans sergilemektedir. Bu iş akışı, robotların hem görsel hem de dil bağlamını kullanarak belirsiz bilgileri işleyebilmesine olanak tanır ve karmaşık manipülasyon görevlerinde daha iyi performans sağlar.

- NOD-TAMP: Geleneksel TAMP çerçeveleri genellikle açık geometrik modellere ve nesne temsillerine dayandıkları için uzun-horizon manipülasyon görevlerinde genelleme yapmakta zorlanır. NOD-TAMP, nesne türlerini genelleme konusunda yardımcı olmak için sinirsel nesne tanımlayıcıları (NOD) kullanarak bu zorluğun üstesinden gelir. NOD’lar, nesnelerin uzamsal ve ilişkisel özelliklerini kodlayan 3D nokta bulutlarından türetilen öğrenilmiş temsillerdir. Bu, robotların yeni nesnelerle etkileşime girmesine ve eylemleri dinamik olarak uyarlamalarına olanak tanır.

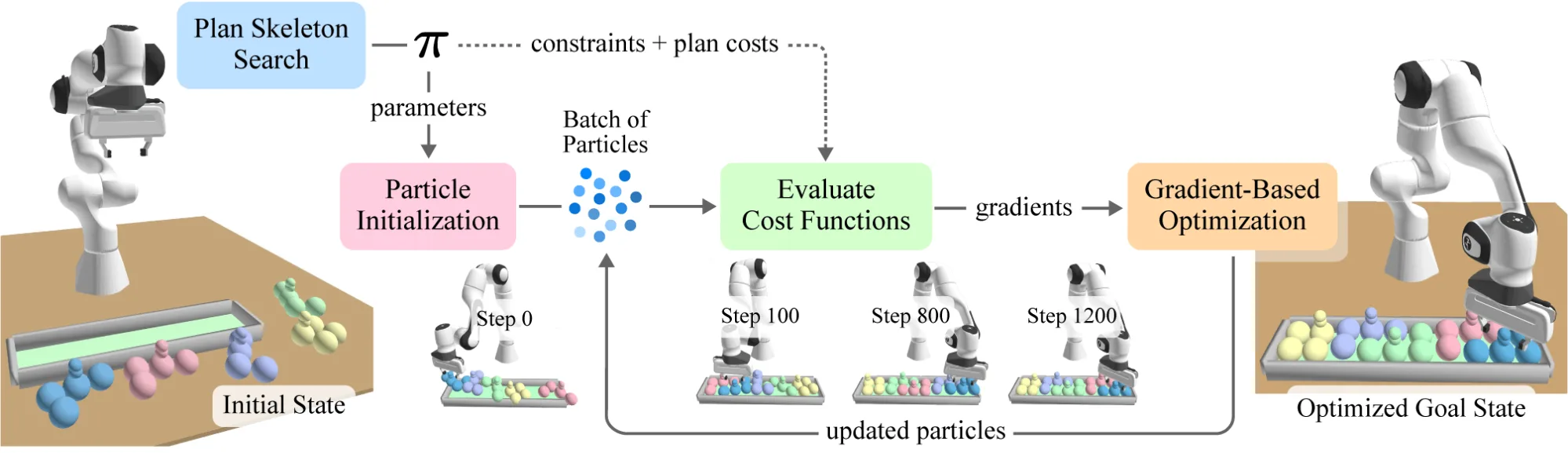

cuTAMP, GPU paralelleştirmesi ile robot planlamasını hızlandırır

Klasik TAMP, bir görevin eylem taslağını (plan iskeletleri) analiz ederek başlar ve ardından sürekli değişkenleri çözmeye ilerler. Bu ikinci adım, hareket sistemlerinde genellikle darboğazdır ve bu, cuTAMP sayesinde büyük ölçüde hızlandırılmaktadır. cuTAMP’te belirli bir iskelet için, binlerce örnek (partikül) alınır ve ardından farklı kısıtlamaları (ters kinematik, çarpışmalar, stabilite ve hedef maliyetleri gibi) karşılamak için GPU üzerinde farklılaştırılabilir toplu optimizasyon gerçekleştirilir.

Eğer bir iskelet uygulanabilir değilse, algoritma geri yollar. Eğer uygulanabilir ise, algoritma bir plan sunar ki bu genellikle sınırlı paketleme/yığma görevleri için birkaç saniye içinde gerçekleşir. Bu, robotların paketleme, yığma veya pek çok nesneyi manipüle etme çözümlerini saniyeler içinde bulabilmesine olanak sağlar. Bu “vektörleştirilmiş tatmin” gerçekte uzunca uzun sorun çözmeyi mümkün kılmanın özüdür.

Robotlar, başarısızlıklardan öğrenir: Stein varyasyonel çıkarım

Uzun-horizon manipülasyon modelleri, eğitim sırasında karşılaşmadıkları yeni koşullarda başarısız olabilir. Fail2Progress, robotların kendi başarısızlıklarından öğrenmelerini sağlayarak manipülasyonu geliştirmek amacıyla oluşturulmuş bir çerçevedir. Bu çerçeve, hataları veri destekli düzeltmeler ve simülasyon tabanlı yeniden inceleme yoluyla beceri modellerine entegre eder. Fail2Progress, gözlemlenen başarısızlıklara benzer hedefli sentetik veri setleri oluşturmak için Stein varyasyonel çıkarımını kullanır.

Bu oluşturulan veri setleri, beceri-etki modelini ince ayar yaparak yeniden dağıtmak için kullanılabilir ve böylece uzun-horizon görevlerde aynı başarısızlıkların tekrarı azalır.

Başlangıç noktası

Bu yazımızda algılamaya dayalı TAMP, GPU hızlandırmalı TAMP ve robot manipülasyonu için simülasyona dayalı bir geliştirme çerçevesini ele aldık. Geleneksel TAMP’deki ortak zorlukları inceledik ve bu araştırma çabalarının bunları nasıl çözmeyi hedeflediğini gördük.

Daha fazla bilgi edinmek için aşağıdaki kaynaklara göz atabilirsiniz:

- OWL-TAMP – Makale, proje web sitesi

- VLM-TAMP – Makale, proje web sitesi

- NOD-TAMP – Makale, proje web sitesi

- cuTAMP – Makale, proje web sitesi

- Fail2Progress – Makale, proje web sitesi

Bu yazı, NVIDIA Araştırma’nın fiziksel yapay zeka ve robotik uygulamalarındaki en son gelişmeler hakkında geliştiricilere daha derin bilgiler sunmak için hazırlanan NVIDIA Robotics Araştırma ve Geliştirme Bülteni R2D2nin bir parçasıdır.

Gelişmelerden haberdar olmak için bültenimize abone olabilir ve NVIDIA Robotics’i YouTube, Discord, ve geliştirici forumları üzerinden takip edebilirsiniz. Robotik yolculuğunuza başlamak için ücretsiz NVIDIA Robotik Temeller kurslarına kaydolun.

Teşekkürler

Bu yazıda bahsedilen araştırmalara katkıda bulunanlara teşekkür ederiz: Ankit Goyal, Caelan Garrett, Tucker Hermans, Yixuan Huang, Leslie Pack Kaelbling, Nishanth Kumar, Tomas Lozano-Perez, Ajay Mandlekar, Fabio Ramos, Shuo Cheng, Mohanraj Devendran Shanthi, William Shen, Danfei Xu, Zhutian Yang, Novella Alvina, Dieter Fox ve Xiaohan Zhang.