Büyük dil modelleri, matematik ve bilim gibi akıl yürütme yoğun görevleri üstlenirken, çıktılarının uzunluğu önemli ölçüde artıyor; bazen on binlerce token’a kadar uzanıyor. Bu durum, özellikle gerçek dünyada gecikmeye duyarlı ortamlarda bu modellerin verimli bir şekilde çalışmasını sağlamak için kritik bir engel oluşturuyor.

Bu zorlukları ele almak ve araştırma topluluğunun akıl yürütme modellerinin bilimini ilerletmesine yardımcı olmak amacıyla NVIDIA, Nemotron-H-47B-Reasoning-128K ve Nemotron-H-8B-Reasoning-128k modellerini geliştirdi. Bu modeller ayrıca FP8 quantize edilmiş varyantlarıyla da mevcut. Tüm bu modeller, Nemotron-H-47B-Base-8K ve Nemotron-H-8B-Base-8K temel modellerinden geliştirilmiştir.

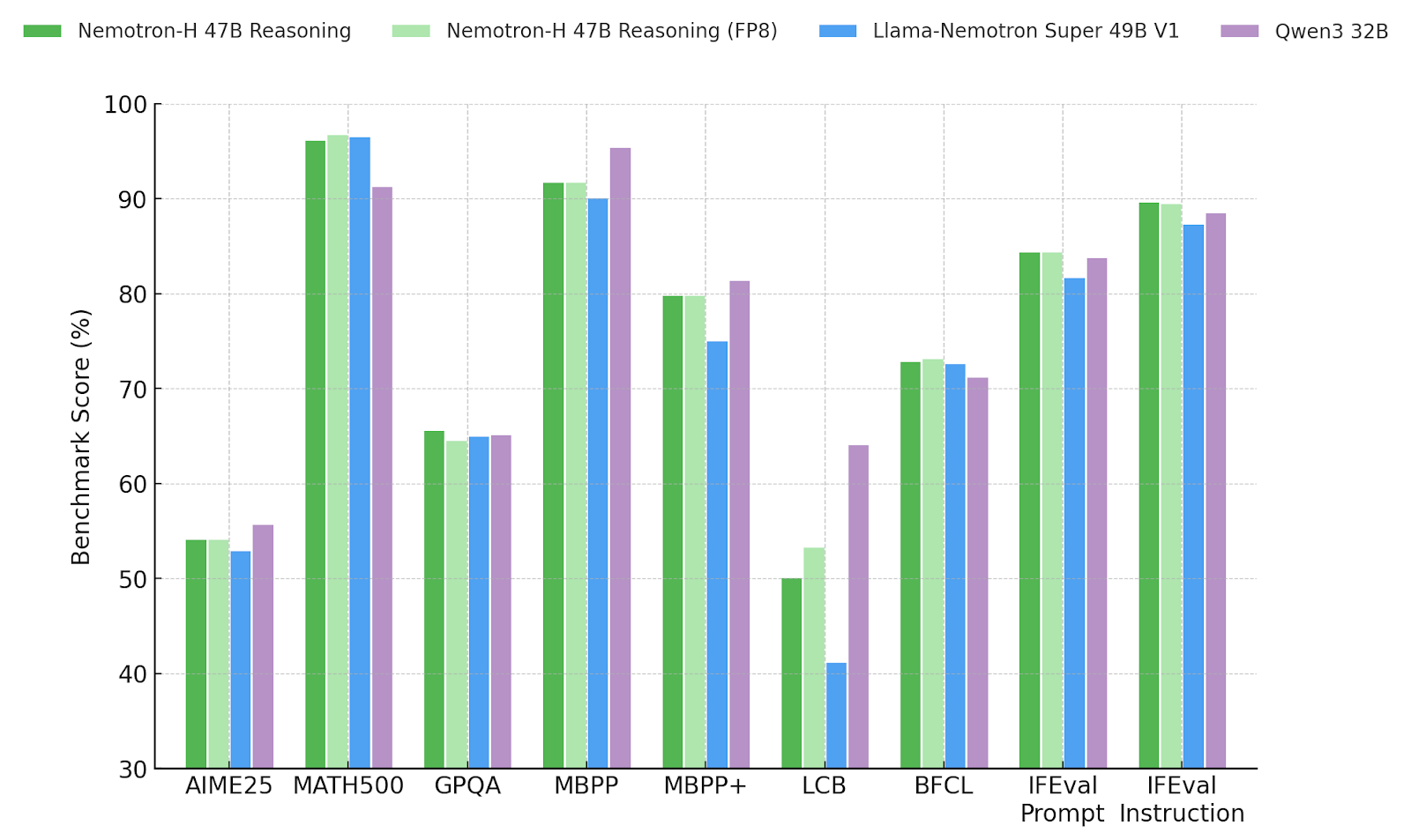

Bu model ailesinin en yetenekli olanı, Nemotron-H-47B-Reasoning, benzer boyuttaki transformer modellerine kıyasla önemli inferans zamanı hızlandırmaları sunuyor. Özellikle, Llama-Nemotron Super 49B V1.0 modeli ile karşılaştırıldığında neredeyse 4 kat daha yüksek bir throughput sunmakta ve 128K token bağlamlarını desteklemektedir. Ayrıca, akıl yürütmeye dayalı görevlerde eşdeğer veya daha yüksek bir doğruluk sunuyor. Nemotron-H-8B-Reasoning-128k modeli de Llama-Nemotron Nano 8B V1.0 modeliyle karşılaştırıldığında benzer eğilimler sergiliyor.

Bu sonuçlar, Nemotron-H gibi hibrit mimarilerin, saf Transformer modelleri kadar etkili bir şekilde sonrasında eğitim sürecine tabi tutulabileceğini göstermektedir. Ayrıca, throughput ve bağlam uzunluğu gibi önemli avantajlar sağlar.

Esnek Kontrol ile Çeşitli Kullanım Alanları

Yeni Nemotron-H Akıl Yürütme model ailesinin önemli bir özelliği, hem akıl yürütme hem de akıl yürütme dışı modlarda çalışma yeteneğidir. Kullanıcılar, görev doğrultusunda ayrıntılı ara adımlarla sonuç almak veya modeli özlü yanıt vermesi yönünde yönlendirebilir. Tercih belirtilmediğinde model, en iyi stratejiyi kendisi akıllıca seçiyor. Bu tür esnek kontrol, modeli çeşitli kullanım durumlarına adapte etmeyi kolaylaştırıyor.

NVIDIA, dört Nemotron-H Akıl Yürütme modelini açık araştırma izni altında yayımlıyor ve topluluğu bu modeller üzerinde çalışma, test etme ve yenilik yapmaya davet ediyor. Model kartları ve model ağırlıkları burada mevcuttur:

- Nemotron-H-47B-Reasoning-128k

- Nemotron-H-47B-Reasoning-128k-FP8

- Nemotron-H-8B-Reasoning-128k

- Nemotron-H-8B-Reasoning-128k-FP8

Eğitim Aşamaları

Eğitim süreci, akıl yürütme izlerini barındıran düzenlenmiş örneklerle denetimli ince ayar (SFT) ile başladı. Bu izler, <think> etiketleri içinde yer alıyor ve modele nihai sonuca ulaşmadan önce adım adım problem çözme sürecinde rehberlik ediyor. Bu izler çoğu zaman birden fazla çözüm yolunu temsil ediyor ve modelin alternatifleri keşfetmesini ve tekrar denemesini teşvik ederek doğruluğu artırıyor. Ancak, eklenen ayrıntı, özellikle daha uzun izlerde inferans maliyetini artırabiliyor.

Bunu dengelemek için, akıl yürütme içermeyen, serbest formatlı eşleştirilmiş örnekler sunarak modelin doğrudan yanıt verme yetisini geliştirdik. Bu çift formatlı eğitim, modelin farklı akıl yürütme gereksinimlerine uyum sağlamasına yardımcı oluyor.

Aşama 1: Matematik, Kod ve Bilim Akıl Yürütmeyi Master Etmek

İlk ince ayar aşaması, matematik, bilim ve kodlama gibi açık akıl yürütmenin büyük değer taşıdığı alanlara odaklandı. Buradaki eğitim verileri, akıl yürütme ve akıl yürütme dışı örnekler arasında 5:1 oranı kullandı ve bazı örnekler halka açık olarak Llama-Nemotron-Post-Training-Dataset üzerinden temin edilebilir. 30,000 adım boyunca 256’lık bir parti boyutuyla eğitim alındı ve model, iç STEM ölçütlerinde sürekli bir iyileşme gösterdi.

Aşama 2: Talimat Kapsamını Genişletme, Diyalog ve Güvenlik

İkinci aşama, talimat takibi, güvenlik uyumu ve çok adımlı diyalog gibi konulara yöneldi. Bu aşama, sürekli olarak Aşama 1’den örnek almaya devam etti ve akıl yürütme ve akıl yürütme dışı örnekler arasında daha dengeli bir karışım sundu. Bu, modelin daha geniş bir görev yelpazesine genel özelleşmesini sağlayarak akıl yürütme modlarını değiştirmede daha fazla kontrol sağladı.

Uzun Bağlamlar için Eğitim

128K-token bağlamları desteklemek amacıyla, modeli 256K-token uzunluğundaki sentetik diziler üzerinde eğittik. Bu diziler, Aşama 2 eğitim verileri arasındaki daha kısa konuşmaları birleştirip uzun menzilli bellekleri zorlayıcı görevlerle zenginleştirerek oluşturuldu. Tanışma örnekleri arasında:

- Daha önceki aşamaları referans alan takip soruları

- Derin geçiş anlayışı gerektiren uzun belge tabanlı QA

- Çapraz referanslı çok adımlı sohbet

- Distraktörler ile anahtar kelime toplama görevleri

Bu örnekler, modelin sağlam uzun bağlam dikkat desenleri geliştirmesini teşvik etti. RULER metriği kullanılarak bu yetenek değerlendirildi. Model, aynı 128K-token koşulları altında 84% RULER puanı elde etti; bu da Llama-Nemotron ile karşılaştırıldığında önemli kazanımlar olduğunu gösteriyor.

GRPO İle Pekiştirme Öğrenimi

SFT sonrasında, Grup Göreli Politika Optimizasyonu (GRPO) uygulandı. Her aşama belirli yeteneklere odaklandı; talimat izleme veya araç kullanımı gibi, otomatik doğrulayıcılarla birlikte görev özel veri setleri oluşturuldu. Genel bir ödül modeli ile daha geniş bir ince ayar için fine-tuning uygulandı.

Talimat Takip Eğitimi

Talimatlara bağlılığı artırmak için, 16,000 istem örneği LMSYS Chat veri setinden alındı. Bu istemler, IFEval tarzı talimatlarla eşleştirildi. Kural tabanlı bir doğrulayıcı, çıktıları her talimatı ne kadar iyi yerine getirdiğine göre puanlayarak doğru bir şekilde talimatlara uyum sağlamayı teşvik eden bir ödül sinyali oluşturdu.

Fonksiyon Kullanımı ile İlgili Eğitim

Sonrasında, 40,000 geçerli araç kullanımı örneği üzerine eğitim aldık. Bu örnekler Glaive V2 ve Xlam veri setlerinden alındı. Sağlamlık geliştirmek için, doğru işlev çağrısının imkansız olduğu 10,000 olumsuz örnek ekledik. Bu dengeli veri seti, modelin araç kullanma konusundaki hassasiyetini artırmasına yardımcı oldu.

Yardımcı Olma Üzerinden Genel Eğitimi

Son GRPO aşamasında, yanıtların yardımcı olma niteliğini artırmak amacıyla Qwen-32B tabanlı bir ödül modeli kullandık. 92.8 puan alan bu model, HelpSteer2 veri setinden alınan istemlerle çalıştı ve yaklaşık 200 adım süresince GRPO uygulandı. Kısa sürede olsa, bu aşama çıktılarda dikkat çekici iyileşmelere neden oldu.

Çıkışta Kontrol Edilen Akıl Yürütme

Inferans zamanı davranışı, sistem isteminde basit kontrol etiketleri ile özelleştirilebilir:

{'reasoning': True}akıl yürütme modunu tetikler{'reasoning': False}doğrudan yanıt modunu tetikler- Etiket belirtilmezse, model kendi kararını alır

Jinja sohbet şablonumuz, bu kontrol dizilerini algılar ve asistanın yanıtını buna göre değiştirir. {'reasoning': True} bulunduğunda, yanıt başına Assistant:<think>n eklenir; bu da akıl yürütme izinin başlangıcını gösterir. {'reasoning': False} bulunduğunda, yanıt Assistant:<think></think> ile başlar ve akıl yürütme dışı bir yanıt olarak işaretlenir. Bu mekanizma, akıl yürütme veya akıl yürütme dışı modların kontrolünde neredeyse %100 başarı sağladı.

Sonuçlar

Matematik, kodlama, bilim, araç kullanımı ve diyalog ölçütlerinde, Nemotron-H-47B-Reasoning-128K, Llama-Nemotron Super 49B V1.0 ile eşit veya daha yüksek bir doğruluk sunmakta ve Qwen3 32B modelini bütün akıl yürütme dışı sınavlarda geçmektedir. Model, tüm lineer katmanlara uygulanan son eğitim sonrasında kuantizasyonu desteklemekte ve minimal doğruluk kaybıyla etkin bir şekilde konuşlandırma gerçekleştirilmesine olanak tanımaktadır. Bu kuantize versiyon için kontrol noktaları ve sonuçları sağlanmakta ve pratikte etkinliğini gösterilmektedir.

Bu nedenle, uygulamanız şeffaflık, hassasiyet veya hız gerektiriyorsa, Nemotron-H-47B-Reasoning çok yönlü ve yüksek performans sunan bir temel modeldir.

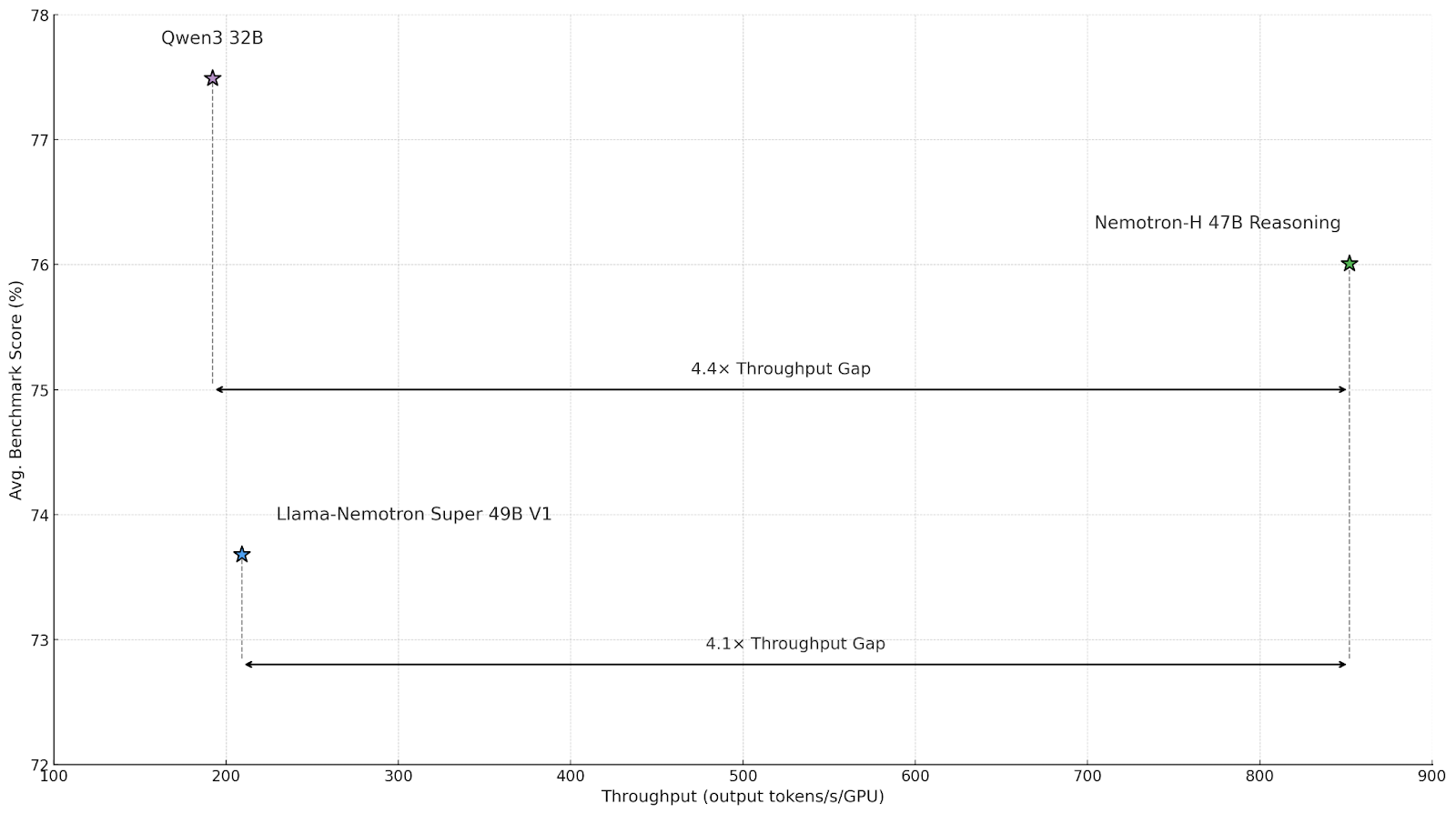

Throughput Karşılaştırmaları

Hibrit Mamba-Transformer mimarisi sayesinde, Nemotron-H-47B-Reasoning, benzer boyuttaki yalnızca Transformer modellerine göre önemli inferans zamanı hızlandırmaları sunuyor. Aşağıdaki tablo, akıl yürütme tarzı iş yükü için ortalama benchmark doğruluğu ile inferans throughputunu göstermektedir. Bu kıyaslamalar için, Megatron-LM kullanarak, iki NVIDIA H100 GPU’sunda BF16’da maksimum ulaşılabilir throughput değerlendirilmiştir; her modelini, her biri kısa girdi dizilerini (128 token) işleyip genişletilmiş akıl yürütme izleri oluşturduğu (32K çıktı token) maksimum parti boyutunu seçerek test edilmiştir.

İç değerlendirme yapılandırmamız -tutarlılığı sağlamak için kullanılan- Qwen3’ün en yüksek ortalama benchmark puanını elde ettiğini gösteriyor; ardından Nemotron-H-47B-Reasoning geliyor. Özellikle, Nemotron-H, yalnızca Transformer tabanlı temellere kıyasla yaklaşık 4 kat daha yüksek throughput sunuyor.

Katkıda Bulunanlar

Yian Zhang, David Mosallanezhad, Bilal Kartal, Dima Rekesh, Luis Vega, Haifeng Qian, Felipe Soares, Julien Veron Vialard, Gerald Shen, Fei Jia, Ameya Mahabaleshwarkar, Samuel Kriman, Sahil Jain, Parth Chadha, Zhiyu Li, Terry Kong, Hoo Chang Shin, Anna Shors, Roger Waleffe, Duncan Riach, Cyril, Meurillon Matvei, Novikov, Daria Gitman, Evelina Bakhturina, Igor Gitman, Shubham Toshniwal, Ivan Moshkov, Wei Du, Prasoon Varshney, Makesh Narsimhan Sreedhar, Somshubra Majumdar, Wasi Uddin Ahmad, Sean Narenthiran, Mehrzad Samadi, Jocelyn Huang, Siddhartha Jain, Vahid Noroozi, Krysztof Pawelec, Twinkle Vashishth, Oleksii Kuchaiev, Boris Ginsburg, Mostofa Patwary ve Adithya Renduchintala.