NVIDIA Blackwell mimarisi ailesinin en son üyesi olan NVIDIA Blackwell Ultra GPU, eğitim ve yapay zeka sorgulamalarını hızlandırmak için çekirdek yenilikleri bir araya getiriyor. Bu yapı, silikon yeniliklerini yeni düzeyde sistem entegrasyonu ile birleştirerek, AI fabrikaları ve bunların desteklediği büyük ölçekli, gerçek zamanlı yapay zeka hizmetleri için bir sonraki seviyede performans, ölçeklenebilirlik ve verimlilik sağlıyor.

Enerji verimliliği yüksek çift retikül tasarımı, yüksek bant genişliği ve büyük kapasiteli HBM3E bellek alt sistemi, beşinci nesil Tensor Cores ve devrim niteliğinde NVFP4 hassasiyet formatı ile Blackwell Ultra, hızlandırılmış hesaplama konusunda çıtayı yükseltiyor. Bu derinlemesine inceleme, mimari gelişmeleri, bunların önemini ve yapay zeka iş yükleri için nasıl ölçülebilir kazançlara dönüştüğünü açıklıyor.

Çift Retikül Tasarımı: Tek GPU

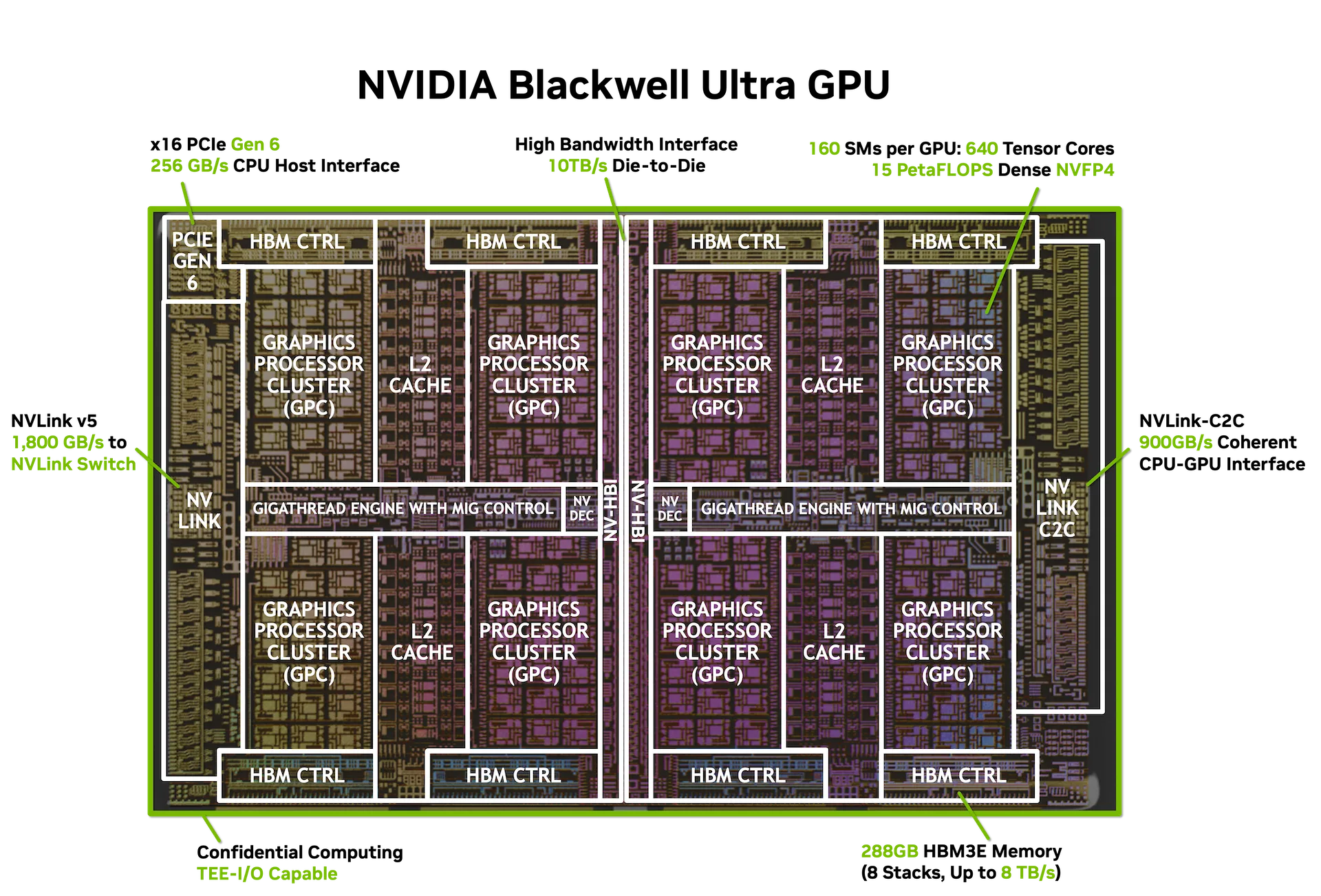

Blackwell Ultra, NVIDIA Yüksek Bant Genişliği Arayüzü (NV-HBI) kullanarak bağlanmış iki retikül boyutunda çip içeriyor. Bu özel, güç verimliliği yüksek çipler arası bağlantı teknolojisi, 10 TB/sn bant genişliği sağlıyor. Blackwell Ultra, TSMC 4NP kullanılarak üretiliyor ve 208 milyar transistör içeriyor; bu, NVIDIA Hopper GPU’dan 2.6 kat daha fazla. Tüm bunlar, geliştiricilerin neredeyse iki on yıldır keyfini sürdüğü CUDA programlama modelini koruyarak tek bir NVIDIA CUDA programı olarak çalışıyor.

Faydaları

- Birleşik hesaplama alanı: İki çip arasındaki 160 Akış Çoklayıcısı (SM), toplamda 640 beşinci nesil Tensor Core ile 15 PetaFLOPS yoğun NVFP4 hesaplama sağlıyor.

- Tam tutarlılık: Tam tutarlı bellek erişimleri ile paylaşılan L2 önbellek.

- Maksimum silikon kullanımı: Santimetrekare başına pik performans.

Akış Çoklayıcıları: AI Fabrikasının Hesaplama Makineleri

Şekil 1’de görüldüğü gibi, Blackwell Ultra’nın kalbini, tam GPU implementasyonunda sekiz Grafik İşlem Birimi (GPC) içinde düzenlenmiş 160 Akış Çoklayıcısı (SM) oluşturuyor. Her SM, Şekil 2’de gösterildiği gibi, aşağıdakileri içeren bir hesaplama motorudur:

- 128 CUDA Çekirdeği FP32 ve INT32 işlemleri için; ayrıca FP16/BF16 ve diğer hassasiyetler için de kullanılabilir.

- 4 beşinci nesil Tensor Core ile FP8, FP6 ve NVFP4 olarak optimize edilmiş ikinci nesil Transformer Motoru.

- 256 KB Tensor Belleği (TMEM) ara sonuçların warp senkron depolanması için, veri trafiğini azaltarak daha yüksek yeniden kullanım sağlar.

- Özel Fonksiyon Üniteleri (SFUs), AI kernellerinde kullanılan transandantal matematik ve özel işlemler için.

NVIDIA Tensor Cores: AI Hesaplama Güç Makineleri

NVIDIA, Tensor Cores’ı Volta mimarisindeki ilk tanıtımıyla birlikte, GPU’ların derin öğrenme için yapabileceklerini köklü bir şekilde değiştirdi. Tensor Cores, her bir elemanı tek tek işlemek yerine, doğrudan küçük matrisler üzerinde çalışır. Bu özellik, çoğu hesaplamanın büyük sayılar ızgaralarının çarpımı ve toplamı üzerine kurulu olduğu sinir ağları için mükemmel bir uyum sağladı.

Sonraki nesillerde, Tensor Cores yeteneklerini, hassasiyet formatlarını ve paralelliği artırdı:

- NVIDIA Volta: Eğitim için FP16 ile FP32 birikimi sağlayan 8 iplikli MMA birimleri.

- NVIDIA Ampere: Tam warp genişliğinde MMA, BF16 ve TensorFloat-32 formatları.

- NVIDIA Hopper: 128 iplikte warp grup MMA, FP8 desteği olan Transformer Motoru.

Blackwell ve Blackwell Ultra, beşinci nesil Tensor Cores ve ikinci nesil Transformer Motoru ile bu yetenekleri bir üst seviyeye taşıyor; bu durum yoğun ve seyrek AI iş yükleri için daha yüksek bant genişliği ve daha düşük gecikme süresi sağlıyor. Blackwell Ultra’daki her Akış Çoklayıcısı (SM) 640 Tensor Core içeriyor ve böylece en yeni hassasiyet formatını, yani NVFP4’ü destekliyor.

Bu iyileştirmeler sadece brüt FLOPS ile ilgili değil. Yeni Tensor Core’lar, her SM başına 256 KB Tensor Belleği (TMEM) ile sıkı bir şekilde entegre edilmiştir ve bu da veri taşıma işlemlerini azaltır. Ayrıca, çift iplik bloğu MMA desteği ile eşleşen SM’ler, bir MMA işlemi üzerinde iş birliği yaparak, operatörleri paylaşır ve gereksiz bellek trafiğini azaltır.

Sonuç olarak daha yüksek sürdürülebilir bant genişliği, daha iyi bellek verimliliği ve daha hızlı büyük parti ön eğitimi, pekiştirmeli öğrenme sonrası eğitimi ve düşük parti, yüksek etkileşimli çıkarım sağlanır.

Ultra-Yüksek NVFP4 Performansı

NVIDIA NVFP4’ün tanıtılması, Blackwell GPU mimarisinde yer alan yeni 4-bit kayan nokta formatı, iki seviyeli ölçekleme kombinasyonu sunuyor. Bu, 16 değerden oluşan bloklar için uygulanan bir FP8 (E4M3) mikro blok ölçeği ile birlikte, bir tensor seviyesinde FP32 ölçeğini içeriyor. Bu, standart FP4’e göre belirgin şekilde daha düşük hata oranları ile donanım hızlandırmalı nicememeye olanak tanıyor. NVFP4, düşük-hassasiyetli AI çıkarımında dengeleyici bir noktada hassasiyet, verimlilik ve performans sunmaktadır.

Blackwell Ultra’nın yoğun NVFP4 hesaplama yeteneği, orijinal Blackwell GPU’ya göre önemli bir performans artışı sağlıyor. Temel mimari, 10 petaFLOPS NVFP4 performansı sunarken, Ultra bunu 15 petaFLOPS’a yükseltiyor; bu, Blackwell GPU’ya göre 1.5 kat ve NVIDIA Hopper H100 ile H200 GPU’larıyla 7.5 kat artış anlamına geliyor.

Dikkat Katmanında Hızlandırılmış Softmax

Modern AI iş yükleri, “düşünme” için uzun girdi bağlamları ve uzun çıktı dizileri gerektirir. Dönüştürücü dikkat katmanları, SM’lerin SFU’ları tarafından yürütülen üstel, bölme gibi transandantal işlemlerle zorluk yaşar.

Blackwell Ultra’da, dikkat için anahtar talimatlar üzerinden SFU verimliliği iki kat artırılmıştır. Bu, Blackwell GPU’lara göre 2 kat daha hızlı dikkat katmanı hesaplama sağlar. Bu iyileştirme, hem kısa hem de uzun dizili dikkat için hız kazandırırken, özellikle büyük bağlam pencereleri olan akıl yürütme modelleri için etkilidir; çünkü softmax aşaması gecikme darboğazına dönüşebilir.

Dönüştürücü modellerinin dikkati mekanizmasını hızlandırarak, Blackwell Ultra şunları sağlar:

- Daha hızlı AI akıl yürütme, etkileşimli uygulamalarda ilk token için gereken süreyi azaltır.

- Toplam işleme döngülerini azaltarak maliyetleri düşürür.

- Sistem verimliliğini artırarak, her watt başına daha fazla dikkat dizisi işlenmesini sağlar.

Şekil 4’te, Blackwell Ultra’nın hızlandırılmış dikkat katmanı talimatlarından elde edilen performans kazançları, NVFP4 hassasiyeti ile birleşerek, LLM ve çoklu modda çıkarım için önemli bir iyileşmeyi gösterir.

Bellek: Multi-Trilyon Parametre Modelleri için Yüksek Kapasite ve Bant Genişliği

Blackwell Ultra, sadece hesaplama değil, aynı zamanda en büyük AI modellerinin taleplerini karşılamak için bellek kapasitesini de artırıyor. GPU başına 288 GB HBM3E ile, H100’e kıyasla 3.6 kat daha fazla yerleşik bellek sunuyor ve Blackwell’den %50 daha fazla. Bu kapasite, bellek dışı kalmadan 300B+ parametreli modellerin barındırılmasını sağlayarak, dönüşümlü modeli genişletmeye ve AI fabrikalarındaki yüksek eşzamanlı çıkarımı sağlamaya kritik öneme sahiptir.

Yüksek Bant Genişliği Bellek Özellikleri

- Maksimum kapasite: 288 GB, H100’e göre 3.6 kat artış.

- HBM yapılandırması: 8 yığın, 16 × 512-bit denetleyici (toplam 8,192 bit genişlik).

- Bant genişliği: Her GPU için 8 TB/sn, H100’e göre 2.4 kat iyileşme sağlar (3.35 TB/sn).

Bu büyük bellek yapısı, aşağıdaki imkanları sağlar:

- Tam model ikameti: 300B+ parametre modelleri için bellek dışı kalma olmadan.

- Uzun bağlam uzunlukları: Dönüştürücü modeller için daha büyük KV önbellek kapasitesi.

- İşlem verimliliğinin artması: Çeşitli iş yükleri için daha yüksek işlem-bellek oranları.

Bağlantı: Ölçek İçin Tasarlandı

Blackwell ve Blackwell Ultra, GPU’dan GPU’ya iletişim için beşinci nesil NVIDIA NVLink’i, NVIDIA Grace CPU’ya koherent bağlantı için NVLink-C2C’yi ve ana bilgisayar CPU’ları ile bağlantı için x16 PCI-Express Gen 6 arabirimini desteklemektedir.

NVLink 5 Özellikleri

- Her GPU için Bant Genişliği: 1.8 TB/sn çift yönlü (18 bağlantı x 100 GB/sn).

- Performans Ölçeklendirme: NVLink 4’e göre 2 kat iyileşme (Hopper GPU).

- Maksimum Topoloji: Engellemesiz hesaplama yapısı içinde 576 GPU.

- Rack Ölçek Entegrasyonu: 130 TB/sn toplam bant genişliği ile NVL72 yapılandırmaları (72 GPU).

Ana Bilgisayar Bağlantısı

- PCIe Arayüzü: Gen6 × 16 bağlantı (256 GB/sn çift yönlü) .

- NVLink-C2C: Bellek tutarlılığı olan Grace CPU-GPU iletişimi (900 GB/sn).

Tablo 1, nesiller arasında etkileşimleri karşılaştırmaktadır.

| İnterkonnekte | Hopper GPU | Blackwell GPU | Blackwell Ultra GPU |

|---|---|---|---|

| NVLink (GPU-GPU) | 900 | 1,800 | 1,800 |

| NVLink-C2C (CPU-GPU) | 900 | 900 | 900 |

| PCIe Arayüzü | 128 (Gen 5) | 256 (Gen 6) | 256 (Gen 6) |

Performans Verimliliğinin İlerlemesi

Blackwell Ultra, Blackwell’a göre %50 daha fazla NVFP4 hesaplama ve GPU başına %50 daha fazla HBM kapasitesi ekleyerek, daha büyük modeller ve daha hızlı işleme imkânı sunuyor. Hızlandırılmış softmax yürütmesi, gerçek dünya çıkarım hızlarını daha da artırıyor ve veri merkezi başına token üretim oranını (TPS/MW) yükseltiyor. Her mimari iyileştirme, kullanıcı deneyimini ve operasyonel verimliliği bir üst seviyeye çıkarmak için yüklü olmuştur.

Şekil 6, NVIDIA Hopper HGX H100 NVL8 sistemi, NVIDIA Blackwell HGX B200 NVL8 sistemi, NVIDIA Blackwell GB200 NVL72 sistemi ve NVIDIA Blackwell Ultra GB300 NVL72 sistemi için bu iki metriği çizer; bu, nesillerin nasıl bir sıçrama yarattığını gösterir. Eğri, en alt noktasında Hopper NVL8 ile başlamakta ve en üstte Blackwell Ultra NVL72 ile NVFP4 hassasiyetinde noktalanmaktadır; bu, her mimari ilerlemenin Pareto sınırını yukarı ve sağa taşıdığını göstermektedir.

Bu mimari yenilikler, yapay zeka çıkarım ekonomisini geliştirmekte ve AI fabrika tasarımında mümkün olanı yeniden tanımlamakta; daha fazla model örneği, daha hızlı yanıt süreleri ve önceki NVIDIA platformlarına göre daha yüksek verimlilik sunmaktadır.

Donanım ve dağıtım konfigürasyonlarındaki yeniliklerin veri merkezi verimliliği ve kullanıcı deneyimini nasıl etkilediğini keşfetmek için interaktif Pareto Sınırı açıklayıcısına göz atabilirsiniz.

Kurumsal Düzey Özellikler

Blackwell Ultra, yalnızca ham performans sunmakla kalmıyor; aynı zamanda operasyonları kolaylaştıran, güvenliği güçlendiren ve ölçekli güvenilir performans sunan kurumsal düzeyde özellikler ile tasarlandı.

Gelişmiş Zamanlama ve Yönetim

- Geliştirilmiş GigaThread Motoru: İyileştirilmiş bağlam değiştirme performansı ve 160 SM’ye yayılmış optimize edilmiş iş yükü dağıtımı sağlayan bir sonraki nesil iş zamanlayıcı.

- Çoklu Örnek GPU (MIG): Blackwell Ultra GPU’ları, farklı boyutlarda MIG örneklerine bölünebilir. Örneğin, bir yönetici, iki örnek oluşturup her biri 140 GB bellek içerebilir veya dört örneği 70 GB ile, ya da yedi örneği 34 GB ile yapılandırabilir; bu sayede güvenli çoklu kiralanabilirlikle tutarlı performans izolasyonu sağlanabilir.

Güvenlik ve Güvenilirlik

- Gizli hesaplama ve güvenli AI: Hassas AI modelleri ve verilerini güvenli ve performanslı bir şekilde koruma sağlamak; Blackwell mimarisinde endüstride bir ilk olan TEE-I/O yetenekleriyle GPU’lara güvenli donanım tabanlı Trusted Execution Environment (TEE) sağlamaktadır.

- Gelişmiş NVIDIA Uzaktan Doğrulama Servisi (RAS) motoru: Sistemlerin arızalarını öngörmek, bakım takvimlerini optimize etmek ve büyük ölçekli dağıtımlarda sistem çalışma süresini en üst düzeye çıkarmak için binlerce parametreyi izleyen yapay zeka destekli güvenilirlik sistemidir.

AI Video ve Veri İşleme Gelişmeleri

Blackwell Ultra, çok modlu veri işleme gerektiren modern AI iş yükleri için özel motorları entegre eder:

- Video ve JPEG çözme: NVIDIA Video Decoder (NVDEC) ve NVIDIA JPEG Decoder (NVJPEG) motorları, yüksek bant genişliği görüntü ve video işlemeleri için özel sabit işlevli donanım birimleridir.

- NVDEC, CUDA Çekirdeklerini kullanmadan GPU’da modern codec’ler (AV1, HEVC, H.264 gibi) için toplu veya gerçek zamanlı video çözümeye izin verir.

- NVJPEG, donanımda JPEG dekompresyonunu hızlandırarak, büyük ölçekli görüntü işleme hatlarını önemli ölçüde daha hızlı hale getirir.

- Her iki motor da NVIDIA DALI (Veri Yükleme Kütüphanesi) tarafından kullanılır; bu da onları AI eğitim ve çıkarım iş akışlarına entegre ederek, görüntü artırımı, veri seti ön işleme ve çoklu modelli model girişi hazırlığı için kullanılabilir.

- Decompression engine: 800 GB/sn hızla donanım hızlandırmalı veri dekompresyonu, CPU üzerindeki yükü azaltır ve analitik iş yükleri için sıkıştırılmış veri setlerinin daha hızlı yüklenmesini teşvik eder. NVIDIA nvCOMP, dekompresyon motorunun taşınabilir programlamasını sağlar.

NVIDIA GPU Çip Özeti Karşılaştırması

Blackwell Ultra’nın ilerlemelerini perspektife oturtmak için Tablo 2, Hopper, Blackwell ve Blackwell Ultra arasındaki ana çip spesifikasyonlarını karşılaştırmaktadır. Bu karşılaştırma, transistor sayısı, bellek kapasitesi, bağlantı bant genişliği ve hassasiyet hesaplama boyunca gösterilen nesil sıçramalarını ortaya koymaktadır; ayrıca dikkat hızlandırma ve NVFP4 gibi mimari gelişmeleri de içerir. Yan yana yapılan bu inceleme, Blackwell Ultra’nın performansı artırarak AI fabrika dağıtımlarında hem düğüm hem de raf ölçeği için kritik yetenekleri genişletmeye nasıl katkıda bulunduğunu sergiliyor.

| Özellik | Hopper | Blackwell | Blackwell Ultra |

|---|---|---|---|

| Üretim süreci | TSMC 4N | TSMC 4NP | TSMC 4NP |

| Transistörler | 80B | 208B | 208B |

| Çip başına die sayısı | 1 | 2 | 2 |

| NVFP4 yoğun | seyrek performansı | – | 10 | 20 PetaFLOPS | 15 | 20 PetaFLOPS |

| FP8 yoğun | seyrek performansı | 2 | 4 PetaFLOPS | 5 | 10 PetaFLOPS | 5 | 10 PetaFLOPS |

| Dikkat hızlandırma (SFU EX2) |

4.5 TeraExponentials/sn | 5 TeraExponentials/sn | 10.7 TeraExponentials/sn |

| Maks HBM kapasitesi | 80 GB HBM (H100) 141 GB HBM3E (H200) |

192 GB HBM3E | 288 GB HBM3E |

| Maks HBM bant genişliği | 3.35 TB/sn (H100) 4.8 TB/sn (H200) |

8 TB/sn | 8 TB/sn |

| NVLink bant genişliği | 900 GB/sn | 1,800 GB/sn | 1,800 GB/sn |

| Maks güç (TGP) | 700W’a kadar | 1,200W’a kadar | 1,400W’a kadar |

Çipten AI Fabrikasına

Blackwell Ultra GPU’lar, NVIDIA’nın bir sonraki nesil yapay zeka altyapısının omurgasını oluşturuyor; bu yapı, masaüstü süper çiplerden tam AI fabrika raflarına kadar dönüşüm performansı sağlıyor.

NVIDIA Grace Blackwell Ultra Süper Çipi

Bu süper çip, bir Grace CPU ile iki Blackwell Ultra GPU’yu NVLink-C2C aracılığıyla birleştirerek 30 PFLOPS yoğun, 40 PFLOPS seyrek NVFP4 AI hesaplaması sunuyor ve HBM3E ile LPDDR5X’i birleştirerek 1 TB birleşik bellek kapasitesine sahip. ConnectX-8 SuperNIC’ler, yüksek hızlı ağ bağlantısı için 800 GB/sn sağlar (Bkz. Şekil 7). NVIDIA Grace Blackwell Ultra Süper Çipi, GB300 NVL72 raf ölçek sistemi için temel hesaplama bileşenidir.

- NVIDIA GB300 NVL72 raf ölçek sistemi: Bu sıvı soğutmalı raf, NVLink 5 ve NVLink Switching ile birbirine bağlı 36 Grace Blackwell Süper Çipi barındırarak 1.1 exaFLOPS yoğun FP4 hesaplama performansına ulaşmasını sağlar. GB300 NVL72, aynı zamanda 10 kat daha iyi gecikmeye (kullanıcı başına TPS) ve Hopper platformlarına göre 5 kat daha yüksek verimliliğe sahip 50 kat daha yüksek AI fabrika çıktısını da sağlamaktadır. GB300 sistemleri, raf güç yönetimini de yeniden tanımlayarak, senkronize GPU yük artışlarını karşılamak için çoklu güç rafı yapılandırmalarına dayanır. NVIDIA güç düzeltmeleri, enerji depolama ve atma mekanizmaları ile yük çekme işlemlerini dengelemeye yardımcı olur.

- NVIDIA HGX ve DGX B300 Sistemleri: Standartlaştırılmış 8 GPU Blackwell Ultra yapılandırmaları. NVIDIA HGX B300 ve NVIDIA DGX GB300 Sistemleri, AI altyapısı için esnek dağıtım modellerini sürdürmeye devam ediyor ve tam CUDA ve NVLink uyumluluğu sağlıyor.

Tam CUDA Uyumluluğu

Blackwell Ultra, tüm CUDA ekosistemine tam geri uyumluluk sağlarken, bir sonraki nesil AI framework’leri için optimizasyonlar sunuyor:

- Framework entegrasyonu: NVFP4 hassasiyeti ve çift die mimarisi için optimize edilmiş çekirdekler ile SGLang, TensorRT-LLM ve vLLM’de yerel destek.

- NVIDIA Dynamo: Hedeflenmiş olarak dağıtılmış çıkarım ve zamanlama çerçevesi, iş yüklerini on binlerce GPU üzerinde akıllıca düzenleyerek büyük ölçekli dağıtımlar için %30’a kadar daha yüksek çıktılar sunuyor.

- NVIDIA Enterprise AI: Büyük ölçekte AI iş yüklerini geliştirmek, dağıtmak ve yönetmek için optimize edilmiş framework’ler, SDK’lar, mikro hizmetler ve kurumsal düzeyde araçlar sunan uçtan uca, bulut merkezli AI yazılım platformu.

- NVIDIA geliştirme araçları ve CUDA kütüphaneleri:

- Özel çekirdek geliştirme için CUTLASS

- Profil oluşturma ve ayarlama için Nsight Systems ve Nsight Compute

- Hassasiyete dikkat eden grafik optimizasyonu için Model Optimizer

- Derin öğrenme parçaları için cuDNN

- Çoklu GPU iletişimi için NCCL

- Başlatma yükünü azaltmak için CUDA Graphs

Sonuç

NVIDIA Blackwell Ultra, AI fabrikalarının ölçeksiz ve verimsiz yapay zeka uygulamalarını bir araya getirmek için sağlam bir temel oluşturuyor. Çift die entegrasyonundaki yenilikler, NVFP4 hızlandırması, devasa bellek kapasitesi ve ileri teknolojide bağlantılar sayesinde, Blackwell Ultra daha önce hesaplama açısından imkânsız olan AI uygulamalarını gerçekleştirmeye olanak tanıyor.

Endüstri, kanıt niteliğindeki AI’dan, üretim AI fabrikalarına geçerken, Blackwell Ultra, yapay zeka hedeflerini gerçeğe dönüştürmek için eşsiz performans, verimlilik ve ölçek sunarak, hesaplama temelini oluşturuyor.

Daha Fazla Bilgi Alın

Bir trilyon token çağına güç veren yenilikler hakkında daha derine dalın. Tam silicon-sistem hikayesini keşfetmek için Blackwell Mimarisi Teknik Raporunu indirin.

Şükran

Bu yazıya katkıda bulunan NVIDIA GPU mimarları, mühendisleri ve ürün yöneticileri Manas Mandal, Ronny Krashinsky, Vishal Mehta, Greg Palmer, Michael Andersch, Eduardo Alvarez, Ashraf Eassa, Joe DeLaere ve diğerleri için teşekkür ederiz.