Gelişmiş dil modelleri (LLM’ler) büyüdükçe daha zeki hale geliyor. Şu anda ön plana çıkan açık modeller, yüz milyarlarca parametre ile donatılmış durumda. Aynı zamanda, günümüzdeki en iyi modeller mantıklı düşünme yeteneğine sahip, bu da kullanıcıya son yanıtı vermeden önce birçok ara akıl yürütme işlemi gerçekleştirdikleri anlamına geliyor. Bu iki eğilimin bir birleşimi—büyüyen modeller ve daha fazla token kullanarak düşünme—signifikant bir şekilde daha yüksek hesaplama performansı gerekliliğini artırıyor.

En iyi üretim yüklerinde en yüksek performansı sağlamak, en son teknoloji yelpazesini gerektiriyor; bu yelpaze çipleri, sistemleri ve yazılımları kapsıyor ve sürekli olarak bu yelpazeye katkı sağlayan geniş bir geliştirici ekosistemini içeriyor.

MLPerf Inference v5.1, MLPerf Inference endüstri standartları benchmark’ının son versiyonu. Yılda iki kez yapılan benchmark turları, AI çıkarım performansına dair bir dizi test içeriyor ve düzenli olarak yeni modeller ve senaryolarla güncelleniyor. Bu turda yer alan başlıca modeller ve detayları şunlardır:

- DeepSeek-R1 – 671 milyar parametreye sahip popüler bir karışım uzmanı (MoE) akıl yürütme modeli, DeepSeek tarafından geliştirilmiştir. Sunucu senaryosunda, ilk token için geçen süre (TTFT) 2 saniye olup, kullanıcı başına 12.5 token/saniye (TPS/user) hedefi bulunmaktadır. Belirtilen TPS/user hedeflerinin %99’u, belirlenen hızın altında kalmamasını garanti eder.

- Llama 3.1 405B – MLPerf Inference v5.1, Llama 3.1 serisinin en büyük modeline yönelik yeni bir etkileşim senaryosu ekliyor; bu senaryo, mevcut sunucu senaryosuna göre daha hızlı bir 12.5 TPS/user eşiği ve daha kısa bir 4.5 saniye TTFT gerektirmektedir.

- Llama 3.1 8B – Llama 3.1 serisinin 8 milyar parametreye sahip bir üyesi, çevrimdışı, sunucu (2 saniye TTFT, 10 TPS/user) ve etkileşimli (0.5 saniye TTFT, 33 TPS/user) senaryolar sunuyor. Bu, önceki turlarda kullanılan GPT-J benchmark’ının yerini alıyor.

- Whisper – son bir ayda HuggingFace‘te neredeyse 5 milyon indirme sayısına ulaşan popüler bir ses tanıma modeli. Bu, daha önceki MLPerf Inference benchmark setlerinde yer alan RNN-T’nin yerini aldı.

Bu turda, NVIDIA yeni Blackwell Ultra mimarisiyle ilk sonuçlarını gönderdi. Bu, MLPerf Inference v5.0’da Blackwell mimarisinin ilk kez görünmesinden yalnızca altı ay sonra gerçekleşti ve yeni çıkarım performans rekorları belirledi. Ayrıca, NVIDIA platformu bu turda eklenen tüm yeni benchmarklar—DeepSeek-R1, Llama 3.1 405B, Llama 3.1 8B ve Whisper—üzerinde yeni performans kayıtları da belirledi ve diğer tüm MLPerf çıkarım benchmarklarına göre GPU başına performans rekorlarını tutmaya devam ediyor.

| MLPerf Çıkarım Performans Kayıtları | |||

| Benchmark | Çevrimdışı | Sunucu | Etkileşimli |

| DeepSeek-R1 | 5,842 token/saniye/GPU | 2,907 token/saniye/GPU | ** |

| Llama 3.1 405B | 224 token/saniye/GPU | 170 token/saniye/GPU | 138 token/saniye/GPU |

| Llama 2 70B 99.9% | 12,934 token/saniye/GPU | 12,701 token/saniye/GPU | 7,856 token/saniye/GPU |

| Llama 2 70B 99% | 13,015 token/saniye/GPU | 12,701 token/saniye/GPU | 7,856 token/saniye/GPU |

| Llama 3.1 8B | 18,370 token/saniye/GPU | 16,099 token/saniye/GPU | 15,284 token/saniye/GPU |

| Stable Diffusion XL | 4.07 örnek/saniye/GPU | 3.59 sorgu/saniye/GPU | ** |

| Mixtral 8x7B | 16,099 token/saniye/GPU | 16,131 token/saniye/GPU | ** |

| DLRMv2 99% | 87,228 örnek/saniye/GPU | 80,515 örnek/saniye/GPU | ** |

| DLRMv2 99.9% | 48,666 örnek/saniye/GPU | 46,259 sorgu/saniye/GPU | ** |

| Whisper | 5,667 token/saniye/GPU | ** | ** |

| R-GAT | 81,404 örnek/saniye/GPU | ** | ** |

| Retinanet | 1,875 örnek/saniye/GPU | 1,801 sorgu/saniye/GPU | ** |

MLPerf Inference v5.0 ve v5.1, Kapalı Bölüm. Sonuçlar 9 Eylül 2025 tarihinde www.mlcommons.org üzerinden alınmıştır. NVIDIA platformu aşağıdaki girişlerden elde edilen sonuçlar: 5.0-0072, 5.1-0007, 5.1-0053, 5.1-0079, 5.1-0028, 5.1-0062, 5.1-0086, 5.1-0073, 5.1-0008, 5.1-0070, 5.1-0046, 5.1-0009, 5.1-0060, 5.1-0072, 5.1-0071, 5.1-0069. Çip başına performans, toplam verimliliğin rapor edilen çip sayısına bölünmesiyle elde edilmiştir. Her bir çip için performans, MLPerf Inference v5.0 veya v5.1’in birincil metriği değildir. MLPerf adı ve logosu, MLCommons Derneği’nin Amerika Birleşik Devletleri ve diğer ülkelerde tescilli ve tescil edilmemiş markalarıdır. Tüm hakları saklıdır. İzinsiz kullanım kesinlikle yasaktır. Daha fazla bilgi için www.mlcommons.org adresini ziyaret edin.

NVIDIA, ayrıca tüm DeepSeek-R1 ve Llama model gönderimlerinde NVFP4 hızlandırmasının kapsamlı bir şekilde kullanılmasını sağladı.

Blackwell Ultra ile Akıl Yürütme Rehberlik Rekorları

Bu turda, NVIDIA GB300 NVL72 rack ölçekli sistemi kullanarak mevcut durumda sonuçlar sundu; Blackwell Ultra mimarisi kullanarak yapılan ilk MLPerf gönderimleri oldu. Blackwell Ultra, NVIDIA Blackwell mimarisinde yapılan birçok gelişmeye dayanıyor ve birkaç önemli iyileştirme sunuyor:

- 1.5 kat daha yüksek NVFP4 yapay zeka hesaplama kapasitesi

- 2 kat daha yüksek dikkat katmanı hesaplama kapasitesi

- 1.5 kat daha yüksek HBM3e kapasitesi

GB200 NVL72 gönderisiyle karşılaştırıldığında, GB300 NVL72, GPU başına 1.4 kat daha yüksek performans sundu ve bu yeni DeepSeek-R1 benchmark’ında yeni bir standart belirledi. Doğrulanmamış sonuçlarla karşılaştırıldığında, Blackwell Ultra, GPU başına yaklaşık 5 kat daha yüksek verimlilik sağladı. Bu da önemli ölçüde daha yüksek bir yapay zeka fabrikası verimliliği sağladı ve token maliyetlerini düşürdü.

| DeepSeek-R1 Performansı | ||

| Mimari | Çevrimdışı | Sunucu |

| Hopper | 1,253 token/saniye/GPU | 556 token/saniye/GPU |

| Blackwell Ultra | 5,842 token/saniye/GPU | 2,907 token/saniye/GPU |

| Blackwell Ultra Avantajı | 4.7 kat | 5.2 kat |

MLPerf Inference v5.1, Kapalı. Blackwell Ultra sonuçları, 5.1-0072 girişinde elde edilen sonuçlara dayanmaktadır. Hopper sonuçları **MLCommons Derneği tarafından doğrulanmamaktadır. GPU başına performans MLPerf Inference v5.1’in birincil metriği değildir ve rapor edilen verimliliğin toplamı, rapor edilen hızlandırıcı sayısına bölünerek hesaplanır. Doğrulanmış sonuçlar, 9 Eylül 2025 tarihinde www.mlcommons.org adresinden alınmıştır. MLPerf adı ve logosu, MLCommons Derneği’nin Amerika Birleşik Devletleri ve diğer ülkelerde tescilli ve tescil edilmemiş markalarıdır. Tüm hakları saklıdır. İzinsiz kullanım kesinlikle yasaktır. Daha fazla bilgi için www.mlcommons.org adresini ziyaret edin.

Bu sonuçları mümkün kılabilen, Blackwell Ultra’nın olağanüstü mimari yetenekleri ve son derece optimize edilmiş NVIDIA çıkarım yelpazesidir. Blackwell Ultra’nın DeepSeek-R1 için sunduğu anahtar teknolojiler şunlardır:

NVFP4’ün Yaygın Kullanımı

Temel DeepSeek-R1 modeli, FP8 hassasiyetinde depolanan ağırlıklar içeriyor. NVIDIA tarafından geliştirilen ve NVIDIA TensorRT Model Optimizasyon kütüphanesinin bir parçası olarak dahil edilen bir kuantizasyon tarifi kullanılarak, DeepSeek-R1’in ağırlıklarının çoğu başarılı bir şekilde NVFP4’e kuantize edildi. Bu, model boyutunu azaltırken, Blackwell ve Blackwell Ultra’daki daha yüksek işlem hacmi kullanma imkanı sağladı ve benchmark’ın belirlediği hassasiyet hedefini karşıladı.

FP8 Anahtar-Değer Ön Belleği

Temel DeepSeek-R1 modelinde, anahtar-değer (KV) önbelleği BF16 veri formatında depolandı. Bir kez daha, TensorRT Model Optimizer ve TensorRT-LLM çıkarım kütüphanelerini kullanarak, KV önbelleği FP8 hassasiyetine kuantize edildi ve bu da bellek alanını önemli ölçüde azalttı ve daha yüksek performansı sağladı.

Yeni Paralellik Teknikleri

DeepSeek-R1 modelinin benzersiz mimarisi nedeniyle, çoklu GPU yürütmesi için kullanılan geleneksel tensör paralel ve boru hattı paralel teknikleri maksimum performans için yetersiz kaldı. NVIDIA DeepSeek-R1 gönderimleri için uzman paralelliği (MoE) model yürütmesinin bir parçası olarak ve dikkat mekanizması için veri paralelliği kullanıldı. Bu, yeniden tasarlanan MoE ve dikkat çekirdekleri ile birlikte toplama ve dağıtma işlemlerini gerçekleştiren yeni iletişim çekirdeklerini gerektirdi.

Bu yeni paralellik tekniği, tüm GPU’lar arasında bağlam sorgu yükünü dengelemek için kritik bir öneme sahip. Bu meydan okuma, yüksek genel verimliliği ve düşük ilk token gecikmesini (TTFT) korumayı içeriyor. Dikkat Veri Paralelliği Dengesi (ADP Balance) geliştirilmiş bir teknik, bu sorunları çözmek için bağlam sorgusunu akıllıca dağıtarak her bir GPU’nun verimliliğini artırıyor. Bu, tıkanıklıkları önleyerek, tüm kullanıcılar için hızlı ve yanıt veren bir deneyim sunuyor. Detaylı teknik bilgi için TensorRT-LLM GitHub sayfasına başvurabilirsiniz.

CUDA Grafikleri

Firmware iterasyonları için yalnızca decode işlemlerinde, NVIDIA gönderimleri GPU işlemlerini tek bir CPU işlemi kullanarak kaydetmek ve yeniden oynatmak için CUDA Grafikleri kullanır. Bu yöntem CPU üst yükünü azaltarak daha yüksek performans sağlar.

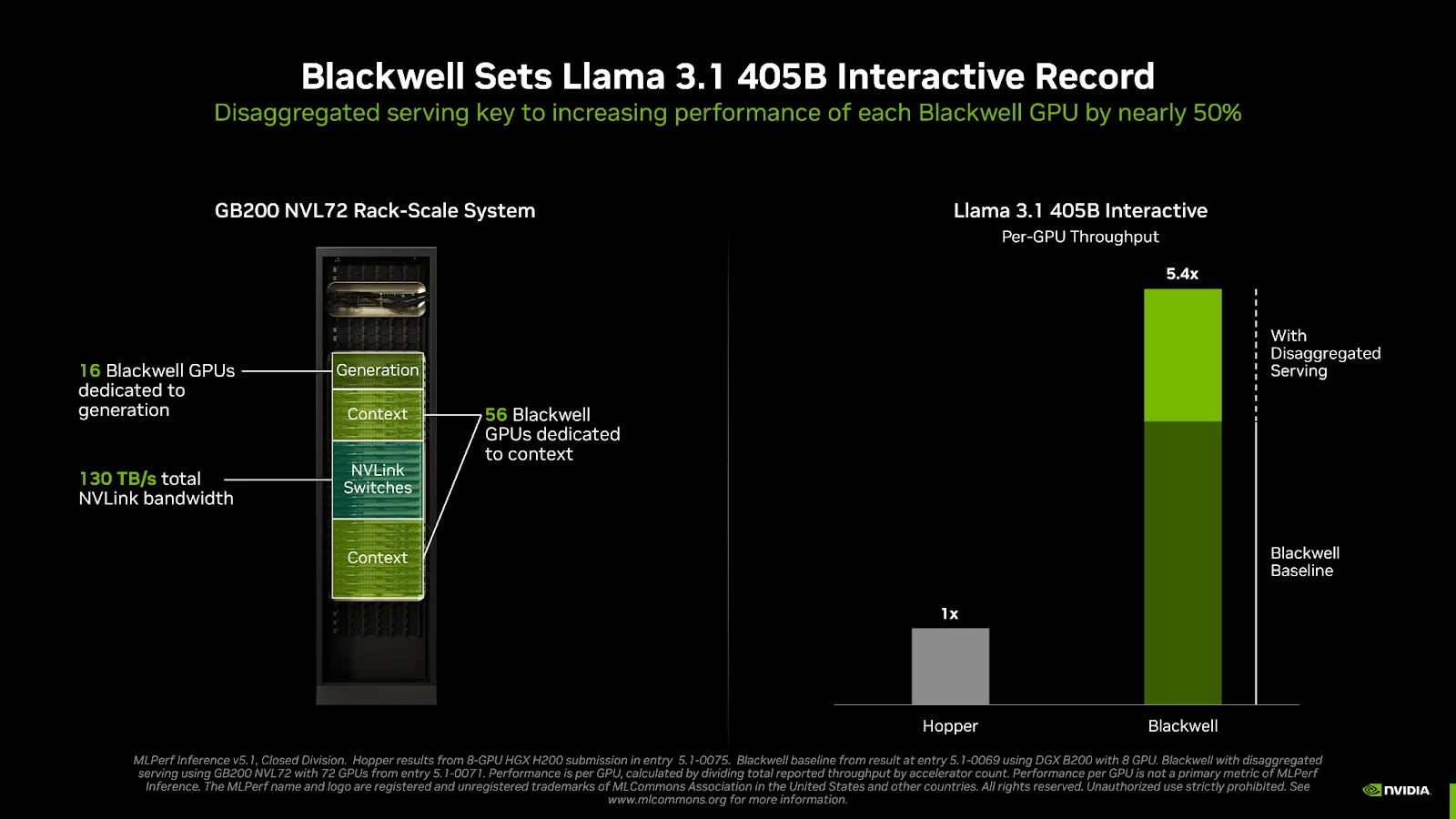

Disaggregated Sunumla Blackwell Performansı

Llama 3.1 405B benchmark’ı için eklenen yeni etkileşim senaryosu, sunucu senaryosuna göre daha sıkı TTFT ve TPS/user gereksinimleri getiriyor ve token çıkış hızında 2 kat daha fazla ve TTFT süresinde 1.3 kat daha hızlıdır. Bu zorlu yeni benchmark senaryosunda güçlü performans sunmak, NVIDIA Blackwell platformu ve NVIDIA çıkarım yazılım yelpazesinde birçok son teknoloji ürünü teknolojinin uygulanmasını gerektirdi.

Bu kadar büyük Llama 3.1 405B modelini etkileşimli token hızlarında sunabilmek için, modellerin birçok GPU arasında bölündüğü bir sistem kullanmak, optimal verimlilik sağlıyor ve gecikme gereksinimlerini karşılıyor. Bu büyük model için çoklu-GPU çıkarımının muazzam iletişim ihtiyaçlarını karşılamak üzere, NVIDIA Blackwell ve Blackwell Ultra platformları 72 GPU arasında 1,800 GB/s hızında her yönlü iletişimi destekliyor. Toplam agregat bant genişliği ise 130 TB/s’ye ulaşıyor.

Bu gereksinimleri karşılarken maksimum verimliliği sağlamak amacıyla, NVIDIA’nın GB200 NVL72 rack ölçekli sistemi, bu benchmark’ta, geleneksel toplu hizmet yerine disaggregated sunum uygulamasıyla gönderildi. Bu uygulama, geleneksel toplu hizmet sistemine kıyasla GPU başına neredeyse 1.5 kat daha fazla verimlilik kazandırdı; ayrıca toplu hizmet sonuçlarına göre 5 kat daha fazla bir gelişim sağladı.

Hopper sonuçları 8-GPU HGX H200 gönderiminde, 5.1-0075 girişine aittir. Blackwell temel değerlerinden, 5.1-0069 girişinden alınmıştır. Blackwell disaggregated sunumu ise GB200 NVL72 ile 72 GPU’dan edinilen sonuçlardır, 5.1-0071’de belirtilmiştir. Performans, toplam rapor edilen verimliliğin hızlandırıcı sayısına bölünmesi ile hesaplanmış olup, GPU başına olarak ifade edilen bir metrik değildir. MLPerf adı ve logosu, MLCommons Derneği’nin Amerika Birleşik Devletleri ve diğer ülkelerde tescilli ve tescil edilmemiş markalarıdır. Tüm hakları saklıdır. İzinsiz kullanım kesinlikle yasaktır. Daha fazla bilgi için www.mlcommons.org adresine başvurun.

Geleneksel LLM uygulamaları, çıkarımın iki ana aşamasını—bağlam ve üretimi—aynı GPU veya düğüm üzerinde birleştirir. Ancak bu aşamalar temel olarak farklı özelliklere sahiptir: Bağlam, token-paralel ve hesaplama yoğun iken, üretim ise otoregresif ve gecikmeye duyarlıdır. Ayrıca, her iki aşama da farklı hizmet seviyeleri altında çalışır—bağlam için TTFT, üretim için ise aratoken gecikmesi (ITL) söz konusu olduğundan, bu aşamalar genelde farklı model paralelleme stratejileri gerektirir. Bir arada bulunmaları sıklıkla uzun giriş dizileri için verimsiz kaynak kullanımıyla sonuçlanır.

Disaggregated sunum, bağlam ve üretimi farklı GPU veya düğümler arasında ayrıştırarak, her aşama için bağımsız optimizasyon yapılmasına olanak tanır. Bu yaklaşım, her aşama için farklı paralellik tekniklerinin ve esnek GPU tahsisinin kullanılmasını sağlayarak genel sistem verimliliğini artırır.

NVIDIA Dynamo çıkarım çerçevesi, disaggregated sunum desteği sağlar. Dynamo’nun son sürümü, disaggregated sunumdan fazlasını içeren birçok ek yetenek sunmaktadır; SLA tabanlı otomatik ölçekleme, gerçek zamanlı LLM gözlemleme ölçüleri ve hata toleransı gibi. Daha fazla bilgi edinebilirsiniz.

Temel Çıkarımlar

NVIDIA, hem yeni eklenen hem de mevcut benchmarklar üzerinde geniş bir yapay zeka modeli yelpazesindeki çıkarım performansını kanıtlayarak liderliğini sürdürmeye devam ediyor. Blackwell Ultra GPU mimarisine dayanan GB300 NVL72 rack ölçekli sisteminin piyasaya sürülmesi, akıl yürütme çıkarımını büyük ölçüde artırdı ve bu, sadece altı ay önce Blackwell tabanlı GB200 NVL72 gönderisi ile gerçekleşti.

Ayrıca, Llama 3.1 405B etkileşim gönderimi, ileri düzey hizmet tekniklerinin çıkarım verimliliğinde büyük artışlar sağlayabileceğini göstermektedir.

Bu blogda yer alan harika sonuçları yeniden üretmek için, MLPerf Inference v5.1 GitHub deposuna göz atabilirsiniz.

Ve çıkarım performansını daha da hızlandırmak için NVIDIA, uzun bağlam işleme için özel olarak tasarlanmış Rubin CPX adlı bir işlemci tanıttı. Bu yeni Rubin CPX hakkında daha fazla bilgi için bu teknik blog yazısını okuyabilirsiniz.