Yapay zeka sistemleri ve iş yüklerinin hızla geliştiği bu dönemde, model eğitimi performansını en üst düzeye çıkarmak, yalnızca çip hızından daha fazlasını gerektiriyor. Bu, hesaplama, ağ ve model çerçevesi olmak üzere tüm katmanı kapsamlı bir değerlendirmeyi gerektiriyor.

Yapay zeka sisteminin performansını değerlendirmek karmaşık bir süreç olabilir. Uygulama değişiklikleri yapmanın birçok yolu var, ancak bunlar şu anda etkili bir şekilde uygulamak için önemli çaba ve özel bilgi gerektiriyor.

NVIDIA DGX Cloud Benchmarking Recipes, eğitim performansını artırma konusunda rehberlik sunan bir kaynak niteliğindedir; bu kaynak, her iş yükü için iyi performansın neye benzediğini ve buraya nasıl ulaşılacağına dair en iyi uygulamaları paylaşıyor.

Daha fazla bilgi almak için NVIDIA DGX Cloud Benchmarking Recipes‘e göz atabilirsiniz.

Yapay Zeka Sistemini Kapsamlı Olarak Değerlendirmek

DGX Cloud Benchmarking Recipes, hem gerçek dünya ortamlarında performansı ölçen hem de yapay zeka eğitim iş yüklerinde optimizasyon fırsatlarını tanımlayan bir uçtan uca benchmarking setidir. Bu tarifler, gerçek dünya yapay zeka uygulamaları için performansı değerlendirmek üzere hazırlanmıştır ve tüm AI yelpazesini göz önünde bulundurur.

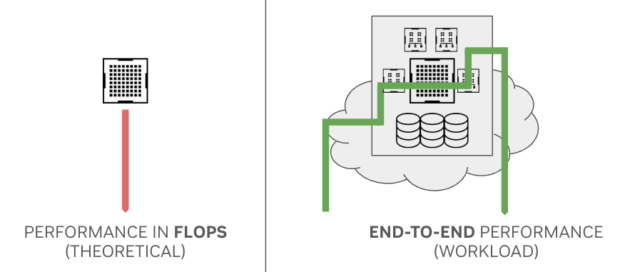

Çip merkezli ölçütler, örneğin, teorikyüke karşı işlemci performansı (FLOPS) ve bant genişliği, son derece uç performansı tahmin etmekte yetersiz kalabilir. Geleneksel olarak, peak FLOPS platformların karşılaştırılmasında sıkça kullanılsa da, end-to-end uygulama performansını etkileyen birçok unsurlardan yalnızca bir tanesidir.

Pratikte, bir yapay zeka modelinin eğitim süresi, ağ, yazılım, donanım ve altyapı gibi birçok farklı bileşenin işleyişine bağlıdır.

Örneğin, NVIDIA NVLink ağ fabrici, geleneksel tek sunucu, 8-GPU limitinin ötesinde, paralel stratejilerin ölçeklenmesini sağlar. NVIDIA Grace sınıfı sistemlerde, NVLink ağı, gerçek dünya uygulamalarında daha yüksek FLOPS elde etmenize olanak tanır ve teorik ile pratik performans arasındaki farkı kapatır.

AI platformlarını yalnızca FLOPS ile değerlendirmek, toplam eğitim süresi ve ilgili maliyetler hakkında yanlış tahminlere yol açabilir. Günümüzün modern AI iş yükleri, örneğin Llama 3.1 modellerinin ince ayarını yaparken, son derece kapsamlı performans ölçümleri yaparak, gerçek kullanım senaryolarında bir platformun nasıl performans göstereceği konusunda daha doğru bilgiler sunmak önemlidir.

Performansı etkileyen altyapı faktörleri şunlardır:

- Sunucu donanım tasarımları

- İşletim sistemleri

- Sanalizasyon katmanları

- Yazılım yığılmaları

- Ağ mimarileri

- Depolama uygulamaları

Performansı etkileyen yapay zeka iş yükü faktörleri şöyle sıralanabilir:

- Hesaplama ile iletişim oranı

- Model ölçekleme faktörleri

- Batch boyutu

- Kesinlik formatı

- Veri yükleme stratejileri

İş Yüklerini Optimal Performansa Ayarlamak

Yalnızca iş yürütme yönünden benchmarking yapmanın ötesinde, NVIDIA DGX Cloud Benchmarking Recipes aynı zamanda popüler modeller ve iş yüklerini optimize etmek için kılavuz niteliğindedir. Bu tarifler, Llama 3.1, Grok ve Mixtral gibi popüler modellerin performansını maksimize etmek için iş yüküne özgü stratejiler sunmaktadır.

| İş Yükü | Tip | Açıklama | Container Versiyonu | Dataset | Maks. Ölçek (#GPU) | DTYPE |

| Nemotron4 | Eğitim | 15B ve 340B benchmarkları | 24.09 | Sentetik | 2048 | FP8, BF16 |

| Nemo Megatron | Eğitim | 175B benchmarkları | 24.05 | Pile | 2048 | FP8, BF16 |

| Llama 3.1 | Eğitim | 8B, 70B, ve 405B benchmarkları | 24.09 | Pile | 2304 | FP8, BF16 |

| PaXML | Eğitim | 5B ve 175B benchmarkları | 24.03.04 | Sentetik | 2048 | FP8, BF16 |

| Maxtext | Eğitim | Llama2 70B benchmarkları | 2024.12.09 | Sentetik | 2048 | FP8, BF16 |

| Grok1 | Eğitim | Grok1 314B benchmarkları | 24.09 | Sentetik | 2048 | FP8, BF16 |

| Llama 2 | İnce Ayar | Hugging Face 70B benchmarkları | 24.02 | HF Llama2 | 512 | BF16 |

| Mistral | İnce Ayar | Hugging Face 7B benchmarkları | 24.02 | HF Mistral | 256 | BF16 |

Tablo 1’de, iş yükleri eğitim ve ince ayar süreçlerini içermekte ve mümkün olan yerlerde FP8 ve BF16 desteklemektedir.

Her eğitim iş yükü, platformu kullanma şeklinin farklı bir parmak izine sahiptir. İş yükü parmak izinin temel sorusu şudur: “Hesaplama süresi, iletişim veya ağ süresi ile ne kadar örtüşüyor?”

Bazı modeller daha fazla hesaplama odaklı olabilirken, bazıları iletişim odaklıdır ve bu, paralel strateji seçimine ve sıra uzunluğu ve batch boyutu gibi hiper parametrelere bağlıdır. Modellerin ölçeklenmesi, artırılan GPU sayısı ile farklılık gösterir, ayrıca zayıf veya güçlü ölçekleme gibi türler de vardır.

Her iş yükü ve küme ölçeği için modelinizi ve sisteminizi optimal performans için ayarlamalısınız.

Model tarafında, bu, paralel stratejilerin, batch boyutlarının, kesinlik formatlarının ve veri yükleme stratejilerinin ayarlanmasını içerebilir. Sistem tarafında ise, iş yükünün maksimum düzeyde NVLink yüksek bant genişliğinden faydalandığından emin olmanız önemlidir (örneğin tensor ve bağlam paralelliği için) ve ölçeklendirme dokusunun ilgili ağ toplulukları için bir engel oluşturmadığını doğrulamanız gerekir (örneğin, boru hattı veya uzman paralelliği için).

Bu, RDMA gibi düşük taşıma gecikmesi sağlayan bir doku ve etkilitrafik yönetimi ve uygulamalı yönlendirme gerektirir. Yapay zeka iş yüklerinin verimli bir şekilde ölçeklenmesi için bu teknolojilerin kullanılması önemlidir çünkü bu, titremeyi azaltarak tutarlı performans ve güvenilirlik sağlayabilir.

FP8 Kullanımı

DGX Cloud Benchmarking Recipes, FP8 iş yükleri için özellikle optimize edilmiş konfigürasyonlar ve ayar önerileri sunarak optimal performans elde etmenize yardımcı olmaktadır. Örneğin, Llama 3.1 70B eğitimi için tarif, DGX Cloud platformları için dikkatle test edilmiş ve optimize edilmiş FP8 ayarları içermektedir.

Bir yapay zeka iş yükü için iyi performansın ne olduğunu anlamak karmaşık olabilir. DGX Cloud Benchmarking Recipes, çeşitli popüler modeller için bir dizi temel performans sonucu sağlayarak, kendi uygulamalarınız için gerçekçi beklentiler ve hedefler belirlemenize olanak tanır.

Bu temel veriler, mevcut işlem kaynaklarının ne kadar verimli kullanıldığını ölçen model FLOPS kullanımı (MFU) gibi metrikleri içerir. MFU ve veri akışı, popüler modeller için nasıl karşılaştırıldığını görebilirsiniz. Sonuçlarınızı bu karşılaştırmalarla değerlendirerek optimizasyonlarınızın etkinliğini gözlemleyebilir ve iyileştirme alanlarını belirleyebilirsiniz.

DeepSeek-R1, bir NVIDIA H200 GPU düğümünde çalışabilen 671B parametreli bir modeldir. Yüksek işlemci kullanımı, hesaplama, ağ ve paralellik stratejilerinin kapsamlı optimizasyonu ile ulaşılan performansın nasıl teorik limitlere daha yakın olabileceğini göstermektedir. Sistematik benchmarking, doğrudan karşılaştırmalar yapmayı sağlar ve ekiplerin modellerini ve platformlarını işbirliği içinde optimize etmelerine yardımcı olur.

Son olarak, bu iş yükü bazlı performans optimizasyonları, uygulama ayarları etrafında daha fazla araştırma ve tartışma gereksinimini de göstermektedir. Örneğin, paralelleştirme stratejilerinin önerilen kullanımı, iş yükleri ve platformlar arasındaki kombinasyonlara göre değişiklik göstermektedir.

DGX Cloud Benchmarking Recipes ile Başlayın

Platform performansını benchmark etmek için tarifler, NVIDIA’nın halka açık kaydı olan NGC Kataloğu’nda barındırılmaktadır. Tarife güncellemeleri hakkında daha fazla bilgi almak için DGX Cloud Benchmarking 24.11.1‘ye bakabilirsiniz.

Her iş yükü tarifinde, aşağıdaki bilgilere erişim sağlayabilirsiniz:

- Çevreler arası yeniden üretilebilirlik için konteynerize edilmiş benchmarklar

- Gerekli olduğu durumlarda sentetik veri üreten scriptler

- Performans metriği toplama ve raporlama (stdout’a)

- Platforma özgü konfigürasyon en iyi uygulamaları

- Kıyaslama için NVIDIA referans mimarisinden performans verileri

Bu tarifler, Slurm küme yönetimini gerektirmektedir. Kubernetes desteği şu anda geliştirilme aşamasındadır. DGX Cloud Benchmarking Recipes’i kullanmak için, en uygun iş yüküne uyum sağlayan tarife dosyasını indirin ve küme kurulum ve benchmarking scriptlerini çalıştırın.

Platform Performans Hedeflerini Sürekli Hareket Ettir

Günümüz yapay zeka dünyasında optimal performans elde etmek, yalnızca bireysel bileşenlere odaklanarak değil, tüm sistemlerin nasıl birlikte çalıştığını kavrayarak mümkün olmaktadır. Ham GPU kapasiteleri elbette önemlidir; ancak tam optimizasyon, donanım ve yazılım yapılandırmalarından iş yüküne özgü parametrelere kadar her katmanın dikkatlice ayarlanmasıyla mümkündür.

NVIDIA olarak, her teknoloji katmanını sürekli geliştirmek için benchmark tariflerini kullanıyoruz; bu da donanım bağlantılarından (NVIDIA NVLink ve NVLink Switch gibi) yazılım kütüphanelerine (NVIDIA TensorRT-LLM gibi) kadar önemli performans kazançları sağlıyor.

Örneğin, yalnızca yazılım geliştirmeleriyle, MLPerf Inference’da H100 GPU’larında3.4 kat artış sağlanmıştır ve bu, bir yıl içinde gerçekleşmiştir. Bu sürekli optimizasyonlar, kuruluşların daha karmaşık modeller çalıştırmasını, altyapı gereksinimlerini azaltmasını ve verimliliği artırmasını mümkün kılmakta; bu da daha fazla yenilik yaratmaktadır.

Bu benchmarking tarifleri, ekibinizin aşağıdaki hedeflere ulaşmasına yardımcı olur:

- FP8 için belirli ortamlar için yapay zeka iş yüklerini optimize etmek.

- Bir kümenin performansının NVIDIA’nın gözlemlenen performansına ne kadar yakın olduğunu değerlendirmek.

- Mevcut kurulumlarınızda performans darboğazlarını belirlemek.

Büyük modellerin eğitimi haftalar veya aylar sürebilir ve bu süreç milyonlarca işlem kaynağı gerektirebilir; bu nedenle, küçük performans iyileştirmeleri bile zaman ve maliyet tasarrufuna dönüşebilir. NVIDIA’nın sürekli olarak gelişen performans optimizasyonları ve iş yüküne özgü tarifleri ile, iş gücünüzü altyapı ayarlarından ziyade yeniliğe odaklamanız mümkündür.

Daha fazla bilgi için DGX Cloud Benchmarking Recipes‘e göz atabilirsiniz.