NVIDIA GTC 2025‘te, büyük ölçekli dağınık dağıtım ortamlarında üretken yapay zeka ve akıl yürütme modelleri için yüksek verimli, düşük gecikmeli bir açık kaynaklı çıkarım sunma çerçevesi olan NVIDIA Dynamo‘yu tanıttık.

Dynamo’nun en son v0.2 sürümü, aşağıdaki özellikleri içermektedir:

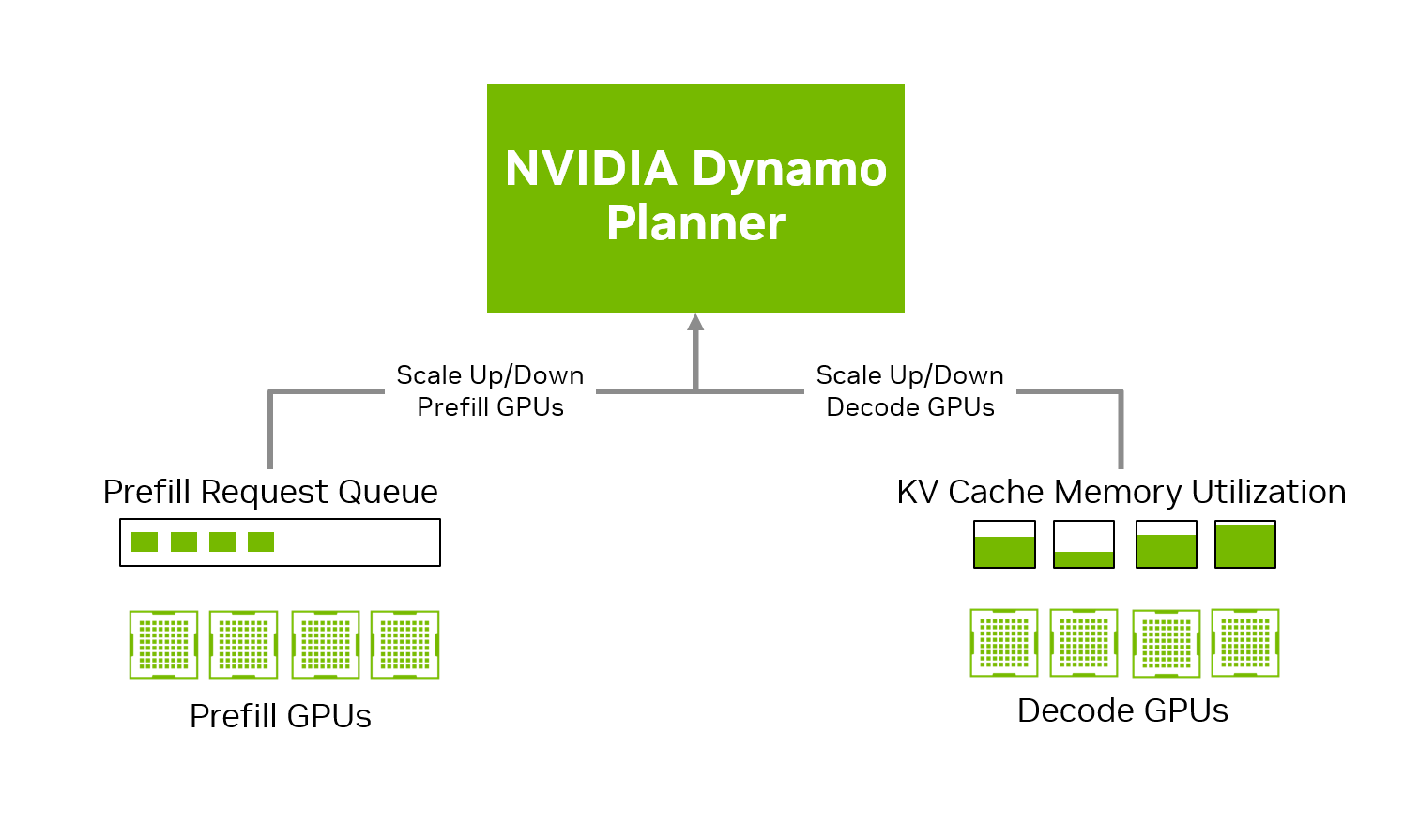

- Prefill ve decode GPU autoscaling için bir planlayıcı.

- Büyük ölçekli Dynamo dağıtımları için Kubernetes otomasyonu.

- AWS üzerindeki internode veri transferleri için AWS Elastic Fabric Adaptor (EFA) desteği.

Bu yazıda, bu özellikleri inceleyecek ve GPU yatırımlarınızdan nasıl daha fazla verim alabileceğinizi göstereceğiz.

Dağınık Dağıtım Yükleri için GPU Autoscaling

Bulut bilişimin hızlı benimsenmesinin temel sebeplerinden biri olan otomatik ölçekleme, talebe göre otomatik olarak hesaplama kapasitesini ayarlama yeteneğidir. Bu, önceden zirve yükler için altyapı sağlamaya gerek kalmadan maliyet verimliliği ve operasyonel esneklik sunar. Ancak, bu kavramın modern LLM çıkarım yükleri için etkili uygulanması hala büyük bir zorluktur.

Geleneksel otomatik ölçekleme, genellikle saniye başına sorgu sayısı (QPS) gibi basit metriklere dayanır. Ancak, modern LLM sunum ortamlarında tüm çıkarım talepleri eşit değildir ve özellikle dağınık sunum kullananlarda QPS tek başına sistem yükünü tahmin etmek için yetersizdir. Uzun giriş dizisi uzunluğuna (ISL) sahip bir istek, kısa ISL’lere sahip olanlardan çok daha fazla kaynak tüketebilir.

Uzun ISL’ler, prefill GPU’lar üzerinde baskı oluştururken, uzun çıkış dizi uzunlukları (OSL) decode GPU’larını zorlar. Dağınık bir kurulumda, yük dağılımı anlık olarak dramatik şekilde değişebilir, bu nedenle QPS gibi basit metriklere dayalı otomatik ölçekleme stratejileri etkisiz hale gelir. Bu karmaşıklık, prefill ve decode GPU’ları arasında yük dengelemesini zorlaştırır.

Bunun için, LLM’ye özgü çıkarım kalıplarını ve dağınık sunum mimarilerini anlayan, özel bir planlama motoruna ihtiyaç vardır. Bu motor, yalnızca ne zaman ölçekleneceğine değil, hangi tür GPU’ların nasıl bir yönde ölçekleneceğine de karar vermelidir. Ayrıca, geliştiricilerin talep dalgalanmalarını prototipleme ve büyük ölçekli üretim dağıtımlarında dikkate alabilmelerine olanak tanıyan yerel deneyleri desteklemelidir.

v0.2 sürümüyle birlikte, NVIDIA Dynamo Planlayıcıyı tanıtıyoruz. Bu planlayıcı, dağınık sunum için çıkarım bilincine sahip bir otomatik ölçekleyicidir. Dynamo Serve CLI (Komut Satırı Arayüzü) kullanan geliştiriciler, artık GPU Planlayıcısını dağıtımlarıyla bir arada çalıştırarak, yük kalıplarını izleyebilir ve prefill ile decode aşamaları arasında hesaplama kaynaklarını dinamik olarak yönetebilirler.

LLM’leri Lokal Gelişimden Üretime Tek Komutla Ölçeklendirme

AI çıkarım ekiplerinin karşılaştığı temel zorluklardan biri, LLM’leri yerel geliştirme ortamlarından büyük ölçekli, üretim odaklı Kubernetes dağıtımlarına geçişin operasyonel karmaşıklığıdır. Yerel ortamlar deneyler ve prototipleme için idealken, veri merkezi ölçeğindeki üretim sistemlerinin gerçeklerini yansıtmazlar.

Tarihsel olarak, uygulamaların yerel ortamdan üretime geçişi, sıklıkla bir dizi manuel adım gerektirmiştir: uygulamanın ve destekleyici bileşenlerinin konteynerleştirilmesi, Kubernetes YAML yapılandırma dosyalarının el ile hazırlanması, Kubernetes kaynaklarının yapılandırılması ve konteyner imajlarının Kubernetes uyumlu kayıt defterlerine yayımlanması. Bu süreç sıkça zaman alıcı, hatalara açık ve geliştirici uzmanlığına bağımlı olmuştur; bu da gelişim döngülerini yavaşlatarak yeni LLM

yetkili uygulamaların pazara çıkışını geciktirmiştir.

LLM’lerin boyut ve karmaşıklığı arttıkça, bunların üretim ortamlarında dağıtım gereksinimleri de önemli ölçüde büyümüştür. Modern çıkarım sunucuları, artık aşağıdaki gibi ek bileşenler talep etmektedir:

- LLM’ye özgü istek yönlendirmesi ile çıkarım düğümleri arasında optimal istek dağılımı.

- KV önbellek dışa aktarma ile büyük ölçekli çıkarım bellek taleplerini verimli bir şekilde yönetmek.

- Dinamık GPU tahsisi ile hesaplama kaynaklarının etkili ve maliyet etkin bir şekilde kullanılmasını sağlamak.

Bu bileşenler sıkı bir şekilde entegre olduğu için, bunları Kubernetes’te manuel olarak konteynerleştirmek üretim dağıtımı sırasında ek bir zorluk olarak karşımıza çıkar.

Bu zorlukları aşmak için, v0.2 sürümü, Kubernetes dağıtımını otomatikleştirmek üzere NVIDIA Dynamo Kubernetes Operatörü‘nü tanıtmaktadır. Operatör, üretim dağıtımının karmaşıklıklarını tamamen otomatik hale getirmek için görüntü oluşturma ve grafik yönetim yetenekleri içermektedir. Böylece, AI çıkarım ekipleri, bir masaüstü GPU veya yerel GPU düğümündeki bir Dynamo prototipinden, tek bir CLI komutuyla binlerce GPU içeren ölçeklenebilir bir veri merkezi dağıtımına geçebilir.

Bu otomasyon, manuel Docker dosyası oluşturma ve YAML yapılandırması oluşturma ihtiyacını ortadan kaldırırken, çıkarım iş yüklerini GPU optimize edilmiş Kubernetes kümeleri boyunca dinamik olarak tahsis ve ölçeklendirir. Ayrıca, öncü Kubernetes yerli MLOps bulut araçlarıyla sorunsuz bir şekilde entegre olur ve Kubernetes kümesini tüm büyük bulut hizmeti sağlayıcılarına dağıtmayı kolaylaştırır.

Geliştirme ve yapılandırma süreçlerini ortadan kaldırarak, Dynamo, AI ekiplerinin altyapı kurulumu yerine model yeniliği ve teslimine odaklanmalarını sağlamaktadır. Bu, üretim sürelerini büyük ölçüde azaltır ve modern veri merkezi ölçeğindeki LLM dağıtımı için gereken güvenilirlik, esneklik ve ölçeklenebilirliği sağlar.

NVIDIA Destekli Amazon EC2 İnternode KV Önbellek Transferlerini Optimize Etme

LLM’lerin çıkarım maliyetlerinin önemli bir nedeni KV önbelleğidir. Genellikle son kullanıcılardan gizli yönetilen KV önbelleği, önemli maliyet tasarrufları sağlayabilir. Dağınık sunum ve KV önbelleğini dışa aktarma gibi teknikler, KV önbelleğinin üretilmesi ve depolanmasını optimize etmek için gelişmiştir.

Ancak bu yöntemler, veri iletiminin düşük gecikmeli bir şekilde GPU düğümleri arasında yapılmasına bağlıdır; bu genellikle InfiniBand veya Ethernet gibi ağ protokolleri aracılığıyla gerçekleştirilir ve veri, dosya sistemleri veya nesne depoları gibi harici depolama alanlarına taşınabilir. Çıkarım sunum çerçevelerine çeşitli ağ ve depolama kütüphanelerini entegre etmek zaman alıcıdır ve çoğu zaman etkisiz KV önbellek hareketine yol açarak gecikmeleri artırır ve çıkarım maliyetlerini yükseltir.

Bu zorluklarla başa çıkmak için, Dynamo, açık kaynaklı NVIDIA Çıkarım Transfer Kütüphanesi (NIXL)‘yi içermektedir. NIXL, heterojen ortamlarda veri taşımak için özel olarak tasarlanmış yüksek performanslı ve düşük gecikmeli bir bire bir iletişim kütüphanesidir. Farklı donanım ve protokollerle başa çıkmanın karmaşıklığını soyutlayarak, hızlı ve asenkron transferler için tutarlı bir API sağlar. GDS (GPUDirect Storage), UCX (Unified Communication X), Amazon S3 (Simple Storage Service) ve daha fazlası ile entegrasyonu destekler ve NVIDIA NVLink-C2C, NVIDIA NVLink Switch, InfiniBand, RoCE ve Ethernet gibi bağlantılar üzerinden çalışır.

NIXL ile geliştiricilerin protokol seçimi veya entegrasyon mantığını manuel olarak ele almasına gerek kalmaz. Bunun yerine, NIXL’in ön yüz API’sından basit get, push ve delete komutları kullanabilir ve kütüphane en iyi arka uç seçimlerini otomatik olarak yaparak tüm alt yapı yönetimini üstlenir. Bu, geliştirmeyi büyük ölçüde basitleştirirken performansı artırır.

Dynamo’nun en son sürümü, NIXL’in AWS Elastic Fabric Adapter (EFA) desteğini artırmaktadır. EFA, EC2 örnekleri için bir internode iletişim ağ arayüzüdür. V0.2 Dynamo sürümü ile, AWS bulutunda LLM’leri dağıtan AI hizmet sağlayıcıları, artık NVIDIA destekli EC2 örneklerinde, NVIDIA Hopper ile güçlendirilmiş P5 ailesi ve NVIDIA Blackwell ile güçlendirilmiş P6 ailesi gibi multinode kurulumlarda Dynamo’nun dağıtılmış ve dağınık sunum yeteneklerinden yararlanabilirler.

Bir Sonraki Kullanıcı Buluşmasına Katılın

NVIDIA Dynamo’yu açık kaynak olarak geliştiriyoruz ve yol haritamızı GitHub’da yayımladık. NVIDIA Dynamo ile nasıl çalıştığınızı duymayı ve tartışmayı dört gözle bekliyoruz.

5 Haziran’da San Francisco’da bir araya geleceğimiz ilk yüz yüze kullanıcı buluşması‘na katılın; burada v0.2 sürümü ve Dynamo yol haritası üzerine daha derinlemesine bir tartışma yapacağız. Orada sizi görmekten mutluluk duyarız.