NVIDIA ve OpenAI, yapay zekada sınırları zorlamaya 2016 yılına dayanan NVIDIA DGX’in lansmanı ile başladılar. Bu işbirlikçi yapay zeka inovasyonu, OpenAI gpt-oss-20b ve gpt-oss-120b modellerinin piyasaya sürülmesiyle devam ediyor. NVIDIA, yeni açık ağırlık modellerini NVIDIA Blackwell mimarisi üzerinde hızlandırılmış çıkarım performansı için optimize etti ve NVIDIA GB200 NVL72 sisteminde saniyede 1.5 milyon token (TPS) hızına ulaştı.

gpt-oss modelleri, karar verme yeteneklerine sahip metin odaklı LLM’lerdir. Bu modeller, popüler mixture of experts (MoE) mimarisini ve SwigGLU aktivasyonlarını kullanmaktadır. Dikkat katmanlarında, 128k bağlam ile RoPE kullanılarak, tam bağlam ile 128-token kayar pencere arasında geçiş yapılmaktadır. Modeller, tek bir 80 GB veri merkezi GPU’suna sığacak şekilde FP4 hassasiyetinde yayınlanmıştır ve Blackwell tarafından yerel olarak desteklenmektedir.

Bu modeller, NVIDIA H100 Tensor Core GPU’ları üzerinde eğitildi; gpt-oss-120b’in eğitim süreci 2.1 milyon saatten fazla, gpt-oss-20b ise yaklaşık 10 kat daha kısa sürdü. NVIDIA, Hugging Face Transformers, Ollama ve vLLM gibi birçok üst düzey açık kaynak çerçevesi ile çalıştı; ayrıca, optimize edilmiş çekirdekler ve model geliştirmeleri için NVIDIA TensorRT-LLM ile işbirliği yaptı. Bu blog yazısı, NVIDIA’nın gpt-oss’yi yazılım platformuna nasıl entegre ettiği konusunda geliştiricilerin ihtiyaçlarını karşılamak için bir örnek sunmaktadır.

| Model Adı | Transformer Blokları | Toplam Parametreler | Her Token için Aktif Parametreler | Uzman Sayısı | Her Token için Aktif Uzmanlar | Girdi Bağlam Uzunluğu |

| gpt-oss-20b | 24 | 20B | 3.6B | 32 | 4 | 128K |

| gpt-oss-120b | 36 | 117B | 5.1B | 128 | 4 | 128K |

NVIDIA İşbirliği ve Performans Artışı

NVIDIA ayrıca OpenAI ve topluluk ile birlikte çalışarak performansı maksimize etmek için bazı özellikler ekledi:

- TensorRT-LLM Gen için dikkat ön dolgu, dikkat çözümü ve MoE düşük gecikme süresi desteği.

- CUTLASS MoE çekirdekleri Blackwell üzerinde.

- XQA çekirdeği, özel dikkat için Hopper üzerinde.

- Optimize edilmiş dikkat ve MoE yönlendirme çekirdekleri, LLM’ler için FlashInfer çekirdek hizmeti kütüphanesi aracılığıyla mevcuttur.

- OpenAI Triton çekirdek MoE desteği, hem TensorRT-LLM hem de vLLM‘de kullanılmaktadır.

NVIDIA ile vLLM Kullanarak Dağıtım

vLLM ile işbirliği içinde, NVIDIA, Hopper ve Blackwell mimarileri için doğruluğu güvence altına alma ve performansı analiz etme çalışmaları yaptı. Veri merkezi geliştiricileri, FlashInfer LLM hizmet çekirdek kütphanesi aracılığıyla Nvidia optimize edilmiş çekirdekleri kullanabilir.

vLLM, Python bağımlılık yönetimi için uv kullanmayı önermektedir. vLLM, OpenAI uyumlu bir web sunucusu başlatmak için kullanılabilir. Aşağıdaki komut, modeli otomatik olarak indirip sunucuyu başlatacaktır. Daha fazla ayrıntı için dökümantasyona ve vLLM Cookbook kılavuzuna başvurabilirsiniz.

uv run --with vllm vllm serve openai/gpt-oss-20b

TensorRT-LLM ile Dağıtım

Optimizasyonlar, NVIDIA/TensorRT-LLM GitHub deposunda mevcuttur; burada geliştiriciler, dağıtım kılavuzunu kullanarak yüksek performanslı bir sunucu başlatabilir. Kılavuz, model kontrollerini Hugging Face üzerinden indirir. NVIDIA, geliştirici deneyimi üzerinde çalışarak Transformers kütüphanesi ile yeni modelleri entegrasyona odaklandı. Kılavuz, ayrıca bir Docker konteyneri sağlar ve hem düşük gecikmeli hem de maksimum çıktı için performans yapılandırması hakkında bilgi sunar.

1 Milyondan Fazla Token ile GB200 NVL72

NVIDIA mühendisleri, yeni gpt-oss-120b ve gpt-oss-20b modellerinin, hem NVIDIA Blackwell hem de NVIDIA Hopper platformlarında lansman günü hızlı performans göstermesini sağlamak için OpenAI ile yakın işbirliği yaptı.

Lansman sırasında, ilk performans ölçümlerine göre, tek bir GB200 NVL72 raf ölçeği sistemi, daha büyük ve daha hesaplamalı olarak talepkar olan gpt-oss-120b modelini 1.5 milyon token/saniye hızında sunabilir; bu, yaklaşık 50,000 eşzamanlı kullanıcıya eşdeğerdir. Blackwell’in mimarisi, çıkarım performansını artıran birçok özelliğe sahiptir; bunlar arasında FP4 Tensor Cores ile ikinci nesil Transformer Motoru ve beşinci nesil NVIDIA NVLink yer almaktadır. Bu, 72 Blackwell GPU’nun tek bir devasa GPU gibi hareket etmesini sağlar.

Performans, çok yönlülük ve yenilik hızı, NVIDIA platformunun ekosisteminin en son modelleri hızlı bir şekilde sunmasına olanak tanır ve böylece token başına düşük maliyet sağlanır.

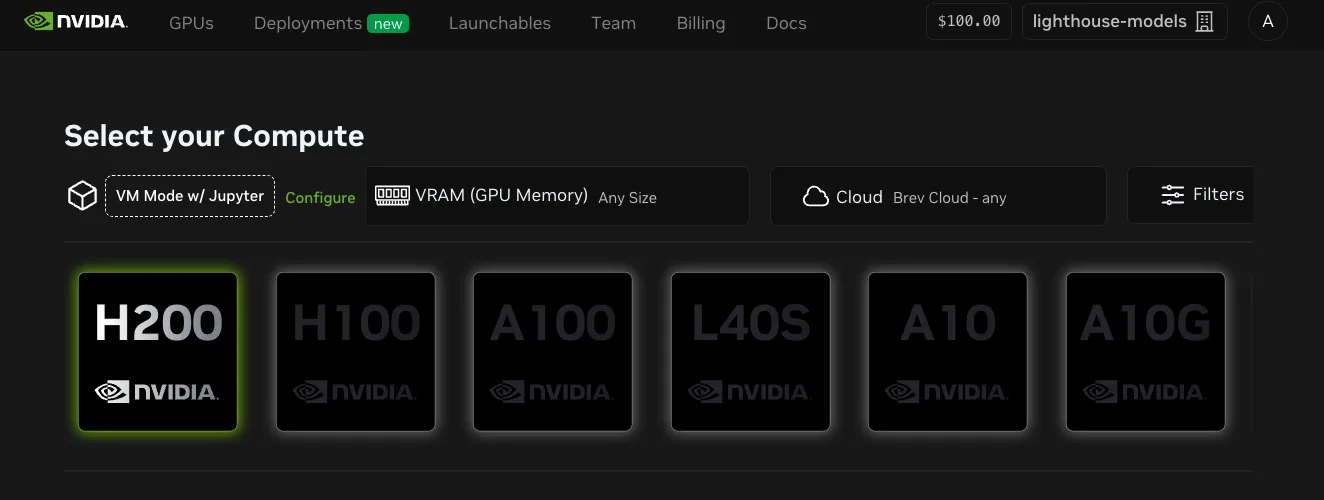

NVIDIA Launchable ile Optimize Edilmiş Modeli Deneyin

TensorRT-LLM kullanarak dağıtım, ayrıca NVIDIA Launchable’da bir JupyterLab not defteri üzerinden Python API’si kullanarak da mevcuttur. Geliştiriciler, birçok bulut platformundan GPU’ları test edebilen yapılandırılmış bir ortamda tek bir tıklama ile optimize edilmiş modeli dağıtabilir.

NVIDIA Dynamo ile Dağıtım

NVIDIA Dynamo, geliştiricilerin OpenAI gpt-oss gibi modelleri büyük ölçekli uygulamalar için dağıtmasına yardımcı olan açık kaynaklı bir çıkarım hizmet platformudur. Anahtar çıkarım arka uçları ile entegrasyon sağlarken, LLM’ye özel yönlendirme, elastik otomatik ölçeklendirme ve dağılmış hizmet gibi özellikleri sunar. Uzun giriş dizisi uzunluğuna sahip uygulamalarda, Dynamo’nun dağılmış hizmeti performansı önemli ölçüde artırır. 32K ISL’de, Dynamo, aynı sistem verimliliğinde ve aynı GPU bütçesi içerisinde etkileşimde 4 kat iyileşme sağlar. Dynamo ile dağıtım yapmak için bu kılavuzu takip edin.

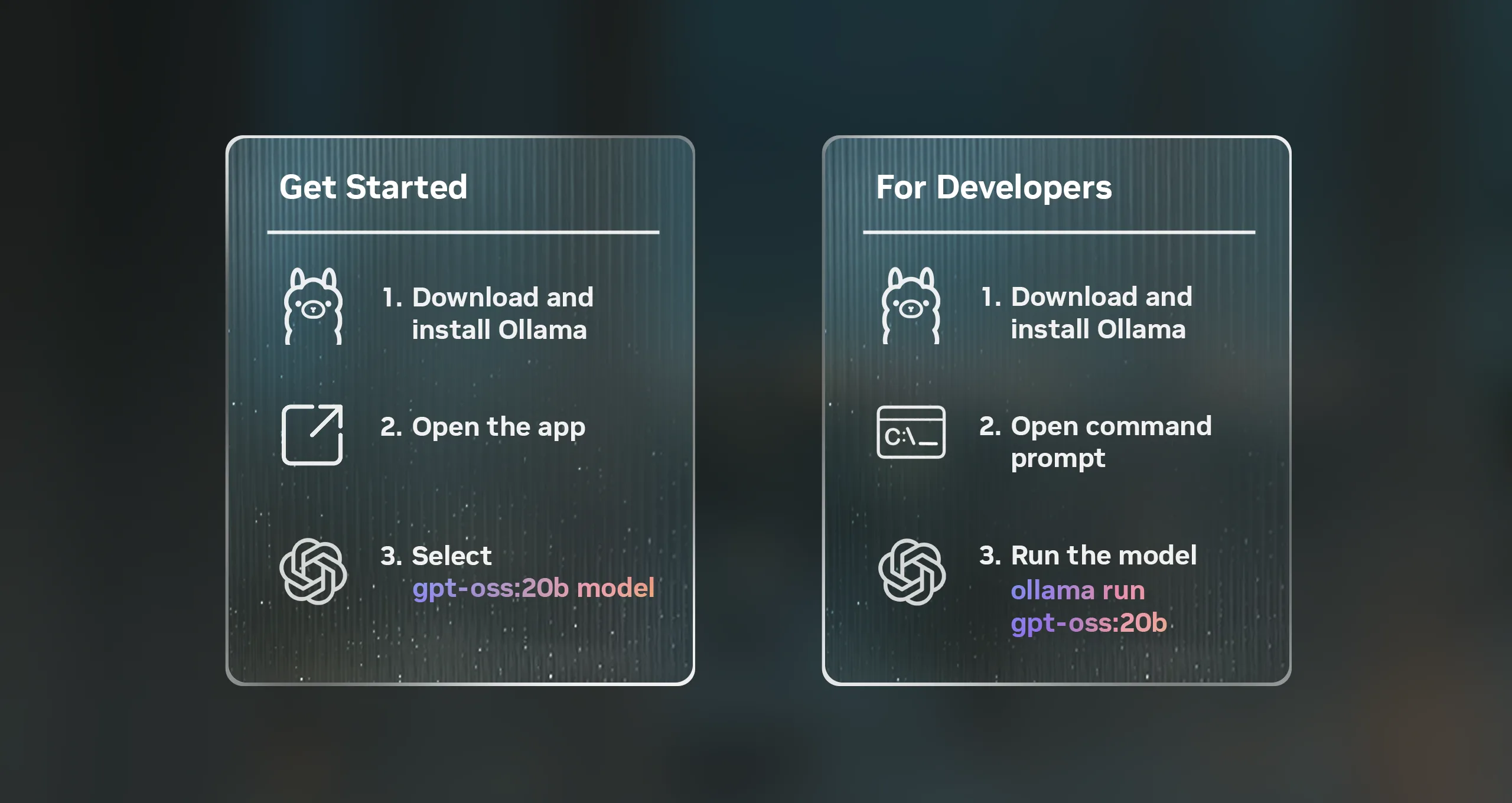

NVIDIA GeForce RTX AI PC’lerde Yerel Olarak Çalıştırma

Geliştiriciler, daha hızlı iterasyon, daha düşük gecikme süresi ve daha fazla veri gizliliği için yapay zekayı yerel olarak çalıştırabilir. Her iki model de NVIDIA RTX PRO GPU’ları ile donatılmış profesyonel iş istasyonlarında çalıştırılabilir; ayrıca gpt-oss-20b, en az 16 GB VRAM’e sahip herhangi bir GeForce RTX AI PC’de yerel olarak dağıtılabilir. Geliştiriciler, bu modelleri Ollama, Llama.cpp veya Microsoft AI Foundry Local gibi uygulamalar ve SDK’lar aracılığıyla deneyimleyebilir. Başlamak için RTX AI Garage‘a göz atabilirsiniz.

Kurumsal Üzerinde Kolaylık Sağlayan NVIDIA NIM

Kurumsal geliştiriciler, NVIDIA NIM Preview API ve web playground ortamını kullanarak gpt-oss modellerini ücretsiz deneyebilir. Modeller, NVIDIA NIM mikro hizmetleri olarak paketlenerek, her GPU hızlandırmalı altyapıda esneklik, veri gizliliği ve kurumsal düzeyde güvenlik ile dağıtımını kolaylaştırmaktadır.

gpt-oss modelleri, NVIDIA geliştirici ekosisteminin her katmanında entegre edilmesiyle geliştiricilerin en iyi işe yarayan çözümleri kullanmasını sağlar. Başlamak için NVIDIA API Katalog UI veya OpenAI Cookbook üzerinden NVIDIA geliştirici kılavuzunu kullanabilirsiniz.