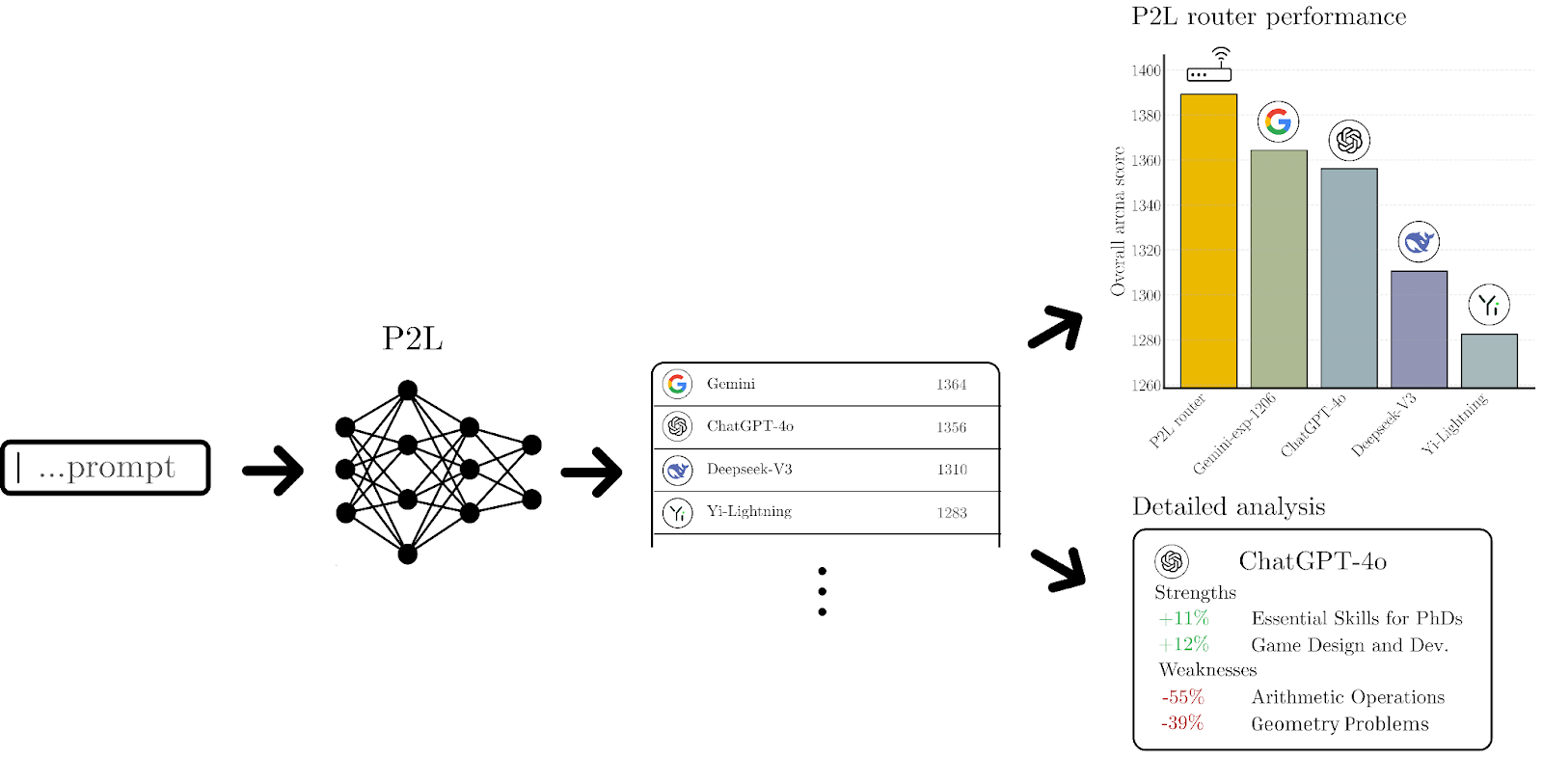

Kaliforniya Üniversitesi, Berkeley’deki LMArena, büyük dil modellerinin belirli görevlerde nasıl performans sergilediğini kolayca görmeyi sağlıyor. Bu sıralamalar, NVIDIA ve Nebius‘un desteğiyle güçlenen Prompt-to-Leaderboard (P2L) modeli aracılığıyla oluşturuluyor. İnsanların, matematik, kodlama veya yaratıcı yazma gibi alanlarda hangi yapay zekanın en iyi performansı gösterdiğine dair oyları toplanıyor.

“Kullanıcı tercihlerimizi görevler arasında topluyor ve Bradley-Terry katsayıları uygulayarak hangi modelin hangi alanda en iyi performansı sergilediğini belirliyoruz” diyor LMArena’nın kurucu ortağı ve Berkeley’de doktora öğrencisi olan Wei-Lin Chiang. LMArena (eski adıyla LMSys), P2L’yi geliştirmek için son iki yıldır çalışıyor.

LMArena, P2L’yi ölçeklenebilir bir şekilde uygulamak için NVIDIA DGX Cloud ve Nebius AI Cloud ile iş birliği yapıyor. Bu iş birliği ve LMArena’nın NVIDIA GB200 NVL72‘yi kullanması, bulutta üretim hazır AI iş yüklerinin geliştirilmesine olanak tanıdı. NVIDIA AI uzmanları, projenin her aşamasında destek sundu ve bu, P2L ile DGX Cloud platformunun iyileştirilmesine yardımcı olan hızlı geri bildirim ve birlikte öğrenme döngüsünü sağladı.

P2L’nin merkezinde, gerçek zamanlı bir geri bildirim döngüsü yer alıyor: Ziyaretçiler, yapay zeka destekli yanıtları karşılaştırıp en iyi olanı seçiyor ve böylece ayrıntılı, istek bazlı liderlik panoları oluşturuluyor. Özetle, LMArena insan sıralamalarını kullanarak P2L’yi eğitiyor, böylece en optimal sonucu kalite açısından belirleyebiliyor.

“Tek bir genel sıralamanın ötesinde bir şey istedik” diyen Evan Frick, LMArena’nın kıdemli araştırmacısı ve Berkeley doktora öğrencisi, “Bir model matematikte mükemmel olabilir ama yazımda ortalama bir performans sergileyebilir. Tek bir puan, çoğu zaman bu ince ayrıntıları gizliyor” şeklinde ekliyor.

Kişiselleştirilmiş liderlik panolarının yanı sıra, P2L maliyet bazlı yönlendirmeyi de mümkün kılıyor. Kullanıcılar bir bütçe belirleyebilir (örneğin, saatte 5 $) ve sistem, bu limit içinde en iyi performansı gösteren modeli otomatik olarak seçecektir.

P2L’yi Üretime Taşımak: LMArena, Nebius ve NVIDIA

Şubat ayında, LMArena P2L’yi Nebius aracılığıyla NVIDIA DGX Cloud‘da barındırılan NVIDIA GB200 NVL72’de devreye aldı. NVIDIA ve Nebius, erken benimseyenlerin, NVIDIA’nın Blackwell platformunu çoklu düğüm yapılandırmaları yönetirken test etmelerini kolaylaştıran ortak bir kum havuzu ortamı geliştirdi.

P2L, alan bazında doğruluğa ve maliyete göre sorguları dinamik olarak yönlendirebilir, bu da NVIDIA GB200 NVL72’nin performans sınırlarını zorlamak için idealdir.

“P2L’yi öyle bir şekilde inşa ettik ki geliştiriciler hangi modelin en iyi olduğunu tahmin etmek zorunda kalmasın” diyor Chiang. “Veriler, hangisinin matematik, kodlama veya yazma konusunda daha iyi olduğunu gösteriyor. Sonra bu bilgilere göre sorguları yönlendiriyoruz—bazen maliyeti, bazen de performansı dikkate alarak.”

NVIDIA GB200 NVL72: Esnek, Ölçeklenebilir ve Geliştirici Hazır

NVIDIA GB200 NVL72, 36 Grace CPU’s ve 72 Blackwell GPU’s ile entegre edilmiştir ve bu bileşenler, yüksek bant genişliği ve düşük gecikmeli performans için NVIDIA NVLink ve NVLink Switch ile bağlanmaktadır. 30 TB’a kadar hızlı, birleşik LPDDR5X ve HBM3E bellek, talepkar yapay zeka görevleri için etkili kaynak tahsisini sağlar.

LMArena, tek bir düğümde ilk eğitimi yaparak ve sonrasında çoklu düğümlere ölçeklenerek platformu test etti ve etkileyici bir tek düğüm verimliliği ve etkili yatay ölçeklenebilirlik sergiledi.

“Çoklu düğüm genişletmeleri hakkında konuşuyoruz ama tek bir düğüm bile bizi oldukça meşgul ediyor” diyor Chiang. “En büyük zorluk, gerçek zamanlı performansı sağlarken sistemin sürekli veri geri bildirimine adapte olmasını sağlamak. Ama bu aynı zamanda en eğlenceli kısım.”

Açık Kaynak Etkinliği ve Ekosistem Hazırlığı

DGX Cloud ekibi, Nebius ve LMArena ile iş birliği yaparak GB200 NVL72 için açık kaynak geliştiricileri için hızlı ve sorunsuz bir dağıtım sağladı. Ekip, PyTorch, DeepSpeed, Hugging Face Transformers, Accelerate, Triton (upstream), vLLM, xFormers, torchvision ve llama.cpp gibi önemli yapay zeka çerçevelerinin yanı sıra Arm64, CUDA 12.8+ ve Blackwell ortamı için WAN2.1 video difüzyonu gibi yeni model çerçevelerini de doğruladı ve derledi.

Bu kapsamlı etkinlik, geliştiricilerin son teknoloji açık kaynak araçlardan yararlanmalarını sağladı. Böylece düşük seviyeli uyumluluk veya performans sorunları ile uğraşmadılar. Mühendislik çabası, derleme ve optimizasyon, konteynerleştirme, orkestra en iyi uygulamaları ve çerçevelerin ölçekli çalıştırması için uçtan uca doğrulama gibi konuları kapsadı.

Proje, NVIDIA, Nebius ve LMArena arasında “derin koordinasyon” gerektirdi, bu sayede geliştiriciler, açık kaynak kütüphanelerini ve bileşenlerini taşımak yerine ürünlerini inşa etmeye odaklanabildiler. Paul Abruzzo, NVIDIA DGX Cloud ekibinin kıdemli bir mühendisi, “GB200 NVL72’ye erken erişim programı aracılığıyla erişim sağlanmasına rağmen LMArena hala güçlü bir performans sergiledi. Mevcut modelini sadece dört günde eğitti” diyor.

“GB200’ün yeni Arm mimarisine yönelik bağımlılıkları oluşturup taşıdıktan sonra, DGX Cloud ekibi bu angajman için gerekli açık kaynak çerçevelerini sağlayabildi ve hızlı dağıtım ve ölçek deneyleri mümkün hale geldi” diye ekliyor Abruzzo.

Bu iş birliği, GB200 NVL72’nin yeni mimarisi üzerinde yapay zeka iş yüklerini etkinleştirmek için yalnızca teknik bir kilometre taşı sağlamakla kalmadı, aynı zamanda büyük ölçekli yapay zeka için tekrar edilebilir bir dağıtım modeli sundu. Doğrulanmış çerçeveler, yönlendirme kılavuzları ve dağıtım planları artık gelecek müşterilerin GB200 NVL72’yi benimsemelerini kolaylaştırıyor; ister tam ölçekte ister daha hedefe yönelik alt kapasite yapılandırmalarıyla.

“Nebius ve NVIDIA ile çalışmak, P2L’yi hızlı bir şekilde ölçeklendirme yeteneğimizi temelden dönüştürdü” diyor Chiang. “GB200 NVL72’nin performansı, deney yapma, hızlı bir şekilde yineleme yapma ve canlı kullanıcı girişine uyum sağlayan gerçek zamanlı bir yönlendirme modeli sunma esnekliği verdi. Sonuç olarak, doğruluk ve verimlilikte gelişmeler görüyoruz.”

Anahtar Bilgiler

Bu dağıtım, NVIDIA GB200 NVL72 platformunda yapay zeka iş yüklerinin nasıl hızlı ve esnek bir şekilde ölçeklenebileceğini gösteriyor ve hız, uyum sağlama yeteneği ve Arm64 ekosistem hazırlığı için yeni standartlar belirliyor.

- Hızlı değer elde etme: Üretim ölçeğindeki bir modeli NVIDIA GB200 NVL72’de dört günde eğitme.

- Esnek dağıtım: Hem tam yapı hem de alt kapasiteli kullanım durumlarını doğruladı.

- Ölçeklenebilirlik kanıt noktası: Tek düğümden çoklu düğüm dağıtımına geçiş, NVIDIA GB200 NVL72’de yapay zeka iş yüklerinin ölçeklenebilirliğini gösterdi.

- Açık kaynak uyumlu: Partner altyapısında Arm64 + CUDA için büyük çerçevelerin derlenip optimize edildiği ilk kez.

NVIDIA GB200 NVL72’yi Nebius ile NVIDIA DGX Cloud’da Deneyimleyin

Aİ yenilik yolculuğunuzu hızlandırmak, dağıtım karmaşıklığını azaltmak ve en son teknolojileri kullanmak için NVIDIA DGX Cloud ve Nebius AI Cloud, LMArena’da görülen başarılı sonuçları çoğaltmaya hazır. NVIDIA ile iletişime geçin ve bugünden itibaren iş yüklerinizi GB200 NVL72’de nasıl dağıtacağınızı öğrenin.

Ayrıca LMArena’nın Prompt-to-Leaderboard (P2L) sistemi hakkında daha fazla bilgi edinebilirsiniz; bu sistem NVIDIA DGX Cloud ve Nebius AI Cloud üzerinde geliştirilmiştir.