Büyük dil modelleri (LLM), kodlama, mantık yürütme ve matematik gibi doğal dil işleme (NLP) görevlerinde yüksek bir standart belirledi. Ancak, bu modellerin kullanımı kaynak açısından yoğun olduğundan, güçlü performans sunan ancak maliyet açısından daha uygun olan küçük dil modellerine (SLM) olan ilgi artmaktadır.

NVIDIA’nın araştırmacıları ve mühendisleri, büyük modelleri daha küçük ve verimli varyantlara sıkıştırmada önemli bir strateji olan yapılandırılmış ağırlık budama ile bilgi damı yöntemini birleştiren bir yöntem geliştirdiler. Daha fazla bilgi için Budama ve Bilgi Damıtma ile Kompakt Dil Modelleri başlıklı çalışmaya göz atabilirsiniz.

Bu yazı, model budama ve bilgi damıtma nedir, bunların nasıl çalıştığı ve kendi modellerinize nasıl kolayca uygulayarak NVIDIA TensorRT Model Optimizatörü ile en iyi performansa ulaşabileceğiniz konusunda bilgi vermektedir.

Model Budama Nedir?

Budama, karmaşık özellikleri öğrenmek için yeterli kapasite ile eğitim alan sinir ağlarının yaygın aşırı parametrelenmesinden faydalanan bir model optimizasyon tekniğidir. Budama, eğitimli bir modelden önemsiz parametreleri, yani ağırlıkları, nöronları veya katmanları sistematik bir şekilde belirleyip kaldırma işlemidir.

Bu işlem, genelde bir modelin ağırlıklarının büyük bir kısmını, doğruluğuna minimal etki edecek şekilde ortadan kaldırarak daha kompakt bir model elde edilmesini sağlar. Bu da daha hızlı çıkarım hızları ve daha düşük hesaplama maliyeti demektir. Budama, bir ağaç uzmanının bir ağacı keserek sağlığını ve büyümesini iyileştirmesine benzetilebilir; model budama da bir modeli daha küçük ve verimli hale getirir.

İki ana budama yaklaşımı vardır: derinlik budama ve genişlik budama.

Derinlik budama, sinir ağından tüm katmanları kaldırarak, modelin genel derinliğini ve karmaşıklığını azaltır (Şekil 1).

Genişlik budama ise iç yapıları, örneğin bireysel nöronları, dikkat başlıklarını veya gömme kanallarını kaldırarak modelin genişliğini inceltir (Şekil 2).

Temel fikir, LLM’nin genel performansına en az katkıda bulunan parçaların tanımlanması ve kaldırılmasıdır. Önem derecesini değerlendirmek için farklı yöntemler kullanılabilir, örneğin:

- Magnitude budama: Küçük mutlak değerlere sahip ağırlıkları sıfıra yaklaştırır.

- Aktivasyona dayalı budama: Bir kalibrasyon veri seti kullanarak, modelin farklı bölümlerinin önemini aktivasyonlarına göre tahmin eder.

- Yapısal budama: Tüm yapıları, yani katmanları veya dikkat başlıklarını kaldırır.

Araştırmalar, genişlik budamanın genellikle daha iyi doğruluk sağladığını, ancak derinlik budamanın da aynı parametre sayısında daha fazla çıkarım gecikmesi azalttığını göstermektedir. Derinlik budaması, genişlik budaması veya her ikisinin bir kombinasyonu arasındaki seçim, doğruluk ve gecikme arasındaki istenen dengeye bağlı olmalıdır. Daha fazla bilgi için Uygulamada LLM Budama ve Damıtma: Minitron Yaklaşımı çalışmasına göz atabilirsiniz.

Bilgi Damıtma Nedir?

Bilgi damıtma, daha büyük bir “öğretmen” modelinden, daha küçük ve daha verimli bir “öğrenci” modeline bilgi aktarımını sağlayan bir model sıkıştırma tekniğidir (Şekil 3). Amacı, daha az kaynakla dağıtım yapabilen, büyük modelin yüksek performansını koruyan kompakt bir model oluşturmaktır.

Bilgi damıtma, öğrenci modelini, öğretmenin yalnızca zor etiketlerine bağlı kalmadan, öğretmen modelinin *yumuşak* çıktı olasılıklarını eşleştirerek eğitme sürecidir. Bu süreç, zengin, genelleştirilebilir davranışları aktararak öğrencinin öğretmene yakın bir doğruluğa ulaşmasını sağlar.

İki yaygın damıtma tarzı, yanıt temelli ve özellik temelli damıtmadır ve her biri, öğretmenden öğrenciye bilgi aktarımında farklılık gösterir.

Yanıt Tabanlı Bilgi Damıtma Nedir?

Yanıt tabanlı bilgi damıtma, öğrenci modelin öğretmenin *yumuşak* çıktı olasılıklarını eşleştirmesi için eğitilmesini sağlar, böylece yalnızca *sert* etiketler yerine kullanılır. Bu yumuşak hedefler, örneğin “kedi”nin “kaplandan” daha yakın olduğunu belirten sınıflar arası benzerlikleri iletir ve öğrenci, bu hedeflerle uyum sağlamak için KL dağılımı kullanılır.

Uygulaması basit olan bu yaklaşım, öğretmenin iç özelliklerine erişim gerektirmeden yüksek derecede etkilidir. Uygulamada, damıtma kaybı genellikle, gerçek etiketler üzerinde standart çapraz entropi ile bir araya getirilir ve kayıp ağırlıkları, stabilite ve sadakat dengesini sağlamak için ayarlanır; böylece, öğretmenin doğruluğunun büyük kısmını koruyan kompakt modeller elde edilir.

Özellik Tabanlı Bilgi Damıtma Nedir?

Özellik tabanlı bilgi damıtma, öğretmenin ara temsilcilerinin gizli aktivasyonlarının veya özellik haritalarının öğrenciye aktarılmasını sağlar. Bu süreç, öğrencinin, öğretmenin iç yapısını yalnızca benzer çıktılarla değil, benzer iç yapılarla öğrenmesi için yönlendirilmesine yardımcı olur. Eğitim sırasında, seçilen öğretmen ve öğrenci katmanları eşleştirilir ve arabirim katmanları, boyutlar farklı olduğunda kullanılır.

Bu derin, katman düzeyinde gözetim, yanıt tabanlı damıtma ile kıyaslandığında daha zengin sinyaller sağlamakta ve görsel veriler (örn. CNN özellik haritaları) ile NLP’de (örn. Dönüştürücü gizli durumları ve dikkat) etkili olmuştur. Öğretmenin ara katmanlarına erişim gerektirdiğinden ve katmanların dikkatli bir şekilde seçilip ağırlıklandırılması gerektiğinden, bu teknik stabilite ve doğruluğu sağlamak için standart görev kaybıyla bir arada kullanılmalıdır.

Budama ve damıtma, model sıkıştırma için güçlü bir süreç oluşturarak, SLM’lerin üretim ortamlarında ve kenar uygulamalarında dağıtım için uygun hale gelmesini sağlar. TensorRT Model Optimizatörü, bu tekniklerin ölçeklenerek uygulanmasını sağlamakta ve son teknoloji LLM’leri dağıtım için uygun, maliyet etkili çözümlere dönüştürmektedir.

TensorRT Model Optimizatörü ile Model Budama Nasıl Yapılır?

Bu bölüm, TensorRT Model Optimizatörü kullanarak bir boru hattı oluşturma sürecini anlatmaktadır. Veri setinin hazırlanması, WikiText veri setinde bir öğretmen modelinin ince ayarının yapılması ve budama ile damıtma tekniklerinin uygulanarak 6B parametreli Qwen3-8B modelinin üretilmesi adımlarını içermektedir. Daha fazlası için Qwen3-8B Budama ve Damıtma ile NeMo 2.0 Çerçevesi not defterine göz atabilirsiniz.

Budama ve damıtma işlemlerinden önce, Hugging Face modellerinin NVIDIA NeMo kontrol noktası formatına dönüştürülmesi ve veri setinin ön işlenmesi gerekmektedir. Ayrıntılı talimatlar için modelin dönüşümü ve veri hazırlama adımına bakabilirsiniz.

Burada, hem derinlik budama hem de genişlik budama yöntemlerini kullanarak nasıl budama yapılacağını göstereceğiz. Sağlanan komut dosyaları, NVIDIA NeMo çerçeve konteyneri nvcr.io/nvidia/nemo:25.09 içinde çalıştırılabilir.

Modeli Derinlik Budama Yöntemiyle Oluşturma

İlk yaklaşım, Qwen3 8B modelini 36 katmandan 24 katmana (yaklaşık 6B parametre) kısaltmak için, 1,024 örnekten oluşan küçük bir kalibrasyon veri seti kullanarak en iyi 24 katmanı otomatik olarak seçmektir.

Bu sürecin komut dosyası aşağıda gösterilmektedir; iki GPU’lu bir boru hattı paralel yapısı kullanarak budama işlemi gerçekleştirebiliriz.

torchrun --nproc_per_node 2 /opt/NeMo/scripts/llm/gpt_prune.py

--devices 2

--pp_size 2

--restore_path Qwen3-8B-nemo

--legacy_ckpt

--save_path Qwen3-8B-nemo-depth-pruned

--seq_length 4096

--num_train_samples 1024

--mbs 4

--data_paths wikitext-data/wikitext-train_text_document

--target_num_layers 24

Modeli Genişlik Budama Yöntemiyle Oluşturma

Model boyutunu azaltmanın ikinci alternatifi, genişlik budamasıdır. Bu, önemli mimari bileşenlerin küçültülmesiyle gerçekleştirilir: MLP ara katman boyutu (ffn_hidden_size) 12,288’den 9,216’ya, Gömme (hidden_size) ise 4,096’dan 3,584’e düşürülerek 6B model elde edilmiştir.

Ayrıca, gerekli olduğunda dikkat başlıklarının sayısını (num_attention_heads) ve GQA sorgu gruplarının sayısını (num_query_groups) azaltılabilir. Model boyutunu elde etmek için katman sayısını (num_layers) ayarlamak da mümkündür.

Bu sürecin komut dosyası, iki GPU’lu bir boru hattı paralel yapısı kullanarak budama işlemini gerçekleştirmek için aşağıda verilmiştir.

torchrun --nproc_per_node 2 /opt/NeMo/scripts/llm/gpt_prune.py

--devices 2

--pp_size 2

--restore_path Qwen3-8B-nemo

--legacy_ckpt

--save_path Qwen3-8B-nemo-width-pruned

--seq_length 4096

--num_train_samples 1024

--mbs 4

--data_paths wikitext-data/wikitext-train_text_document

--target_ffn_hidden_size 9216

--target_hidden_size 3584

Önemsiz veya düşük öneme sahip ağırlıkları budayarak, budama işlemi modelin bellek ayak izini küçültmekle kalmaz, ayrıca çıkarım hızını artırabilir. Ancak, bu işlem genelde, budama aşamasında kaybedilen doğruluğu geri kazanmak ve budanmış modelin hedef görevlerde yüksek performansı sürdürmesini sağlamak için ince ayar veya yeniden eğitim ile takip edilir. İşte bu noktada damıtma devreye girer.

TensorRT Model Optimizatörü ile Bilgi Damıtma Nasıl Yapılır?

Bu örnek, Qwen3 derinlik ve genişlik budanmış modellerin Model Optimizatörü ve NeMo 2.0 Çerçevesi ile bilgi damıtma sürecini anlatmaktadır.

Öğretmen modelden derinlik budanmış bir modele bilgi damıtma sürecinde, öğrenci modelin yolu Qwen3-8B-nemo-depth-pruned olacaktır. Bu yol, derinlik budama adımının çıktısını temsil etmektedir ve daha fazla ayrıntı için NeMo damıtma not defterine göz atabilirsiniz.

Bu süreç için aşağıdaki script verilmiştir. Tek düğümde sekiz GPU’lu bir Tensor Paralel yapısı kullanarak damıtma işlemi gerçekleştirecek şekilde tasarlanmıştır. Pratikte, daha hızlı eğitim için çok düğümlü eğitim önerilmektedir.

torchrun --nproc_per_node 8 /opt/NeMo/scripts/llm/gpt_train.py

--name Qwen3-8B-nemo-depth-pruned-distill

--devices 8

--num_nodes 1

--tp_size 8

--model_path Qwen3-8B-nemo-depth-pruned

--teacher_path Qwen3-8B-nemo

--legacy_ckpt

--max_steps 40

--warmup_steps 1

--gbs 768

--mbs 8

--lr 1e-4

--min_lr 1e-5

--seq_length 4096

--log_dir .

--log_interval 5

--val_check_interval 5

--limit_val_batches 2

--data_paths wikitext-data/wikitext-train_text_document

Öğretmen modelden genişlik budanmış bir modele bilgi damıtma süreci yaparken, student_model_path modeli Qwen3-8B-nemo-width-pruned olacaktır. Bu model, genişlik budama adımında sağlanan modeldir ve detaylar için NeMo budama not defterine göz atabilirsiniz.

Bu süreç için aşağıdaki script verilmiştir. Tek düğümde sekiz GPU’lu bir Tensor Paralel yapısı kullanarak damıtma işlemi gerçekleştirecek şekilde tasarlanmıştır. Pratikte, daha hızlı eğitim için çok düğümlü eğitim önerilmektedir.

torchrun --nproc_per_node 8 /opt/NeMo/scripts/llm/gpt_train.py

--name Qwen3-8B-nemo-width-pruned-distill

--devices 8

--num_nodes 1

--tp_size 8

--model_path Qwen3-8B-nemo-width-pruned

--teacher_path Qwen3-8B-nemo

--legacy_ckpt

--max_steps 40

--warmup_steps 1

--gbs 768

--mbs 8

--lr 1e-4

--min_lr 1e-5

--seq_length 4096

--log_dir .

--log_interval 5

--val_check_interval 5

--limit_val_batches 2

--data_paths wikitext-data/wikitext-train_text_document

Geniş kapsamlı bilgi için NeMo Çerçevesi damıtma belgelendirmesine göz atabilirsiniz. Bu kaynaklar, damıtmayı çalışma akışınıza entegre etmenizi oldukça kolay hale getirecektir.

Budama ve Damıtmanın Model Performansına Etkisi

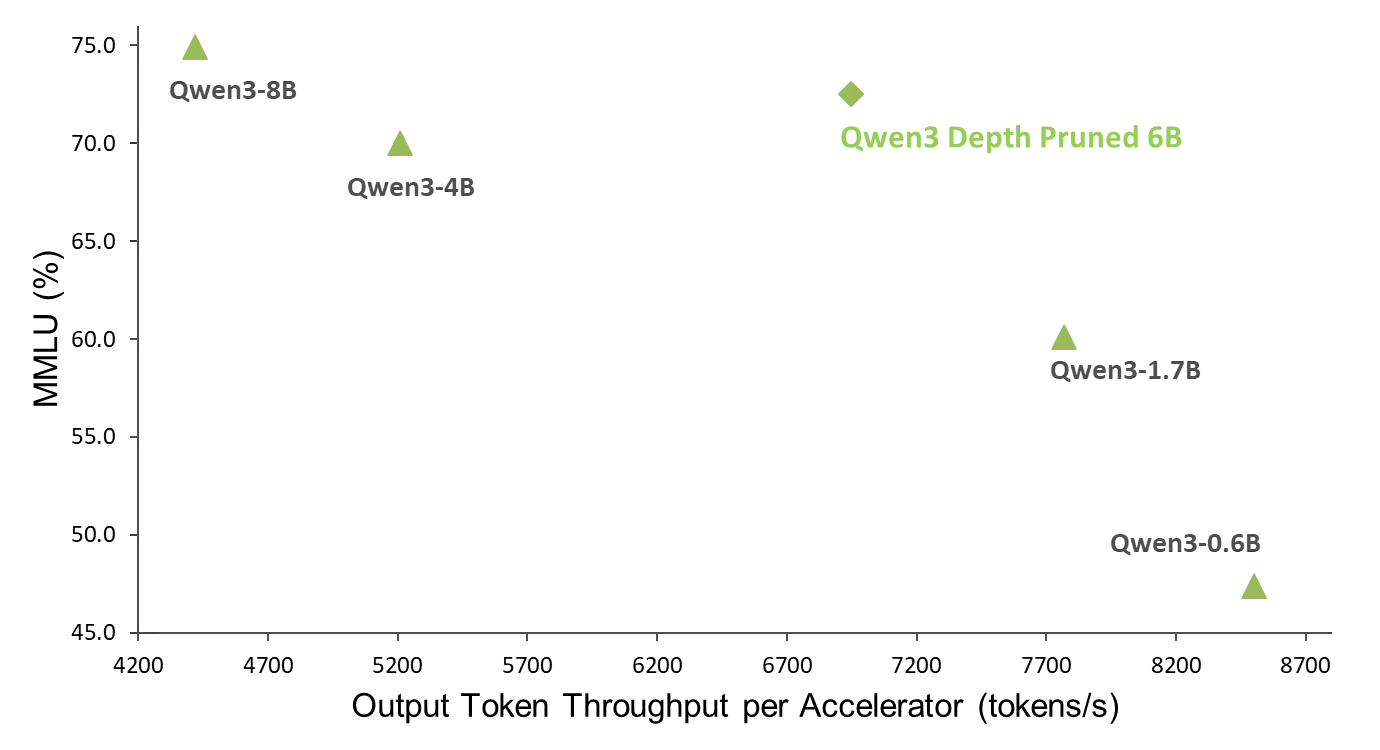

Model Optimizatörü ile yapılan budama ve damıtma deneysel sonuçları, Qwen3 Derinlik Budalı 6B modelinin Qwen3 4B modeline göre %30 daha hızlı olduğunu göstermektedir ve MMLU (Küresel Çoklu Görev Dil Anlama) benchmarkında da daha iyi performans sergilemektedir. Derinlik budaması, modeli 36’dan 24 katmana indirgemek için uygulanmıştır ve bu işlem, NVIDIA H100 80 GB HBM3 kullanılarak gerçekleştirilmiştir.

Budama modeli, OptimalScale/ClimbMix veri setinden elde edilen veriler ile damıtılmıştır. Bu deneyde, verilerin %25’i, yani yaklaşık 90B token kullanılmıştır. Damıtma süreci, her biri sekiz NVIDIA H100 GPU içeren 96 düğümle 8 saat sürmüştür (6K GPU saati).

6B budanmış model, 4B modeline kıyasla önemli bir performans artışı göstermektedir. Özellikle, 6B budanmış model, %30 oranında bir hız artışı elde ederek çeşitli hesaplama görevleri için önemli ölçüde daha verimli bir çözüm olmuştur. Tüm modeller, Model Optimizatörü kullanılarak FP8 hassasiyetine göre kuantize edilmiştir ve TensorRT-LLM ile çalıştırılmıştır.

%30 hız avantajının yanı sıra, 6B budanmış model, MMLU benchmarkında daha yüksek bir puanı ile üstün bir doğruluk da sergilemektedir. 72.5 puan ile 4B modelinin 70.0 puanını geçerek, dil ile ilgili birçok görevde daha iyi bir anlama ve yetenek gösterir. Bu hız ve doğrulukta çift yönlü iyileşme, 6B budanmış modelin hızlı işlem ve yüksek kaliteli sonuçlar gerektiren uygulamalar için daha sağlam ve etkili bir çözüm olmasına olanak tanımaktadır.

Budanan modeller, bir ön eğitim veri seti üzerinde damıtıldığı için, model temel bir varyant olarak kalmaktadır. Temel bir model olarak ele alındığı için, tüm modeller sadece temel benchmarklar üzerinde (örneğin MMLU) karşılaştırılmıştır. Bu modellerin akıl yürütme görevlerinde pratikte kullanımı, modellerin son eğitimden geçirilmesini gerektirecektir.

Budama ve Bilgi Damıtma ile Başlama

Budama ve bilgi damıtma, LLM’leri adım adım küçültmek için oldukça maliyet etkin yöntemlerdir ve genellikle sentetik veri ile ince ayar yapma veya tam ön eğitimden daha fazla veri verimliliği sunar.

Başlamaya hazır mısınız? Qwen3 8B Budama ve Damıtma ile NeMo 2.0 Çerçevesi not defterini inceleyin. Daha fazla bilgi için NVIDIA/TensorRT-Model-Optimizer GitHub repo’suna göz atabilir ve budama ve damıtma ile ilgili daha fazla bilgi alabilirsiniz. Model optimizasyon teknikleri ile ilgili TensorRT Model Optimizatörü kullanarak, son eğitim kuantizasyonu, kuantizasyon bilinci eğitim ve spekülatif kodlama gibi ilgili yazılara da göz atabilirsiniz.