Alibaba, Tongyi Qwen3’ü piyasaya sürdü; bu, açık kaynaklı hibrit akıl yürütme büyük dil modelleri (LLM’ler) ailesini içeriyor. Qwen3 ailesi, toplamda 235 milyar parametreye ve 22 milyar aktif parametreye sahip olan 235B-A22B (235B total parameters and 22B active parameters) ve 30B-A3B olmak üzere iki MoE (Mixture of Experts) modeli ile 0.6B, 1.7B, 4B, 8B, 14B, ve 32B dahil altı yoğun modelden oluşuyor.

Ultra hızlı token üretimi ile geliştiriciler, Qwen3 modellerini NVIDIA GPU’lar üzerinde farklı çerçeveler (frameworks) kullanarak üretim uygulamalarına entegre ve dağıtımını kolayca yapabiliyor. Bu çerçeveler arasında NVIDIA TensorRT-LLM, Ollama, SGLang ve vLLM yer alıyor.

Qwen3 Modellerinin Avantajları

Qwen3, Çin’deki ilk hibrit akıl yürütme LLM’si olarak dikkat çekiyor ve AIME, LiveCodeBench, ArenaHard ve BFCL gibi popüler kriterlerde son derece yüksek doğruluk sağlıyor. Qwen3, mantık yürütme, talimat takibi, ajan yetenekleri ve çok dilli destek gibi alanlarda yapılan gelişmelerle oluşturulmuş kapsamlı bir model ailesi sunuyor. Bu modeller, dünyanın önde gelen açık kaynaklı modelleri arasında yer alıyor.

Gerçek Zamanlı Üretim Dağıtımında LLM Tabanlı Performans

LLM ekosisteminin dinamik ve evrilen doğası, yeni modellerin ve teknolojilerin sürekli tanıtılması ile yüksek performanslı ve esnek çözümler gerektiriyor. Üretim dağıtımları için LLM’leri optimize etme ihtiyacı giderek artıyor.

Etkin bir çalışma ortamı tasarlamak zor çünkü sürekli artan taleplerle başa çıkmak zorundasınız. Bu zorluklar, LLM’lerin önceden doldurma ve kodlama aşamalarındaki farklı hesaplama ve bellek gereksinimlerini, çok büyük modellerde paralel dağıtımları, devasa eş zamanlı talepleri ve oldukça dinamik girdi/çıktı uzunluğu taleplerini içeriyor.

Yüksek performanslı çekirdekler, düşük hassasiyetli kuantizasyon, parti zamanlama, örnekleme optimizasyonu ve KV önbellek optimizasyonu gibi birçok optimizasyon tekniği, bu tür zorluklarla başa çıkmak için kullanılıyor. Geliştiriciler, senaryolarına en uygun teknolojiler kombinasyonunu keşfetmek için denemeler yapmalılar.

TensorRT-LLM, NVIDIA GPU’larda yüksek performanslı hesap çekirdekleri, çok düğümlü ve çok GPU’lu iletişim desteği, çeşitli paralellik ve kuantizasyon stratejileri sunarak verimliliği sağlıyor. Bunun yanı sıra, TensorRT-LLM yeni mimarisi, PyTorch ile inşa edildi ve esnek, geliştirici dostu bir çalışma akışı sunuyor. LLM API’si ile hızlı bir şekilde çıkarım yapmak için gerekli ayarları yapabilirsiniz.

Qwen3’ü TensorRT-LLM ile Optimize Ederek Çalıştırma

Benchmark için Qwen3-4B modelimizi kullanarak bir PyTorch arka uç kuracağız ve testlerimizi gerçekleştireceğiz.

- Öncelikle,

extra-llm-api-config.ymlyapılandırma dosyası ve benchmark test veri kümesini hazırlayın.

python3 /path/to/TensorRT-LLM/benchmarks/cpp/prepare_dataset.py

--tokenizer=/path/to/Qwen3-4B

--stdout token-norm-dist --num-requests=32768

--input-mean=1024 --output-mean=1024 --input-stdev=0 --output-stdev=0 > /path/to/dataset.txt

cat >/path/to/extra-llm-api-config.yml <<EOF

pytorch_backend_config:

use_cuda_graph: true

cuda_graph_padding_enabled: true

cuda_graph_batch_sizes:

- 1

- 2

- 4

- 8

- 16

- 32

- 64

- 128

- 256

- 384

print_iter_log: true

enable_overlap_scheduler: true

EOF- Benchmark komutunu

trtllm-benchkullanarak çalıştırın.

trtllm-bench

--model Qwen/Qwen3-4B

--model_path /path/to/Qwen3-4B

throughput

--backend pytorch

--max_batch_size 128

--max_num_tokens 16384

--dataset /path/to/dataset.txt

--kv_cache_free_gpu_mem_fraction 0.9

--extra_llm_api_options /path/to/extra-llm-api-config.yml

--concurrency 128

--num_requests 32768

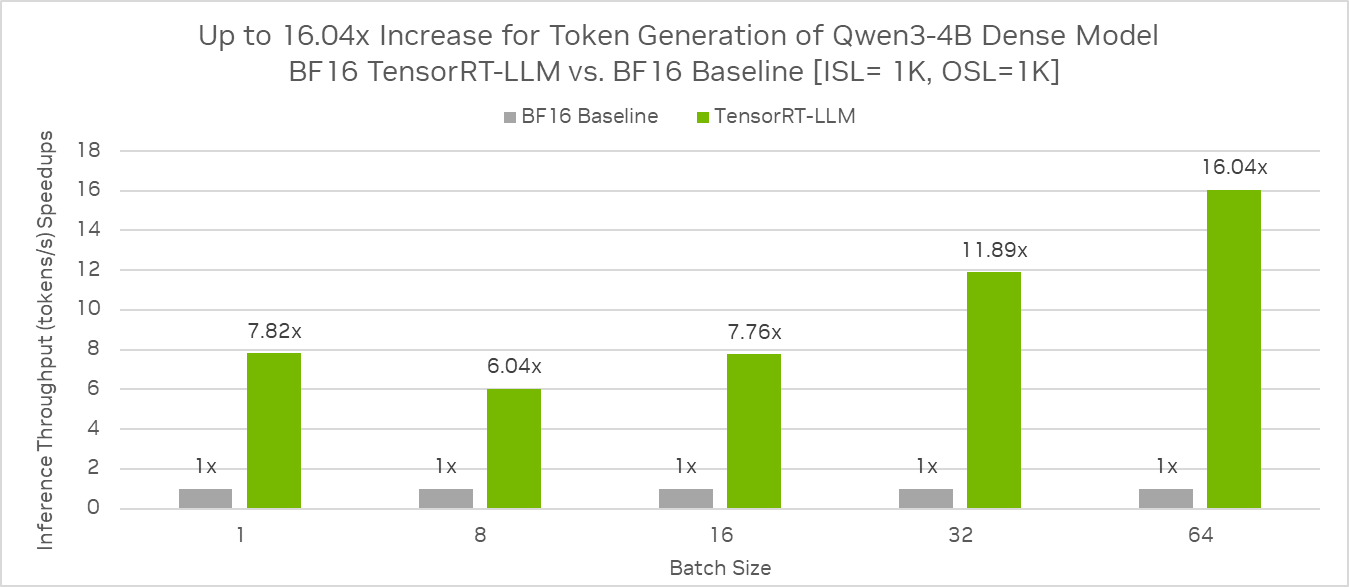

--streamingAynı GPU yapılandırmasıyla, ISL = 1K ve OSL = 1K temel alınarak, Qwen3-4B yoğun modelinin TensorRT-LLM ile BF16 hassasiyetinde çalıştırılarak, BF16 temel hale göre 16.04 kat daha hızlı çıkarım ürettiği görüldü.

Benzer adımlar, diğer Qwen3 modelleri için de model optimizasyonu yapmak üzere uygulanabilir.

- sunucu komutunu

trtllm-serveile çalıştırın.

trtllm-serve

/path/to/Qwen3-4B

--host localhost

--port 8000

--backend pytorch

--max_batch_size 128

--max_num_tokens 16384

--kv_cache_free_gpu_memory_fraction 0.95

--extra_llm_api_options /path/to/extra-llm-api-config.yml- Model başarıyla barındırıldığında, standart OpenAI API kullanarak çıkarım çağrıları yapılabilecektir.

curl -X POST "http://localhost:8000/v1/chat/completions"

-H "Content-Type: application/json"

--data '{

"model": "Qwen/Qwen3-4B",

"Max_tokens": 1024,

"Temperature": 0,

"messages": [

{

"role": "user",

"content": "Fransa'nın başkenti neresidir?"

}

]

}'Ollama, SGLang ve vLLM Çerçeveleri ile Qwen3-4B Çalıştırma

TensorRT-LLM dışında, Ollama, SGLang ve vLLM gibi çerçeveler kullanarak da Qwen modelleri NVIDIA GPU’larında kolayca dağıtılabiliyor. Qwen’in bu sürümü, NVIDIA RTX gibi cihazlarda kullanılabilecek birkaç boyutlu modeller sunuyor.

Ollama kullanarak yerel olarak çalıştırmak için:

- En son Ollama sürümünü ollama.com/download adresinden indirin ve kurun.

ollama runkomutunu kullanarak modeli çalıştırın. Bu işlem, modeli almak ve etkileşim için başlatmak için gereklidir.

ollama run qwen3:4b- Modelin düşünme (thinking) modunu değiştirmek için, kullanıcı istemlerine veya sistem mesajlarına

/think(varsayılan) ve/no_thinkekleyin.ollama runkomutunu çalıştırdıktan sonra terminalde düşünme modlarını test edebilirsiniz:

"İki sayıyı toplayan bir python lambda işlevi yaz" - Düşünme modu etkin

"İki sayıyı toplayan bir python lambda işlevi yaz /no_think" - Düşünmeyen modda- Özel NVIDIA GPU’ya göre optimize edilmiş diğer model varyantları için ollama.com/library/qwen3 adresini inceleyin.

SGLang kullanarak çalıştırmak için:

- SGLang kütüphanesini kurun.

pip install "sglang[all]"- Modeli indirin. Bu demoda Hugging Face üzerinden modeli indirdik, huggingfaceCLI komut istemini kullanarak. Modeli indirmek için bir API anahtarı sağlamanız gerektiğini unutmayın.

huggingface-cli download --resume-download Qwen/Qwen3-4B --local-dir ./- Modeli yükleyip çalıştırın. Farklı ihtiyaçlar için ek argümanlar eklenebilir. Daha fazla ayrıntı için belgeleri kontrol edin.

python -m sglang.launch_server

--model-path /ssd4TB/huggingface/hub/models/

--trust-remote-code

--device "cuda:0"

--port 30000

--host 0.0.0.0- Model çıkarım çağrısı için kullanılabilir.

curl -X POST "http://localhost:30000/v1/chat/completions"

-H "Content-Type: application/json"

--data '{

"model": "Qwen/Qwen3-4B",

"messages": [

{

"role": "user",

"content": "Fransa'nın başkenti neresidir?"

}

]

}'vLLM kullanarak çalıştırmak için:

- vLLM kütüphanesini kurun.

pip install vllm- Model yükleyip

VLLM servekomutunu kullanarak çalıştırın. Farklı ihtiyaçlarınız için ek argümanlar eklenebilir. Daha fazla bilgi için belgeleri kontrol edin.

vllm serve "Qwen/Qwen3-4B"

--tensor-parallel-size 1

--gpu-memory-utilization 0.85

--device "cuda:0"

--max-num-batched-tokens 8192

--max-num-seqs 256- Model çıkarım çağrısı için kullanılabilir.

curl -X POST "http://localhost:8000/v1/chat/completions"

-H "Content-Type: application/json"

--data '{

"model": "Qwen/Qwen3-4B",

"messages": [

{

"role": "user",

"content": "Fransa'nın başkenti neresidir?"

}

]

}'Özet

Qwen modellerini NVIDIA GPU’lar üzerinde popüler çıkarım çerçeveleri kullanarak denemek isteyen geliştiriciler, sadece birkaç komut ile hızlıca başlayabilirler. Model dağıtımı ve çıkarımı için uygun çerçeve seçimi, AI modellerinin üretimdeki performansını, kaynaklarını ve maliyetlerini dengelemeye dayanmaktadır.