Gelişmiş Sorgu Yeniden Yazma ile RAG Sistemlerinin Gücünü Ortaya Çıkarma

Retrieval-Augmented Generation (RAG) sistemleri, net olmayan veya örtük niyet taşıyan kullanıcı sorgularını yönetmekte zorluk yaşayabilir. Kullanıcılar genellikle sorularını belirsiz bir biçimde ifade ederler. Örneğin, “NVIDIA NeMo model eğitimindeki son güncellemelerden bahset” sorgusu, kullanıcının NeMo büyük dil modeli (LLM) özelleştirme özelliklerindeki gelişmelere ilgi duyduğunu ima edebilir; ancak bu tercih açıkça ifade edilmemiştir. Bu durum, suboptimal sonuçlara yol açabilir.

RAG sistemlerinin gerçek potansiyelini ortaya çıkarmak için, temel tekniklerin ötesine geçmek gerekmektedir. Bu yazıda, AI akıl yürütme yeteneklerinin NVIDIA Nemotron LLM’lerinden nasıl yararlanarak RAG sistemlerini önemli ölçüde geliştirdiğini göreceğiz. Bir sorgu motorunun arama yeteneklerini iyileştirmek için uyguladığımız gelişmiş stratejileri örneklerle açıklayacağız.

RAG’de Sorgu Yeniden Yazma Nedir?

Sorgu yeniden yazma, kullanıcının ilk istemini daha optimize bir sorguya dönüştürerek bilgi alımını artıran kritik bir adımdır. Bu süreç, RAG performansını artırmak için çok önemlidir çünkü kullanıcının soruyu sorma şekli ile bilginin yapısının bulunduğu bilgi tabanı arasındaki anlamsal boşluğu kapatır. Sorgu iyileştirilerek belirsizlik ve aşırı karmaşıklık gibi sorunlar aşılabilir, böylece daha hassas ve ilgili belgelerin elde edilmesi sağlanır. Bu yüksek kaliteli bağlam, dil modelinin daha doğru, kapsamlı ve gerçeğe dayalı yanıtlar üretmesine olanak tanır.

Etkin sorgu yeniden yazma için bazı teknikler öne çıkmaktadır:

- Q2E (Query2Expand): Kullanıcının bilgi arayışını çeşitli şekillerde ifade eden, anlamsal olarak eşdeğer sorgular veya genişlemeler üreterek, ilgili belgeleri geri alma olasılığını artırır.

- Q2D (Query2Doc): Orijinal sorgudan bir sahte belge oluşturur ve geri alma pasajlarının tarzını ve içeriğini yansıtır. Bu, bilginin bilgi havuzunda nasıl depolandığı ile uyumu artırır.

- CoT (chain-of-thought) sorgu yeniden yazma: Bu yöntem, LLM’ye orijinal sorguyu parçalayarak ilgili bağlam üzerinde çoğaltmalar yapmasını ve genişletilmiş sorguyu vermeden önce mantıklı bir gerekçelendirme sunmasını söyler. Bu yöntem, sorguyu doğrudan değiştirmek yerine, geniş bir anahtar kelime setini doğal olarak içeren mantıksal açıklamalar üretir.

Bu teknikleri kullanarak RAG sistemleri, kötü yapılandırılmış soruları yeniden yapılandırabilir, hayati anahtar kelimeleri öne çıkarabilir ve kullanıcı sorgularını bilgi havuzunun anlamlarıyla daha yakından ilişkilendirebilir; böylece hem arama hem de yanıt kalitesini önemli ölçüde yükseltir.

NVIDIA Nemotron Modelleri RAG’yi Nasıl İlerletiyor?

NVIDIA Nemotron ailesi, Meta Llama ailesinin üzerine kurulu ve RAG ile bilgiye dayalı sistemler gibi gelişmiş uygulamalar için optimize edilmiş LLM’lerini sunmaktadır. Nemotron modelleri, gelişmiş akıl yürütme yetenekleri, yüksek verimlilik ve esnek dağıtım için tasarlanmış bir açık AI modeli ailesidir. Nano, Super ve Ultra boyutlarında mevcut olan bu modeller, Meta Llama mimarisini NVIDIA’nın kapsamlı sonrası eğitim teknikleriyle birleştirerek sektör benchmarklarında üst düzey doğruluk sağlamaktadır.

Nemotron ailesi içinde, Llama 3.3 Nemotron Super 49B v1 modelinin RAG’deki ilerlemeleri geliştirmek için en uygun model olduğunu bulduk; özellikle çıkarım gecikmesi ve uygun akıl yürütme yeteneği açısından. Natural Questions (NQ) veri setindeki sonuçlar, sorgu yeniden yazmanın geri alma doğruluğunu önemli ölçüde artırdığını açıkça göstermektedir.

| NQ (Natural Question) veri seti | Doğruluk@10 | Doğruluk@20 |

| Orijinal sorgu | 43.1% | 58.3% |

| COT sorgu yeniden yazma ile Llama 3.3 Nemotron Super 49B v1 | 63.8% | 74.7% |

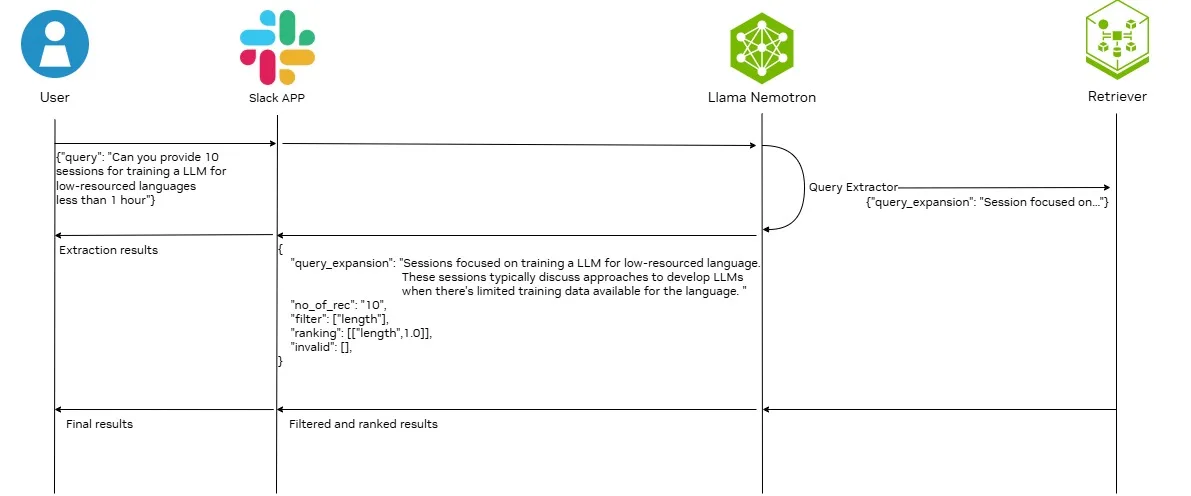

NLG Pipelines ile Sorgu Eveleme Mimarisi

Bu mimaride, Llama Nemotron modeli bir sorgu çıkarıcı olarak şu işlevleri üstlenir:

- Kullanıcı sorgusunu analiz eder ve ana sorguyu çıkarır. Bu adım, kullanıcı sorgusunu gereksiz ve dikkat dağıtıcı ifadelerden arındırarak geri alma sonuçlarını olumsuz etkileyebilecek unsurları dışarıda bırakır.

- Kullanıcı sorgusunu filtreleme veya sıralama kriterlerini çıkarmak üzere analiz eder. Elde edilen filtreleme kriteri, hibrit geri alma araması veya bir yeniden sıralama modeli için kullanılabilir ve bu da kullanıcıların yalnızca alaka düzeyine ek olarak başka sıralama ölçütleri belirlemelerine olanak tanır.

- Çekirdek sorguyu genişleterek ilgili bağlamsal bilgileri ekler. Bu süreç, parafraz üretmek, karmaşık sorguları alt sorulara ayırmak veya arka plan bağlamı eklemek gibi teknikleri içerebilir. Kullanıcının sorgusunun belirsiz veya eksik olduğu durumlarda, sorguları bu şekilde genişletmek geri alma ve doğruluk oranını artırır.

- Genişletilmiş sorguyu NVIDIA NeMo Retriever’a ileterek hızlandırılmış aktarım, gömme ve yeniden sıralama işlemi gerçekleştirir.

Slack, ek uygulamalarla entegrasyonu sağlamak ve geleneksel bir ön yüz geliştirme ve bakım ihtiyacını ortadan kaldırmak için arka uç ile entegre edilmiştir. Kullanıcılarla arka uç arasında sorunsuz iletişim sağlamak için birkaç önemli bileşen bulunmaktadır:

- Anlık olay yönetimi: SocketModeHandler, Slack kullanıcıları ile arka uç arasındaki iletişimi kolay hale getirir.

- Modüler bot yapılandırması: Bileşenlerin yüklenmesi, temel mantığa bağlanması, etkinlik yöneticileri ve günlüklerin ayarlanmasını sağlar.

- Düzenli olumsuz etki: Yanıtların hepsinin yan temalarda atanması, sohbetleri daha organize hale getirir ve karmaşayı azaltır.

Bu yazının amacı, Şekil 1’de gösterilen mimarinin NVIDIA GTC 2025 oturumlarının arama sonuçlarını iyileştirmeye yardımcı olması içindir. Sorgu yeniden yazımı, anlamsal benzerlik aramalarıyla daha yoğun bir oturum seti elde edilmesini sağlar.

Sorgu Motorunu Geliştirme Yöntemleri

RAG iş akışında sorgu yeniden yazma gerekliliğini vurgulayan ana zorluk, kullanıcıların dili ile içerik sözlüğü arasındaki anlamsal boşluktur. Örneğin, kullanıcı sorgusu “Düşük kaynaklı dil için LLM eğitimi oturumları” şeklindedir. Bu sorgudaki ana zorluk, “düşük kaynaklı dil” ifadesidir.

Kullanıcı, çok dilli LLM’lerin veya Sovereign AI ile ilgili oturumları arıyor olabilir. Ancak, bu konuyu tartışan birçok GTC 2025 oturumu mevcut olmasına rağmen, hiçbiri “düşük kaynaklı dil” anahtar kelimesini kullanmamaktadır. Bunun yerine daha yaygın ifadeler “çok dilli”, “İngilizce olmayan”, “Sovereign AI” ya da “Korece” veya “Fransızca” gibi belirli diller olabilmektedir. Bu nedenle, orijinal sorguyu kullanarak ilgili oturumları almak ve sıralamak tatmin edici bir sonuca ulaştırmayabilir.

Bu problemi aşmak için Q2E tekniklerini kullanarak sorguları yeniden yazdık. Bu kullanıcı durumunda Q2D ve COT sorgu yeniden yazma uygun değildir, çünkü kullanıcı sorgusu alan odaklıdır ve genel amaçlı LLM, kullanıcı sorgusuna bağlam oluşturma konusunda bilgiye sahip olmayabilir; bu da yüksek LLM hayal gücü riski doğurur. Aşağıda bu kullanım durumu için bir Q2E örneği verilmiştir.

## Talimat

### Hedef

GTC oturumları için yapılan kullanıcı sorgusu hakkında ne tür oturumlar arandığını belirleyin.

### Adımlar

1. Kullanıcı sorgusundan ana isteği çıkarın.

- Kullanıcının ne aradığına dikkat edin.

- Anahtar kelimeleri bulmalısınız.

- İlgili terimleri ve filtreleme kriterlerini göz önünde bulundurmalısınız.

- Üzerinde durulmaması gereken kelimeleri ana sorgudan çıkarın.

2. Ana sorgu çıkarımınızın açıklamasını yapın.

- Anahtar kelimeleri cümle içerisinde tanımlayın.

Örneğin, “Düşük kaynaklı diller için LLM eğitimi oturumları” sorgusuyla, sorgu genişlemesi, anlamsal benzerlik tabanlı bir geri alma sistemi tarafından en ilgili oturumların sıralamasını önemli ölçüde artırabilir. Genişletme, sıralayıcının kapsamı genişletmesine ve sıralama sürecinde daha da etkili olmasına olanak tanır.

Sorgu Yeniden Yazmanın Faydaları

Sorgu yeniden yazma aracılığıyla arama sonuçlarını iyileştirerek, gelişmiş işlem boru hattı, geleneksel RAG yaklaşımlarına göre önemli avantajlar sunar. Bu avantajın ana kaynağı, kullanıcı sorgularını akıllıca yeniden formüle etmektir. Bu kayda değer bir bağlam ve ayrıntı ekler, yüksek kalitede ve ilişkili bir aday havuzu oluşturur ki bu, sistemin performansında en büyük etkenlerden biridir.

Bu Yöntemin Zorlukları

Sorgu yeniden yazma, AI çıkarımı gerektirdiğinden kaynak tüketimi yüksek ve geleneksel yöntemlere göre daha yavaş olup ölçeklenebilirliği sınırlayabilir. Ayrıca, LLM’ler aynı anda yalnızca belirli sayıda belge işleyebilir; bu durum büyük aday setleri için kaydırma penceresi stratejileri gerektirir. Bu ise karmaşıklığı artırır ve genel sıralama kalitesini zayıflatabilir.

RAG Pipelines Ne Zaman Optimize Edilmeli?

Bu geliştirilmiş RAG boru hattı, doğruluğun hızdan daha önemli olduğu alanlarda özellikle değerlidir. Örneğin;

- Hukuki belge analizi: Sorgu yeniden yazma, karmaşık davalar için en ilgili emsal belgeleri yüzeye çıkartmaya yardımcı olur.

- Klinik araştırmalar: Klinikler, en uygulanabilir araştırmalar ve kılavuzları bulabilir, bu da daha iyi hasta sonuçlarını destekler.

- Risk değerlendirmesi ve karar verme: Güncel ve bağlamsal olarak ilgili bilgi, risk değerlendirmesi, uyum ve yatırım kararları için kritiktir.

Gelişmiş RAG Boru Hatları ile Başlayın

Bu yazıda, NVIDIA Llama Nemotron ailesinin akıl yürütme yeteneklerini kullanarak RAG boru hatlarını geliştirmek için yenilikçi bir yaklaşım tanıttık. Geleneksel yöntemlerin sınırlamalarını aşarak, bu geliştirilmiş mimari, özellikle yüksek doğruluk ve derin anlayış gerektiren senaryolarda daha etkili ve kullanıcı odaklı bilgilere erişim sağlar.

NVIDIA NIM modellerinin tüm yetenekleri hakkında daha fazla bilgi edinmek için Gelişmiş Açık NVIDIA Llama Nemotron Akıl Yürütme Modelleri ile Kurumsal AI Ajanları Oluşturun yazısını inceleyebilirsiniz. Ayrıca, NVIDIA API Kataloğu üzerinde NVIDIA NIM modelleri ile denemeler yapabilirsiniz.