Üretken Yapay Zeka, metin tabanlı modellerden multimodal modellere evrim geçirdi ve son zamanlarda video alanına da genişleyerek çeşitli endüstrilerde yeni potansiyel uygulamaların kapılarını araladı. Video modelleri, kullanıcılara yeni deneyimler sunmak veya otonom ajanları ölçekli bir şekilde eğitmek için senaryoları simüle etmekte yardımcı oluyor. Bu teknoloji, robotik, otonom araçlar ve eğlence gibi pek çok sektörde devrim niteliğinde değişiklikler sağlıyor.

Video temel modellerin geliştirilmesi, video verisinin geniş ve çeşitli yapısı nedeniyle benzersiz zorluklar sunmaktadır. Bu durum, zaman ve mekân dinamiklerini anlamak için etkili model eğitiminin yanı sıra ölçeklenebilir veri kürasyon hatlarının gerekliliğini de gündeme getiriyor.

NVIDIA NeMo çerçevesinde, kendi video temel modellerinizi ön eğitim ve ince ayar yapabileceğiniz yenilikçi video temel model yeteneklerini duyuruyoruz. Bu çerçeve, yüksek hacimli veri kürasyonu, etkili multimodal veri yükleme işlevselliği, ölçeklenebilir model eğitimi ve paralel in-framework çıkarım olanakları sunuyor.

Optimize Edilmiş Hatlar ile Yüksek Hızda Video Kürasyonu

NeMo Küratör, 100 PB veya daha fazla video içeren büyük veri setlerini işleyip hazırlayarak üretken yapay zeka modeli doğruluğunu artırır.

NeMo Küratör’ün ölçeklenebilir veri hatlarını kullanarak, verimliliği artırmak amacıyla videoları kesip, etiketleyip ve filtreleyebilirsiniz. Performansı optimize edecek şekilde NeMo Küratör aşağıdaki kombinasyonu kullanmaktadır:

- NVDEC: Donanım çözümleyici

- NVENC: Donanım kodlayıcı

- Ray: AI uygulamalarını ölçeklendirmek için bir hesaplama çerçevesi

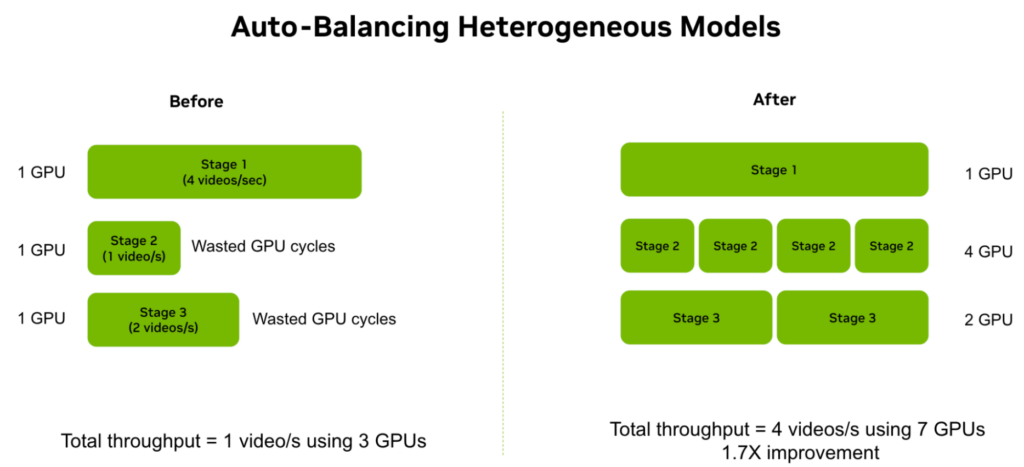

NeMo Küratör, H100 ve GB200 GPU’larının performansını kullanarak L40S GPU’larda NVENC’ten faydalanmak için birden fazla GPU türü ile heterojen kümeleri kullanabilen otomatik dengeleme teknikleri sağlıyor.

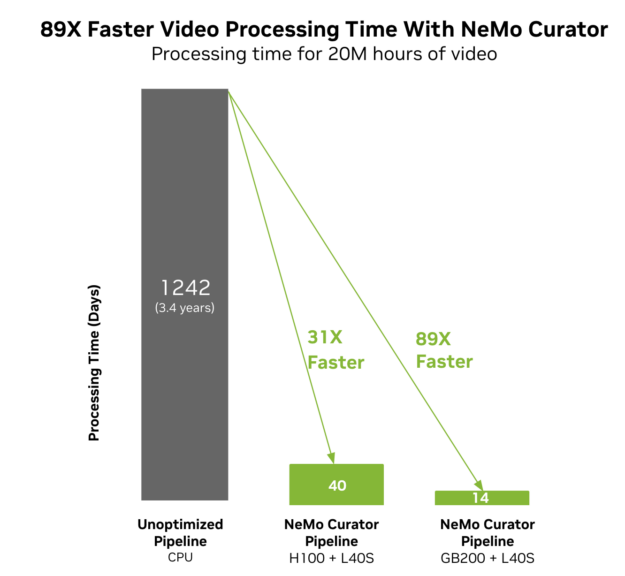

Şekil 1, NeMo Küratör’ün 20 milyon saatlik video verisini işleyerek, işleme süresini yıllardan günlere indirerek 89 kat hız artırımı sağladığını göstermektedir. Bu, optimizasyon yapılmamış CPU hatlarıyla karşılaştırıldığında 1K GPU kullanılarak gerçekleştirilmektedir.

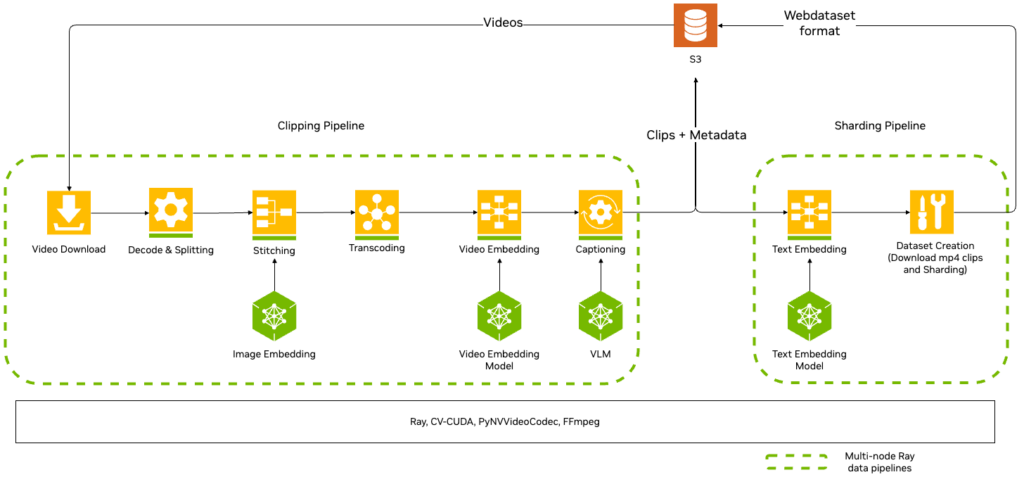

NeMo Küratör, video temel model eğitimi ve ince ayar datasetleri için aşağıdaki önemli hatları sağlar:

- Kesme (Clipping)

- Parçalama (Sharding)

Küçük kesimler oluşturmak için, film kesim hattı, ham videoları, çerçeve bazında renk değişimlerini analiz ederek kısa, sürekli parçalar halinde keser. Birleştirme aşaması ise kenar ekleme benzerliklerini kullanarak aynı kesimlerin yan yana getirilip kaynaştırılmasını sağlar. Bu kesimler daha sonra yüksek kaliteli video kodlamasına (H264) dönüştürülür ve var olan veya bir VLM tarafından yapay olarak üretilen öğelerle etiketlenerek anlamsal arama yeteneklerini kolaylaştırır.

Parçalama, etiketlerin metin gömülerini oluşturarak eğitim için son WebDataset’i yaratır. NeMo Küratör, ayrıca Ray akışını kullanarak otomatik dengeleme sistemi kurar ve her aşamadaki işçi sayısını en iyi şekilde dağıtarak herhangi bir aşamada darboğaz oluşmasının önüne geçer (Şekil 3).

Verimli Multimodal Veri Yükleme

Video modelleri, milyarlarca görüntü ve milyonlarca video üzerindeki eğitim gereksinimlerini karşılarken, eğitim süresinde yüksek verimlilik sağlamak için etkili bir veri yükleme stratejisi gerektirir.

NeMo çerçevesinde, eğitim sırasında yüksek verimlilik sağlamak için Megatron-Energon veri yükleyici kullanılmaktadır:

- Büyük ölçekli verileri parçalara ayırma: WebDataset formatını kullanarak TB boyutundaki datasetleri sıkıştırılmış dosyalara ayırır ve eğitim sırasında I/O yükünü azaltır.

- Deterministik kaydetme ve yükleme: Eğitim işi kesintiye uğradığında veri setinin tekrarsız bir geçiş yapılmasını sağlar, farklı eğitim kümesi yapılandırmalarında tutarlılığı garanti eder.

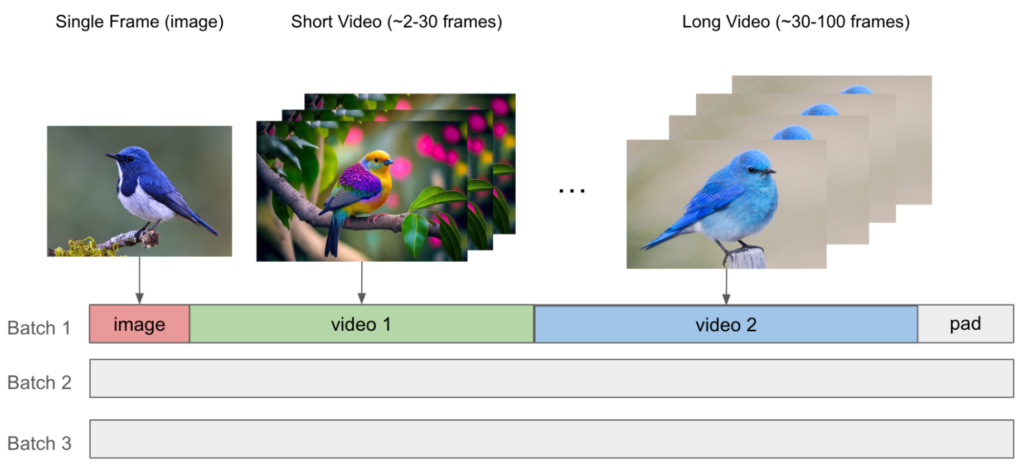

- Özdeş paketleme: Değişken uzunlukta veya çözünürlükteki görüntüleri ve videoları maksimum dizilim uzunluğuna kadar birbirine paketleyerek, doldurma nedeniyle oluşan hesaplama israfını en aza indirir ve veri yükleme mantığını basitleştirir. NeMo, dizilim paketleme ile hızlandırılmış eğitim sağlamak için Transformer engine‘den özel THD dikkat çekir.

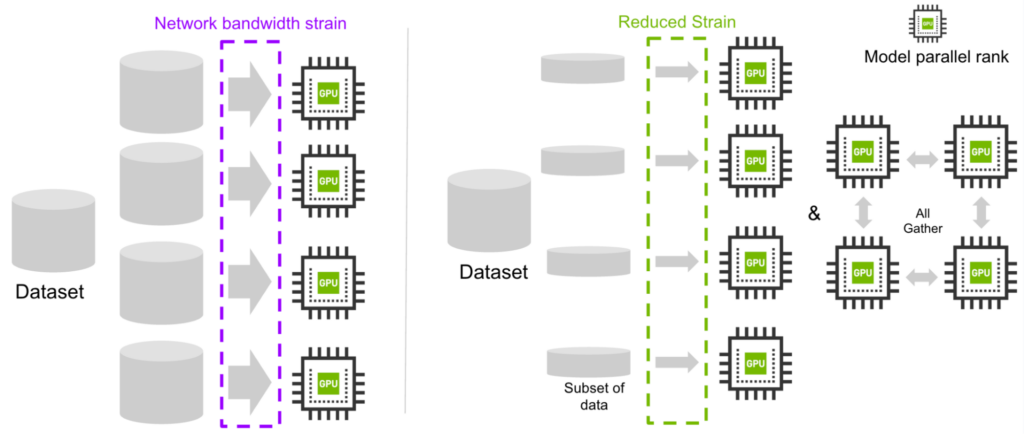

- Ağ bant genişliği üzerindeki baskıyı azaltma: Her model paralel derecesi, tüm datasetin yerine farklı bir veri alt kümesini indirir ve ardından tüm dereceleri toplayarak aynı veri yükleyicisini oluşturur.

Video Temel Model Eğitimini Ölçeklendirme

Video temel modeller, ya otoregresif ya da difüzyon modeller olabilir.

NeMo çerçevesinin büyük dil modelleri (LLM) için oluşturulmuş araçları, otoregresif modeller için yeniden kullanılabilirken, difüzyon dönüştürücülerinin desteği olarak DiT, MovieGen ve en son NVIDIA Cosmos dünya temel modelleri gibi yenilikçi yapılar eklenmiştir.

NeMo teknoloji yığını, yüksek verimlilik sağlamakta ve en son benchmark’larda %40’tan fazla Model FLOPs Kullanımını (MFU) sağlamıştır (Tablo 1).

| Model boyutu | Bağlam uzunluğu | Eğitim yapılandırması | Kullanılan GPU (TFLOPS/s) | Verim (token/s/GPU) |

| DiT 7B | 8k | temel, optimizasyon yok | OOM | |

| DiT 7B | 8k | CP=2 | 457 | 8,969 |

| DiT 7B | 74k | TP=4 SP CP=4 | 414 | 2,933 |

| DiT 28B | 8k | TP=2 SP PP=2 | 435 | 2,392 |

| DiT 28B | 74k | TP=8 SP CP=4 PP=4 | 411 | 994 |

Kısaltmalar: CP=bağlam paralelliği; TP=tensor paralelliği; SP=dizi paralelliği; PP=boru hattı paralelliği

Video Difüzyon Boru Hattının Genel Görünümü

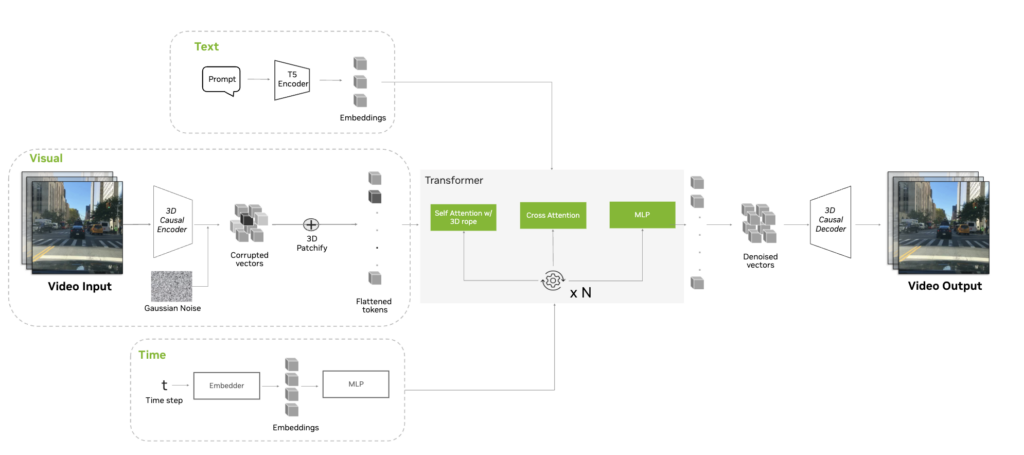

Bir video difüzyon eğitim boru hattı, genellikle şu ana adımlardan oluşur:

- Girdi görüntü ve videoları tokenize etme: 3D zamanlayıcı ile 3D mekan-zamansal token’lar üretmek için.

- Difüzyon gürültü program dalga zaman adımı t ve metin girişi ile koşullandırılan bir dönüştürücü kodlayıcı kullanma:

- Zaman adımı koşullandırması, eğitim sırasında Model FLOPs Kullanımını (MFU) artıran bir Uyarlanabilir Katman Normalizasyonu (AdaLN) mekanizması ile uygulanır. Ayrıca, AdaLN-LoRA kullanma seçeneği ile.

- Metin koşullandırması, her dönüştürücü bloğundaki çapraz dikkat katmanıyla sağlanır.

- NeMo çerçevesi, tıpkı DiT mimarisine benzer bir şekilde veya Gruplu-Sorgu Dikkati (GQA) kullanan MovieGen Llama mimarisine dayalı olarak dönüştürücü kodlayıcıyı başlatma olanağı sağlar.

- Difüzyon kaybını hesaplama: Dönüştürücüden gelen gürültü tahmini ile paralel EDM difüzyon boru hattı kullanılarak.

NeMo, ayrıca dikkat blokları öncesinde sorguları ve anahtarları dengelemek için kök ortalama kare katman normalizasyonu (RMSNorm) uygulanır ve difüzyon eğitimini istikrara kavuşturur. RMSNorm, tensor paralelliğiyle uyumlu kalmak için her dikkat başlığı için uygulanır.

Video Difüzyon Modelleri için Paralellik Optimizasyonları

NeMo ve Megatron-Core, çeşitli model paralellik tekniklerini destekler:

- Tensor paralel (TP)

- Dizi paralel (SP)

- Boru hattı paralel (PP)

- Bağlam paralel (CP)

Ancak, bu teknikler video difüzyon dönüştürücülerine uygulandığında benzersiz zorluklarla karşılaşılmaktadır. NeMo, ölçeklenebilir ve performanslı bir eğitim sağlamak için bu sorunları nasıl çözüyor:

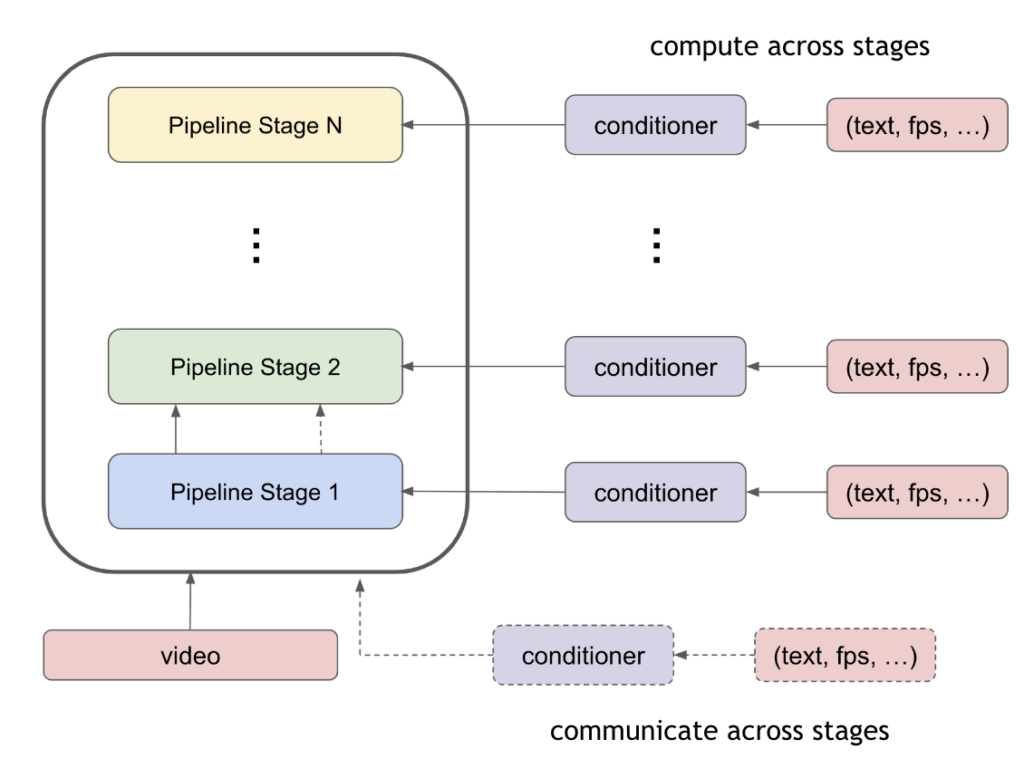

- Koşullandırma için verimli boru hattı paralelliği

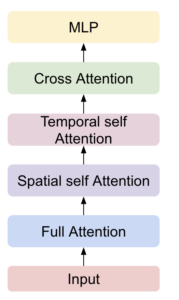

- Uzamsal-Zamansal DiT (ST-DiT) mimarisine destek

- Özelleştirilmiş rastgele tohum mekanizması

Geleneksel yaklaşımda, koşullandırma bilgilerini boru hattı aşamaları arasında iletmek için ek iletişim maliyetine katlanılması gerekmektedir. NeMo, bu sorunu boru hattındaki her aşamada koşullandırma gömme değerlerini hesaplayarak çözer. Koşullandırma için hesaplama maliyeti, iletişim maliyetinden çok daha azdır ve eğitim verimliliğini artırır.

Uzamsal-Zamansal DiT (ST-DiT) mimarisi, her dönüştürücü bloğuna ek uzamsal ve zamansal öz-dikkat katmanları ekler, bu da uzun video dizileriyle eğitim esnasında tam öz-dikkati sağlamanın yerine geçer. Bu yaklaşım, bu katmanlar için daha kısa giriş dizisi üzerinden daha küçük bir hesaplamada iletişim yükü ortaya koyar. NeMo, bu durumu yerel dikkat hesaplamaları ile A2A iletişim yöntemini kullanarak çözer.

| Katman | Girdi Seq | İletişim primi | İletişim bant genişliği |

| Zamansal öz-dikkat | Kısa seq | Yerel hesaplama & A2A | (bhw/cp, t, d) |

| Uzamsal öz-dikkat | Kısa seq | Yerel hesaplama & A2A | (bt/cp, hw, d) |

| Tam dikkat | Uzun seq | CP ile P2P | (b, h*w*t/cp, d) |

Kısaltmalar: b=işlem hacmi; h*w=uzamsal boyut; t=zamansal boyut; cp=bağlam paralel boyutu; d=gizli boyut, girdi boyutu (b, t*h*w, d).

Özelleştirilmiş rastgele tohumlama mekanizması, aşağıdaki bileşenlerde rastgele tohumların doğru bir şekilde başlatılmasını sağlamayı amaçlamaktadır:

- Zaman adımı

- Gaussian gürültü

- Gerçek model ağırlıkları

Tablo 3, NeMo’nun başlangıç stratejisini göstermektedir.

| RNG tohum | Veri paralel | Bağlam paralel | Boru hattı paralel | Tensor paralel |

| Zaman adımı (t) | Farklı | Aynı | Aynı | Aynı |

| Gaussian gürültü | Farklı | Farklı | Aynı | Aynı |

| Ağırlık başlatma | Aynı | Aynı | Farklı | Farklı |

Kısaltmalar: Farklı= Diğer paralel sıralardan farklı rastgele tohum; Aynı= Diğer paralel sıralarla aynı rastgele tohum.

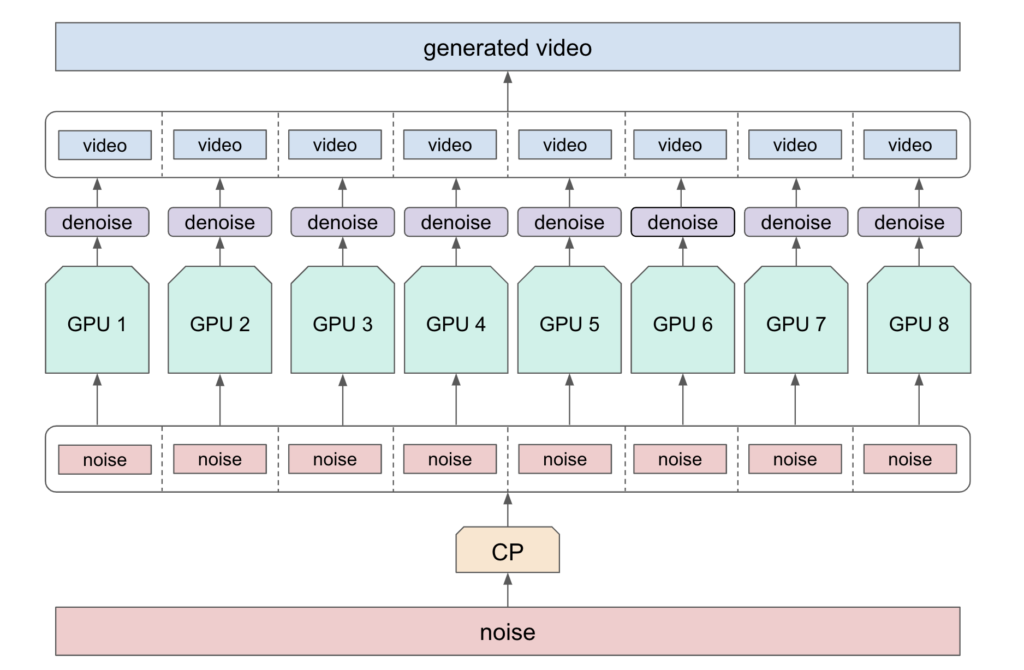

Verimli İn-framework Çıkarım

NeMo çerçevesi, denoising işlemlerini birden fazla GPU’ya dağıtarak çıkarımı hızlandırır. Paralel denoising işleminden sonra, latent tensörler video dizisini yeniden yapılandırmak için bir araya getirilir ve ardından Cosmos video tokenizer ile kod çözme yapılır.

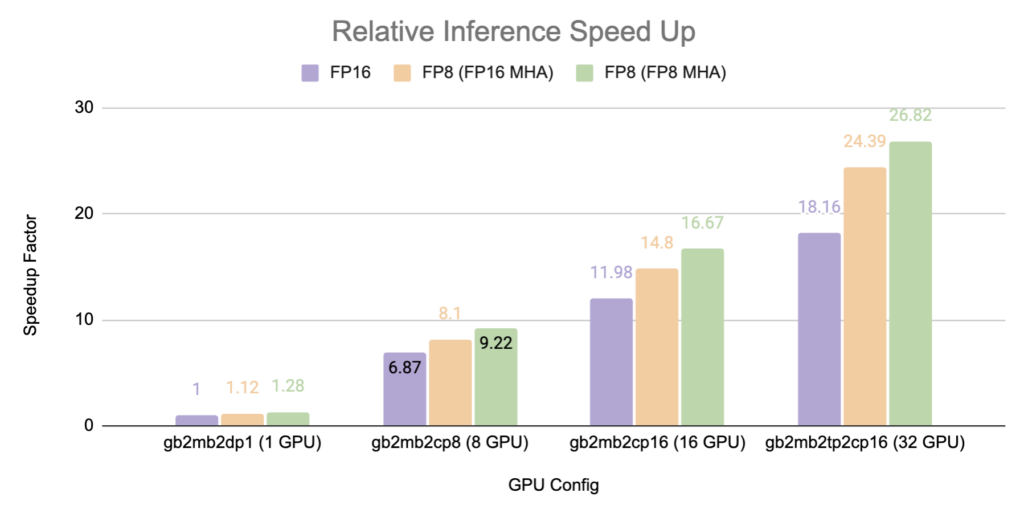

Benchmark’lar, 32 H100 GPU’ya kadar %80-90 ölçeklenebilirlik verimliliği sağlarken, FP8 Çoklu Başlı Dikkat, 1 ve 32 GPU ile sırasıyla %28 ve %48 performans artışı sağlamaktadır.

Sonuç

Bu yazıda, NVIDIA NeMo çerçevesinin video temel modellerini etkili ve verimli bir şekilde ön eğitim veya ince ayar yapabilmenizi sağlayan tüm özelliklerini ele aldık.

NeMo Küratör, kesme ve parçalama hatları aracılığıyla yüksek hızlı veri kürasyonu sunarken, Megatron Energon kütüphanesi de etkili multimodal veri yükleme imkânları sunmaktadır. NeMo çerçevesi, difüzyon ve otoregresif modeller üzerine optimize edilmiş çeşitli model paralelliği teknikleri ile video temel model eğitiminde ölçeklenebilirlik sağlar. Ayrıca, birden fazla GPU’ya dağıtılmış denoising işlemleriyle ve FP8 Çoklu Başlı Dikkat ile verimli in-framework çıkarım sağlar.

NeMo Küratör ile video verilerinizi küratörlük yapmaya başlayabilir, tokenize edebilir, eğitim sürecine geçebilir ve hem otoregresif hem de difüzyon modelleri için ince ayar yapabilirsiniz.

Ayrıca, NVIDIA Cosmos dünya temel modellerini build.nvidia.com adresinden deneyebilir ve NVIDIA CEO’su Jensen Huang’ın CES açılış konuşmasını izleyerek NVIDIA Cosmos dünya temel model platformu hakkında daha fazla bilgi edinebilirsiniz.