Yapay zeka (AI) modellerinin daha büyük hale gelmesi ve daha uzun metin dizilerini işleyebilmesiyle birlikte, verimliliğin ölçek kadar önemli hale geldiği bir döneme giriyoruz.

Alibaba, araştırma ve geliştirme topluluğuna yeni nesil hybrid Mixture of Experts (MoE) mimarisini tanıtmak amacıyla iki yeni açık model olan Qwen3-Next 80B-A3B-Thinking ve Qwen3-Next 80B-A3B-Instruct’u piyasaya sürdü.

Geliştiricilerin gelişmiş akıl yürütme yeteneklerini doğrudan kullanıcı arayüzü üzerinden veya NVIDIA NIM API’si aracılığıyla test edebilmesi için Qwen3-Next-80B-A3B-Thinking artık build.nvidia.com’da aktif durumda.

Bu yeni mimarinin uzun bağlam uzunlukları (>260K token girişi) ve büyük ölçekli parametre verimliliği için optimize edildiği belirtiliyor. Her model 80 milyar parametre içeriyor, ancak spars MoE yapısı nedeniyle her token başına yalnızca 3 milyar parametre etkin. Bu da dev bir modelin gücünü küçük bir modelin verimliliğiyle birleştiriyor.

Qwen3-Next gibi bir MoE modelinin performansı, 512 farklı uzman arasında yönlendirme yaptığı için GPU’lar arası iletişime bağlıdır. Blackwell’in 5. nesil NVLink’i, doğrudan GPU’dan GPU’ya 1.8 TB/s bant genişliği sağlıyor. Bu yüksek hızlı yapı, uzman yönlendirme sürecinde gecikmeyi en aza indirmek için gereklidir ve doğrudan daha hızlı çıkarım ile daha yüksek token verimliliğine dönüşür.

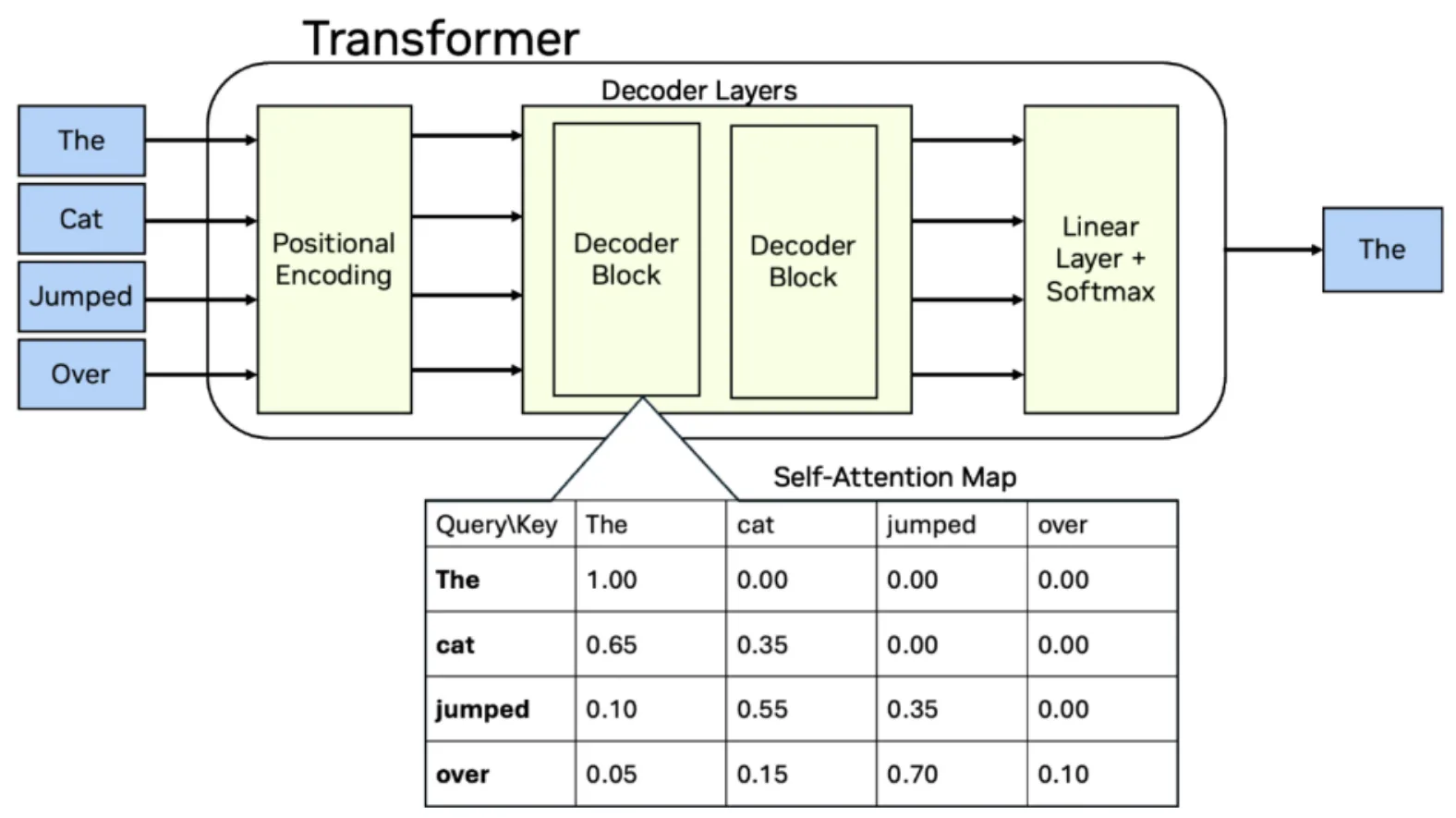

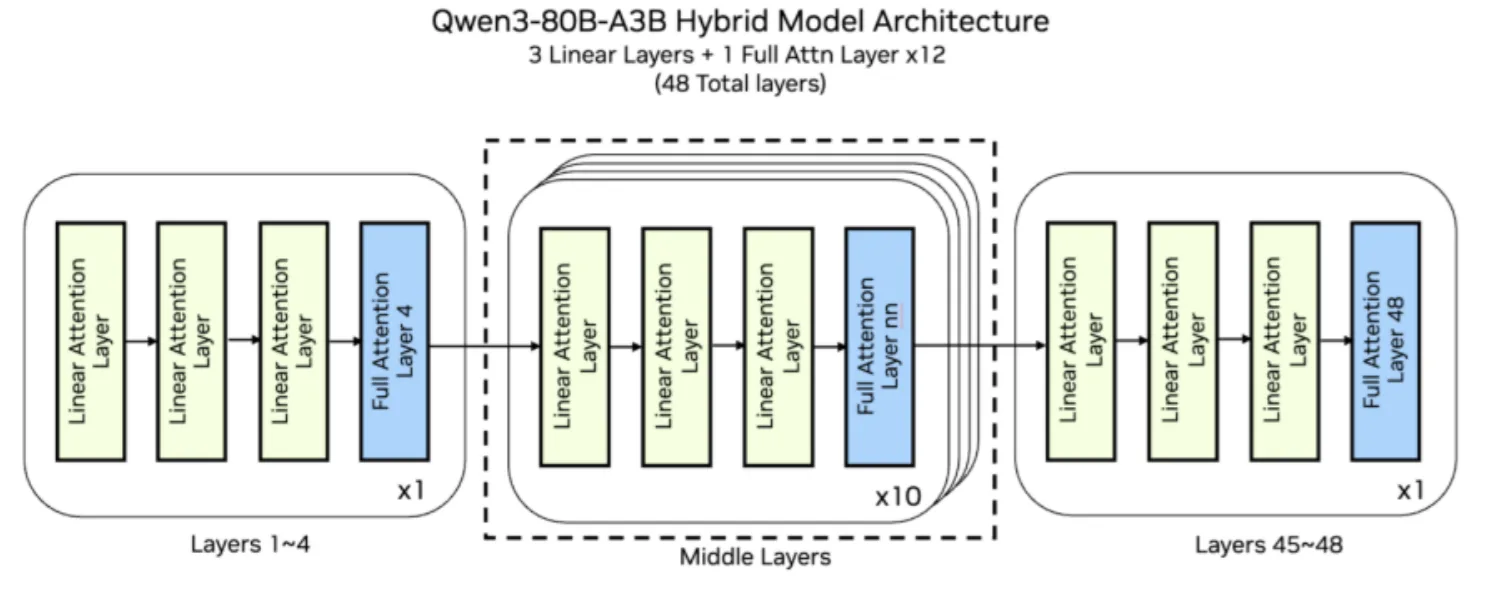

Model, 48 katmandan oluşuyor; her 4. katman GQA dikkat mekanizması kullanırken, kalanlar yeni lineer dikkat yöntemini kullanıyor. Büyük dil modelleri (LLM’ler), girdi dizisinin her token’ını yorumlamak ve önem atamak için dikkat katmanlarını kullanıyor. Ancak daha az olgun yazılım yığınları, yeni mimariler için önceden optimize edilmiş ilkelere veya dikkat türleri arasındaki sürekli geçişleri verimli kılacak birleşimlere sahip değil.

Uzun giriş bağlamı kapasitesine ulaşmak için model, Gated Delta Networks teknolojisini kullanıyor; bu teknoloji NVIDIA araştırma ekibi ve MIT ile birlikte geliştirilmiştir. Gated DeltaNets, odaklanma dizisi işleme yeteneğini artırarak modelin çok uzun metinleri etkili bir şekilde işlemesini sağlıyor. Bu sayede hafıza ve hesaplama hemen hemen doğrusal olarak büyüyerek, modelin önemli kısımları unutmasını önlüyor.

Bunların yanı sıra, model NVIDIA Hopper ve Blackwell üzerinde optimize edilmiş çıkarım performansı sunabiliyor. NVIDIA’nın esnek CUDA programlama mimarisi, geleneksel Transformer modellerinin tam dikkat katmanlarını ve Qwen3-Next modellerindeki lineer dikkat katmanlarını deneysel bir şekilde deneme imkanı sağlıyor. NVIDIA üzerinde çalıştırıldığında, Qwen3-Next modellerindeki hibrit yaklaşım verimlilik artışları sağlayarak daha fazla token üretimi ve AI fabrikaları için daha fazla gelir elde etme yolunu açıyor.

NVIDIA, topluluk için model dağıtımını sağlamak amacıyla açık kaynak çatıları SGLang ve vLLM ile işbirliği gerçekleştirdi. Geliştiriciler, kendi ihtiyaçlarına göre kurumsal yazılım konteynerleri aracılığıyla en ileri düzey açık modellere ulaşabilirler.

Model Dağıtımına Başlayın

SGLang sunucu çerçevesiyle model dağıtımı yapmak isteyen kullanıcılar aşağıdaki talimatları kullanabilirler. Daha fazla bilgi ve konfigürasyon seçenekleri için SGLang belgelere göz atabilirsiniz.

python3 -m sglang.launch_server --model Qwen/Qwen3-Next-80B-A3B-Instruct --tp 4

vLLM ile Dağıtım

vLLM sunucu çerçevesi ile model dağıtımı yapmak isteyen kullanıcılar aşağıdaki talimatları izleyebilirler. Daha fazla bilgi için vLLM duyuru bloguna göz atabilirsiniz.

uv pip install vllm --extra-index-url https://wheels.vllm.ai/nightly --torch-backend=auto

vllm serve Qwen/Qwen3-Next-80B-A3B-Instruct -tp 4

NVIDIA NIM ile Üretime Hazır Dağıtım

Kurumsal geliştiriciler, Qwen3-Next-80B-A3B ve diğer Qwen modellerini denemek için NVIDIA ortamında barındırılan NIM mikrosite uç noktalarını kullanabilirler. NVIDIA API kataloğu‘nda mevcut olan bu pre-packaged, optimize edilmiş NIM mikrositeleri yakında indirilebilir hale gelecektir.

Açık Kaynak AI Üzerinde Geliştirmek

Yeni hibrit MoE Qwen3-Next mimarisi, verimlilik ve akıl yürütme alanında sınırları zorlamakta ve topluluk için önemli bir ilerleme kaydettiklerini göstermektedir. Bu modellerin açık bir şekilde sunulması, araştırmacıların ve geliştiricilerin deneme yapabilmeleri, yeni şeyler inşa edebilmeleri ve yenilikleri hızlandırmaları için bir fırsat sunuyor. NVIDIA olarak bu konuda açık kaynak katkılarına büyük önem veriyoruz ve örnek olarak NeMo AI yaşam döngüsü yönetimi, Nemotron LLM’leri ve Cosmos dünya temel modelleri gibi projelerle bu taahhüdü yerine getiriyoruz. Amacımız, AI modellerinin geleceğinin sadece daha güçlü değil, aynı zamanda daha erişilebilir, şeffaf ve işbirlikçi olmasıdır.

Bugün Başlayın

Açık Router üzerinde modelleri deneyebilirsiniz: Qwen3-Next-80B-A3B-Thinking ve Qwen3-Next-80B-A3B-Instruct. Ayrıca Hugging Face üzerinden Qwen3-Next-80B-A3B-Thinking ve Qwen3-Next-80B-A3B-Instruct‘ı indirebilirsiniz.