Gelişmiş yapay zeka (AI) modellerinin geliştirilmesi ve dağıtımı sürecinde, ölçeklenebilir ve verimli bir GPU altyapısına erişim oldukça önemlidir. Ancak, bu altyapının bulut tabanlı ve konteynerleşmiş ortamlarda yönetimi karmaşık ve maliyetli olabilir. İşte bu noktada NVIDIA Run:ai devreye giriyor. NVIDIA Run:ai, artık AWS Marketplace’te genel olarak erişilebilir durumda ve bu da kuruluşların yapay zeka altyapı yönetimlerini daha da kolaylaştırıyor.

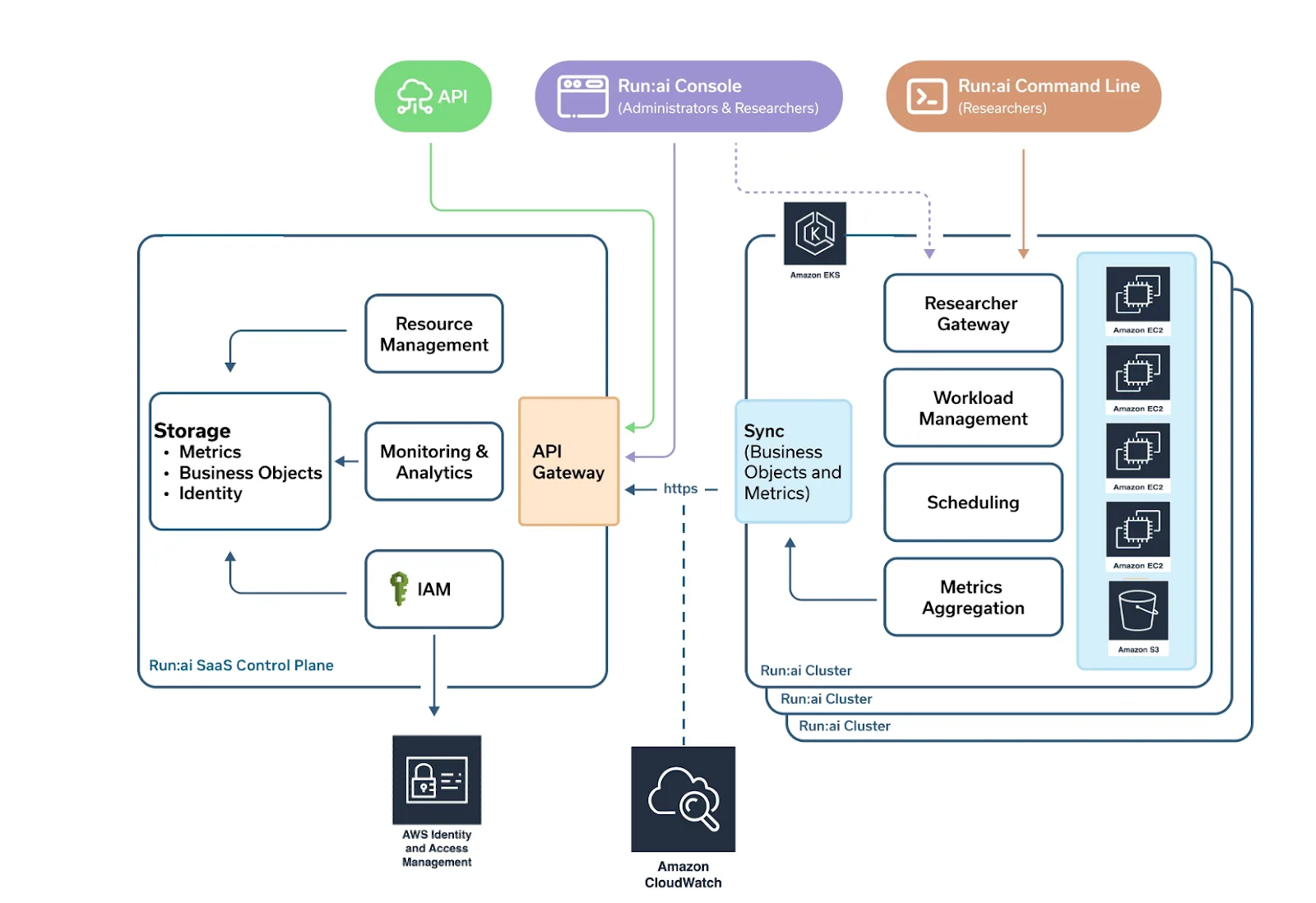

Kubernetes tabanlı ortamlara özel olarak geliştirilen NVIDIA Run:ai, GPU altyapısı için bir kontrol düzlemi işlevi görmektedir. Bu, karmaşıklığı ortadan kaldırarak, kuruluşların AI iş yüklerini hızla, etkin bir şekilde ve düzgün bir yönetişimle ölçeklendirmelerini sağlar.

Bu yazıda, NVIDIA Run:ai’nin Amazon Web Services (AWS) üzerindeki AI iş yüklerini ve GPU’ları nasıl yönettiğine dair detaylara ineceğiz. NVIDIA Run:ai, NVIDIA GPU destekli Amazon EC2 instance’ları, Amazon Elastic Kubernetes Service (EKS), Amazon SageMaker HyperPod, AWS Identity and Access Management (IAM), Amazon CloudWatch ve diğer AWS yerel hizmetleri ile sorunsuz bir şekilde entegre olmaktadır.

Karşılaşılan Zorluk: Verimli GPU Orkestrasyonu

Modern AI iş yükleri, geniş ölçekli eğitimden gerçek zamanlı çıkarıma kadar dinamik, güçlü GPU’lara erişim gerektirmektedir. Ancak Kubernetes ortamlarında, GPU’lar için yerel destek sınırlıdır. Karşılaşılan yaygın zorluklar şunları içerir:

- Statik tahsis nedeniyle verimsiz GPU kullanımı

- İş yükü önceliklendirmesi ve yeniden önceliklendirme eksikliği

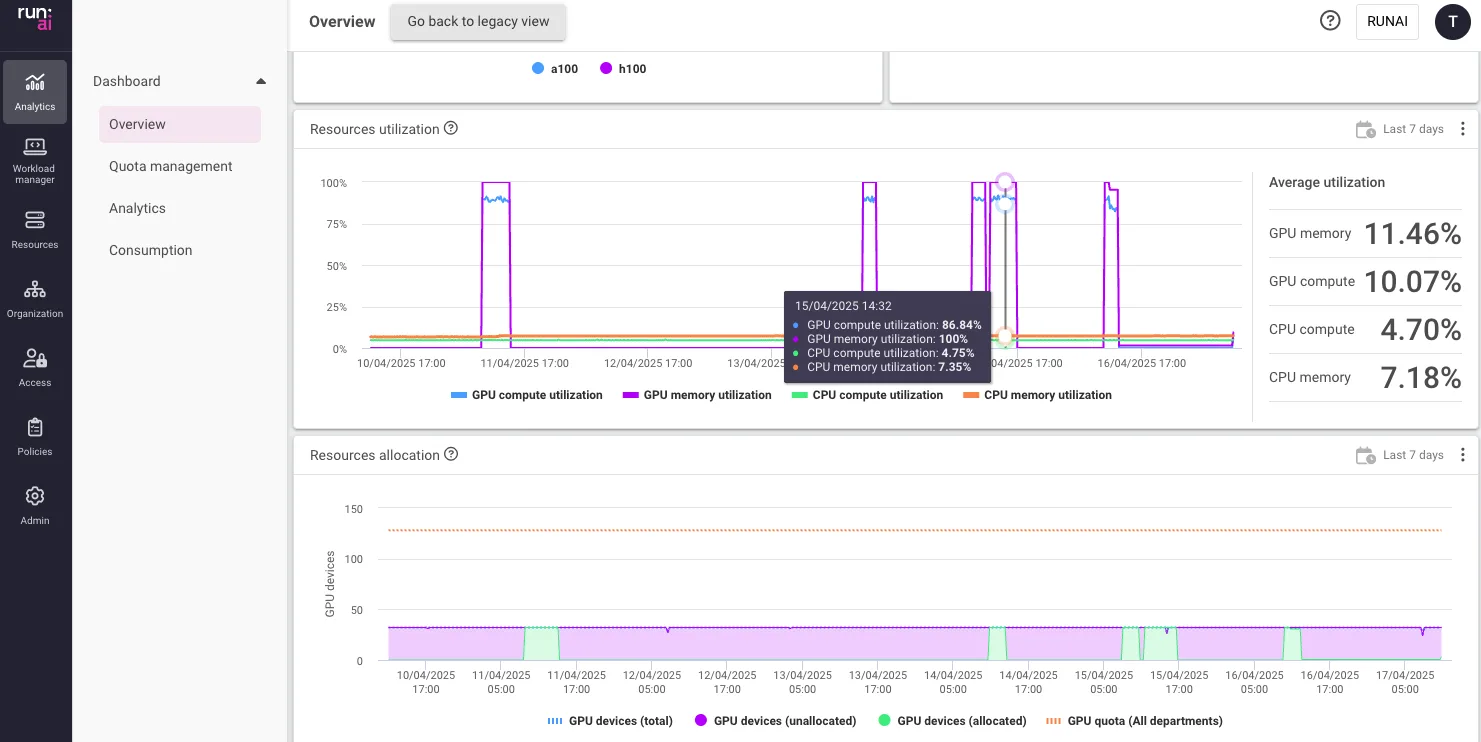

- GPU tüketimine dair sınırlı görünürlük

- Takımlar ve iş yükleri arasında yönetişimi sürdürme zorluğu

NVIDIA Run:ai Çözümü

NVIDIA Run:ai, yalnızca AI/ML iş yükleri için tasarlanmış Kubernetes tabanlı bir orkestrasyon platformu sunarak, bu zorluklaraçözüm sağlar. Dinamik, politika bazlı GPU kaynakları planlamasıyla sanal GPU havuzları oluşturur.

Ana Özellikler:

- Fraksiyonel GPU tahsisi: Tek bir GPU’yu birden fazla çıkarım işine veya Jupyter defterine paylaşma imkanı sunar.

- Dinamik planlama: İş önceliğine, kuyruklama ve mevcudiyete bağlı olarak tam veya fraksiyonel GPU’lar tahsis eder.

- İş yükü bilincine sahip orkestrasyon: eğitim, ayar ve çıkarma iş yüklerini farklı şekilde ele alır, her aşama için optimize edilmiş politikalar sunar.

- Takım bazlı kotalar ve izolasyon: fairshare veya katı kotalar kullanarak takımlara veya projelere kaynak garantisi sağlar.

- Çok kullanıcı yönetimi: Paylaşılan altyapı ortamlarında maliyet şeffaflığı ve uyum sağlamanıza yardımcı olur.

NVIDIA Run:ai’nin AWS Üzerindeki Çalışma Şekli

NVIDIA Run:ai, performansı optimize etmek ve operasyonları basitleştirmek için NVIDIA destekli AWS hizmetleri ile sorunsuz bir şekilde entegre olur:

1. Amazon EC2 GPU Destekli Instansları

NVIDIA Run:ai, NVIDIA GPU’ların bulunduğu EC2 instance’larının üstünde dağıtılan Kubernetes kümelerine AI iş yüklerini planlar. Bu, akıllıca paylaşım ve kutuplama aracılığıyla GPU kullanımını maksimize eder.

- Birden fazla GPU ve düğümde eğitim desteklenir.

- Etkin iş yükleri için zaman dilimlendirme ve GPU aşırı tahsisi sağlar.

2. Amazon EKS (Elastic Kubernetes Service)

NVIDIA Run:ai, Amazon EKS ile yerel olarak entegre olmaktadır, bu sayede AI iş yükleri için özel olarak tasarlanmış bir planlama ve orkestrasyon katmanı sunar. Kubernetes kümelerinde GPU kaynaklarının kullanılabilirliğini maksimize eder.

- EKS ile NVIDIA Run:ai Planlayıcısının yerel entegrasyonu

- Gelişmiş GPU kaynak yönetimi ile AI iş yüklerini orkestre etme ve optimize etme yeteneği

- NVIDIA GPU Operatörü ile uyumlu olup, EKS düğümleri üzerinde GPU sürücülerinin, izleme ajanlarının ve kütüphanelerin otomatik olarak sağlanmasını destekler.

3. Amazon SageMaker HyperPod

NVIDIA Run:ai, Amazon SageMaker HyperPod ile entegre edilerek hem yerel hem de özel/bulut ortamlarında AI altyapısını sorunsuz bir şekilde genişletir.

- NVIDIA Run:ai’nin gelişmiş AI iş yükü ve GPU orkestrasyon platformu ile birleştirildiğinde etkinlik ve esneklik artırır.

- Büyük ölçekli dağıtılmış eğitim ve çıkarım için özel olarak tasarlanmıştır.

Amazon CloudWatch ile Entegrasyon

GPU iş yüklerini ölçekli bir şekilde izlemek, gerçek zamanlı görünürlük gerektirir. NVIDIA Run:ai, Amazon CloudWatch ile entegre edilebilir:

- Özel Ölçümler: GPU düzeyinde kullanım ölçümlerini (örneğin, bellek kullanımı ve zaman dilimleme istatistikleri) CloudWatch’a aktarır.

- Görselleştirme: İş, takım veya proje başına GPU tüketimini görselleştirir.

- Alarm: Düşük kullanım, iş başarısızlıkları veya kota ihlalleri gibi durumlarda uyarı tetikler.

NVIDIA Run:ai’nin zengin iş yükü telemetrisi ile CloudWatch’ın analitik ve uyarı mekanizmalarını birleştirerek, kullanıcıların kaynak tüketimi ve verimliliği hakkında eyleme geçirilebilir içgörüler edinmesini sağlar.

AWS IAM ile Entegrasyon

Güvenlik ve yönetişim, AI altyapısının temeli olmalıdır. NVIDIA Run:ai, AWS IAM ile entegre olarak:

- AWS kaynaklarına güvenli erişimi yönetir.

- NVIDIA Run:ai içinde API, kaynak ve isim alanı seviyelerinde en az ayrıcalık erişim kontrollerini uygular.

- Uyum ve güvenlik için erişim günlüğü ve API etkileşimlerinin denetimini destekler.

IAM entegrasyonu, yalnızca yetkilendirilmiş kullanıcıların ve servislerin AWS ortamındaki NVIDIA Run:ai kaynaklarına erişim veya yönetim sağlamasını garantiler.

Örnek: EKS Üzerinde Çok Takımlı GPU Orkestrasyonu

Diyelim ki bir işletme AI platformunda üç takım var: doğal dil işleme (NLP), bilgisayarla görme ve üretken AI. Her takım, eğitim için garanti edilmiş GPU erişimine ihtiyaç duymaktadır ve ayrıca paylaşılan altyapıda çıkarım görevleri yürütmektedir.

NVIDIA Run:ai ile:

- Her takım, kendine ait bir quota ve ad alanı ile fairshare politikası alır.

- Eğitim işleri, öncelik ve mevcut kapasiteye göre dinamik olarak kuyruklanır ve planlanır.

- İnteraktif işler, kıt GPU kaynaklarından en yüksek getiriyi elde etmek için fraksiyonel GPU kullanır.

- Tüm kullanım CloudWatch üzerinden izlenir ve erişim IAM rolleri ile kontrol edilir.

Bu model, AI ekiplerinin birbiriyle çatışmadan hızlı hareket etmelerini sağlar ve israf edilen GPU’lar üzerinde bütçeyi fazlasıyla artırmalarına engel olur.

Başlayın

Kuruluşlar AI çabalarını ölçeklendirdikçe, GPU altyapısını manuel yönetmek sürdürülemez bir hale gelir. NVIDIA Run:ai, AWS üzerindeki NVIDIA teknolojileri ile birlikte, GPU yönetimini basitleştiren, verimliliği artıran ve AI yeniliklerini hızlandıran güçlü bir orkestrasyon katmanı sunar.

EKS, EC2, IAM, SageMaker HyperPod ve CloudWatch ile yerel entegrasyon sayesinde, NVIDIA Run:ai bulutta AI/ML iş yükleri için birleşik ve kurumsal düzeyde bir temel sağlar.

NVIDIA Run:ai’yi AWS ortamınıza dağıtmak veya daha fazla bilgi edinmek için AWS Marketplace’te NVIDIA Run:ai listesine göz atabilir veya NVIDIA Run:ai belgeleri‘ni keşfedebilirsiniz.