Modern yapay zeka (YZ) iş yükleri, büyük ölçekli eğitimden gerçek zamanlı çıkarıma kadar, güçlü GPU’lara dinamik erişim gerektirir. Ancak, Kubernetes ortamlarında GPU yönetimi için sınırlı yerel destek bulunması, verimsiz GPU kullanımı, yük önceliklendirmesi ve öncelikli çalışma zorlukları, er geç görünür hale gelir. Bu da görüntüleme ve kuota politikalarını uygulamakta zorluklara yol açar.

Kapalı ortamlarda GPU kaynaklarını etkin bir şekilde düzenlemek, performansı ve verimliliği artırmaya yardımcı olur. NVIDIA Run:ai, bu süreci akıllı GPU kaynak yönetimi ile basit hale getirerek, organizasyonların YZ iş yüklerini hızla, çevik bir şekilde ve yönetişim altında ölçeklendirmelerine olanak tanır.

Bu blogda, NVIDIA Run:ai‘nin, artık Microsoft Marketplace‘de genel olarak kullanıma hazır hale geldiğini inceleyeceğiz. Bu platformun GPU kullanımını nasıl optimize ettiğini, yönetişim ve kuota uygulamalarını nasıl sağladığını, ve AI iş yüklerini ekipler ve projeler arasında dinamik olarak nasıl planladığını öğreneceksiniz. Ayrıca, Azure Kubernetes Service ile olan kusursuz entegrasyonu, hibrit bulut ortamlarını desteklemesi ve küme, düğüm havuzları ve tam YZ yaşam döngüsünü yönetme araçlarını da ele alacağız. Sonunda, NVIDIA Run:ai‘nin YZ orkestrasyonunu nasıl basitleştirdiğini, performansı artırdığını ve ölçeklenebilir, maliyet etkin YZ operasyonlarına olanak tanıdığını göreceksiniz.

NVIDIA Run:ai ile AI iş yüklerini yönetmek

NVIDIA Run:ai, AI ve makine öğrenimi iş yüklerini yönetmek için özel olarak tasarlanmış Kubernetes yerel bir AI orkestrasyon platformudur. Dinamik, politika tabanlı GPU kaynaklarının zamanlaması için esnek bir katman sunar. Bu platform, GPU kullanımını optimize ederken, yönetişim, kuota ve iş yükü önceliklendirmelerini de sağlar.

Temel yetenekler arasında şunlar bulunur:

- Kesirli GPU tahsisi: Tek bir GPU’yu birden fazla çıkarım işi veya geliştirme ortamı arasında paylaşarak kullanımını artırır.

- Dinamik zamanlama: İş önceliği, kuyruklama ve erişilebilirliğe dayanarak, tam veya kesirli GPU’lar tahsis eder.

- İş yüküne duyarlı orkestrasyon: Eğitim, ayar ve çıkarım iş yüklerini maksimize etmek için farklı zamanlama politikaları farklı işler için belirler.

- Ekip bazlı kuotalar ve izolasyon: Adil pay veya garantili kuotalar kullanarak ekipler veya projeler için GPU kaynaklarını garanti eder.

- Birleşik AI altyapısı: Merkezi orkestrasyon, hibrit ve çoklu bulut ortamlarında yönetimi basitleştirir.

NVIDIA Run:ai’nin Azure’daki işleyişi

NVIDIA Run:ai, Microsoft’unGPU destekli sanal makine (VM) ailelerine sorunsuz bir şekilde entegre olarak, performansı optimize eder ve YZ iş yüklerinin yönetimini basitleştirir.

Azure, farklı ihtiyaçlara yönelik geniş bir GPU destekli VM ailesi sunmaktadır: NC ailesi, compute-intensive ve yüksek performanslı hesaplama (HPC) görevleri için optimize edilmiştir; ND ailesi, derin öğrenme ve YZ araştırmaları için özel olarak tasarlanmıştır; NG ailesi, bulut oyun ve uzaktan masaüstü deneyimleri için; NV ailesi ise görselleştirme, renderleme ve sanal masaüstü iş yüklerine odaklanır. Bu GPU destekli aileler, YZ, grafik ve simülasyon iş yüklerini hızlandırmak için gerekli esneklik ve performansı sağlar.

Bu VM’ler, T4, A10, A100, H100, H200 ve GB200 Grace Blackwell Süperçipi gibi NVIDIA GPU’ları kullanır. Birçok VM, yüksek hızlı NVIDIA Quantum InfiniBand ağı ile donatılmıştır ve bu da ileri düzey AI ve derin öğrenme uygulamaları için gereken düşük gecikme ve yüksek iletim performansını sağlar.

NVIDIA Run:ai, Azure’un bulut altyapısı ile yakından entegre olmuştur; bu da YZ iş yükleri için kesintisiz bir deneyim sunar. NVIDIA Run:ai, Azure Kubernetes Service (AKS)‘ı kullanarak çeşitli YZ projeleri arasında GPU kaynaklarını etkin bir şekilde yönetir ve sanalize eder.

Ayrıca NVIDIA Run:ai, büyük veri kümesi ve model depolama için Azure Blob Storage ile birlikte çalışarak, yerel ve bulut kaynakları arasında verimli veri erişimi ve aktarımı sağlar. Bu yakın entegrasyon, organizasyonların GPU kullanımını en üst seviyeye çıkarmalarını ve Azure’un güvenlik ve depolama özelliklerinden tam olarak faydalanmalarını sağlar.

Azure Kubernetes Service (AKS) ile AI iş yüklerini yürütmek

Azure Kubernetes Service (AKS), küme yönetimini ve ölçeklendirmeyi kolaylaştıran yönetilen bir Kubernetes ortamı sağlar. NVIDIA Run:ai, AKS’yi zenginleştirerek GPU kaynaklarını dinamik olarak yöneten akıllı bir orkestrasyon katmanı ekler. NVIDIA Run:ai ile AKS aracılığıyla, AI iş yükleri gerçek zamanlı önceliklere ve kaynak kullanılabilirliğine dayanarak planlanır. Bu, boşta kalan GPU süresini azaltır ve üretkenliği artırır.

Ekipler, AKS içindeki ad alanlarını ve kuota politikalarını kullanarak iş yüklerini izole edebilir, bu da adil erişimi ve yönetişimi güvence altına alır. Başlamak için bazı ipuçlarına göz atın.

Günümüz işletmeleri için hibrit altyapıyı destekleme

Kuruluşlar büyüdükçe ve AI iş yükleri karmaşıklaştıkça, birçok şirket yerel veri merkezleri ile Azure gibi bulut platformlarını birleştiren hibrit stratejiler benimsiyor. Bu yaklaşım, işletmelerin hassas iş yüklerini yerel olarak tutarken, diğer görevler için bulutun ölçeklenebilirliğinden ve esnekliğinden yararlanmalarına olanak tanır. Bu ortamlar arasında kaynakları etkili bir şekilde yönetmek, performans, maliyet ve kontrol dengesini sağlamak açısından kritik öneme sahiptir.

Deloitte ve Dell Technologies gibi şirketlerde, NVIDIA Run:ai kullanarak yerel altyapı ile bulut kaynaklarını karıştırmanın GPU kullanımını artırdığı ve veri merkezleri ile bulut ortamları arasında hesaplama kapasitesinin daha akıcı paylaşımına olanak sağladığı gözlemlenmiştir. Benzer şekilde, John Hopkins Üniversitesi gibi kurumlar da NVIDIA Run:ai kullanarak, iş yüklerini hem yerel hem de Azure’da çalıştırarak deneylerini daha verimli bir şekilde ölçeklendirmekte, GPU kaynaklarına olan bekleme sürelerini azaltmakta ve hızla tekrar deneme yapabilmektedir.

Microsoft Marketplace’te başlamaya hazır olun

NVIDIA Run:ai, Microsoft Marketplace’de özel bir teklif olarak mevcuttur. Özel liste, esnek dağıtım, özel lisanslama ve mevcut kurumsal anlaşmanıza sorunsuz entegrasyonu garantiler. Özel bir teklif talep etmek için:

- NVIDIA Run:ai sayfasını ziyaret edin ve “İle Başlayın” seçeneğine tıklayın.

- “NVIDIA Run:ai Hakkında Bize Ulaşın” formunu doldurun.

- Bir NVIDIA temsilcisi, size özel bir teklif oluşturmak için sizinle iletişime geçecektir.

- Öneri kabul edildikten sonra, AKS kümenizi NVIDIA Run:ai’e bağlamak için şu adımları izleyin:

- Bir Azure AKS kümesi oluşturun. Bunun için AKS belgelerine bakabilirsiniz.

- NVIDIA Run:ai kontrol düzlemini yükleyin.

- NVIDIA Run:ai kümesini yükleyin.

- NVIDIA Run:ai kullanıcı arayüzüne (UI) erişin.

NVIDIA Run:ai ile Azure’da başlamaya hazır olun

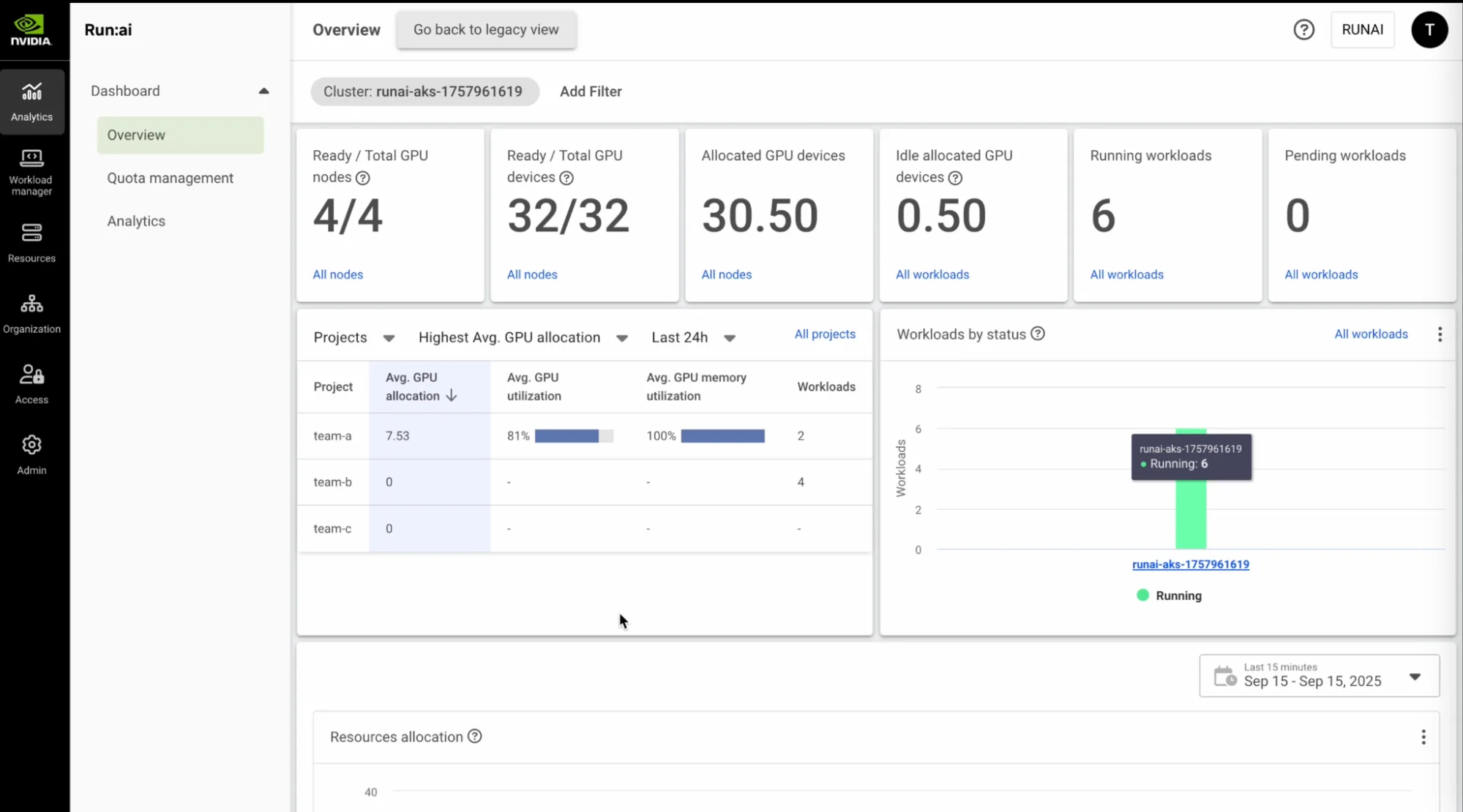

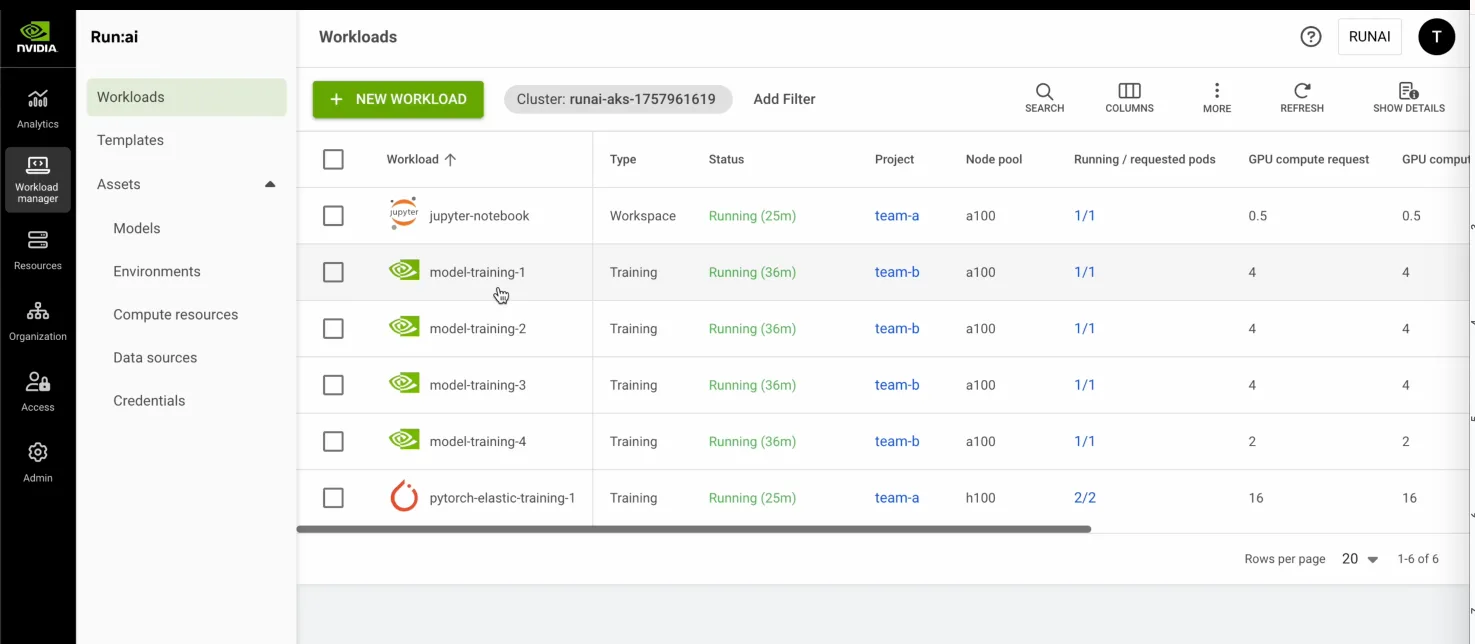

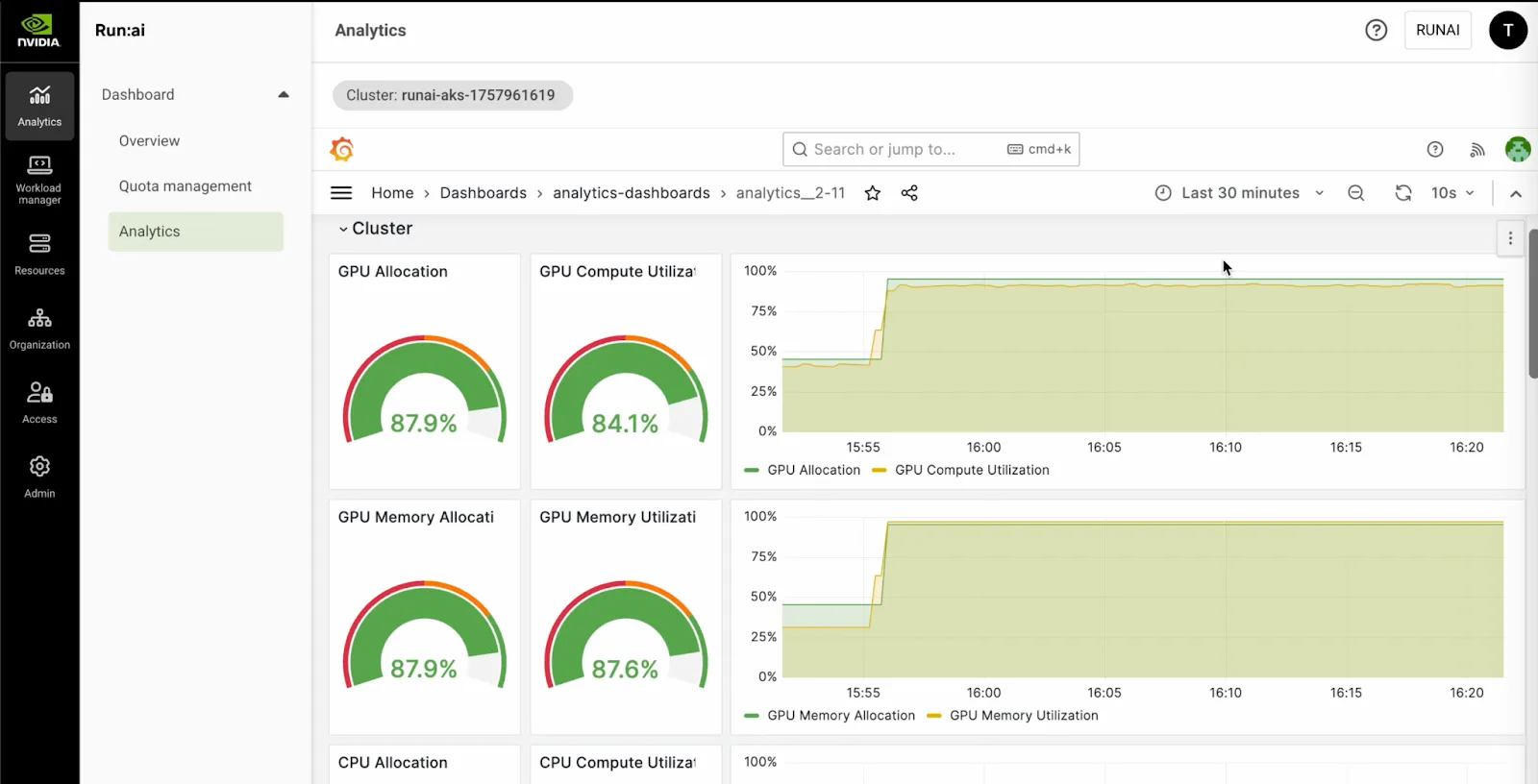

AKS kümesine hızlı bir bağlantı sağladıktan sonra, NVIDIA Run:ai sizlere tüm GPU kaynaklarının net ve kapsamlı bir görünümünü sunar. Gösterge paneli, küme sağlığına dair gerçek zamanlı içgörüler sunar; böylece GPU kullanılabilirliği, aktif iş yükleri ve bekleyen görevler gibi bilgileri görebilirsiniz. Örneğin, her biri sekiz GPU barındıran dört düğümden oluşan bir kümede, hangi GPU’ların boşta olduğunu veya kullanıldığını anında görebilirsiniz.

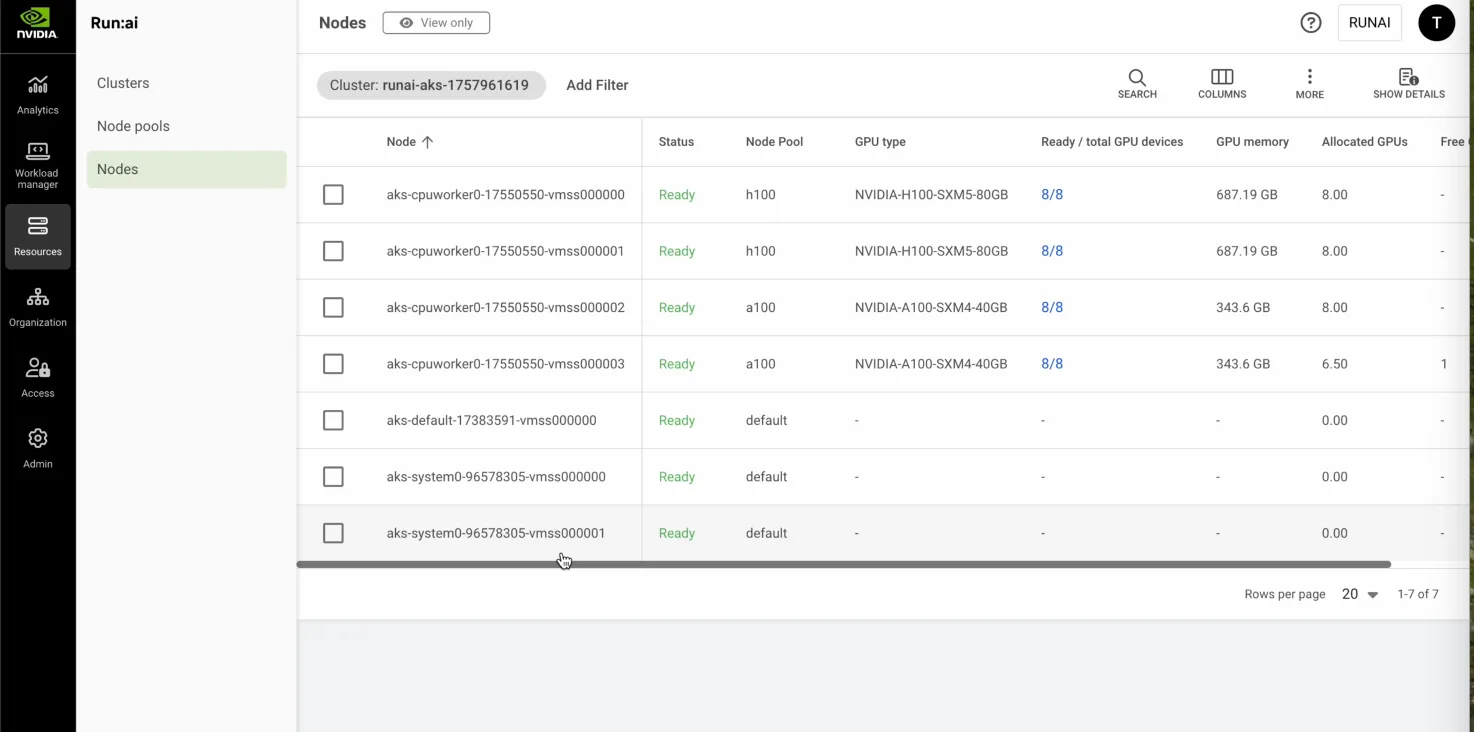

AKS kümenizi NVIDIA Run:ai kontrol düzlemine bağladıktan sonra, CPU ve GPU işçi düğümleri de dahil olmak üzere tüm düğümler için birleşik bir görünüm elde edersiniz. NVIDIA Run:ai, heterojen GPU ortamlarını destekleyerek aynı küme içinde A100 ve H100 gibi farklı GPU türlerini yönetme olanağı sunar.

Düğümler ve ekipler arasında GPU kaynaklarını optimize etme

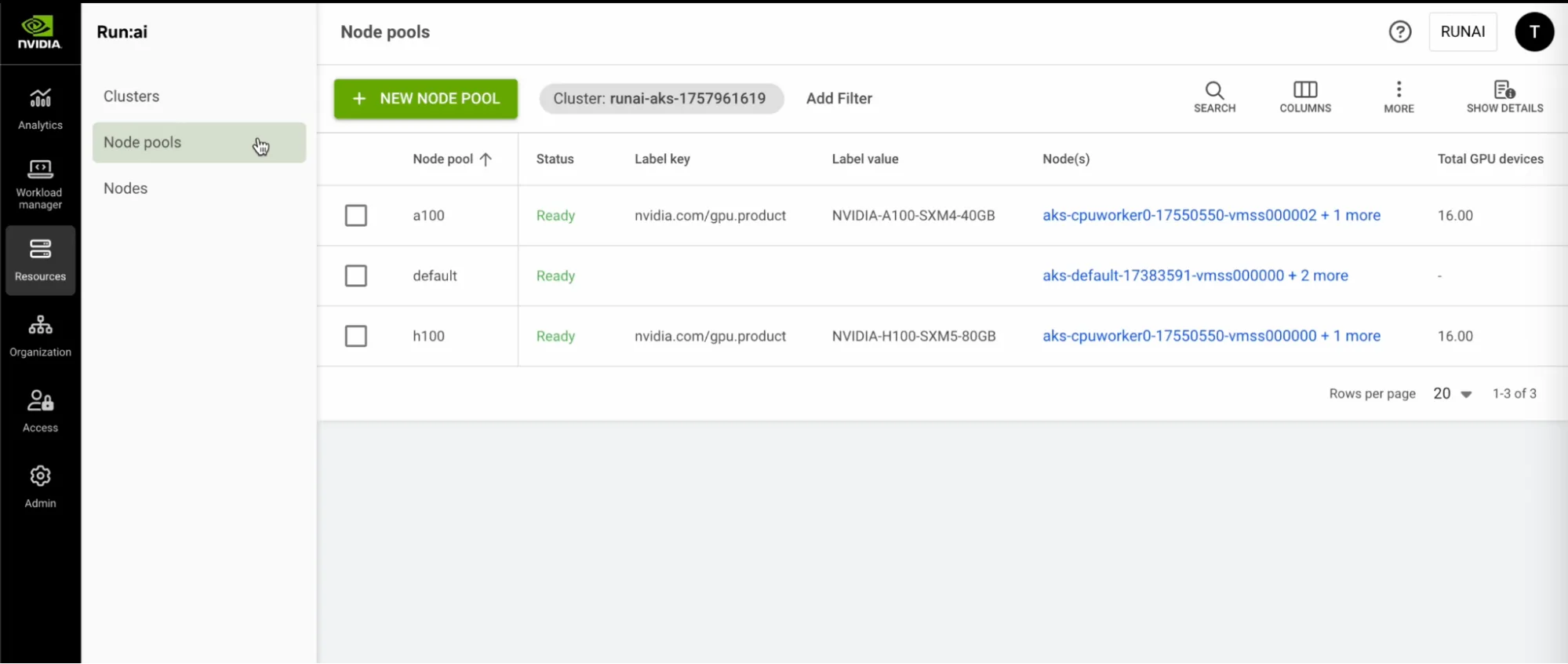

NVIDIA Run:ai, benzer düğümleri düğüm havuzlarına gruplayarak iş yüklerinin belirli bir bağlamda zamanlanmasını sağlar. Bu, görevlerin en uygun GPU veya makine türü ile eşleşmesini sağlar. Düğüm havuzları Azure ölçek setleri ile de uyumlu olabilir ve düğüm ekleyip çıkardıkça dinamik bir şekilde ayarlanabilir—bu, iş yüklerinizin gereksinimlerine esneklik sağlar.

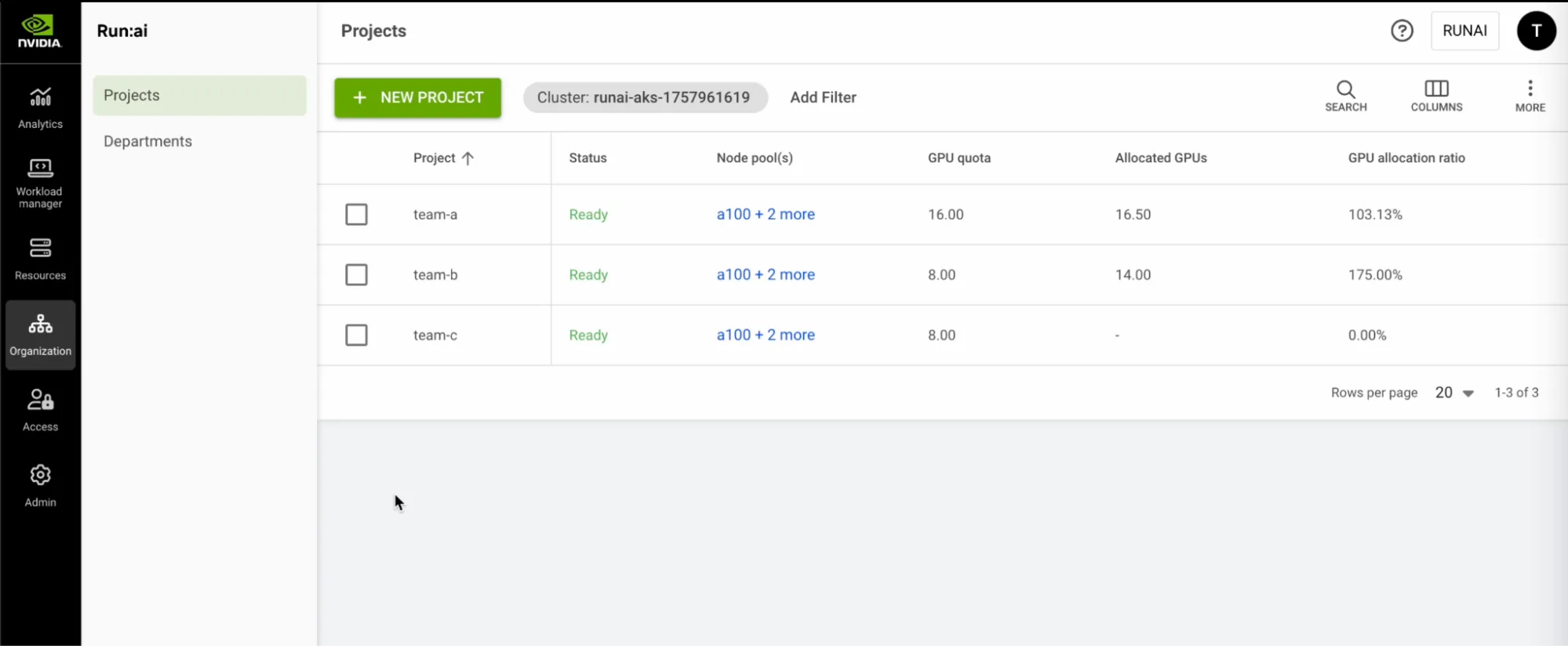

GPU kaynaklarını projeler ve kuotalar kullanarak ekipler arasında dağıtın ve kullanımını optimize edin. NVIDIA Run:ai, her ekip için, örneğin Ekip A, B ve C (şekil 5’te gösterilmiştir) için temel GPU kuotalarını garanti ederken, bazı iş yüklerinin bu limitlerin ötesine geçmesine izin verirken kaynak erişimini garanti eder. Zamanlayıcı, gerektiğinde iş yüklerini adil bir şekilde önceliklendirir.

YZ yaşam döngüsünü destekleme

NVIDIA Run:ai, etkileşimli Jupyter not defterlerinden tek düğümlü ve çok düğümlü eğitim işlerine kadar ve de çıkarım iş yükleri boyunca iş yüklerini yönetir. PyTorch Elastic gibi popüler çerçeveleri ayrı GPU havuzlarında çalıştırabilir veya modelleri Hugging Face ve NVIDIA NGC kapları üzerinden platformda yerel olarak dağıtabilirsiniz. NVIDIA Run:ai, dinamik, dağıtılmış çıkarım için NVIDIA Dynamo’yu da destekler; bu da kaynak kullanımını verimli hale getirir ve AI modellerinin çok sayıda GPU ve düğümde ölçeklenebilir dağıtımını sağlar.

NVIDIA Run:ai, gerektiğinde GPU kaynakları üzerinde yalnızca izleme yapmakla kalmaz, aynı zamanda farklı zaman dilimleri boyunca kullanım analizleri sunar. Bu sayede farklı ekipler veya iş birimleri arasında maliyet paylaşımı veya gösterim yapma yeteneği kazandırır. Bu içgörüler, IT ve yönetim ekiplerinin GPU altyapısını ölçeklendirirken bilgilerle dolu kararlar almalarını sağlar; böylece en iyi performans ve maliyet etkinliği sağlanır.

Sonuç

YZ benimsemesi arttıkça, verimli GPU yönetimi kritik hale gelir. NVIDIA Run:ai, Azure üzerinde güçlü bir orkestrasyon platformu sunarak GPU kaynak yönetimini basitleştirir ve YZ yeniliğini hızlandırır.

NVIDIA Run:ai‘nin akıllı zamanlayıcısı ile Azure’un ölçeklenebilir GPU altyapısını ve YZ araçlarını birleştirerek organizasyonlar, üretkenliği ve maliyet etkinliği artıran birleşik, kurumsal düzeyde hazır bir çözüm elde eder.

NVIDIA Run:ai’yi Microsoft Marketplace’te keşfedin ve YZ altyapı yönetimini basit hale getirerek YZ yolculuğunuzu hızlandırın.