Modern AI (Yapay Zeka) yükleri artık tek GPU (Grafik İşlemci) ile gerçekleşen çıkarım hizmetlerinin çok ötesine geçti. Model paralelliği, hesaplamaları birçok GPU arasında etkili bir şekilde ayırarak, ölçeklenebilir, en son teknoloji dağıtımların temelini oluşturuyor. En yüksek performanslı modeller, yalnızca bir token için eğitimli parametrelerin bir alt kümesini aktive eden mixture-of-experts (MoE) mimarilerini benimsemeye başladı. Ancak MoE’leri ölçeklendirmenin getirdiği karmaşık paralellik, iletişim ve zamanlama gereksinimlerinin dikkatlice optimize edilmesi gerekiyor.

Uzman paralelliği (EP), uzmanları birçok GPU arasında stratejik olarak dağıtarak bu zorlukların üstesinden gelmek ve ölçeklenebilir performansı açığa çıkarmak için önemlidir. DeepSeek-R1 gibi 256 uzman ve 671 milyar parametreye sahip modeller büyüdükçe, NVIDIA Tensor RT-LLM’nin Wide Expert Parallelism (Geniş-EP) gibi yeni araçlara ihtiyaç var. Bu, büyük ölçekli dağıtımı daha verimli hale getirerek hem performansı arttırıyor hem de toplam sahip olma maliyetini düşürüyor.

Bu blogda, büyük ölçekli EP’nin performansı nasıl etkilediğini ve NVL72 raf ölçeği alanındaki çıkarım ekonomisini nasıl yeniden şekillendirdiğini ele alacağız.

Geniş ölçekli uzman paralelliğini nasıl elde edersiniz?

Uzman paralelliği (EP), MoE modelinin uzmanlarını birçok GPU arasında dağıtan bir model-paralel tekniğidir. Küçük ölçeklerde, EP, iş yükünü cihazlar arasında dengeleyerek bellek üzerindeki baskıyı azaltmaya ve kullanımı yüksek tutmaya yardımcı olur.

DeepSeek-R1 gibi yüz milyarlarca parametreye ve yüzlerce uzmana sahip modeller büyüdükçe, bu tekniklerin kapsamının genişlemesi gerekiyor; bu, bizim büyük ölçekli EP olarak adlandırdığımız süreçtir. Bu blog için büyük ölçekli EP, uzmanları sekiz veya daha fazla GPU’ya dağıtma işlemine atıfta bulunur. Bu, daha hızlı ağırlık yükleme için toplam bant genişliğini artırır ve genel GPU kullanımını artırmak için daha büyük etkili batch boyutlarını destekler.

Büyük ölçekli EP’nin bellek ve hesaplama zorlukları nelerdir?

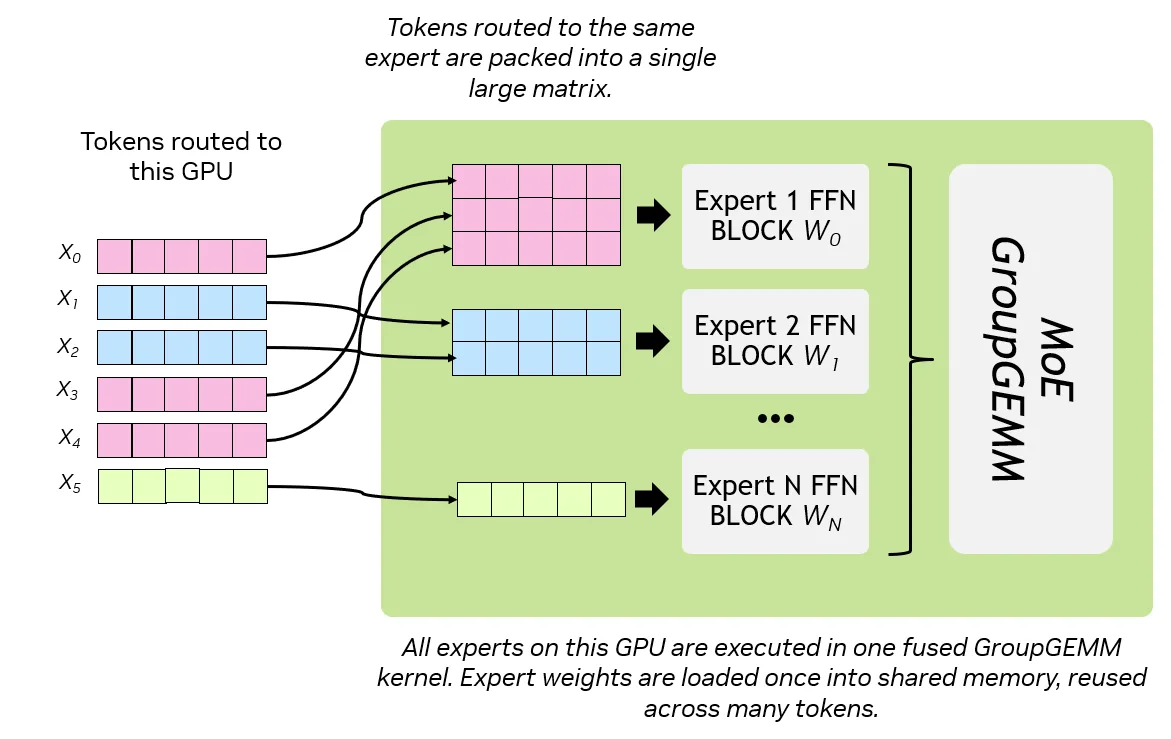

MoE modelleri, çıkarım sırasında yalnızca küçük bir uzman alt kümesini aktif hale getirme avantajını sunar; bu da her token için hesaplama gereksinimini önemli ölçüde azaltır. Bunu başarmak için, MoE’ler her bir token ve katman bazında aktif bir uzmanı yüklerler. Yüksek throughput ve gecikme kısıtlı senaryolarında, ağırlık yükleme gecikmesi hızlı bir şekilde MoE GroupGEMMs adı verilen belirli bir hesaplama süreci için büyük bir darboğaza dönüşebilir.

MoE GroupGEMMs, tüm tokenların aynı ödeme şeridine aynı anda gönderilmesi gibidir; böylece verimli bir batch içinde işlenebilirler. Pratikte, her bir uzman için tokenları gruplayarak tek bir büyük hesaplama işlemine dönüştüren matris çarpımlarıdır. Bu, aritmetik yoğunluğu artırır, ancak her bir uzmanın ağırlıklarını on-chip bellek/register’lara yüklemeyi gerektirir.

Büyük ölçekli EP, uzman paralel yapılandırmasına daha fazla GPU ekleyerek bazı MoE GroupGEMM darboğazlarının üstesinden gelir; bu da her bir GPU’da tutulan uzman sayısını etkili bir şekilde azaltır. Sonuçlar:

- Daha az ağırlık yükleme baskısı (her GPU’da daha küçük bir uzman ağırlıkları kümesi)

- GroupGEMM çekirdeği tarafından daha kolay ağırlık yeniden kullanımı (daha yüksek aritmetik yoğunluk—yüklenen ağırlıkların byte başına daha fazla FLOP)

- Çekirdek içinde daha iyi hesaplama/bellek dengesi

Büyük ölçekli EP, küçük ölçekli EP’nin sınırlamalarını aşmaya yardımcı olurken, büyük MoE’leri ölçeklendirmeyi zorlaştıran yeni sistem düzeyi kısıtlamalar da getirir. TensorRT-LLM Wide-EP, bu kısıtlamaları algoritmik olarak hedef alarak ve aynı zamanda sistem ve mimari düzeyinde iş yükü yönetimini ele alarak bu zorlukları aşmaya yardımcı olur.

Sistem tasarımı ve mimarisi nasıldır?

Uzman paralelliğini ölçeklendirmenin yolu sadece GPU eklemekten geçmez. Bellek hareketi ve iletişimi verimli tutacak sistem tasarımı ve mimarisi gereklidir. İnterkonekt bant genişliği ve topoloji, aktivasyonların ve ağırlıkların cihazlar arasında akışını sağlamak için temeli oluşturur.

Buna ek olarak, optimize edilmiş yazılım ve çekirdekler, uzmanlar arası trafiği yönetmek için iletişim primitifleri, bant genişliği farkındalığıyla zamanlama ve yük dengelemesi ile görev yapar. Birlikte bu yetenekler, büyük ölçekli EP’yi pratik ve verimli hale getirir.

Nvlink ile dağıtılmış uzman iletişim gecikmesini azaltmak

Büyük ölçekli EP’deki en büyük darboğazlardan biri iletişim gecikmesidir. Çıkarımın decode aşamasında, dağıtılmış uzmanların, sistemde birçok GPU boyutunda dağıtılmış çıktıları birleştirmek için bilgi alışveriş etmesi gerekmektedir. Örneğin, DeepSeek-R1’in 256 uzmanını 64 GPU’ya dağıtırken, her bir katmanda hangi uzmanların aktive edildiği ve ağırlıkların nerede bulunduğu iletişim maliyetini etkiler.

Büyük ölçekli EP, aktif uzmanlar için ağırlık yükleme gecikmesini azaltırken, bunlar token-gather kolektifleri tarafından toplanan dağıtılmış çıktıları birleştirme ve yeniden sıralama gereksinimi nedeniyle ortadan kalkabilir. NVL72’nin sağladığı 130 TB/s agregalı bant genişliği olmadan, bu iletişim deseninin karmaşıklığı ve yükü büyük ölçekli EP’yi pratik olmaktan çıkarırdı.

NCCL ile optimal uzman yönlendirmesi için çekirdekleri optimize etme

MoE’ler, her token için en uygun uzmanları dinamik olarak seçen bir yönlendirme mekanizması kullanır. Bu, her bir transformer bloğunun her bir token için dağıtım ve uzman katmanlarından geçtikten sonra agregasyon gerektirdiği anlamına gelir. İçinde bulunan tüm-all işlemleri, zaten bellek sınırına ulaşan decode aşamasını hızla doldurabilir.

Bu zorlukların üstesinden gelmek için özel EP iletişim çekirdeklerine ihtiyaç vardır. GB200 NVL72 için, birden fazla raf ölçeği dağıtım senaryolarıyla CUDA grafik uyumluluğunu ele almak için özel çekirdekler uyguladık. Öne çıkan, geniş ölçekli EP dağıtımları için statik olmayan veri boyutlarını işlemek üzere tasarlanmış yüksek performanslı NCCL çekirdekleridir. Bu özel EP çekirdekleri, iletişim boyutlarını GPU bellekinden doğrudan alarak NVL72’nin toplam belleğinden faydalanabiliyor.

Geniş uzmanları yük dengeleme

Yük dengeleme, kaynak mevcudiyetine göre işe atamalarda en yüksek kullanım oranlarını elde etmek ve sistemin herhangi bir bölümünü aşırı yüklememek için kullanılan klasik bir dağıtım sistemleri tekniğidir. Büyük ölçekli EP iş yüklerinde, yük dengelemesi mevcut GPU’lar arasında uzmanları dağıtmak için kullanılır. Örneğin, GB200 NVL72 rafında Geniş-EP DeepSeek-R1’i EP=64 (temiz bölünme için) çalıştırırken, her katmanda her GPU başına dört uzman dağıtacağız; toplamda her GPU için 232 uzman atanmış olacaktır.

Ayrıca, çok popüler “sıcak uzmanların” bir GPU’da toplanıp diğer GPU’ların “soğuk uzmanlarını” boşta bırakmasını önlemek için, Geniş-EP’nin Uzman Paralel Yük Dengeleyici (EPLB) politikası, sıcak uzmanları soğuk uzmanlarla yeniden dağıtmayı teşvik eder. Bu, uzmanların konteyner tahsisatlarına akışına izin veren konteynerize bir tasarım kullanılarak ele alınır; bu sayede CUDA grafiğini bozmadan gerçekleştirilebilir. Bu ağırlık güncellemeleri, ileri geçişler arasında zamanlayarak engellenmez şekilde gerçekleştirilir.

EPLB iki farklı modda çalışabilir:

- Statik EPLB: Tarihsel veri desenlerine dayalı olarak önceden hesaplanmış uzman-gpu atamaları kullanarak uzman tahsisatını optimize eder.

- Çevrimiçi EPLB: Gerçek zamanlı olarak değişen iş yükü desenlerine dinamik olarak uzmanları yeniden dağıtır.

Statik EPLB, statik olmayan bir EPLB yaklaşımına göre iyi bir temel iyileştirme sunarken, çevrimiçi EPLB gerçek zamanlı üretim sistemlerinde en yüksek yük dengeleme potansiyelini sağlar. Çevrimiçi EPLB’nin ilk uygulamasında, gerçek zamanlı ağırlık güncelleme süreçleriyle ilgili birkaç kritik zorluk keşfedip giderdik.

TensorRT-LLM ve NVIDIA Dynamo ile Geniş-EP

DeepSeek R1 veya Llama 4 gibi MoE modellerini ölçeklendirdiğinizde, çıkarım performansı iki temel unsura dayanır: dağıtılmış hizmet ve Geniş-EP. NVIDIA Dynamo ve TensorRT-LLM, her iki unsuru da destekleyen yazılım omurgasını oluşturur, geleneksel darboğazları aşarak muazzam throughput artışları ve etkili GPU kullanımı sağlar. Aşağıdaki tablo, Dynamo ve Geniş-EP arasındaki farkları ve sinerjileri özetlemektedir.

| Komponent | NVIDIA Dynamo | TensorRT-LLM Geniş-EP |

| Rol | Dağıtılmış çıkarım için orkestrasyon katmanı | Uzman-paralel kodlama için yürütme motoru |

| Optimizasyon Kapsamı | GPU havuzları arasında önceden doldurma & kod çözme aşamalarını orkestre eder | Per token bellek ve hesaplama kullanımını optimize etmek için her GPU’da küçük sayıda uzman dağıtır |

| SLA Farkındalığı | SLA’ya dayalı otomatik ölçekleme ve dinamik oran eşleme (TTFT & ITL) | Verimli uzman zamanlaması ile toplu işlemleri maksimize eder ve gecikmeyi en aza indirir |

| Trafik Uyumu | Dynamo Planlayıcısı aracılığıyla ISL/OSL dalgalanmalarına gerçek zamanlı olarak tepki verir | Hesaplama kullanımını optimize etmek için uzman tahsisatlarını yük dengelemektedir |

| Donanım Sinerjisi | Dağıtılmış GPU alanlarında Kubernetes + Planlayıcı mantığı ile ölçeklenir | Uzman iletişimini verimli hale getirmek için yüksek bant genişliğine sahip alanları (örn. NVL72) kullanır |

NVIDIA Dynamo ile büyük ölçekli uzman paralelliği arasındaki ilişkilere dair daha fazla bilgi için, NVIDIA Dynamo’nun nasıl kullanıldığına dair blog yazımıza göz atmanızı öneririz.

Performans ve iş yükü ekonomisi nedir?

NVLink ölçekleme ile oluşturulan tutarlı bellek alanına erişiminiz olduğunda, büyük ölçekli EP’yi optimize etmenin anahtar noktaları şunlardır:

- Model boyutu ve uzman sayısı: Daha az uzmana sahip daha küçük modeller, ağırlık yüklemesinin azaltılmasının ve dağıtılmış hesaplamanın avantajları, iletişim yüklemesi nedeniyle daha az fayda sağladıklarından Geniş-EP’den daha az kazanır.

- Sistem gecikmesi ve eşzamanlılık hedefleri: Büyük ölçekli EP, throughput’ü gecikmenin kısıtlı olduğu durumlarda en etkili şekilde çalışır, bu sayede iso-latency uygulamasında her GPU için daha fazla throughput sağlanır.

- Donanım yetenekleri: Toplam bellek bant genişliği, inter-GPU bant genişliği ve ulaşılabilir hesaplama miktarı, sistemin optimal paralellik derecesine ulaşmasını belirler.

Pratikte, DeepSeek-R1 gibi modeller büyük ölçekli EP için iyi adaylardır; burada TensorRT-LLM’nin Geniş-EP’sinin GB200 NVL72 raf ölçeği sistemlerinde en iyi verimlilik ve throughput dengesini sağladığı gözlemlenmiştir. Aşağıdaki Pareto sınırları, farklı EP konfigürasyonları arasındaki performansları vurgulamaktadır.

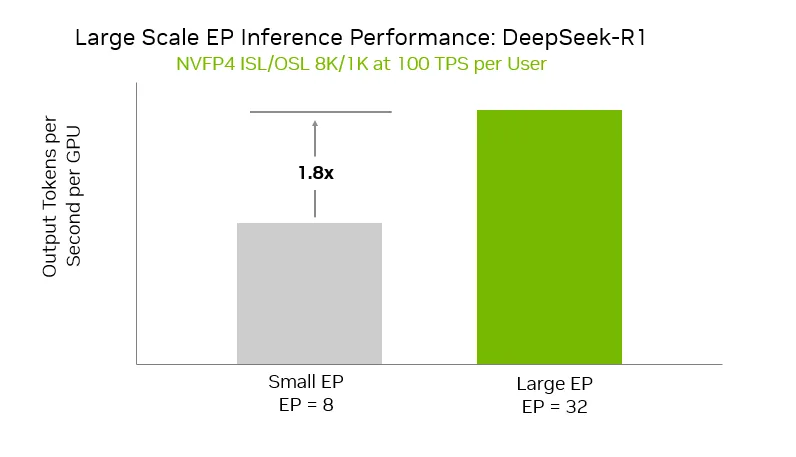

Küçük EP konfigürasyonuna (EP8) kıyasla, büyük EP konfigürasyonu (EP32) GPU başına %1,8 daha fazla throughput sağlıyor. Bu, büyük ölçekli EP ve Geniş-EP’den faydalanmanın performans artışı fırsatını vurguluyor. Ek olarak, spesifik dekodlama ile çoklu token tahmininin (MTP) kullanılma fırsatı, kullanıcı başına token throughput’unu artırmak için mevcut; bu işlev Geniş-EP ile zaten uyumludur.

Sonuç

GB200 NVL72 üzerindeki Geniş-EP, büyük MoE modellerini ölçeklendirmenin pratik bir yolunu sunmaktadır. Uzmanların daha fazla GPU’ya dağıtılması, ağırlık yükleme baskısını azaltmakta, GroupGEMM verimliliğini artırmakta ve NVL72’nin 130 TB/s koheren NVLink alanının sunduğu iletişim gecikmesini azaltmaktadır. Testlerde, büyük EP konfigürasyonları, daha küçük EP yapılandırmalarına göre %1,8 daha yüksek GPU başına throughput’a ulaşmıştır. Bu kazanımlar, throughput, gecikme ve kullanılabilirlik dengesini büyük ölçekli çıkarım için daha verimli hale getiriyor.

Daha geniş bir etki ise sistem ekonomisi üzerinedir. Daha yüksek eşzamanlılık ve daha güçlü GPU verimliliği sağlayarak, NVL72 üzerinde Geniş-EP, token/saniye/GPU oranlarını artırmakta ve büyük modellerin sunum maliyetini düşürmektedir. Geliştiriciler için bu, TensorRT-LLM içinde Geniş-EP’yi keşfetmek adına optimal konfigürasyonları bulmak anlamına gelmektedir. Araştırmacılar için, zamanlama, yük dengeleme ve dekodlama stratejilerini geliştirme alanı yaratmaktadır. Altyapı ekipleri için, GB200 NVL72’nin trilyon parametreli dağıtım maliyetini nasıl değiştirebileceğini vurgulamaktadır.

Daha fazla bilgi için, GB200 NVL72 ile büyük ölçekli EP’nin diğer sistem mimarilerine göre en düşük toplam sahip olma maliyetini sağladığını bulduğumuz en son InferenceMAX benchmarklarının göz atın.

Güncel performans bilgileri için NVIDIA Çıkarma Performans paneline göz atmayı unutmayın.