Veri Yükleme Sorunlarıyla Nasıl Baş edilir?

Yavaş veri yüklemeleri, bellek yoğun katmalar ve uzun süren işlemler – bunlar her Python kullanıcısının karşılaştığı sorunlardır. Bu problemler, değerli zaman kaybına yol açar ve fikirlerinizi geliştirmenizi zorlaştırır.

Bu yazıda, pandas kütüphanesinde yaygın olarak karşılaşılan beş darboğazı ele alacağız, bunları nasıl tanıyacağınızı göstereceğiz ve sisteminizdeki CPU ile bazı kod değişiklikleri yaparak deneyebileceğiniz çözümler sunacağız. Ayrıca, cudf.pandas isimli GPU destekli bir hızlandırıcı ile hiçbir kod değişikliği yapmadan müthiş hız artışları elde edebilirsiniz.

Makinenizde GPU yok mu? Sorun değil! Bu yazılımı Google Colab’da ücretsiz kullanabilirsiniz; burada GPU’lar mevcut ve kütüphane önceden yüklenmiş olarak geliyor.

Yavaş read_csv() Çağrıları mı Alıyorsunuz?

Ağrı noktası: Pandas’ta yavaş CSV ayrıştırmalarındaki sorun, analiz öncesinde iş akışınızı durdurabilir ve CPU kullanımı yükselebilir.

Nasıl Tanıyabilirsiniz: Büyük CSV dosyaları yüklenirken bu işlem dakikalar alabiliyor ve notebook’unuz tamamlanana kadar başka bir şey yapamazsınız—bu durum giriş/çıkış (I/O) yönünden tıkanmaya yol açar.

CPU Çözümü: Daha hızlı bir ayrıştırma motoru kullanmak gibi pd.read_csv("data.csv", engine="pyarrow") bir çözüm deneyebilirsiniz. Bu sayede pandas’ın varsayılan ayrıştırıcısından daha hızlı sonuç alırsınız. Ayrıca, veri yüklenmesini hızlandırmak için verilerinizi Parquet/Feather formatına dönüştürebilir, sadece gereken sütunları yükleyebilir veya parçalar halinde okuyabilirsiniz.

GPU Çözümü: NVIDIA cuDF ile pandas hızlandırıcısı sayesinde CSV dosyaları, GPU iş parçacıkları arasında paralel olarak yüklendiği için süreler çok kısalır.

Büyük Birleştirme İşlemleri Bilgisayarınızı Donduruyor mu?

Ağrı noktası: Pandas’ta büyük birleştirme işlemleri CPU’ya yoğun yük bindirerek çokça bellek tüketebilir, bu da not defterlerinizi dondurur ve makinenizin yavaşlamasına neden olur.

Nasıl Tanıyabilirsiniz: RAM kullanımı aşırı yükselir, fanınız hızlı çalışmaya başlar ve işlem dakikalar alabilir—özellikle on milyonlarca satırla çalışıyorsanız sorun daha belirginleşir.

CPU Çözümü: Birleşim işlemlerinde mümkünse indekslenmiş birleştirmeler ve gereksiz sütunların silinmesi, veri hareketini azaltabilir.

(Örnek Kod:

# Gereksiz sütunları sil

df1 = df1[['id', 'value']]

df2 = df2[['id', 'category']]

# Birleştirme anahtarları benzersizse indeks ayarlama

df1 = df1.set_index('id')

df2 = df2.set_index('id')

# İndeks üzerinde birleştirme

sonuç = df1.join(df2)

)

GPU Çözümü:cudf.pandas uzantısını yükleyip pandas’ı içe aktararak, birleştirme işlemleri, GPU iş parçacıkları arasında paralel olarak çalışır ve büyük veri setlerinde hızlı sonuç almanızı sağlar.

String-Ağırlıklı Veri Setleri Not Defterlerini Çökertiyor mu?

Ağrı noktası: Geniş nesne/string sütunları (özellikle milyonlarca karakter içerenler), bellek kullanımını artırarak her işlemi yavaşlatır. Yüksek kardinaliteye sahip sütunlar en büyük suçlulardır.

Nasıl Tanıyabilirsiniz: Nesne sütunları GB boyutlarına çıkıyor; basit işlemler bile yavaşlayabilir veya bellek hatalarına neden olabilir.

CPU Çözümü: Düşük kardinaliteye sahip string sütunlarını astype('category') ile dönüştürmek büyük hafıza tasarrufu sağlar. Yüksek kardinalite sütunlarını ise string olarak bırakmak daha faydalıdır.

GPU Çözümü:cuDF, string işlemlerini GPU optimizasyonları ile hızlandırarak, .str metotlarının hızlı çalışmasını sağlar. Tek değişiklik %load_ext cudf.pandas.

Gruplama İşlemleri Neden Bu Kadar Yavaş?

Ağrı noktası: Büyük veri setlerinde yapılan gruplama işlemleri, CPU’nuzu uzun süre meşgul edebilir. Bu da hızlı keşfi engeller ve analiz sürecinizi zorlaştırır.

Nasıl Tanıyabilirsiniz: CPU’nuzun bir çekirdeği (veya tüm çekirdekleri) tam kapasite çalışırken, RAM kullanımı artar ve pandas işlemi sırasında ilerleme hissi yok olur.

CPU Çözümü: Gruplama işlemlerinden önce veri setinizin boyutunu azaltın, kullanılmayan sütunları silin veya ilk olarak satırları filtreleyin.

GPU Çözümü:cuDF, gruplama işlemlerini binlerce iş parçacığı arasında dağıtarak, bu işlemleri milisaniyeler içinde tamamlayabilir. Tek yapmanız gereken %load_ext cudf.pandas komutunu kullanarak aynı pandas kodunu çalıştırmaktır.

Büyük Veri Setlerinde Bellek Sorunları mı Yaşıyorsunuz?

Ağrı noktası: Veri setiniz CPU RAM’inizden büyükse, bellek hataları alırsınız veya sadece küçük örneklerle çalışmak zorunda kalırsınız.

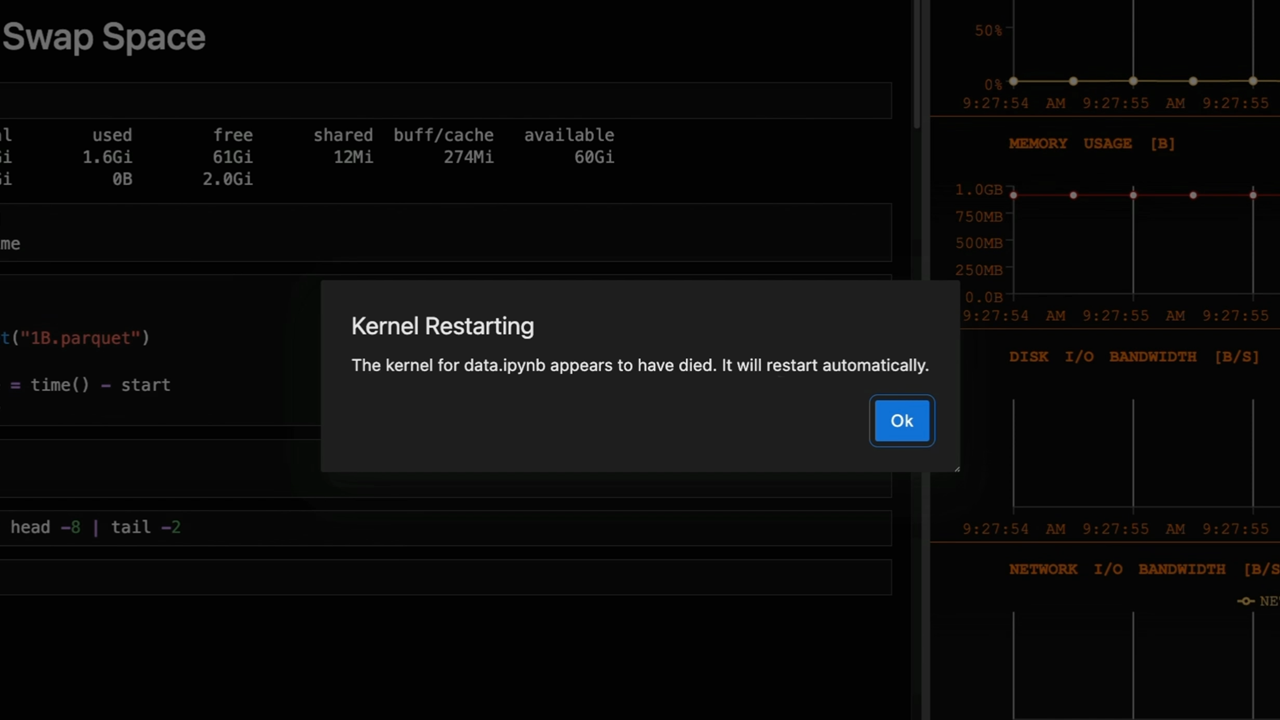

Nasıl Tanıyabilirsiniz: Python bellek hatası alabilir, kerneliniz yeniden başlayabilir veya tam veri setini yükleyemezsiniz.

CPU Çözümü: Bellek kullanımınızı azaltmak için sayısal türleri küçültebilir ve düşük kardinaliteye sahip string sütunlarını kategorilere dönüştürebilirsiniz.

GPU Çözümü:cudf.pandas uzantısı, GPU VRAM ile CPU RAM’ini bir araya getirerek GPU belleğinden daha büyük veri setlerini işlemenizi sağlar.

Çözüm: İş Akışlarını Hızlandırın

Öncelikle CPU ile mevcut en yaygın darboğazları gidermek için hızlı çözümleri deneyin. Eğer hâlâ performans sorunları yaşıyorsanız, GPU hızlandırıcısını devreye alarak müthiş hız artışları elde edebilirsiniz. Hatta tüm bu kütüphaneler önceden yüklenmiş olarak Google Colab’da ücretsiz GPU erişimi ile kullanımınıza sunulmaktadır.

Polars Kullanıyor Musunuz? Polars, bu tür veri çerçevesi performans zorluklarını aşmak için NVIDIA cuDF tarafından güçlendirilen GPU motorunu kullanarak birleştirme, gruplama, toplama ve I/O işlemlerinde de hızlı gelişmeler sağlayabilir. Böylece mevcut Polars sorgularınızı değiştirmeden benzer hız artışları elde edebilirsiniz.

Daha derin bir bilgi için, Acelesi Olan Veri Bilim Çalışmalarını Hızlandırmak için Zero Kodu Değişiklikleri isimli ücretsiz kursu kontrol edebilirsiniz.