2023 yılının başlarında 5G küresel bağlantılar sayısı neredeyse 2 milyara ulaştı ve 2028 yılına kadar 7.7 milyar seviyelerine ulaşması bekleniyor. 5G, daha hızlı hızlar, yüksek kapasite ve iyileştirilmiş gecikme süreleri sunarken, özellikle video ve veri trafiği için, ağ operatörlerine yeni gelirler sağlama vaadi ise henüz gerçekleşmiş değil.

Günümüzde çoğu mobil uygulama buluta yönlendirilmekte. Bu arada, geleneksel tasarımlara dayanan radyo erişim ağı (RAN) ve paket çekirdek çözümleri yazılım iyileştirmeleri ve daha verimli donanım ile aşamalı olarak gelişiyor. Ancak, bu tek amaçlı sistemler, özellikle ses, veri ve video iş yüklerini taşıyan sistemler, telekom şirketlerinin average revenue per user (ARPU) değerlerini önemli ölçüde artırmıyor. Bunun yerine, bu sistemler yalnızca bağlantıyı sağlamakta ve işletme giderleri olarak değerlendirilmekte; bu durum da yatırım getirisini azaltmakta. Fakat bu yaklaşımın değişmek üzere olduğuna dair işaretler var.

ChatGPT gibi yenilikler ve hızlı bir şekilde gelişen büyük dil modelleri (LLM), yeni nesil uygulama taleplerini karşılamak için hızlandırılmış hesaplama gerektiren bir tür uygulamanın ilk örneklerini sunuyor. İlk LLM uygulamaları genellikle merkezi bir yapıda ve büyük veri merkezlerine sıkı sıkıya bağlı olarak gerçekleştirilirken, bu, ağdan buluta doğru giden trafik hareketlerinde bir döngü yaratıyor.

AI Yüksek Hızlı Dağıtımı ve İhtiyaçlar

Görsel dil modelleri (VLM) ve küçük dil modelleri (SLM) ile birlikte LLM çıkarımı üzerindeki gelişmeler, verileri daha yakın bir uygulama mimarisi ile dağıtmak için uygundur. Generatif yapay zeka, ajans yapay zeka ve çok modlu yapay zeka yönelimi, ağ uçlarına çıkarım sürecinin daha yakın olması gerekliliğini doğuracak; zira işletmeler veri yerelleştirme, güvenlik ve belirlenmiş hizmet kalitesi (QoS) talepleri doğrultusunda hareket ediyor. Bu gereksinimler, mevcut telekom ağları tarafından da sunulmakta.

Miras İş Yükleri ile AI Çıkarma Trafiğinin Dengelenmesi

Merkezi bir hesaplama mimarisinden, generatif yapıya yönelik yüksek derecede dağıtık çıkarım yöntemine geçmek, gelecekteki ağlar üzerinde derin etkiler yaratacaktır. SLM, VLM ve LLM çıkarım trafiğindeki artış, ağda daha fazla veri akışıyla sonuçlanacaktır. Son noktalar, bazı talepleri karşılayacak şekilde gelişirken, cihazların işlem gücü, bellek ve enerji ile sınırlı olduğunu unutmamak gerekir.

Tüm ağ trafiğinin buluta yönlendirilmesi, geleneksel uygulamalarda olduğu gibi sorun teşkil etmekte; çünkü generatif yapay zeka modelleri, benzersiz ve gerçek zamanlı yanıtlar oluşturmak için veri taşımaktadır. Beklenen tüketici ve kurumsal çıkarım taleplerinin toplamı, yoğun bir veri boru hattı yaratacaktır.

Çevik Çıkarma Hizmetleri Desteklemek

NVIDIA ve yapay zeka ekosistemi, daha hafif ve çevik çıkarım hizmetleri oluşturma konusunda kararlıdır. Bu hizmetler, her yerde çalışabilen konteynerler olarak geliştirilmiştir; yük dengelemesi, zamanlama ve çeşitli şekillerde birleştirme yapılması mümkündür. Dağıtılabilir konteynerler, generatif yapay zeka modellerinin veriye daha yakın olmasını sağlamakta ve retrieve-augmented generation (RAG) yöntemiyle çalışmaktadır.

Ağ, AI konteynerlerini neredeyse her yerde destekleyebilir. AI ajanları ve daha küçük modeller, model tabanlı yönlendirme ile yeni bir LLM türüne yol açacaktır; burada model ağırlıkları ve ağ içgörüleri, hangi modelin nerede gerektiğini ve bu modellere gelen trafiği nasıl yönlendireceğini belirlemekte kullanılacaktır.

AI Yerel Ağ Altyapısı İhtiyacı

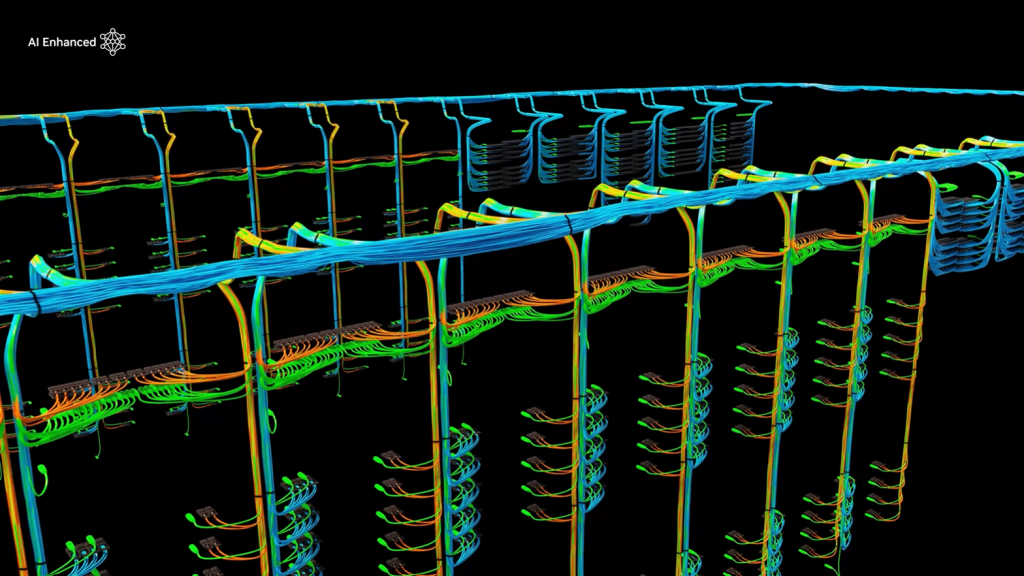

Günümüzdeki telekom ağları genellikle her biri için tek amaçlı ve donanım odaklı çözümler kullanmaktadır. Dağıtılmış Birim (DU) ve Merkezileştirilmiş Birim (CU), her biri ayrı kutularda öngörülmekte; güvenlik duvarları ayrı bir kutuda, Kullanıcı Uç Fonksiyonu (UPF) ise yine ayrı bir kutuda yer almaktadır. Bu birimlerin birbirine bağlanmasında çoğu durumda optimizasyon sağlanmamaktadır.

Yazılım tanımlı iş yükleri kullanmak, bu sorunun çözümünde ilk adımdır. Eğer her uygulama yazılım tanımlı olursa, uygulamalar optimizasyon yapılmış konteynerlerde çalışabilir ve her yerde yer alabilir.

Generatif yapay zeka ortamı ve LLM’lerin ortaya çıkışı, tam yığın hızlandırılmış hesaplama platformları gerektirmekte. Bu AI yerel ağ altyapısı, ölçeklenebilir ve çok çeşitli standart uygulamalarla uyumlu bir şekilde kullanılabilir. Teorik olarak, aynı altyapı yazılım tanımlı herhangi bir uygulamayı barındırabilir ve talebe göre dinamik bir şekilde paylaşılabilir, böylece AI yerel, programlanabilir ve çok amaçlı ağlar oluşturulabilir.

Yüksek performans ve yeni gelir fırsatları, telekom şirketleri için önemli bir fırsat sunmaktadır. AI çıkarım süreci hızla ilerlemekte; telekom şirketleri, hesaplama altyapılarını en üst düzeye çıkartma ve gelirlerini artırma gerekliliği ile bu değişimlere ayak uydurmalıdır.

Telekom şirketleri, kendi altyapılarını paraya dönüştürmek için şu adımları atabilir:

- Kimyasal cihazlardan daha güçlü, düşük güç tüketen CPU’lar ve yeterli DPUs ile ağlarının kaldırabileceği yapılar geliştirmek.

- Sınır bölgelerini belirleyip, AI uyumlu hızlandırılmış hesaplama altyapısıyla donatmak. Bu, büyük bir yatırım gerektirmemekte ve telekom şirketlerine AI destekli çözümleri hedef alacakları müşteri segmentlerine ulaşma fırsatı sunmaktadır.

- İç ve dış kullanımlar için veri merkezinde hızlandırılmış hesaplamaya dayalı bir küme inşa etmek, hem iç ekiplerin hem de müşteri kullanım durumlarının ihtiyaçlarını karşılamak üzere veri kullanmayı sağlamak.

Sonuç

LLM destekli uygulamalar ve yapay zeka yükleri son hızla ilerlerken, telekom şirketleri ağlarını AI trafik yönetimine göre yeniden düşünmelidir. NVIDIA, yazılım sağlayıcıları ve ortaklarıyla iş birliği yaparak AI iş yüklerini haritalandırma, yazılım tanımlı bir modele geçiş yapma ve hızlandırılmış hesaplama mimarisi üzerinde optimizasyon sağlama konularında çalışmaktadır. Ayrıca, telekom şirketleriyle küresel ilerlemeleri paylaşmak, yenilik projelerinde iş birliği yapmak ve yeni ortakları sürece davet etmek amacıyla yakın iş birliği yürütmektedir.

AI optimize edilmiş ağ yapıları hakkında mehr bilgi için NVIDIA Enterprise Reference Architectures sayfasını ziyaret edebilirsiniz.