Üretken yapay zeka, insanların fikirlerini hayata geçirme şeklini devrim niteliğinde değiştirmiştir. Etkin yapay zeka, bu teknolojik evrimdeki bir sonraki adımı temsil etmektedir. Gelişmiş, otonom akıl yürütme ve yinelemeli planlama yöntemlerini kullanarak, AI ajanları karmaşık ve çok adımlı problemleri etkileyici bir verimlilikle çözebilir.

Yapay zekanın endüstrileri dönüştürmeye devam etmesiyle birlikte, AI modellerinin yerel olarak çalıştırılmasına olan talep artmıştır. Yapay zeka geliştirirken veya tüketirken, yerel olarak çalıştırmak birçok avantaj sunar; bunlar arasında artan gizlilik, azalan gecikme süreleri ve çevrimdışı çalışma yeteneği bulunmaktadır.

Yerel yapay zeka, organizasyonların yapay zeka geliştirme ve dağıtım yaklaşımlarını değiştirmektedir. Verilerin yerel olarak işlenmesi, geliştiricilerin sürekli bulut kullanımının maliyetlerini düşünmeden AI denemelerine ve prototiplerine devam etmelerini sağlar. Yerel yapay zeka, yenilikçi fikirlerin test alanı haline gelirken, bulut altyapıları daha yoğun iş yükleri ve büyük ölçekli dağıtımlar için kullanılmaya devam eder.

Yerel Yapay Zekanın Faydaları

Yerel yapay zeka, özellikle belirli endüstri kullanım durumlarının gereksinimlerine yanıt verme konusunda da önemli faydalar sunar. Örneğin, sağlık sektöründe, güvenli hasta verisi analizi ve hızlı teşhis imkanları sağlar. Finans kurumları, gerçek zamanlı dolandırıcılık tespiti ve risk değerlendirmesi için bu teknolojiyi kullanır. Üretim sektöründe ise, anlık kalite kontrol ve öngörücü bakım avantajları sağlar.

Donanım Gereksinimleri

Bu avantajlardan en iyi şekilde yararlanmak için kullanıcıların donanımlarının, özellikle de GPU’larının, yeterli olduğundan emin olmaları gerekiyor. GPU bellek boyutu, yerel olarak çalıştırabileceğiniz modelin boyutu ve karmaşıklığı üzerinde doğrudan etkilidir. Modelin boyutu büyüdükçe, bellek ihtiyacı da artar.

GPU bellek boyutunu hesaplamak için, öncelikle iki temel kavramı anlamak önemlidir: parametreler ve hassasiyet.

Parametreler ve Hassasiyet Arasındaki Denge

Parametreler, bir modelin davranışını belirleyen öğrenilen değerlerdir. Bunu, bir yapay zekanın sahip olduğu bilgi olarak düşünebilirsiniz. Örneğin, bir dil modelinde parametreler, kelimeler ve kavramlar arasındaki ilişkileri anlamasına yardımcı olur. Ne kadar çok parametra sahipse, o kadar karmaşık desenleri anlaması mümkün olur; ancak bu, daha fazla bellek de gerektirir.

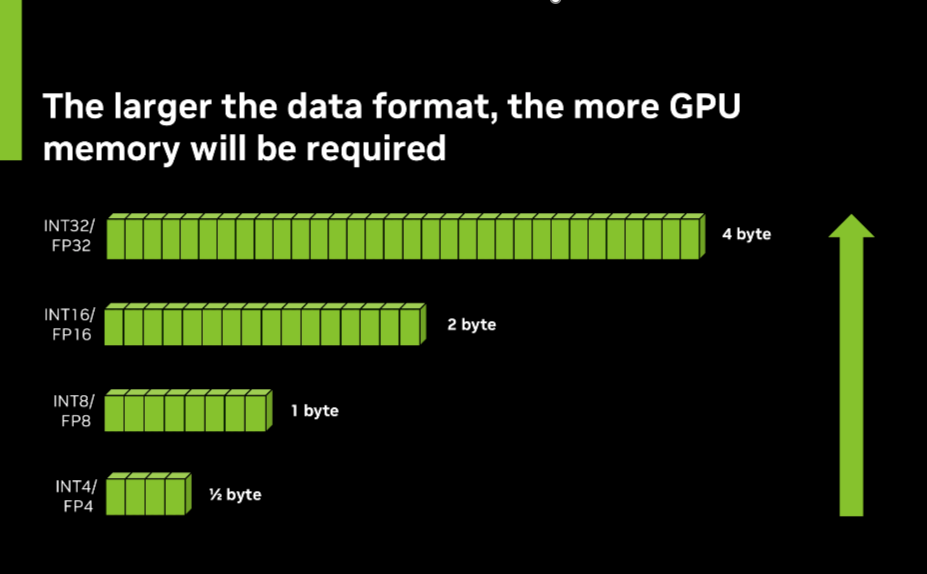

Hassasiyet, bu parametrelerin bellek içinde depolanırken ne derece detay içerdiğini ifade eder. Yüksek hassasiyet (32-bit veya FP32 gibi), daha yüksek sayısal doğruluk sunarken daha fazla bellek ve hesaplama kaynağı gerektirir. Düşük hassasiyet (16-bit veya FP16 gibi) ise alan tasarrufu sağlarken, bazı küçük detayları kaybetme riski taşır.

Gerekli toplam bellek, bir modelin sahip olduğu parametre sayısına ve her bir parametrenin depolandığı hassasiyete bağlıdır. Parametre sayısının artırılması, modelin zekasını artırabilir; ancak bu, bellek ihtiyacını da artıracaktır. Diğer yandan, düşük hassasiyet bellek tasarrufu sağlar, fakat modelin yeteneklerini biraz azaltabilir.

GPU Belleği Hesaplama

Gerekli GPU belleğini tahmin etmek için, öncelikle parametre sayısını bulmalısınız. Bunun için NVIDIA NGC kataloğuna giderek model adını veya model kartını kontrol edebilirsiniz. Birçok model, adlarında parametre sayılarını içerir; örneğin, GPT-3 175B, 175 milyar parametre anlamına gelir.

Sonrasında, bir önceden eğitilmiş modelin hassasiyetini belirlemek için model kartını inceleyebilirsiniz. FP32 (32-bit kayan nokta) genellikle eğitim için veya maksimum doğruluğun kritik olduğu durumlarda tercih edilir. Için, en yüksek sayısal hassasiyeti sunar ancak daha fazla bellek ve hesaplama kaynağı gerektirir.

FP16 (16-bit kayan nokta) ise, özellikle NVIDIA RTX GPU’ları üzerinde daha iyi bir performans ve doğruluk dengesi sağlayabilir. Bu format, FP32’ye göre eğitim ve çıkarımda %100 oranında hız artışı sunar.

INT8 (8-bit tamsayı), kenar cihazlarında ya da hız ve verimliliği önceliklendiren durumlarda sıklıkla kullanılır. FP16’ya göre %400’e kadar bellek kullanımında iyileştirme ve %200 daha iyi hesaplama performansı sağlayabilir. Bu sebeple, kaynak sınırlı ortamlarda kullanılmak üzere idealdir.

FP4 (4-bit kayan nokta) ise, AI uygulamalarında giderek daha yaygın hale gelen yeni bir hassasiyet formatıdır. Bellek taleplerini ve hesaplama gereksinimlerini büyük ölçüde azaltırken, makul bir doğruluk sağlamada önemli bir adımı temsil eder.

Model kartını incelerken, “hassasiyet”, “veri formatı” veya “kuantizasyon” gibi terimler arayın. Bazı modeller, birden fazla hassasiyet formatını destekleyebilir veya performansı ve doğruluğu optimize etmek için farklı formatları birleştiren karma hassasiyet yaklaşımları kullanabilir.

Gerekli GPU bellek miktarını kabaca hesaplamak için, parametre sayısını parametre başına bayt (FP32 için 4, FP16 için 2) ile çarparak sonra bu rakamı iki katına çıkarmanız gerekir. Örneğin, 7 milyar parametreli bir model için FP16 hassasiyeti ile yaklaşık 28 GB GPU belleği gerekecektir (7 milyar x 2 bayt x 2).

NVIDIA RTX GPU’ları, modelleri yerel olarak çalıştırmak için gereken yüksek performansı sunar. NVIDIA RTX 6000 Ada Nesli ile up to 48 GB VRAM sağlayan bu GPU’lar, büyük ölçekli AI uygulamaları için yeterli bellek sunar. Ayrıca, RTX GPU’ları, AI hesaplamalarını hızlandıran özel Tensor Cores içerir; bu da onları yerel AI geliştirme ve dağıtımı için ideal hale getirir.

Yapay Zeka Ayak İzini Kuantizasyon ile Azaltma

Daha az bellek kapasitesine sahip GPU’larda daha büyük modeller çalıştırmak isteyen geliştiriciler için, kuantizasyon teknikleri büyük bir avantaj sunabilir. Kuantizasyon, modelin parametrelerinin hassasiyetini düşürerek bellek gereksinimlerini önemli ölçüde azaltırken çoğu modelin doğruluğunu korur. NVIDIA TensorRT-LLM, modelleri 8-bit veya hatta 4-bit hassasiyete kadar sıkıştırabilen gelişmiş kuantizasyon yöntemleri sunar.

Başlarken

Yapay zekanın günlük yaşamımıza entegre olmaya devam etmesiyle birlikte, güçlü iş istasyonlarında modelleri yerel olarak çalıştırma yeteneği giderek daha önemli hale gelmektedir. AI yeteneklerinizi NVIDIA RTX tabanlı AI iş istasyonları ile NVIDIA AI Workbench kullanarak başlatabilirsiniz. Bu da oyun, içerik üretimi ve daha pek çok alanda yeni olanaklar sunar.

Daha fazla bilgi edinmek için RTX AI iş istasyonlarının yerel AI eğitimi ve özelleştirilmesinde nasıl kullanılabileceğini keşfetmek üzere, PNY ve NVIDIA ile “NVIDIA AI Platform ve Hızlandırılmış Çözümler ile AI Eğitiminizi Maksimize Etme” webinarsına kaydolabilirsiniz.