iOS 18.2 beta sürümünün bir parçası olarak sunulan yeni bir özellik, Avustralya’daki çocukların Apple’a doğrudan uygunsuz içerik bildirmelerine olanak tanıyor.

Apple, Güvenlik Önlemlerini Genişletiyor

Apple tarafından sunulan bu özellik, iOS 17’nin içinde bulunan güvenlik önlemlerinin bir uzantısıdır. Bu önlemler, iMessage, AirDrop, FaceTime ve Fotoğraflardan çıplaklık içeren görüntüleri ve videoları otomatik olarak algılar.

Çocuklar Doğrudan Bildirim Yapabilecek

Başlangıçta, çıplaklık algılandığında, bir çift müdahale penceresi ortaya çıkardı. Bu pencereler, yetişkinlere başvurmanın yollarını açıklar ve çocuğa bir ebeveyne veya vasılaya haber verme talimatı verirdi.

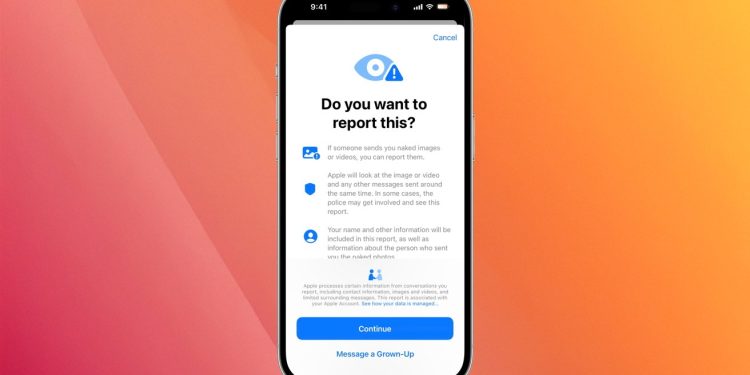

Şimdi, çıplaklık algılandığında, yeni bir bildirim penceresi belirecek. Kullanıcılara, görüntüleri ve videoları doğrudan Apple’a bildirme olanağı tanınacak ve Apple, bilgileri yetkililere iletebilecektir.

Uyarı belirdiğinde, kullanıcının cihazı, herhangi bir saldırgan materyali, materyalden hemen önce veya sonra gönderilen mesajları ve her iki hesabın iletişim bilgilerini içeren bir rapor hazırlayacaktır. Kullanıcılara ne olduğunu anlatan bir form doldurma seçeneği verilecektir.

Küresel Olarak Yayılacak Bir Özellik

Rapor aldığında Apple içerikleri gözden geçirecek. Ardından, şirket hesap üzerinde işlem yapabilir, kullanıcının iMessage üzerinden mesaj gönderme yeteneğini devre dışı bırakabilir ve sorunu kolluk kuvvetlerine bildirebilir.

Bu özellik şu anda Avustralya’da iOS 18.2 beta sürümü olarak sunuluyor ancak daha sonra küresel olarak yayılacak.

The Guardian açıklamasında, Apple’ın 2024 yılının sonuna kadar bulut mesajlaşma servislerinde çocuk istismarını ve terör içeriğini denetleme şartını getiren bir yasayı uygulamak için Avustralya’yı seçtiğini belirtiyor.

Apple, taslak kodun uçtan uca şifrelemeyi korumayacağını önceden belirtti, böylece kullanıcı iletişimlerinin geniş kapsamlı gözetimlere karşı savunmasız kalacağını belirtti. Apple, bu tür çabalarına karşı 2018’in sonlarından bu yana kayıtlarda.

Apple, platformlarındaki Çocuk Cinsel İstismar Materyali (CSAM) ile başa çıkma şekliyle eleştirilere maruz kaldı. Başlangıçta, şirket CSAM korumasını ciddiye almadığı suçlamasıyla karşı karşıya kaldı ve birçok denetim kuruluşunu kızdırdı.

2021’de Apple, kullanıcıların iCloud Fotoğraflarını bilinen CSAM görüntüleri açısından tarayacak CSAM korumalarını hayata geçirmeyi planladı. Eğer bulunursa, görüntü Apple tarafından incelenecek ve ardından bir rapor Kayıp ve Sömürülmüş Çocuklar Ulusal Merkezi’ne (NCMEC) gönderilecekti.

Birçok kullanıcı, Apple’ın özel görüntülerini ve videolarını tarayacağı fikrinden kızgındı ve yanlış tespitlerden endişe ediyordu. Apple, verileri taramanın “veri hırsızlarının bulup istismar etmek için yeni tehdit vektörleri yaratacağı” korkusundan vazgeçti.

2024’te, İngiltere Ulusal Çocuk İstismarını Önleme Derneği (NSPCC), Apple platformlarında küresel olarak rapor edilenin üzerinde İngiltere’de kötüye kullanım görüntüleri bulduğunu belirtti.