Yüksek performanslı bilgi edinme gerektiren uygulamalar, arama motorları, bilgi yönetim sistemleri, AI ajanları ve AI asistanları gibi birçok alanda yer almaktadır. Bu sistemler, kesin içgörüler sunmak, kullanıcı deneyimlerini geliştirmek ve ölçeklendirme yeteneğini korumak için doğru ve hesaplama açısından verimli geri alma süreçlerine ihtiyaç duyar. Geri alma ile zenginleştirme (RAG), sonuçları zenginleştirmek için kullanılır; ancak etkinliği, temel geri alma mekanizmalarının doğruluğuna bağlıdır.

RAG tabanlı sistemlerin işletim maliyetleri, iki ana faktör tarafından yönlendirilmektedir: hesaplama kaynakları ve altoptimal geri alma doğruluğundan kaynaklanan hata maliyetleri. Bu zorluklarla başa çıkmak için geri alma süreçlerinin optimize edilmesi gerekmektedir; bu, performanstan ödün vermeden sağlanmalıdır. Bir yeniden sıralama (reranking) modeli, geri alma doğruluğunu artırarak genel harcamaları azaltmaya yardımcı olabilir. Fakat, yeniden sıralama modellerinin potansiyeline rağmen, bu modeller geçmişte karmaşıklık endişeleri ve bilgi geri alma iş akışlarındaki marjinal kazançlar nedeniyle yeterince kullanılmamıştır.

Bu yazıda, NVIDIA’nın NeMo Retriever yeniden sıralama modelindeki önemli performans iyileştirmelerini ortaya koyarak, günümüz iş akışlarında hesaplama ilişki puanlarının rolünü yeniden tanımladığını göstereceğiz. Detaylı kıyaslamalarla, maliyet-performans dengelerini vurgulayacak ve hafif uygulamalardan kurumsal düzeyde dağıtımlara kadar geniş bir yelpazeyi karşılayan esnek yapılandırmaları sergileyeceğiz.

Yeniden Sıralama Modeli Nedir?

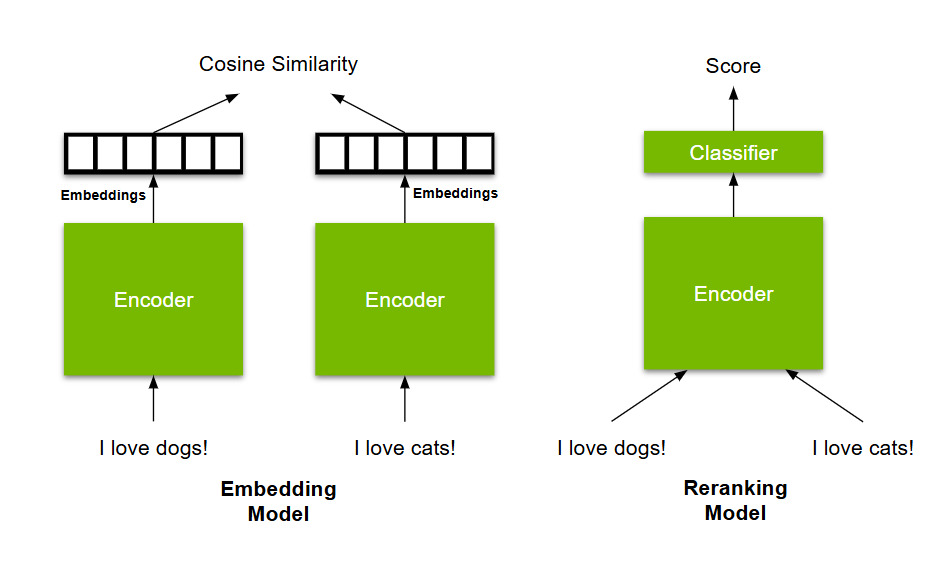

Yeniden sıralama modeli, genellikle bir reranker veya çapraz kodlayıcı (cross-encoder) olarak adlandırılan, iki metin parçası arasında bir ilişki puanı hesaplamak üzere tasarlanmış bir modeldir. RAG bağlamında, bir yeniden sıralama modeli, bir pasajın belirli bir sorguya olan alaka düzeyini değerlendirir. Sadece her bir pasaj için bağımsız anlamsal temsiller üreten ve alaka düzeyini belirlemek için sezgisel benzerlik metriklerine (örneğin, kosinüs benzerliği) dayanan yaklaşımların aksine, yeniden sıralama modeli, sorgu-pasaj çiftini aynı model içerisinde karşılaştırır. Bu, her bir pasaj için bir anlamsal temsil oluşturur ve ardından alaka düzeyini ölçmek için bir sezgisel ölçüt kullanır.

Yeniden sıralama modelleri, sorgu ve pasaj arasındaki örüntüleri, bağlamı ve paylaşılan bilgileri aynı anda analiz ederek daha detaylı ve doğru bir alaka değerlendirmesi sağlar. Bu nedenle, çapraz kodlayıcılar, bir embedding model ile sezgisel bir puan kullanmanın ötesine geçerek alaka düzeyini daha doğru bir şekilde tahmin edebilir; bu da onları yüksek hassasiyetli geri alma iş akışlarının kritik bir bileşeni haline getirir.

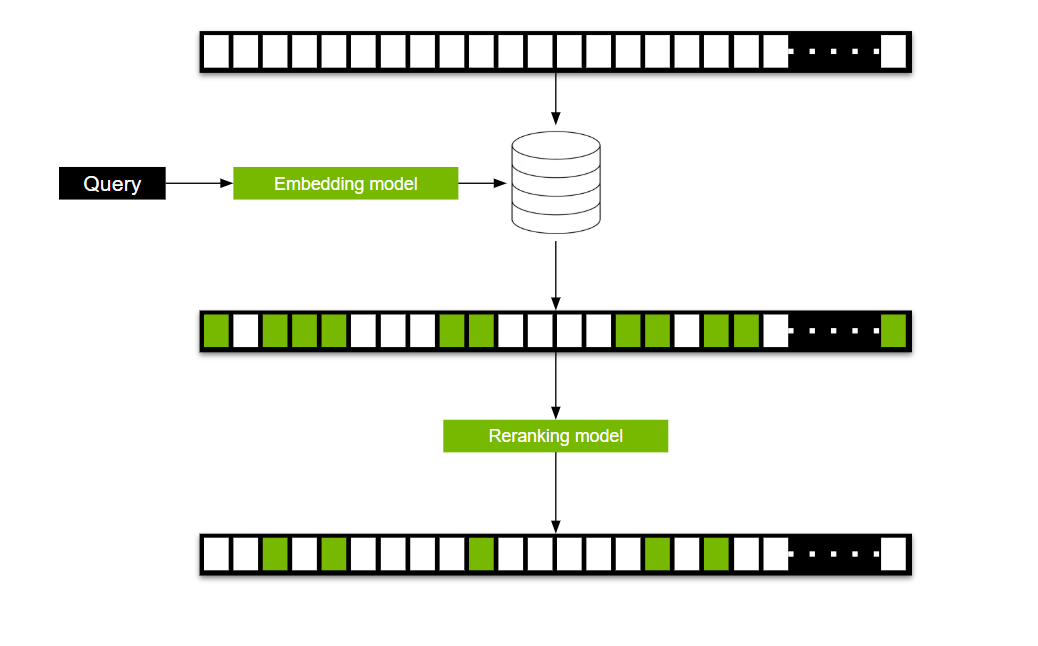

Bir çapraz kodlayıcı kullanarak, tüm korpusta her sorgu-pasaj çifti için bir ilişki puanı üretmek hesaplama bakımından maliyetli olabilir. Bu sorunu aşmak için, çapraz kodlayıcılar tipik olarak iki aşamalı bir süreçte kullanılır.

İlk aşamada, bir embedding modeli, sorgunun anlamsal temsilini oluşturur; bu temsil daha sonra milyonlarca olası adaydan daha küçük bir alt küme, genellikle onlu gruplara daraltmak için kullanılır. İkinci aşamada, çapraz kodlayıcı modeli, bu kısıtlı adayları işler, yeniden sıralar ve son olarak yüksek ilgili bir dizi üretir – genellikle sadece beş pasajdan oluşur. Bu iki aşamalı iş akışı, verimlilik ve doğruluk arasında bir denge kurarak, yeniden sıralama modellerini vazgeçilmez kılar.

Yeniden Sıralama Modelleri RAG’yi Nasıl İyileştirebilir?

Bir büyük dil modelinin (LLM) çalıştırılması, bir embedding veya yeniden sıralama modeline göre önemli ölçüde daha pahalıdır. Bu maliyet, bir LLM’nin işlediği token sayısıyla doğru orantılı olarak artar. Bir RAG sistemi, en yüksek N adet ilgili bilgiyi getirirken, genellikle 3-10 arasında bir aralıkta, ardından bu bilgileri temel alarak bir cevap üretmek için bir LLM kullanır. N’nin artırılması genellikle maliyet ve doğruluk arasında bir denge kurmakla ilgilidir. Daha yüksek bir N, geri alıcının en alakalı bilgi parçasını dâhil etme olasılığını artırırken, aynı zamanda LLM adımının hesaplama masraflarını da artırır.

Geri alıcılar genellikle embedding modellerine dayanır; ancak bir yeniden sıralama modelinin bu süreçte yer alması üç potansiyel fayda sunar:

- Doğruluğu maksimize ederken, RAG’nın çalıştırılması için gereken maliyeti yeterince azaltarak yeniden sıralama modelini karşılayabilir.

- Doğruluğu korurken, RAG için gereken maliyetle birlikte önemli ölçüde azaltabilir.

- Doğruluğu artırır ve RAG’nın çalıştırılması maliyetini düşürebilir.

Peki, bir yeniden sıralama modeli bu sonuçları nasıl elde edebilir? Anahtar, iki aşamalı geri alma sürecinin etkili kullanılmasındadır. İkinci aşamada yeniden sıralama için kullanılan aday sayısının artırılması, doğruluğu artırır. Ancak, bu aynı zamanda maliyeti artırır; bununla birlikte, LLM’ye kıyasla maliyetler marjinaldir. Örneğin: bir Llama 3.1 8B modeli, beş parça işlemek ve bir cevap üretmek için yaklaşık 75 kat daha fazla maliyet gerektirirken, NVIDIA NIM mikro hizmetleri ile oluşturulan NeMo Retriever Llama 3.2 yeniden sıralama modeli çok daha düşük maliyetle çalışmaktadır.

Yeniden Sıralama Modeli İstatistikleri

Premis anlaşıldıktan sonra, bu bölüm performans kıyaslamalarına odaklanacaktır. Aşağıdaki üç terimi anlamak önemlidir:

- N_Base: Bir RAG iş akışında yeniden sıralama olmadan kullanılan parça sayısı (Temel Durum).

- N_Reranked: Yeniden sıralama ile bir RAG iş akışında kullanılan parça sayısı.

- K: Yeniden sıralama sürecinde sıralanan aday sayısı.

Bu üç değişkenle, tüm senaryoların temelini oluşturan üç denklem formüle edilebilir:

- Denklem 1:N_Reranked <= N_Base

- Denklem 2:RAG_Savings = LLM_Cost(N_Base) – (Reranking_Cost(K) + LLM_Cost(N_Reranked))

- Denklem 3:Accuracy_Improvement = Reranking_Accuracy_Boost(K) + Accuracy(N_Reranked) – Accuracy(N_Base)

RAG’nın Çalıştırılması Maliyetini Yeterince Azaltarak Doğruluğu Maksimize Etmek

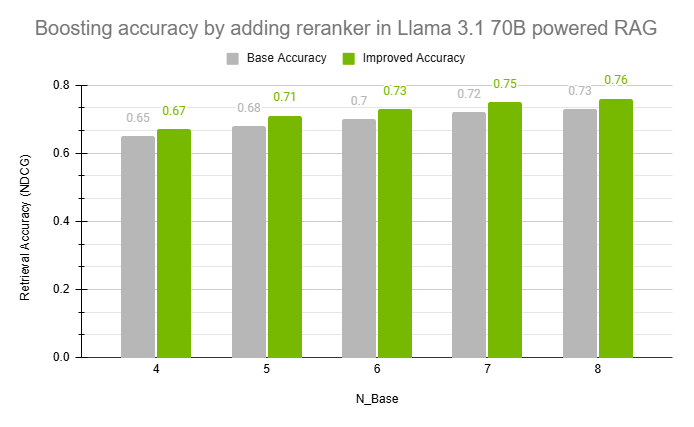

Bu senaryonun amacı, RAG tasarruflarını sıfıra indirirken, doğruluk iyileştirmelerini en üst düzeye çıkarmaktır. Bu nedenle Denklem 2’de K’yı ve N_Reranked’ı maksimize edelim ve belirli bir N_Base için bu maksimize işlemlerini Denklem 3’ü dikkate alarak yapalım. NVIDIA NIM’den elde edilen değerleri yerine koyarak sonuçları Şekil 3’te özetlenmiştir. Temel Doğruluk, N_base sayıda parça ile çalışan iş akışının doğruluğudur; İyileştirilmiş Doğruluk ise N_base-1 parçayı ve bir yeniden sıralama modelini kullanarak elde edilen doğruluktur.

Doğruluğu Korurken RAG’nın Çalıştırılması Maliyetini Azaltmak

Bu senaryonun amacı, doğruluğu olumsuz etkileyemeden maliyet tasarruflarını maksimize etmektir. Denklem 1’de, RAG tasarruflarını maksimize etmek için belirli bir N_Base için K ve N_Reranked’ı minimize etmemiz gerekir. Bunu yapmak için, doğruluk iyileşmesini sıfıra ayarlayın ve N_Base parçaları ile çalışırken doğruluğu eşleştirmek için K ve N_Reranked’ı dengeleyin. Bu dengelemenin sonuçları Şekil 4’te gösterilmiştir.

Doğruluğu Artırırken RAG’nın Çalıştırılması Maliyetini Düşürmek

Önceki iki senaryo, bir slider ölçeğinde iki uç noktadır. Bir uç nokta, maliyet düşürme amacına yönelikken, diğer uç nokta doğruluğun artırılmasıdır. Kullanıcılar, iki uç arasında denge sağlamak için parça sayısını artırıp azaltabilir ve yeniden sıralanacak parça sayısını ayarlayabilir.

NVIDIA NeMo Retriever ile RAG Sistemlerinizi Güncelleyin

Yeniden sıralama modelleri, yalnızca bir seçenek değil, aynı zamanda RAG iş akışlarına dönüştürücü bir ekleme olup, verimlilik ve hassasiyetin yeni seviyelerini açmaktadır. NVIDIA NeMo Retriever yeniden sıralama NIM mikro hizmetleri, maliyet azaltımı ve doğruluk iyileştirmesi konularında önemli faydalar sunarak paradigmaları yeniden tanımlamaktadır. Kıyaslamalar, %21.54 gibi dikkat çekici bir maliyet tasarrufu sağladıklarını ortaya koymaktadır.

Yeniden sıralama modeli yapılandırmalarının esnekliği, geliştiricilerin maliyet etkinliği ile performans kazançları arasında ideal dengeyi kurmalarına olanak tanır; bu da farklı kullanım durumları ve ölçeklenebilirlik taleplerine hitap eder. Bu faydalar, esas olarak RAG’nin üretim maliyetlerini azaltmakla ilişkilidir. Bu maliyet düşüşü, LLM’nin cevap oluşturmak için işlemesi gereken giriş token sayısını azaltmaktan kaynaklanmaktadır.

Bu sonuçlar, yeniden sıralama modellerinin marjinal iyileştirmelere sahip olduğu ve ek karmaşıklık getirdiği yönündeki eski algıyı sorgulamakta ve bugünün makine öğrenimi iş akışlarını optimize etmedeki önemli rollerini vurgulamaktadır.

NeMo Retriever Llama 3.1 yeniden sıralama NIM mikro hizmetini kullanarak RAG sisteminizi güncellemek için hemen build.nvidia.com‘da deneyin. Ayrıca kendi iş akışınızı oluşturmak için bir başlangıç noktası olarak NVIDIA AI Blueprint for RAG‘ye erişebilirsiniz.

2025 NVIDIA GTC etkinliğine katılarak verileriniz içindeki hızlı ve doğru içgörüleri açığa çıkaran en son geri alma iş akışları ve ajanatik teknikleri keşfetmek için bize katılın. İlgili oturumlara göz atın:

- NVIDIA Kurucusu ve CEO’su Jensen Huang ile GTC 2025 Açılış Konuşması

- Kurumsal Veri Platformunu Generatif AI ve RAG ile Dönüştürme [S72205]

- Multimodal Ajanik AI Geri Alma Sistemleri Nasıl Oluşturulur? [S72208]

- Ajanik ve Geri Alma İş Akışları Oluşturmak için En İyi Uygulamalar ve Teknikler [CWE72181]: En zor veri işleme ve geri alma zorluklarınızı paylaşın ve NVIDIA uzmanlarıyla birebir çalışma fırsatını yakalayın.