Büyük dil modellerinin (LLM’ler) yükselişiyle birlikte, derin öğrenme hem model mimarisi tasarımında hem de hesaplama verimliliğinde önemli adımlar atmaktadır. Mikrosantral eğitim, hesaplama gereksinimlerinin yoğun olduğu işlemler için brain floating point 16 (BF16) gibi daha düşük hassasiyet formatlarını kullanırken, gerektiğinde 32-bit floating-point (FP32) stabilitesini korumayı amaçlayan bir strateji olarak öne çıkmaktadır. Daha düşük hassasiyet sayısal formatların benimsenmesi, hızlı hesaplama ve azalan bellek kullanımı vaat ederken, model doğruluğundan da ödün vermemektedir. Artık, floating-point 8 (FP8) gibi daha ince ayrıntılı sayısal formatların araştırılması, önemli ölçüde daha fazla verimlilik sunma potansiyelini taşımaktadır.

Peki, FP8 nasıl çalışır ve onu bu kadar etkili kılan nedir? Bu blog yazısında, FP8 eğitiminin temel unsurlarını — faydalarını, zorluklarını ve yaygın uygulama yöntemlerini — inceleyeceğiz. Ayrıca FP8’i destekleyen donanım mimarilerine de değinecek ve gerçek dünya başarı hikeleri ile yararlı kaynaklar paylaşacağız.

FP8 Formatının Açıklaması

Modern LLM’ler, hesaplama verimliliği ile sayısal stabiliteyi dengeleyen hassasiyet formatlarına ihtiyaç duymaktadır. BF16 uzun süredir verimli sinir ağı eğitiminde standart olarak kullanılsa da, FP8’in tanıtımı, derin öğrenme iş akışının farklı aşamalarının özel taleplerine ince ayar yapılmış yeni formatlar sunmaktadır.

FP8 eğitiminin hız ve verimliliğindeki önemli bir etmen, NVIDIA H100 mimarisi içindeki özel FP8 Tensor Core’ların varlığıdır.

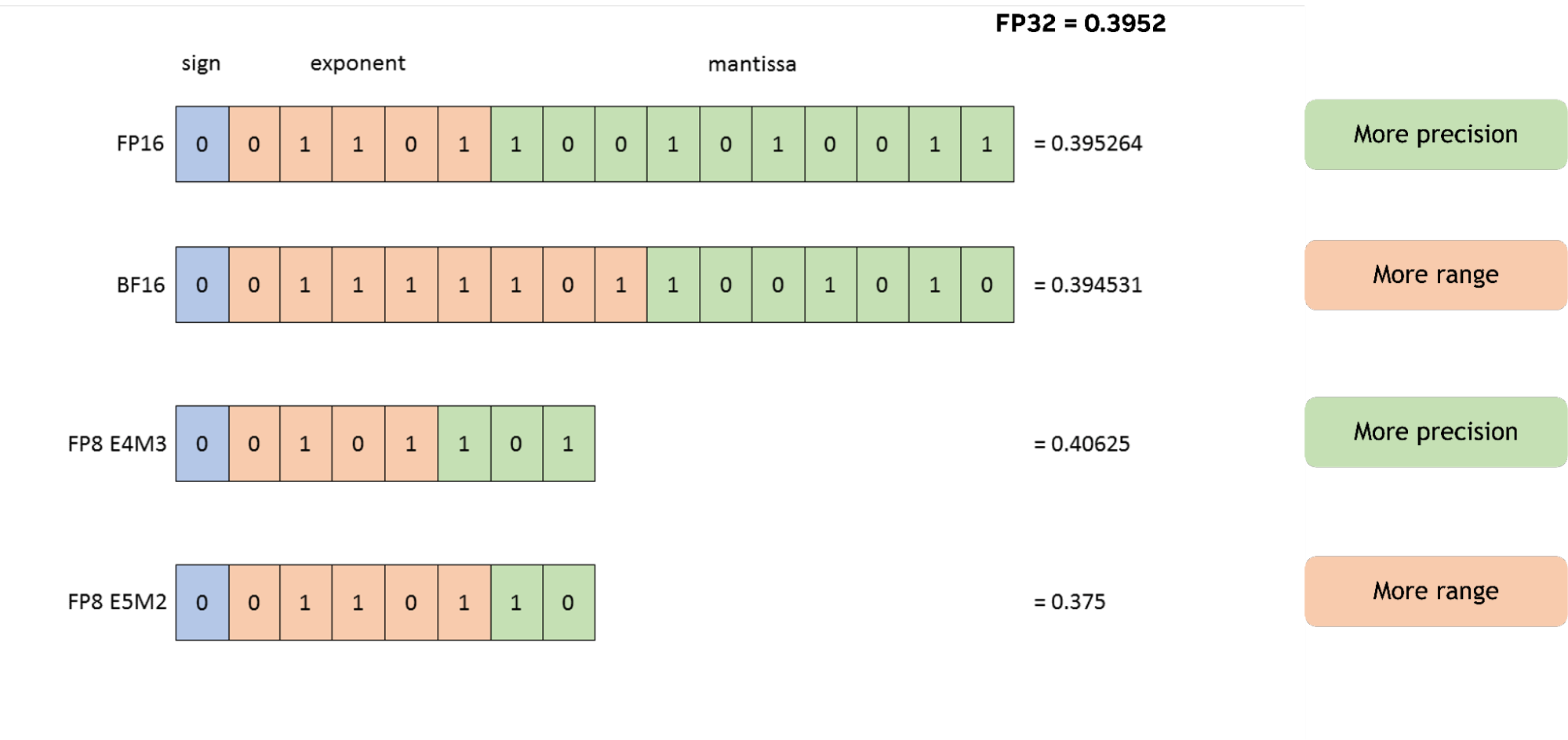

FP8, iki farklı varyanta ayrılır:

- E4M3, 4 üssü ve 3 mantissa biti ile daha fazla doğruluk sunarak, ağırlıkların ve aktivasyonların daha ince değerlerden faydalandığı ileri taşımalar için öncelik vermektedir. ±448’lik yaklaşık bir aralık sağlayarak, NaN (tanımsız) temsili ile birlikte çoğu katman çıktısının taşmasını önlemektedir.

- E5M2, 5 üssü ve 2 mantissa biti ile daha geniş bir dinamik aralık (±57,344, ±inf, nan) sunarak geri dönüşümlerde kritik bir rol üstlenmektedir. Bu daha geniş aralık, gradyanların büyüklüklerindeki önemli varyasyonları temsil etmek için gereklidir.

BF16’nın 8 üssü ve 7 mantissa biti, 1e-38 ile 1e38 arasında muazzam bir dinamik aralık sunarak, ağırlıkların, aktivasyonların ve gradyanların dağılımlarını temsil etmesini sağlamakta; FP8’in çift veri formatı (E4M3: yaklaşık ±448, ve E5M2: ±57344) ile birlikte ayrı ölçek faktörleri kullanma yeteneği, BF16’ya kıyasla donanım verimliliğini artırmaktadır.

FP8’in Tam Sayı Formatlarından Üstün Olma Nedenleri

8-bit tam sayı (INT8) kullanmak bellek tasarrufu sağlasa da, sabit nokta doğası nedeniyle önceden tanımlanmış ölçek faktörlerine ihtiyaç duyar. Bu da aktivasyon ve gradyanların, transformer mimarileri içinde sıkça görülen öngörülemeyen ve genellikle aşırı dinamik aralıklarını karşılama konusunda zorluk çıkarır; bu da kesme ya da önemli kuantizasyon gürültüsüne neden olabilir.

FP8 gibi kayan nokta formatları, her bir sayının kendi örtük “ölçeğini” üssü ile belirleyerek bu durumu aşmaktadır. Örneğin, dikkat mekanizmalarındaki geniş dinamik aralıkta (neredeyse sıfırdan binlerce değere) üssü yükseltilmiş skorlar, INT8’in sabit ölçeklemesi ile büyük hatalar yaratabilmektedir. Ayrıca, yüz milyonlarca veya milyarlarca parametreye sahip derin sinir ağlarında gradient geçişi, FP8’in sayısal üssü ile kolayca temsil edilebilen aşırı değerler üretebilirken, INT8 formatları böyle geniş bir dinamik aralıkla mücadele etmekte zorlanır.

NVIDIA Blackwell Mikroscale Formatlarını Tanıtıyor

Son NVIDIA Blackwell GPU mimarisi, FP8’den daha düşük hassasiyetli sayısal formatları destekleyen donanım desteğini genişletmektedir. Bu, FP4 ve FP6 gibi daha hassas alt FP8 formatlarını içermekte, ayrıca FP8 Blackwell Tensor Core’larını da geliştirmektedir.

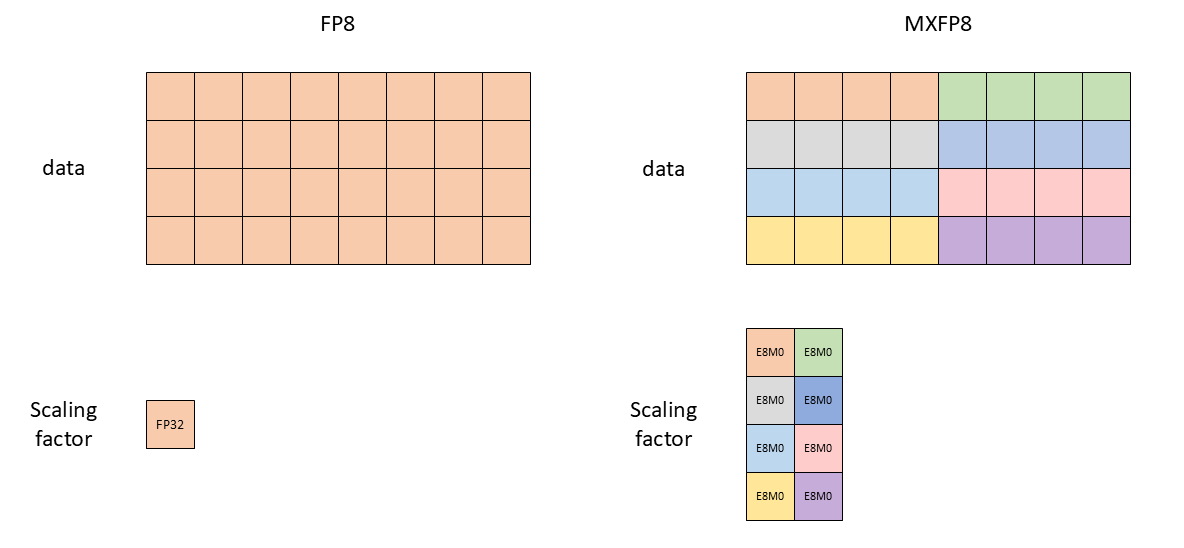

Standart FP8 ile MXFP8 arasında temel fark, ölçekleme mekanizmasının ayrıntılı yapısıdır. Geleneksel FP8, tüm bir tensör boyunca tek bir FP32 ölçek faktörü uygular; bu durum, geniş dinamik aralıklara sahip tensörlerin temsil doğruluğunu sınırlayabilir ve genellikle gradyanlar için daha düşük hassasiyetli E5M2 formatını kullanma gerekliliği doğurabilir. Buna karşın, NVIDIA Blackwell MXFP8, blok düzeyinde bir ölçekleme stratejisi uygular. Özellikle, bir tensör içerisindeki 32 değerlik bir blok, ayrı bir ölçek faktörü ile tanımlanır ve bu işlem GPU’nun Tensor Core’ları tarafından yerel olarak gerçekleştirilir.

Bu hassas ölçekleme, kuantizasyon hatalarını azaltarak, tensörün farklı segmentlerinin FP8 dinamik aralığıyla daha iyi hizalanmasını sağlar ve bu sayede hem yüksek hem de düşük büyüklükteki bileşenlerin korunmasına yardımcı olur. Bu geliştirilmiş kontrol, daha geniş bir tensör türleri yelpazesi boyunca daha yüksek çözünürlükte E4M3 formatının benimsenmesini sağlar.

Konsantrasyon ve Hızlanma

FP8 eğitimi gibi kuantizasyon teknikleri, LLM’lerin hem eğitimini hem de çıkarımını önemli ölçüde hızlandırabilir. Bunun nedeni, tensör değerlerini temsil etmek için gereken daha az bit sayısıdır. Daha az bit, işlemci, bellek ve bant genişliği tasarrufu sağlar. Matris çarpımları daha az talimat gerektirir; değerler daha az yüksek bant genişliği ve önbellek belleği kaplar ve verilerin bellek ile çekirdekler arasında taşınması daha hızlıdır.

Ancak, kuantizasyon ile daha fazla bit çıkardıkça, LLM eğitiminde konsantrasyonu bozma riski de artmaktadır. Bit sayısının azalması, sayısal değerlerin üssü ve mantissası üzerinde etkili olur; bu da dinamik aralığın ve hassasiyetin daralmasına yol açabilir. Sonuç olarak, tensörlerin aşırı değerlerinin doğru temsil edilmemesi, eğitim sırasında bozulma veya hatta ayrılma meydana getirmekte. Bu koşullar altında, hızlanma ve konsantrasyon arasında bir denge kurmak büyük önem taşımaktadır.

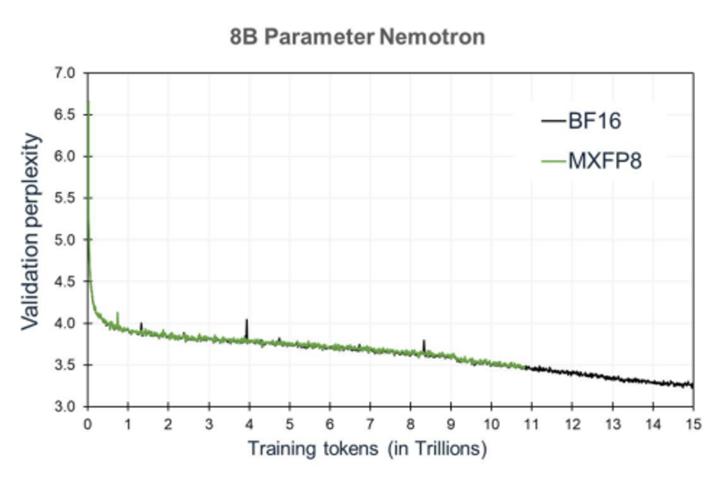

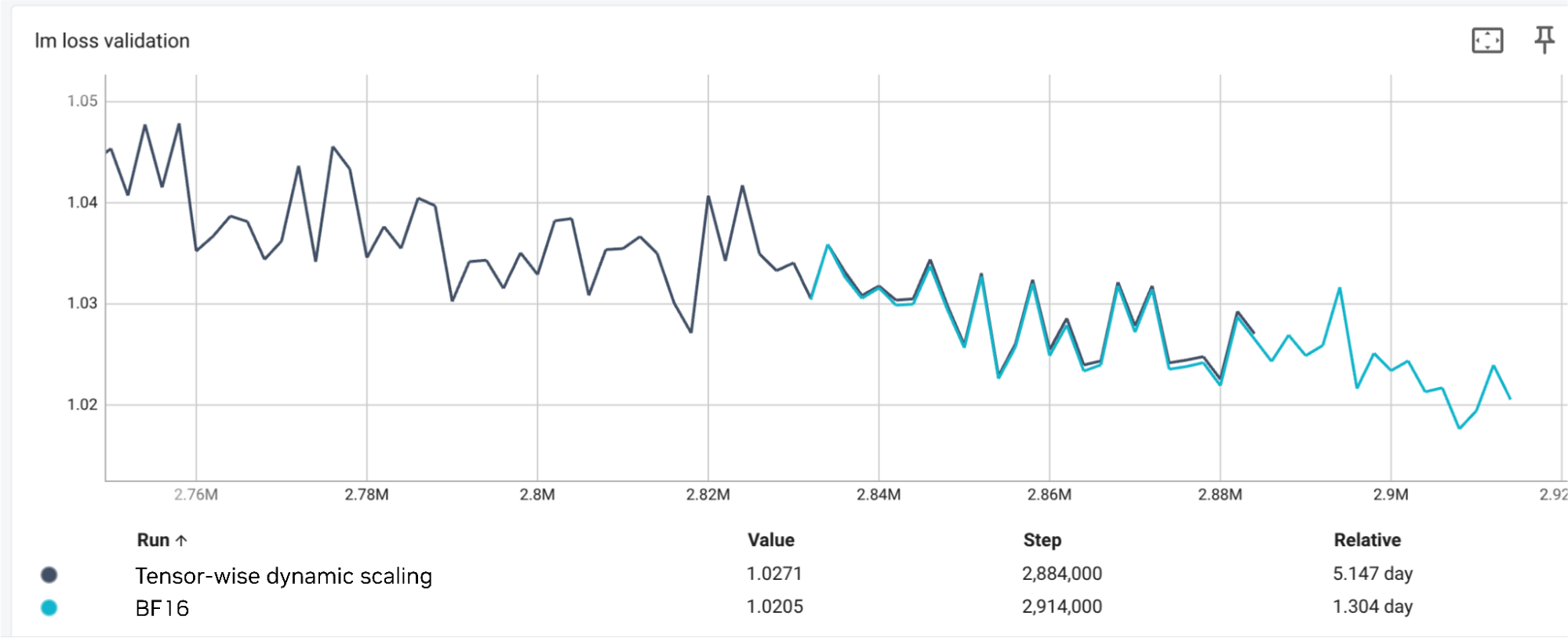

NVIDIA Transformer Engine, NVIDIA Ada Lovelace ve NVIDIA Hopper GPU serilerindeki FP8’i, Blackwell’deki MXFP8’i en uygun biçimde yönetmekte ve kuantizasyonun neden olduğu bozulmayı en aza indirirken önemli hız kazançları elde etmektedir. Örneğin, Şekil 3, 8B LLM için MXFP8 ve yüksek çözünürlüklü BF16’nın ön eğitim konsantrasyonunu karşılaştırmaktadır.

Şekil 3’teki grafik, MXFP8’in karmaşıklığını gösteren doğrulama değerinin BF16 ile benzer bir seyir izlediğini ortaya koyarak, her iki sistemin de eğitim süreçlerinde benzer bir konsantrasyon sağladığını bildirmektedir.

Tarifler Genel Bakış

Büyük sinir ağlarını FP8 ile eğitirken, daha yüksek hassasiyet (örneğin, FP32) ile daha düşük hassasiyetli FP8 formatı arasındaki ölçekleme biçimi hem performans hem de doğruluk için kritik öneme sahiptir. Bu ölçekleme stratejileri genellikle “FP8 tarifleri” başlığı altında bir araya getirilmektedir. Şimdi iki ana kategori olan tensör ölçekleme ve blok ölçekleme üzerine bir iki noktaya bakalım.

Tensör Ölçekleme

Tensör ölçeklemede, belirli bir tensör içinde tüm elemanlar için tek bir ölçek faktörü belirlenir ve uygulanır. Bu yaklaşım daha basit olsa da, tensör içinde geniş dinamik aralıklar olabileceğinden dikkatli bir şekilde yönetilmesi gerekmektedir.

Gecikmeli Ölçekleme

Gecikmeli ölçekleme, mevcut eğitim aşamasındaki ölçek faktörünün hemen o anda ölçülen değerlerden değil, birkaç önceki eğitim adımında gözlemlenen maksimum mutlak değerlerden (genellikle “amax” olarak adlandırılır) hesaplandığı bir stratejidir. Sistem, son birkaç iterasyon boyunca görülen amax değerlerinin tarihini takip eder. Şu anki adım için ölçek faktörü belirlemek amacıyla bu tarihe dayanarak bir algoritma (en basiti, tarihin en yüksek amax’ını almak veya daha karmaşık bir şey olabilir) uygulanmaktadır. Hesaplanan ölçek faktörü, mevcut tensörün FP8’e dönüştürülmesi için kullanılmaktadır. FP8 işlemi sonrasında, ortaya çıkan tensörün mevcut amax değeri kaydedilir ve gelecekteki ölçekleme kararları için tarihe eklenir.

Per-tensör Geçerli Ölçekleme

Bu yöntemde, ölçek faktörü her bir tensör için, mevcut ileri veya geri geçişteki istatistiksel özelliklerine dayanarak belirlenir. Gecikmeli ölçeklemeye göre, per-tensör geçerli ölçekleme, ölçek faktörünü mevcut eğitim adımında belirler. Bu yöntem, tensörün mevcut dinamik aralığına daha duyarlıdır ve her adımda daha doğru bir kuantizasyon sağlayabilir.

Gecikmeli ölçeklemenin aksine, buradaki geçici zirveler amax tarihini kirleterek ve potansiyel olarak dalgalanmalara neden olabileceğinden, per-tensör geçerli ölçekleme, mevcut veri aralığına dayanan ölçeklemeyi dinamik bir biçimde ayarlamaktadır. Bu anlık yanıt verme yeteneği, FP8 temsilini optimize eder ve eğitim sırasında modelin konsantrasyonunu artırmaktadır.

Blok Ölçekleme

Blok ölçeklemesi, tensör ölçeklemesinden daha ayrıntılı bir yaklaşım sergilemektedir. Burada, tüm tensör yerine, tensör daha küçük, bitişik bloklara ayrılır ve her bloğa ayrı bir ölçek faktörü atanır.

MXFP8

NVIDIA Blackwell mimarisi ile MXFP8, blok ölçekleme örneğini temsil eder. Burada, bir tensör 32 ardışık değerlik bloka bölünür. Her bir bu 32 elemanlı blok, kendi özel güç-açısından-2 ölçek faktörünü (E8M0 formatında) alır. Bu ölçekleme, Blackwell Tensor Core’ları tarafından doğrudan donanım düzeyinde yönetilmektedir.

Her küçük blok için bir ölçek faktörü belirleyerek, MXFP8, bir tensörde büyüklüklerdeki farklılıkları daha iyi karşılama imkanı sağlar. Büyük ve küçük bölgelere uygun ölçekleme yapılması, FP8’de daha doğru bir temsil sağlamaktadır.

Genel FP8

MXFP8 sabit bir blok boyutuna (32) sahipken, daha genel FP8 blok ölçekleme kapsamlı blok boyutlarını ayarlamaya izin vermektedir. Tüm değerlerin bir blok içinde aynı ölçek faktörüne sahip olduğu çeşitli boyutlarda bloklara bölünür (örneğin 1×128 veya 128×128). Bu ölçek faktörleri genellikle FP32 olarak saklanmaktadır.

Blok ölçeklemede, elde edilen tensör ile onun transpozu sayısal olarak aynı olmayacağından, her ikisinin gerektiği durumlarda daha yüksek hassasiyetten yeniden hesaplama gerekmektedir.

Bellek Etkileri

NVIDIA Transformer Engine’de, FP8 eğitimi için ölçek faktörleri, FP8 hassasiyeti kullanan her modül içinde otomatik olarak saklanmaktadır (örneğin, transformer mimarilerindeki lineer katmanlar). Standart FP8’de, her tensör ile ilişkilendirilen tek bir ölçek faktörü, 32-bit floating point (FP32) değeri olarak saklanır. Bu ölçek faktörü, tensörün değerlerinin dinamik aralığının FP8 formatının temsili aralığı içinde kalmasını sağlamaktadır.

MXFP8 varyantı ise blok bazlı ölçekleme uygulayarak, her 32 ardışık değere ayrı bir ölçek faktörü atamakta ve böylece bellek kullanımını optimize etmektedir. Bu ölçek faktörleri, dinamik ayarlama için kullanılan amax tarihleriyle birlikte Transformer Engine’in iç tamponları tarafından otomatik olarak yönetilmekte ve eğitim iterasyonları sırasında güncellenmektedir. Kontrol noktaları kaydedilirken, FP8 meta verileri, ölçek faktörleri ve amax tarihleri dahil edilerek özel bir anahtar altında saklanmakta ve tekrar üretilebilirlik ile süreklilik sağlanmaktadır.

Sonuç

Bu yazıda, FP8 hassasiyetinin temel unsurlarını ve büyük ölçekli eğitimi mümkün kılan tarifleri — tensör ve blok ölçeklemeden en son donanım yeniliklerine kadar — inceledik. Her yaklaşımın bellek etkilerini ve pratik hususlarını anlamak, uygulayıcıların model kalitesinden ödün vermeden önemli hız ve verimlilik kazançlarını açığa çıkarmasına yardımcı olabilir.

LLM eğitiminizi optimize etmeye hazır mısınız? NVIDIA Transformer Engine’de en son FP8 tariflerini inceleyin.

Daha Fazla Bilgi Edinin

NVIDIA GTC 2025 etkinliğinde birçok organizasyon, FP8 hassasiyetini kullanarak LLM’lerin sürekli ön eğitimini hızlandırırken yüksek doğruluğu koruma yöntemlerini gösterdi. Daha derinlemesine vaka çalışmaları, teknik detaylar ve pratik bilgiler için aşağıdaki kaynakları keşfedin:

- Vaka Çalışması: iGenius ve NVIDIA DGX Cloud

iGenius’un FP8 hassasiyetini nasıl kullandığını ve Colosseum 355B LLM üzerinde %82,04 doğrulukla MMLU referans puanına ulaştığını keşfedin. Ekip, FP8 stabilitesine yönelik erken öğrenme oranı azaltma ve hassas katmanlar için BF16’nın seçici kullanımı gibi stratejileri detaylandırmaktadır. - GTC 2025 oturumu: FP8 LLM Eğitiminden Çıkarma

DeepL ve diğerlerinin, FP8’i sonraki nesil çeviri modellerinde nasıl kullandığını öğrenin. Üretim dağıtımı ve büyük ölçekli FP8 eğitim sürecinden edindikleri dersler hakkında detaylar alın. - GTC 2025 oturumu: LLM’leri İnşa Etmek: FP8 Hassasiyeti ile Temel Modellerin Ön Eğitimini Hızlandırmak

Zoho’nun Fairseq çerçevesinden NVIDIA NeMo’ya geçişinin, FP8 hassasiyeti ve NVIDIA H100 GPU’larının benimsenmesi ile LLM eğitim hızını, verimliliğini ve model kalitesini nasıl artırdığını keşfedin. Bu yenilikler, ön eğitim maliyetlerini ve zamanını azaltırken, LLM geliştirilmesinde operasyonel mükemmellik için yeni bir standart belirlemiştir.