Günümüzde yapay zeka alanında en merak edilen sorulardan biri, büyük dil modellerinin (LLM’ler) süreklilik arz eden takviye öğrenimi (RL) aracılığıyla gelişip gelişemeyeceğidir, yoksa yeteneklerinin bir noktada tıkanıp tıkanmayacağıdır.

NVIDIA Araştırma tarafından geliştirilen ProRL v2, Uzun Süreli Takviye Öğrenimi (ProRL)nin en son evrimidir ve LLM’lerin uzun süreli RL eğitiminin etkilerini test etmek için özel olarak tasarlanmıştır. Gelişmiş algoritmalar, katı düzenleme kuralları ve kapsamlı alan kapsama ile ProRL v2, standart RL eğitim programlarının ötesine geçerek sınırları zorlamaktadır. Deneylerimiz, modellere binlerce ek RL adımı uygulanmasının ölçülebilir ilerleme sağlayıp sağlayamayacağını sistematik bir şekilde keşfetmektedir.

Bugün, ProRL v2’nin piyasaya sürüldüğünü duyurmaktan heyecan duyuyoruz. Bu yazıda ana yenilikleri, ileri yöntemleri ve ProRL v2’nin yeni ampirik sonuçlarını, büyük dil modellerinin nasıl öğrenmeye ve gelişmeye devam edebileceğine dair önemli bilgilerle birlikte açıklıyoruz.

ProRL v2 ile RL Ölçeklendirmesi Nasıl Sağlanıyor?

Birbirini izleyen düşünce zincirleri, ağaç araması ve diğer yapay zeka teknikleri, modellerin sahip oldukları bilgileri daha iyi kullanmalarına yardımcı olur. RL, özellikle programlanabilir ve doğrulanabilir ödüller ile, modelleri gerçekten yeni alanlara yönlendirme vaadini taşır. Ancak, geleneksel kısa vadeli RL teknikleri genellikle kararsızlıktan ve hızla azalan getirilere maruz kalır ve gerçek sınır genişletici olmaktan ziyade “sıcaklık damıtma” olarak adlandırılan bir üne sahiptir.

ProRL, bu paradigmayı köklü bir şekilde sorgulamaktadır. Sağladıkları:

- Uzun süreli eğitim: Beş ayrı alanda 3,000’den fazla RL adımı, 1.5B akıl yürütme modelleri arasında yeni gerçekleri sağlıyor.

- Kararlılık ve dayanıklılık: KL-düzenlenmiş güven alanları, periyodik referans politika sıfırlamaları ve planlı uzunluk düzenlemeleri içerir.

- Tamamen doğrulanabilir ödüller: Her ödül sinyali programatik olarak belirlenir ve her zaman kontrol edilebilir.

- Kısalıktan ödül: Planlı kosinüs uzunluk cezaları, çıktının kısa ve verimli kalmasını sağlar.

Amacımız, tanıdık çözümleri tekrar tekrar kullanmaktan öteye geçmek ve modelin keşfedebileceği gerçek alanları genişletmektir.

ProRL Algoritmaları ve Düzenleyicileri

ProRL v2, REINFORCE++ temelini geliştirerek, keşfi teşvik etmek için Clip-Higher’ı ve öğrenme verimliliğini artırmak için Dinamik Örnekleme’yi kullanır. Birkaç yenilik tanıtıyoruz:

- Özet uzunlukları için planlı kosinüs uzunluk cezaları

- Aşırı uyum sağlamayı önlemek ve kararlılığı sağlamak için periyodik referans sıfırlamalarıyla KL-düzenlenmiş güven alanları

Proximal Politika Optimizasyonu ile REINFORCE++ Temeli

ProRL’nin temelinde Clip’li proximal politika optimizasyonu (PPO-Clip) kaybı bulunmaktadır; bu, yeni politikanın eski olanlardan ne kadar sapabileceğini kısıtlayarak politika güncellemelerini kararlılığa kavuşturur:

mathcal{L}_mathrm{PPO}(theta) = mathbb{E}_taubigg[

minBig( r_theta(tau) A(tau),

mathrm{clip}big(r_theta(tau), 1 - varepsilon_mathrm{low}, 1 +

varepsilon_mathrm{high}big) A(tau) Big)

bigg]

Burada:

Ve group kelimesi, aynı istem için üretilen tüm yanıtları ifade eder (grup normalizasyonu).

Global Batch Normalization, REINFORCE++ temelinde, küçük grup boyutlarının neden olduğu değer kararsızlığını önlemeye yardımcı olur. Öncelikle, küçük grubun ortalama ödülünü çıkartır ve böylece ödülleri yeniden şekillendirir. Bu nedenle, algoritma, 0 (yanlış) / 1 (doğru) / -0.5 (format ödülü) veya -1 (yanlış) / 1 (doğru) / -0.5 (format ödülü) gibi ödül kalıplarına karşı kayıtsız değildir. Ardından global grup normalizasyonu uygular.

Kesim limitleri:

varepsilon_{text{low}} = 0.20 qquad varepsilon_{text{high}} = 0.28

Clip-Higher ve Dinamik Örnekleme

Clip-Higher, politika entropi çöküşünü azaltmak ve örnekleme çeşitliliğini artırmak için PPO kesim aralığının üst sınırını daha yüksek bir değere taşır (

).

Dinamik Örnekleme, grup yanıtlarının tümü 1 (tamamen doğru) veya 0 (tamamen yanlış) ödüllere sahip olduğu istemleri eleştirerek gradyan tahminlerinde gürültüyü azaltır.

Planlı Kosinüs Uzunluk Cezası

Kısa, token-verimli çıktılar üretmek için bir planlı kosinüs uzunluk cezası uygulanmaktadır:

text{length_reward}(t) = eta_{min} + 0.5 times (eta_{max} - eta_{min})

times [ 1 + cos ( pi t / T ) ]

Burada:

= güncel çıktı uzunluğu (token)

= bağlam token sınırı

,

= ödül/ceza sınırları

Ödül güncellemesi:

R'_tau = R_{text{correct}} + lambda_text{len} cdot eta_text{len}(t)

Cezalar, düzenli aralıklarla (örneğin, 100 güncelleme açık, 500 kapalı) döngüye alınarak, bilgilendiricilik ve kısalık arasında bir denge sağlanır.

KL Düzenleme ve Referans Politika Sıfırlamaları

KL cezası, politikayı bir referansa yakın tutar. Periyodik sıfırlama, aşırı uyumu önlemeye ve kararlılığı sağlamaya yardımcı olur:

mathcal{L}_mathrm{KLtext{-}RL} = mathcal{L}_mathrm{PPO} - beta,

D_mathrm{KL}(pi_theta | pi_mathrm{ref})

KL sapması, REINFORCE++ temelinde düzenlenirken bir

tahmin edici kullanılır:

mathcal{L}_{k_{2}} = mathbb{E}_{s sim D, a sim

pi_{theta_{text{old}}}(cdot|s)} left( frac{1}{2} ( -log x )^2 right)

Burada:

[

x = exp left( mathrm{clamp}left(

log frac{pi_{text{ref}}(a_t mid s_t)}{pi_{theta_{text{old}}}(a_t mid s_t)}, -10, 10

right) right)

]

Bu noktada, clamp işlevi, değerini değer aralığında sınırlamakta ve değerleri (-10, 10) aralığında tutarak değer kararlılığını artırmaktadır.

Referans Sıfırlamaları

Her 200-500 RL adımında (veya KL zirveleri/yavaşlamalar durumunda), referans politika , güncel politikaya sıfırlanır; optimizasyon durumu sıfırlanmaz.

Referans politikasının düzenli sıfırlanması, modelin eski yönlendirmelere bağlı kalmasını engelleyerek etkili bir şekilde öğrenmeye devam etmesini sağlar. Ayrıca, planlı kosinüs uzunluk cezasının uygulanması da önemli bir rol oynar. Cezanın belirli aralıklarla açılıp kapatılması, modelin kısa veya sabit bağlam uzunluklarında hapsetmesini engelleyerek çıktılarının doğruluğunun ve token verimliliğinin iyileşmesini sağlar. Bu iki strateji birlikte, modelin hem referans politikası hem de bağlam uzunluğundan ötede kalmasını ve zamanla doğruluk ve genel performansındaki sürekli iyileşmeleri desteklemesini sağlamaktadır.

RL’yi LLM’ler için Ölçeklendirme ile İlgili Ne Keşfedildi?

Takviye öğrenimini ölçeklendirmenin yeni, etkileyici sonuçları ve sürdürülebilir iyileştirmeler keşfettik. Ayrıca, yenilikçi ve yaratıcı çözümler bulduk ve sınırları aşan gelişmeler yaşadık.

- Yeni en yüksek performans: Performans, daha fazla RL eğitim adımı ile sürekli olarak artmaktadır; ProRL v2 3K, 1.5B akıl yürütme modelleri için yeni bir rekor kırmıştır.

- Sürdürülebilir, önemli iyileştirme: Hem Pass@1 hem de pass@k metrikleri, binlerce RL adımı boyunca artış göstermekte, temel modelin akıl yürütme sınırlarını genişletmektedir.

- Yaratıcı ve yenilikçi çözümler: ProRL çıktıları, ön eğitim verileriyle azalan n-gram örtüşmesi göstermekte ve bu da gerçek yeniliği işaret etmektedir.

- Sınır aşımı: Temel modellerin her zaman başarısız olduğu görevlerde, ProRL hem güçlü geçiş oranları sağlamakta hem de sağlam bir dış dağılım genellemesi göstermektedir.

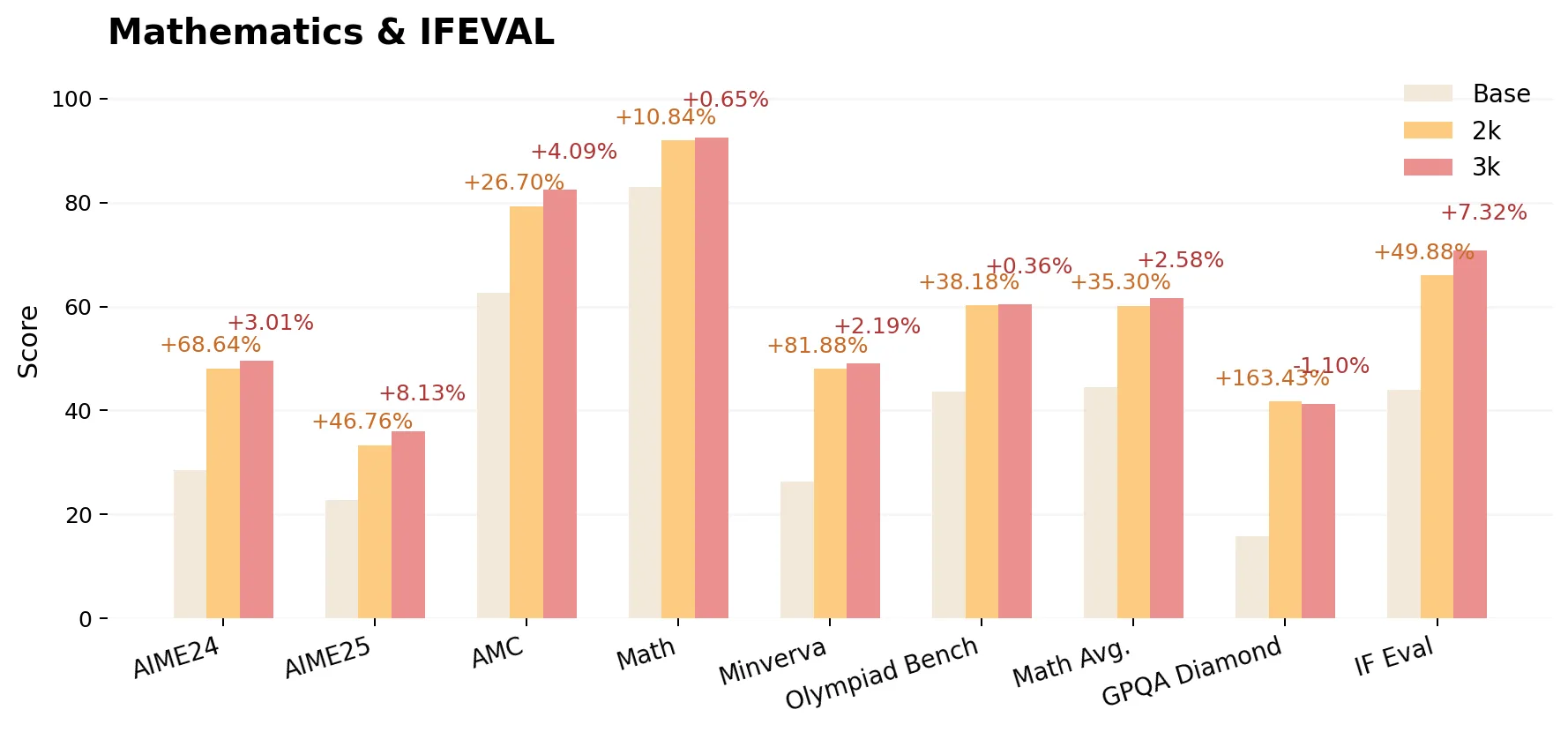

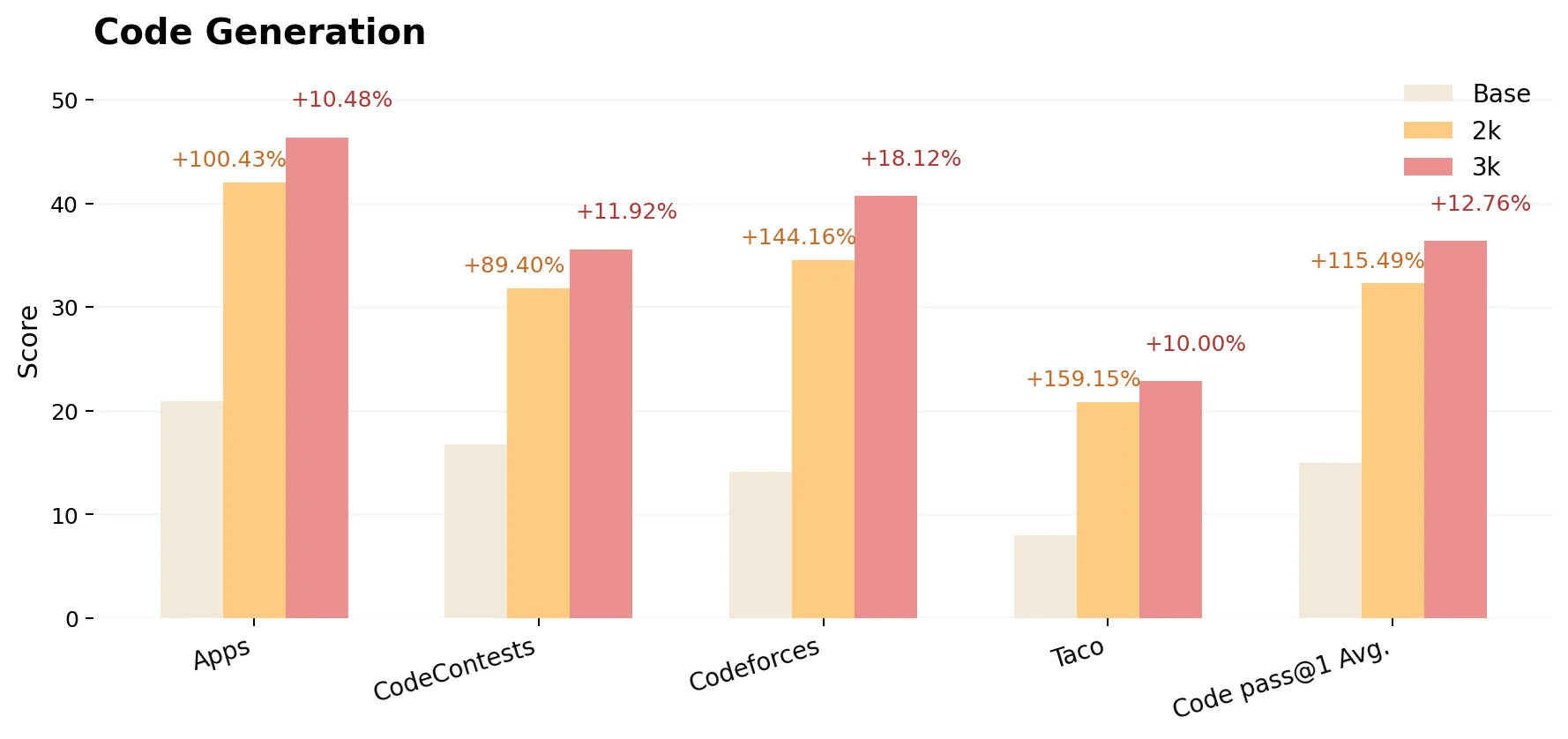

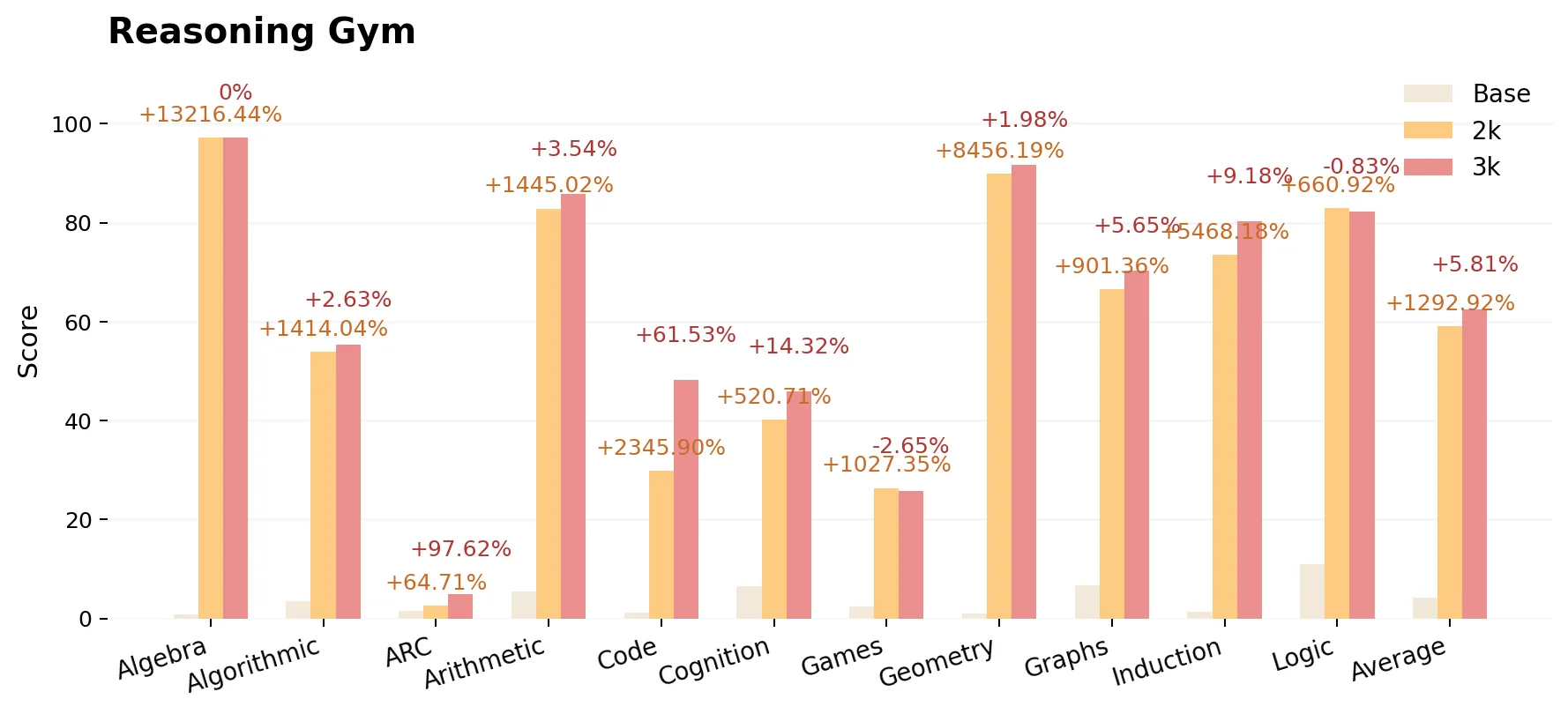

ProRL Kapsamlı Sonuçları

ProRL, matematik, kod üretimi ve çeşitli akıl yürütme gym benchmark’ları üzerinde değerlendirilmiştir. Aşağıdaki değerler raporlanmıştır:

- Temel: DeepSeek-R1-Distill-Qwen-1.5B

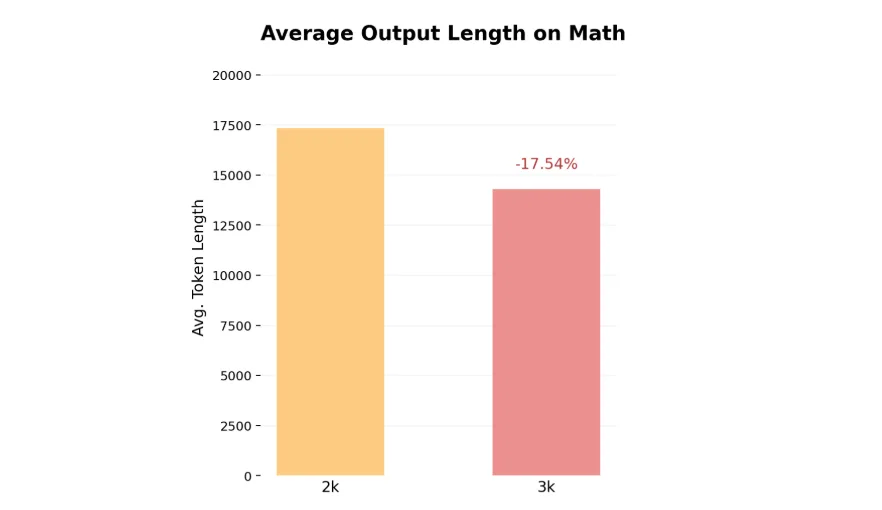

- ProRL v1 2K: 2,000 RL adımı (16K bağlam ile eğitimli)

- ProRL v2 3K: 3,000 RL adımı (8K bağlam ile eğitimli)

Bu yazı yazıldığı sırada model, sürekli eğitim görmekte ve doğruluk iyileştirmeleri yaşamaktadır. Aşağıdaki figürler, 2K adım modelinin temel model üzerindeki performans kazançlarını ve 3K adım modelinin 2K adım modeline göre performans kazançlarını gösterir. Eğitim bağlamı uzunluğu yarıya indirilse bile (16K’dan 8K’ya)—hesaplama maliyetini büyük ölçüde düşürmesine rağmen—görevler üzerindeki genel model doğruluğu artmaktadır:

Sonuç

Ampirik sonuçlarımız, LLM’lerin matematik, kod ve akıl yürütme görevlerinde uzatılmış RL ile sürdürülebilir iyileşmeler elde edebileceğini göstermektedir; bu da tipik eğitimin ötesinde performans sergilemektedir. Değerlendirmemiz, geniş bir yelpazedeki benchmark’larda—özellikle zorlayıcı ve dış veri seti görevlerinde—güçlü kazançlar sergilemektedir. Bu, uzatılmış RL eğitiminin modelin akıl yürütme yeteneklerini anlamlı bir şekilde genişletebileceğini öne sürmektedir.

- Yeni en yüksek performansa sahip 1.5B akıl yürütme modeli: ProRL v2 3K, temel modeli olan DeepSeek-R1-1.5B’yi önemli ölçüde geride bırakmakta ve ProRL v1 2K tarafından elde edilen önceki en yüksek performansı da aşmaktadır.

- ProRL, matematik, kod ve akıl yürütme alanlarında sürdürülebilir, güvenilir iyileştirmeler sunmaktadır. Özellikle temel modellerin (agresif örnekleme ile bile) tamamen başarısız olduğu alanlarda bahsedilmektedir.

- Daha fazla işlem gücü ve daha fazla parametre: RL adımlarını daha ileri götürmek—sadece model boyutunu ölçeklendirmek yerine—katı bir şekilde daha fazla sınır genişlemesi sağlamaktadır.

- Gelişmeler sağlam: İyileşmeler rastgele değil, hemen hemen her alt görev geliştirmeyi fayda sağlamaktadır.

Model performansını artırmaya ya da LLM’lerin akıl yürütme potansiyelini keşfetmeye çalışan uygulayıcılar için ProRL, yeniden üretilebilir bir temel ve pratik bir eğitim tarifi sunmaktadır. Açık kaynaklı modeller ve benchmark’lar ile, topluluğun bu bulguları daha fazla keşfetmesi ve doğrulaması teşvik edilmektedir; bu, LLM’ler için RL’nin limitleri ve fırsatları üzerine süregelen araştırmaların bir parçası olarak yapılmaktadır.

Hadi başlayalım! ProRL modellerini Hugging Face üzerinde keşfedin!