Geniş dil modellerinin (LLM’ler) bazı heyecan verici uygulamaları, etkileşimli konuşma botları, kodlama yardımcıları ve arama işlemleri gibi kullanıcı sorgularına hızlı bir şekilde yanıt verme yeteneğine sahip olmayı gerektiriyor. Bir LLM’nin kullanıcı girdisini (ve bağlamı) alıp yanıt vermeye başlaması için geçen süreye ilk token için geçen süre (TTFT) denir.

LLM’ler, son dönemlerde yüz milyarlarca parametreye kadar büyüyerek daha doğru yanıtlar vermekte ve kullanıcıların daha uzun, bilgi açısından zengin sorgular sormalarını sağlayacak daha büyük bağlam pencerelerini desteklemekte. Örneğin, Llama 3.1 ve 3.2 serisi LLM’ler, yaklaşık bir roman uzunluğunda olan 128K token bağlam pencerelerini destekliyor. Bu yetenekler LLM’leri daha kullanışlı hale getiriyor ancak iyi bir etkileşim için daha fazla hesaplama performansı da gerektiriyor.

Artık yapay zeka, model ön eğitimi ile ölçeklenmenin yanı sıra, eğitim sonrası sentetik veri üretimi ve çıkarsama zamanındaki akıl yürütme ile de ölçeklenmeye başladı. Çıkarsama performansı ve ölçeklenme artık kritik önem taşıyor.

TTFT’nin Önemi

Yapay zeka konuşma botları, dijital asistanlar ve oyunlardaki AI NPC’leri gibi uygulamalar, doğal, insan benzeri konuşma yeteneklerini simüle etmeyi amaçlıyor. Bu kullanım durumları için, birkaç yüz milisaniye civarında bir TTFT, çok kritik. Kullanıcı deneyimi üzerindeki TTFT etkisini anlamak için aşağıdaki animasyonları inceleyelim. Birincisi, yaklaşık yarım saniye TTFT’ye sahip bir konuşma botunu simüle ederken, ikincisi yaklaşık beş saniye TTFT’ye sahip bir botu temsil ediyor.

Hızlı TTFT, güncel bilginin önemli olduğu hizmetlerde, örneğin son günlerde artan ajansal iş akışları‘nda, oldukça etkili. Kullanışlı ajanslar oluşturmak için uygun verilerle LLM istemlerini güçlendiren Geri Dönüşümlü Genişleme (RAG) gereklidir. Bu da bağlamların oldukça uzun olabileceği anlamına gelir; bu durum TTFT’nin hızlı olmasının bu hizmetleri daha etkileşimli hale getirdiği anlamına gelir.

NVIDIA GH200 NVL32 ile TTFT’yi Geliştirme

Bir çıkarım talebine yanıt olarak ilk yeni tokeni oluşturmak için, giriş tokenlerinin LLM tarafından işlenmesi gerekiyor. Bu aşama sıklıkla büyük sayıda token içermekte ve bu nedenle artan toplam hesaplama performansından yararlanarak hızlandırılabilir. Hesaplamalar, tensor paralelliği gibi paralelleştirme teknikleri kullanılarak birden fazla GPU üzerinden dağıtılabilir.

Hesaplamalar birçok GPU arasında dağıtıldığında, tüm GPU’lar arasında veri alışverişi yapılması gerekiyor. Bu yetenek, model katmanında her iki AllReduce senkronizasyonu ile iki kez gerçekleşmektedir. Katman sayısı arttıkça, senkronizasyon trafiği de artmaktadır. Llama 3.1 405B modeli 126 katman içermekte ve bu durum her bir çıkarım adımında 252 AllReduce senkronizasyonu gerektiriyor. 122,880 token’lık bir giriş dizisiyle çalışırken, 32 GPU kullanımı toplamda 114 TB’lık bir bağlantı trafiği oluşturuyor.

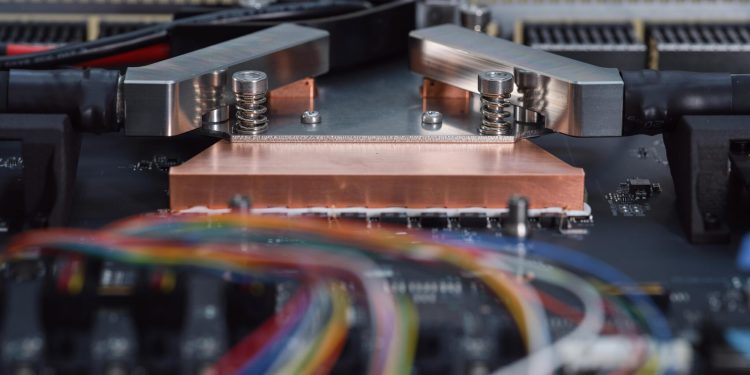

GH200 NVL32 sistemi, 32 NVIDIA GH200 Grace Hopper Superchip’ten oluşmaktadır. Bu süper çiplerin her biri, NVIDIA Grace CPU ve NVIDIA Hopper GPU’dan oluşur ve NVLink-C2C ile bağlıdır. NVLink Switch Sistemi, tüm GPU’ların tam 900 GB/s bant genişliği ile iletişim kurmasını sağlıyor. Bu sistem, 32 GH200’ün bir araya gelerek 127 petaFLOP’luk bir FP8 AI hesaplama gücü sunmasını sağlıyor. Bu da özellikle en talepkar modellerle kısa TTFT süreleri sağlıyor.

Birden fazla GPU’yu kullanarak Llama 3.1 405B modelinde 122,880 token’lık bir sorgu için TTFT’yi 3 kat hızlandırmakta ve bu da gerçek zamanlı bir deneyim sunmaktadır. Llama 3.1 70B için ise aynı uzunlukta bir sorgu için TTFT’yi 2.6 kat hızlandırmakta.

Llama 3.1 70B ve 405B Model Performansı

Tek bir GH200 NVL32 sistemi, 70B Llama 3.1 çalıştırarak 32,768 giriş dizisi uzunluğunda 472 milisaniye TTFT elde etmektedir. Pratikte bu, Llama 3.1 70B’nin 90 sayfalık bir belgenin özetini veya binlerce satırlık kod önerilerinin çıktılarını yarım saniyeden kısa bir sürede vermesi anlamına geliyor.

| Llama 3.1 70B İlk Token için Geçen Süre (milisaniye) (Daha düşük değerler daha iyidir) |

|

| Giriş Dizisi Uzunluğu | GH200 NVL32 |

| 4,096 | 64 |

| 32,768 | 472 |

| 122,880 | 2,197 |

Veriler 6/9/2024 ve 10/9/2024 tarihleri arasında ölçülmüştür.

Ve, 122,880 token’lık bir giriş dizisi için, GH200 NVL32, yalnızca 2.2 saniyede yanıt vermeye başlayabilir.

Llama 3.1 405B modeli ise, yanıtın ilk tokenini oluşturmak için çok daha fazla hesaplama gerektirmektedir; çünkü bu model, Llama 3.1 70B’nin neredeyse 6 katı kadar parametre barındırıyor.

| Llama 3.1 405B İlk Token için Geçen Süre (milisaniye) (Daha düşük değerler daha iyidir) |

|

| Giriş Dizisi Uzunluğu | GH200 NVL32 |

| 4,096 | 208 |

| 32,768 | 1,627 |

| 122,880 | 7,508 |

Veriler 6/9/2024 ve 10/9/2024 tarihleri arasında ölçülmüştür.

GH200 NVL32, Llama 3.1 405B çalıştırarak 32,768 token’lık bir girdi ile yaklaşık 1.6 saniye TTFT sağlamaktadır. Küçük bir kod tabanı büyüklüğündeki 122,880 token’lık bir girdi ile yanıt vermeye başlaması ise yalnızca 7.5 saniye sürmektedir.

Çıkarsama İnovasyonları ve Gelecek

Çıkarsama inovasyonu, sunum teknikleri, çalışma zamanı iyileştirmeleri, kernel’lar ve daha birçok alanda büyük bir hızla devam ediyor. Uçta toplama, öngörücü kodlama, FlashAttention, anahtar-değer önbellekleme gibi gelişmeler, hem endüstri hem de akademi tarafından geliştirilmiştir. Bu yenilikler dizi, model ve sistemlerin daha verimli bir şekilde dağıtılmasını sağlamakta ve güçlü yapay zeka yeteneklerinin tüm NVIDIA ekosisteminde daha erişilebilir hale gelmesini sağlamaktadır.

Hızla inovasyon yapmak için, araştırmacıların zengin bir geliştirici ekosistemi ve üretken bir araç yelpazesine ihtiyacı var. Yeniliklerin en geniş kitlelere ulaşabilmesi için ise büyük bir platform kurulumu kritiktir. NVIDIA hızlandırma platformu, 5 milyondan fazla geliştiriciye ve birkaç yüz milyon GPU’ya sahiptir, bu da CUDA programlama modeli ile uyumludur. Geliştiricilerle, hesaplama sağlayıcılarıyla ve müşterilere derin angajman, NVIDIA platformunda yapay zeka yeniliğini hızlandırmakta ve mümkün kılmaktadır.

Gelecek: Ajansal İş Akışlarını Hızlandırmak

Ajansal iş akışları, ağaç aramaları, öz değerlendirmeler ve karmaşık sorguların yanıtlarını üretmek için yineleme çıkarımlarını yerine getirmektedir. Bu, her bir istemde yapılacak çıkarımların sayısını katlanarak artıracaktır. Her bir çıkarım ile birlikte, toplam yanıtın bir sonraki ajans içinde yeni bir bağlam olarak işlenmesi gerekiyor; dolayısıyla hızlı TTFT’nin önemi artacaktır.

Ayrıca hızlı token üretim hızı ajansal iş akışlarının etkinliği için de oldukça önemlidir. İlerleyen başlıklarda, NVIDIA platformunda NVLink ve NVLink Switch sistemiyle daha fazla GPU kullanarak token üretim hızını artırmaya dair güncellemeler paylaşacağız.

NVIDIA Blackwell GB200 NVL72 İle Yeni Bir Dönem Başlıyor

Gelecekte model boyutları hızla büyümeye devam ederken, daha uzun bağlam uzunluklarını destekleyen modeller ve artan ajansal iş akışları ile hızlı çıkarım için gereken hesaplama gücü de hızla artmaktadır.

Blackwell platformuna dayanan GB200 NVL72, üretken AI ve hızlandırılmış bilgisayar için bir sonraki büyük sıçramayı sunmaktadır. İkinci nesil Transformer Motoru ve beşinci nesil Tensor Çekirdekleri ile, Blackwell, FP4 AI hesaplamasında 20 PFLOPS’a kadar performans sağlıyor. Bu, NVIDIA Hopper’ın AI hesaplama gücünün 5 katıdır. Beşinci nesil NVLink ise GPU’dan GPU’ya bant genişliğini 1,800 GB/s’ye çıkarıyor; bu da Hopper’ın sağladığı bant genişliğinin iki katıdır ve GB200 NVL72 rack ölçekli sistem ile 72 GPU’ya kadar NVLink alanı genişletiliyor. NVIDIA, her teknolojik katmanda performansı artırmak, toplam sahip olma maliyetini düşürmek ve yapay zekanın bir sonraki neslini mümkün kılmak amacıyla yenilik yapmaya devam ediyor.

Bu blog, bir dizi bölümün parçasıdır – NVIDIA HGX H200 ile Medusa kullanarak 1.9x Daha Yüksek Llama 3.1 Performansı konulu Düşük Gecikmeli Çıkarsama Bölüm 1’e göz atın.