AI Yüklerinin Gelişimi

Son yıllarda, yapay zeka (YZ) iş yükleri hızla büyümekte ve bu durum büyük dil modellerinin (LLM’ler) dağıtımındaki artışla daha da belirgin hale gelmektedir. Örgütler, çok milyar parametreli temeli modellerin eğitimi ve dağıtımı için hesaplama altyapısını genişletirken, yüksek token verimliliği sağlama yeteneği kritik bir önem kazanmıştır. İlerleme, yalnızca verimlilik ile değil, aynı zamanda bir YZ fabrikasının ne kadar token işleyebileceği ile tanımlanmaktadır.

YZ’ye Özel Veri Formatlarının Yeniliği

YZ için optimize edilmiş veri formatları, bu çabada anahtar bir yenilik olarak ortaya çıkmıştır. Dar hassasiyetli hesaplama, NVIDIA’nın NVFP4’ü tanıtmasıyla birlikte, çıkarım işlemlerinde olağanüstü gecikme süresi, verimlilik ve throughput sağlamak için devrim niteliğinde bir etki yaratmıştır. Tüm bunlar, üretim seviyesi doğruluğunu korurken gerçekleştirilmiştir.

NVFP4 ile Ön Eğitimde Çığır Açan Yenilikler

NVIDIA, bu yeniliği ön eğitim aşamasına da taşımaktadır, bu durum ise büyük dil modellerinin geliştirilmesinde önemli bir atılımı işaret etmektedir. NVFP4’ün ön eğitimde kullanılması, büyük ölçekte LLM’lerin eğitiminde ve genel altyapı verimliliğinde büyük iyileşmeler sağlanmaktadır. Bu, sadece kademeli bir optimizasyon değil, büyük modellerin ölçekli eğitiminde temelden bir değişimdir.

Hesaplamanın ilerlemeyi yönlendirdiği YZ fabrikaları çağında, hassasiyet bir arka uç detayı olmaktan çıkmakta ve stratejik bir avantaja dönüşmektedir. NVFP4 4-bit ön eğitim ile verimlilik ve ölçeklenebilirlik sınırlarını yeniden tanımlamakta ve yüksek performanslı YZ model gelişimi için yeni bir standart belirlemektedir.

4-bit Kuantizasyon Nedir?

4-bit kuantizasyon, model ağırlıklarının ve aktivasyonlarının yalnızca 4 bitlik bir hassasiyete düşürülmesi sürecidir; bu, tipik 16-bit veya 32-bit kesirli formatlar için oldukça dramatik bir azalmadır. 4 bit ile ön eğitim yapmak zorlu bir süreçtir; çünkü gradyanlar ve güncellemeler, doğruluğu koruyarak eğitim hızını artırmak için dikkatle ele alınmalıdır. Yüksek hassasiyet hesaplamalarını daha küçük bir set miktarına eşlemek için özel teknikler ve tarifler gereklidir.

Daha Az Bit ile Daha Fazla Kapasite Nasıl Açılır?

Son yıllarda, YZ iş yükleri sadece büyük dil modellerinin dağıtımında değil, aynı zamanda temeli model ön eğitimi ve sonrası ölçeğinde de önemli bir artış göstermektedir. Örgütler, multi-milyar parametreli modellerin eğitim ve dağıtımı için hesaplama altyapısını genişletirken, bir YZ fabrikasının sürdürebileceği token throughput’unun artırılması, yeni yeteneklerin açığa çıkarılmasında giderek daha belirleyici hale gelmektedir.

Çıkarım işlemleri daha önce FP32 ve FP16’dan FP8 ve son olarak NVIDIA’nın NVFP4’e kadar pek çok yenilik aşamasından geçmiştir. Post-training kuantizasyon (PTQ) gibi yöntemler, NVFP4’ün doğruluğu koruyarak çıkarım throughput’unu artırmada etkili olduğunu göstermiştir; ancak hala ön eğitim aşamasında zorluklar mevcuttur. Burada, temeli modellerin hala stabilite ve yakınsama için BF16 veya FP8’e bağımlı olduğu görülmektedir.

Eğitim, YZ fabrikalarının hesaplama, güç ve zaman yatırımınızı büyük ölçüde harcayabileceği alanlardan biridir. Enerji bütçeleri belirli olduğundan ve GPU döngüleri sınırlı olduğundan, geliştiricilerin her bir bit, token ve epoch’ı dikkate almaları gerekmektedir. Bu noktada throughput, YZ fabrikalarının hangi ölçeklerde model oluşturabileceğini, ne kadar deney yapabileceğini ve yeniliklerin ne kadar hızlı geleceğini belirleyen bir metrik olmaktadır.

İşte burada 4-bit hassasiyet devrim niteliğinde bir etki yaratmaktadır. Bellek ihtiyaçlarını azaltarak, aritmetik throughput’u artırarak ve iletişimi optimize ederek, 4-bit ön eğitim, aynı donanım üzerinden önemli ölçüde daha fazla token geçirilebilir. Doğru kuantizasyon tarifesi ile FP8/BF16 ile kıyaslandığında benzer bir doğruluk sunarak throughput’u önemli ölçüde artırma olanağı sağlar; bu da daha hızlı yakınsama döngüleri, daha fazla deney ve daha önce görülmemiş ölçekli modellere ulaşma fırsatları sunar. Yani, daha az bit sadece maliyetleri azaltmakla kalmaz, aynı zamanda YZ fabrikalarının elde edebileceği sınırları genişletir.

NVFP4 Ön Eğitim için Kuantizasyon Tarifi

4-bit hassasiyetle ön eğitimi etkin hale getirmek için, dinamik alan, gradyan dalgalanması ve büyük ölçekli eğitimde sayısal stabilite gibi temel zorlukları ele alan özelleştirilmiş bir NVFP4 ön eğitim tarifi geliştirilmiştir.

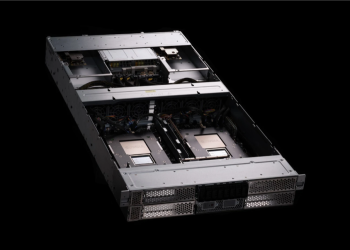

Blackwell, NVIDIA’nın FP4 formatlarını yerel olarak destekleyen ilk mimarisi oldu. GB200 ve GB300 üzerindeki devasa FP4 FLOPs verimliliği, dar hassasiyetli matris işlemlerini hızlandırırken, büyük model yakınsaması için gereken ölçek ve paralelliği koruyarak etkili 4-bit eğitim sağlıyor—bu da FP4 tabanlı ön eğitim uygulayan gelecek nesil YZ fabrikaları için ideal hale getiriyor.

Örnek olarak, Blackwell Ultra ile ölçülen GEMM performansı, Hopper nesline göre 7x bir hız artışını göstermektedir. Modern LLM’ler, özellikle tam bağlı veya lineer katmanlarındaki matris çarpımına dayanarak çalıştığı için, bu işlemlerin verimliliği kritik önem taşımaktadır. FP4 hassasiyetinin bu işlemlerin daha hızlı ve daha verimli bir şekilde yapılmasını sağlaması, ön eğitim sürecinin tamamını—ileri yayılmadan gradyan güncellemelerine kadar—signifikant şekilde hızlandırarak eğitim süresini azaltıp, büyük ölçekli model gelişimini hızlandırmaktadır.

NVIDIA’nın NVFP4 Ön Eğitim Teknikleri

Düşük hassasiyetli eğitimin verimli hale getirilmesi için, NVIDIA’nın NVFP4 ön eğitim tarifesi birkaç önemli tekniği kullanmaktadır:

- NVFP4’ün Mikro-Blok Ölçeklendirmesi ile Geliştirilmiş Değer Temsili: Blackwell, ağırlıklar ve aktivasyonlar için 4-bit bir sayı formatı olan NVFP4 için yerel Tensor Core desteği sunmakta. Her biri on altı 4-bit eleman içeren mikro-bloklar, ortak bir ölçek faktörüne paylaşarak dışlayıcıların etkisini azaltmakta ve daha doğru ölçeklenmeyi mümkün kılmaktadır. Bu, kuantizasyon hatalarını azaltarak genel model doğruluğunu artırmaktadır.

- NVFP4 Yüksek Hassasiyetli Blok Kodlaması: Ölçek faktörlerinin hassasiyeti, kuantizasyon kalitesi ve doğruluğunda kritik bir rol oynamaktadır. MXFP4’ün sınırlı power-of-two ölçek faktörlerine (E8M0) sahip olmasının yanı sıra, NVFP4, ek mantissa bitleri ile birlikte yüksek hassasiyetli E4M3 ölçek faktörlerini kullanarak, daha ince ölçeklendirme ve kuantizasyon kutularının daha iyi kullanımını sağlamaktadır.

- Tensör Dağılımlarını Dar Formatlara Uydurmak: LLM ön eğitiminde gradyanlar ve aktivasyonlar genellikle büyük dışlayıcılara sahip olduğu için dar hassasiyet kuantizasyonunu etkileyebilir. GEMM girdi verilerine Hadamard dönüşümleri uygulamak, dağılımlarını daha Gauss benzeri hale getirerek dışlayıcıları düzeltir ve tensörlerin doğru bir şekilde temsil edilmesini kolaylaştırır. Bu dönüşümler model mimarisine şeffaftır ve ileri ve geri geçişlerde lineer katmanlara uygulanabilir.

- Kuantizasyonda Sadakati Koruma: Kesin ve verimli eğitimi sağlamak için, ileri ve geri geçişler arasında tutarlılığı koruyan kuantizasyon yöntemleri kullanmaktayız. Seçici 2D blok tabanlı kuantizasyon gibi teknikler, eğitim döngüsü boyunca tensör temsillerinin uyumunu korumaya yardımcı olur. Bu tutarlılık, sinyal bozulmasını en aza indirerek ve yakınsama davranışını iyileştirerek genel güvenilirliği artırmakta—özellikle NVFP4 gibi dar hassasiyetli formatlarla işlem yaparken.

- Stokastik Yuvarlama ile Bias’ı Azaltma: Geleneksel (belirleyici) yuvarlama yerine, stokastik yuvarlama, gradyanların her zaman en yakın temsil edilebilir sayıya yuvarlanmasından ziyade, yakınlıklarına göre rastgele yuvarlanmasını sağlamakta. Bu adım, yuvarlama biasını azaltmak, eğitim süresince gradyan akışını korumak ve nihayetinde model doğruluğunu artırmak için gereklidir.

NVFP4 ile 4-Bit Ön Eğitim: Trilyon-Token Ölçeğinde Doğruluk ve Stabilite

Dar hassasiyet formatlarının büyük ölçekli ön eğitimde pratik hale gelmesi için hem model doğruluğunu hem de stabil yakınsamayı sağlamaları gerekmektedir. 4-bit hassasiyetin büyük ölçekli model eğitiminde uygulanabilirliğini değerlendirmek amacıyla, 12 milyar parametreli bir model üzerinde FP8 ve NVFP4 ile deneyler yapılmıştır. Bu model, 10 trilyon token içeren büyük bir veri kümesi kullanarak eğitilmiştir.

12B Hybrid Mamba-Transformer modelinin bir versiyonu başlangıçta 8-bit hassasiyetle eğitilmiş olup—FP8, daha önce yapılan çalışmalarda 16-bit hassasiyetle yakın olduğu gösterilmiştir; bu nedenle karşılaştırma için temel olarak seçilmiştir. Daha sonra, bu 12B model, NVFP4 kullanılarak sıfırdan başarıyla eğitilmiş, bu yeni düşük hassasiyet formatının trilyon-token ölçeğinde tam ön eğitimi destekleyebileceği gösterilmiştir. NVFP4 çalışma süreci, ultra düşük hassasiyet eğitiminde genellikle görülen eğitim istikrarsızlıkları veya sapma sorunları olmadan, stabil bir yakınsama göstermiştir.

NVFP4’ün doğruluk kaybı grafiği, eğitim süresinin tamamında FP8’inkiyle yakından örtüşmektedir. Belirtilen kuantizasyon teknikleri, ileri ve geri geçiş dinamiklerinin, daha agresif bit genişliği azaltımlarına rağmen, daha yüksek hassasiyetli çalışmalarda yakın benzerlik göstermesini sağlamaktadır.

Sonuç: Daha Akıllı Eğitim

12B Hybrid Mamba-Transformer modelini NVFP4 ile ön eğitimden geçirmiş olan geliştiriciler, daha yüksek hassasiyetten FP8 baz alındığında bir dizi alanda performans karşılaştırması yapmışlardır. Seçilen alanlarda, NVFP4’ün FP8 ile performansı karşılaştırılarak, doğruluklarının eşit olduğu gözlemlenmiştir. Bu bulgu, NVFP4’ün, trilyon-token ölçeğinde LLM’lerin ön eğitimi için sağlam bir seçenek olduğunu güçlendirirken, büyük ölçekli model eğitimi için potansiyelini vurgulamaktadır.

NVIDIA’nın NVFP4 formatı, YZ eğitim sahasını yeniden tanımlamakta ve hız, verimlilik ve amaçlı yenilik için yeni bir ölçüt belirlemektedir. 4-bit ön eğitimi mümkün kılan NVFP4, YZ fabrikalarının daha hızlı ve sürdürülebilir bir şekilde ölçeklenmesine olanak tanımakta, yaratıcı YZ’nin geleceğine kapı açmaktadır. Bu çığır açan hesaplama verimliliği, gelişmiş mimariler, daha büyük eğitim çalışmaları ve önemli ölçüde daha fazla token sunarak, zeki sistemler alanında geleceği yönlendirmektedir.