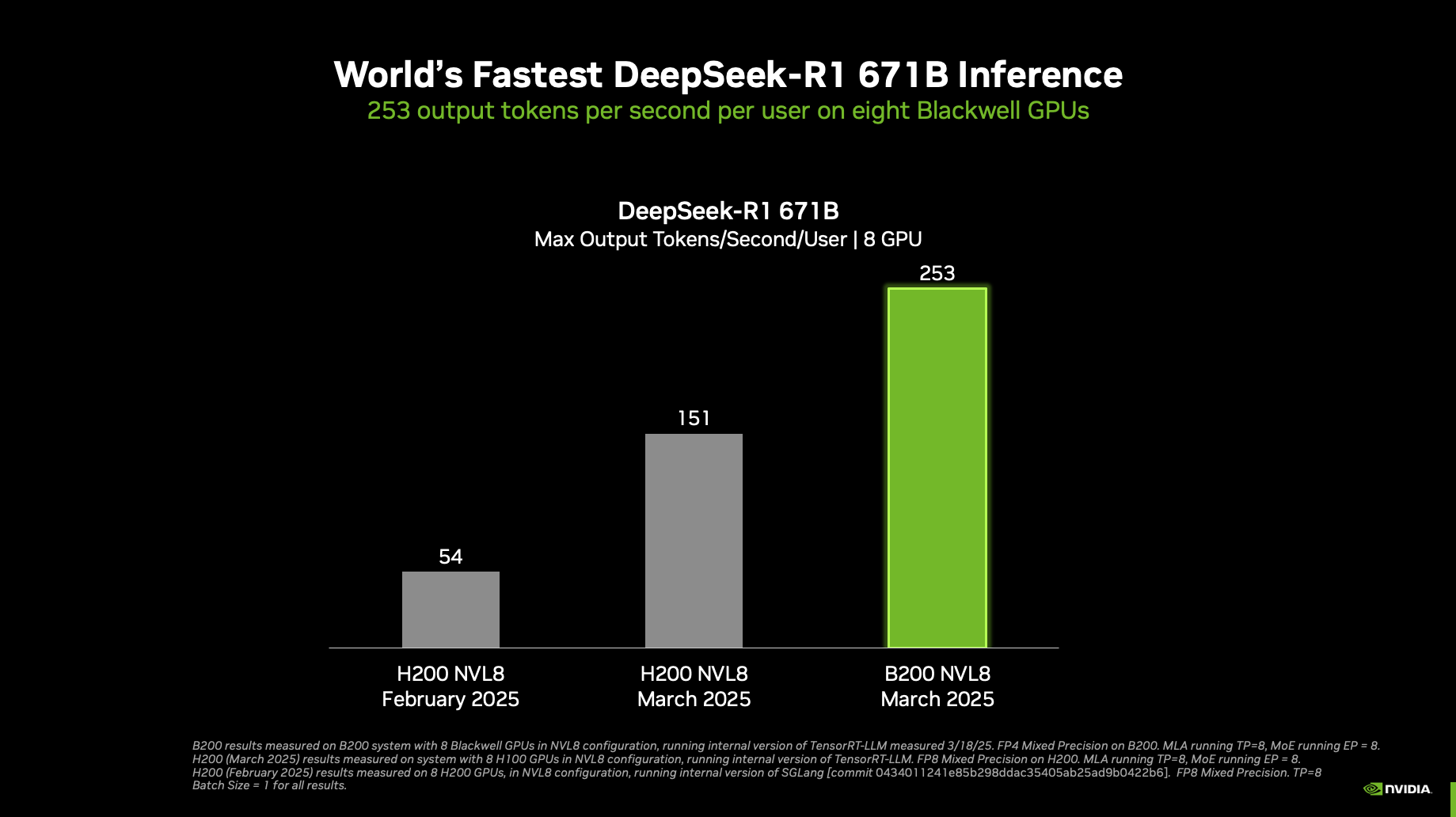

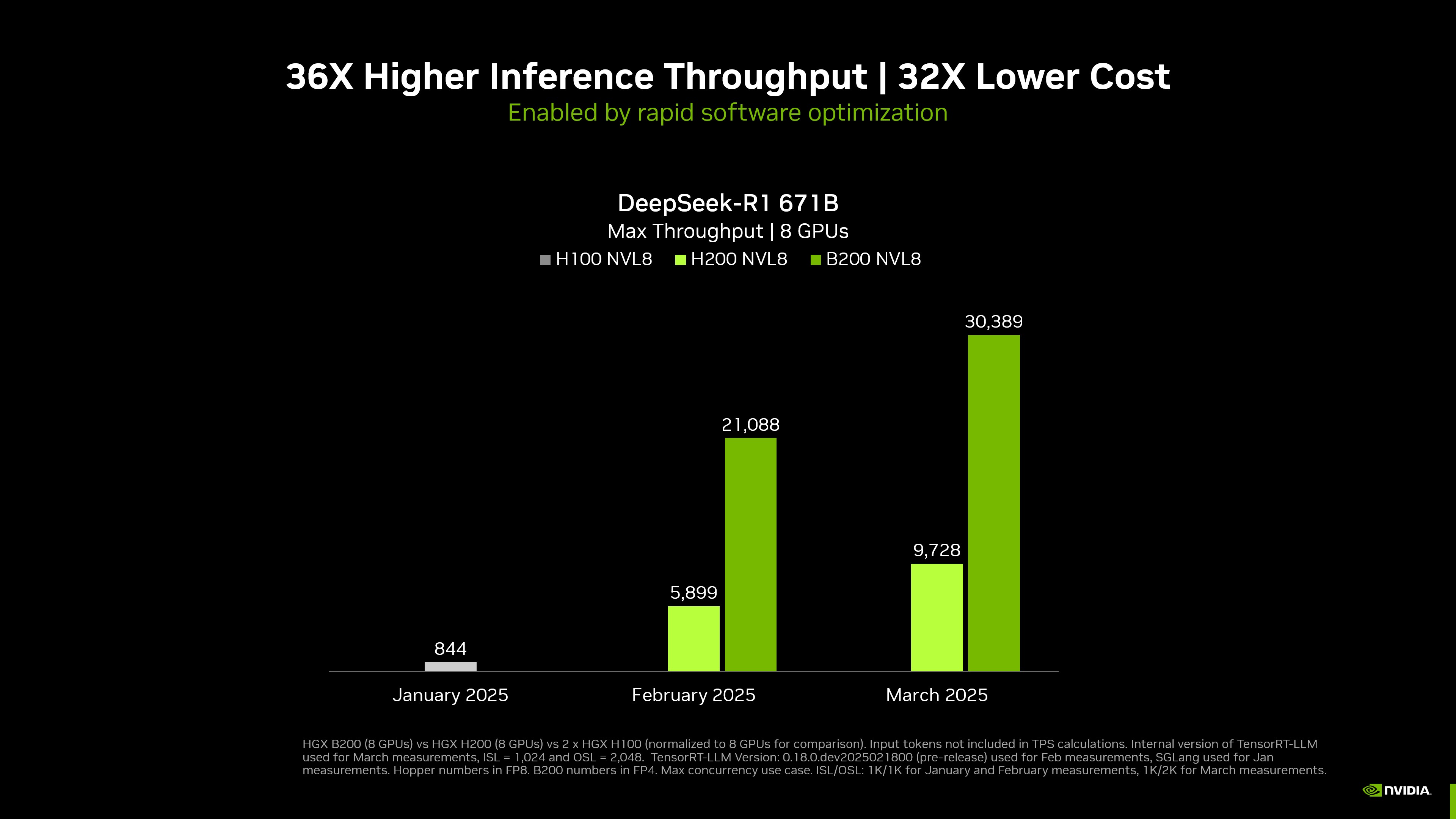

NVIDIA, 2025 GTC etkinliğinde dünyanın en yüksek DeepSeek-R1 çıkarım performansını duyurdu. Tek bir NVIDIA DGX sistemi, sekiz NVIDIA Blackwell GPU’su ile, kullanıcı başına saniyede 250’den fazla token işleme kapasitesine ulaşabilirken, devasa 671 milyar parametreli DeepSeek-R1 modelinde toplamda 30,000 token/saniye üzeri bir verimlilik sunmaktadır. Bu hızlı gelişmeler, NVIDIA’nın açık ekosistemi üzerinden optimize edilen çıkarım geliştirme araçları sayesinde mümkün olmuştur. Bu araçlar, NVIDIA Blackwell mimarisi için yeniden yapılandırılmıştır.

Bu performans rekorlarının daha da artması bekleniyor, çünkü NVIDIA platformu, en yeni Blackwell Ultra GPU’larıyla ve Blackwell GPU’larıyla çıkarımın sınırlarını zorlamaya devam ediyor.

Tek bir DGX B200 8-GPU sistemi ve tek bir DGX H200 8-GPU sistemi verileri | B200 ve H200’ün mevcut sayıları, iç sürüm TensorRT-LLM üzerinde | Mart, Girdi 1,024 token, çıktı 2,048 token; Şubat ve Ocak: 1,024 girdi token, 1,024 çıktı token | Eş zamanlılık 1 | B200 FP4, H100 ve H200 FP8 hassasiyeti.

Maksimum verimlilik, 8-GPU sistemi üzerinden normalize edilmiştir | tek bir DGX B200 8 GPU sistemi, tek bir DGX H200 8 GPU sistemi, iki DGX H100 8 GPU sistemi normalize edilmiştir | İç sürüm TensorRT-LLM | Mart, Girdi 1,024 token, çıktı 2,048 token; Şubat ve Ocak: 1,024 girdi token, 1,024 çıktı token | Eş zamanlılık MAKSİMUM | B200 FP4, H200/H100 FP8 hassasiyeti.

NVIDIA’nın çıkarım ekosistemi, dünyada en büyük olanıdır. Geliştiricilerin, maksimum kullanıcı deneyimini veya maksimum verimliliği hedeflemeleri için çözümler geliştirmelerini sağlar. NVIDIA’nın ve topluluğun sağladığı açık kaynak araçlar, en son Blackwell mimarisi ve yazılım yeniliklerinden yararlanmak üzere optimize edilmiştir.

Bu Blackwell yenilikleri arasında, FP4 hızlandırması ile beşinci nesil Tensor Cores ile %500’e kadar daha fazla AI hesaplama, önceki nesile kıyasla iki kat daha fazla NVIDIA NVLink bant genişliği ve çok daha büyük NVLink alanlarına ölçeklenebilme yer almaktadır. Bu performans iyileştirmeleri, hem çip düzeyinde hem de veri merkezi ölçeğinde, yüksek verimlilik ve düşük gecikme süreleri için kritik bileşenlerdir.

Yüksek Performans için Yazılım ve Donanım İşbirliği

Hızlandırılmış hesaplama, sadece güçlü bir donanım altyapısı gerektirmekle kalmayıp, aynı zamanda optimize edilmiş ve hızla gelişen bir yazılım yelpazesine de ihtiyaç duyar. Bu, hem günümüzün en zorlu iş yüklerinde optimal performansı sağlamayı hem de ortaya çıkacak yeni, daha zorlu iş yüklerine hazırlıklı olmayı içerir. NVIDIA, teknoloji yelpazesinin her katmanını—çipler, sistemler, kütüphaneler, algoritmalar ve daha fazlasını—optimize etmeye devam ederek mükemmel iş yükü performansı sunmaktadır.

Bu yazı, NVIDIA Blackwell platformundan en iyi şekilde yararlanmak için NVIDIA’nın çıkarım ekosisteminde yapılan birçok güncellemenin bir genel görünümünü sunmaktadır. Bu güncellemeler arasında şunlar bulunmaktadır: NVIDIA TensorRT-LLM, NVIDIA TensorRT, TensorRT Model Optimizer, CUTLASS, NVIDIA cuDNN ve popüler AI çerçeveleri olarak, PyTorch, JAX ve TensorFlow. Ayrıca, sekiz Blackwell GPU’ya sahip bir NVIDIA DGX B200 sistemi üzerinde yapılan yeni performans ve doğruluk verilerini de paylaşıyoruz.

NVIDIA TensorRT Ekosistemi

NVIDIA TensorRT ekosistemi, geliştiricilerin NVIDIA GPU’larındaki üretim çıkarım dağıtımlarını optimize etmelerini sağlamaktadır. TensorRT Model Optimizer, çıkarım hızını optimize etmek için ilk adımı temsil eder. Model optimizasyon tekniklerini içerir ve bu teknikler, çıkarım sırasında daha verimli hale getirmek için kuantizasyon, damıtma, budama ve spekülatif kodlama gibi ileri düzey yöntemleri uygular. Son TensorRT Model Optimizer 0.25 sürümü Blackwell FP4’ü hem eğitim sonrası kuantizasyon (PTQ) hem de kuantizasyon bilinciyle eğitim (QAT) için desteklemektedir.

Model optimize edildikten sonra, modelin verimli bir biçimde çalıştırılması için yüksek performanslı bir çıkarım çerçevesi gereklidir. TensorRT-LLM, geliştiricilerin gerçek zamanlı, bütçe ve enerji açısından verimli LLM çıkarımı sağlamalarına yardımcı olan bir araç kutusunu sunmaktadır. Son TensorRT-LLM 0.17 sürümü, Blackwell desteği ekleyerek Blackwell talimatları, bellek hiyerarşisi ve FP4 için özel optimizasyonlar sağlamıştır.

TensorRT-LLM, PyTorch ile yapılandırılmıştır ve yaygın LLM çıkarım işlemleri için güçlü ve esnek çekirdekler ile, olağanüstü çalışma zamanı özellikleri sunmaktadır.

Blackwell ile TensorRT Aracılığıyla Gelişmiş Performans

Blackwell mimarisi ve TensorRT yazılımı, çıkarım performansını önemli ölçüde geliştirmektedir. Bu performans artışı, belirgin şekilde daha yüksek hesaplama performansı ve bellek bant genişliği ile entegre yazılım yelpazesinden kaynaklanmaktadır.

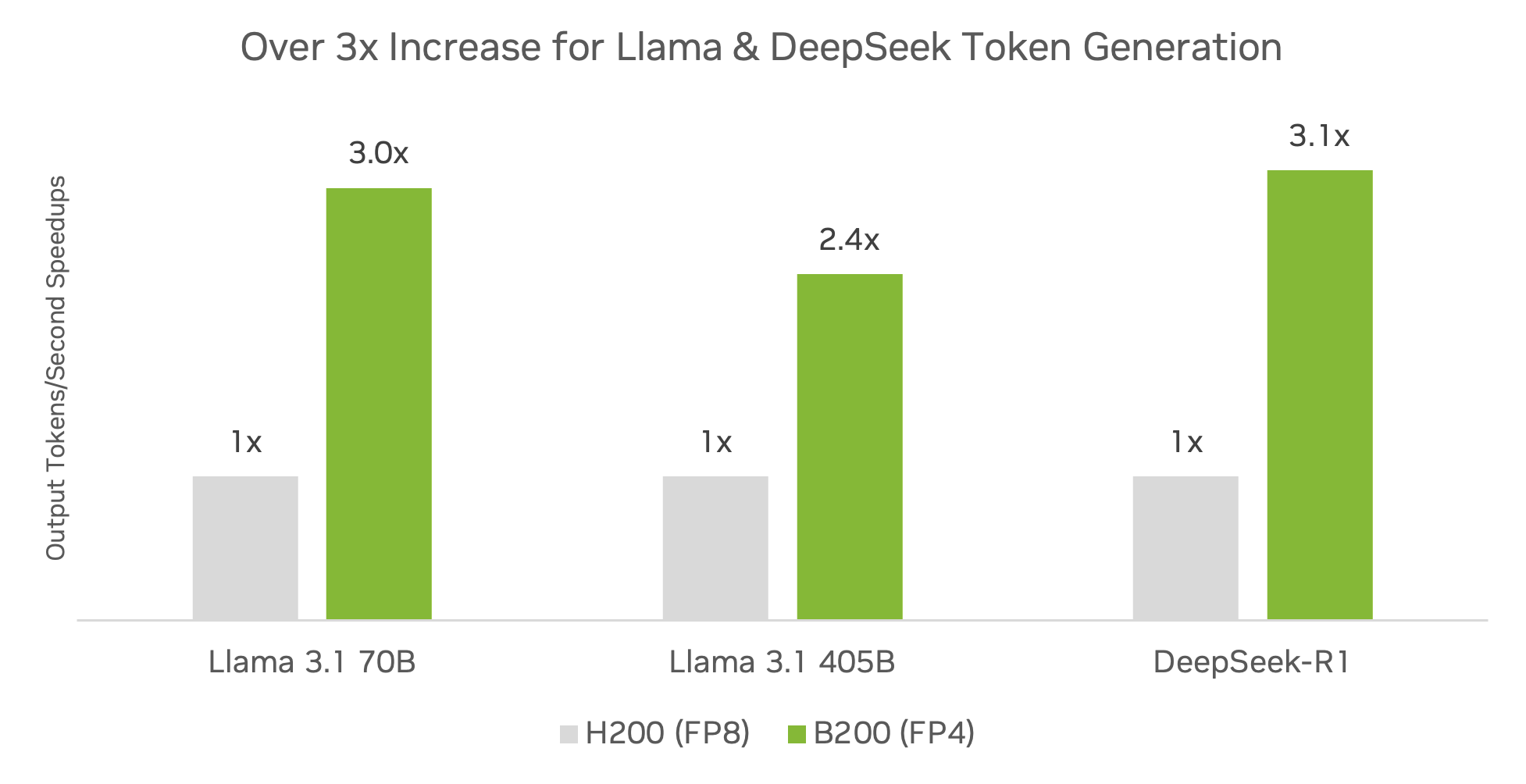

Yaygın topluluk modelleri olan DeepSeek-R1, Llama 3.1 405B ve Llama 3.3 70B üzerinde, tensor RT yazılımı kullanan DGX B200 platformu, zaten DGX H200 platformuna göre 3 kat daha fazla çıkarım verimliliği sağlamaktadır.

Önizleme spesifikasyonları. Değişikliklere tabi olabilir. TensorRT Model Optimizer v0.23.0. TensorRT-LLM v0.17.0. Maksimum yığın boyutu 2048, gerçek yığın boyutu TensorRT-LLM Eş zamanlı Yığınlama ile dinamik olarak ayarlanır. H200 FP16/BF16 GEMM + FP8 KV önbelleği. B200 FP4 GEMM + FP8 KV önbelleği. Verimlilik hızlandırması.

Llama 3.3 70B: Giriş 2048, Çıkış 128

Llama 3.1 405B: Giriş 2048, Çıkış 128

DeepSeek-R1: Giriş 1024, Çıkış 1024

Kuantizasyona tabi tutulukken, düşük hassasiyetteki modellerin minimal doğruluk kaybını koruması kritik öneme sahiptir. DeepSeek-R1 için, TensorRT Model Optimizer FP4 eğitim sonrası kuantizasyon (PTQ), çeşitli veri setleri üzerinde FP8 temel alınan modele kıyasla minimal doğruluk kaybı vermektedir. Bu durum, Tablo 1’de gösterilmektedir.

| MMLU | GSM8K | AIME 2024 | GPQA Diamond | MATH-500 | |

| DeepSeek R1-FP8 | 90.8% | 96.3% | 80.0% | 69.7% | 95.4% |

| DeepSeek R1-FP4 | 90.7% | 96.1% | 80.0% | 69.2% | 94.2% |

Doğruluk sonuçları, popüler Llama 3.1 405B ve Llama 3.3 70B modelleri için burada sağlanan BF16 hassasiyeti ile FP4 kuantizasyonu üzerine sunulmuştur.

| MMLU Temel | GSM8K Temel | |

| Llama 3.1 405B-BF16 | 86.5% | 96.3% |

| Llama 3.1 405B-FP4 | 86.1% | 96.1% |

| Llama 3.3 70B-BF16 | 82.5% | 95.3% |

| Llama 3.3 70B-FP4 | 80.5% | 92.6% |

Düşük hassasiyetlerde, özellikle FP4 olanlarda dağıtımda, QAT uygulanarak doğruluğun geri kazanılması mümkündür; bu, yeterli ince ayar veri setleri sağlandığında geçerlidir. QAT’ın avantajını göstermek için, NVIDIA’nın Nemotron 4 15B ve Nemotron 4 340B modelleri, TensorRT Model Optimizer kullanılarak FP4’e kuantize edilmiştir ve BF16 temel almaya göre kayıpsız FP4 kuantizasyonu elde edilmiştir.

Görsel Üretimde Verimliliği Artırma

Daha önce, TensorRT ve TensorRT Model Optimizer, hem INT8 hem de FP8 veri formatlarına kuantize edilmiş yaygın modellerle yüksek performanslı görsel üretimi mümkün kılmıştır. Artık, NVIDIA Blackwell ve FP4 hassasiyeti, yapay zeka ile görsel üretiminde daha iyi bir performans sunmaktadır. Bu avantajlar, NVIDIA GeForce RTX 50 serisi GPU’lar ile lokaal olarak görsel üretmek isteyen kullanıcılara da genişlemektedir.

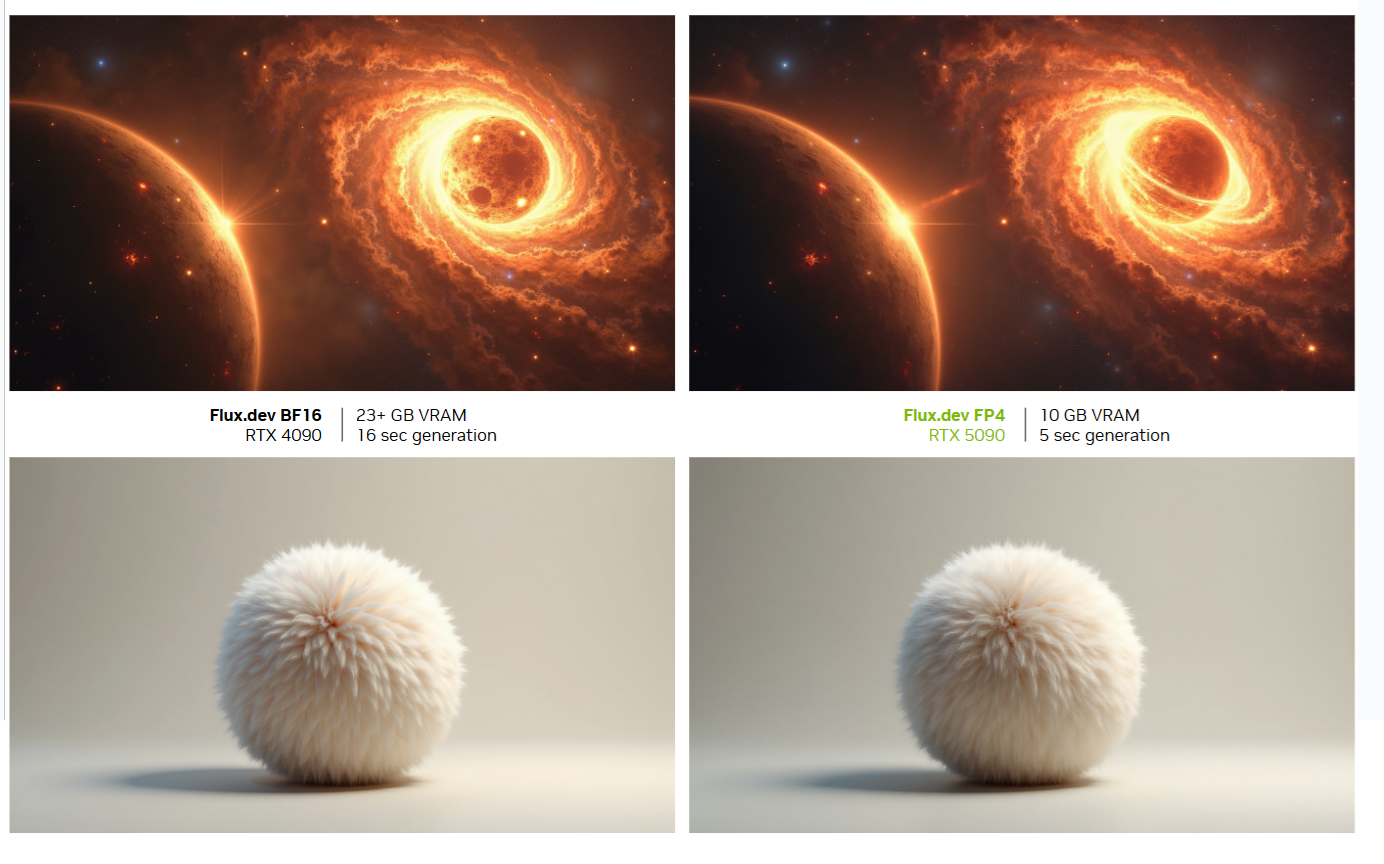

Flux.1 model ailesi, Black Forest Labs tarafından sağlanan son teknoloji metinden görüntüye modellerdir ve karmaşık sahneleri oluşturma ve talep edilen prompt’lara uyum sağlamada üst düzey bir performans sunmaktadır. Geliştiriciler, Black Forest Laboratuvarları’nın Hugging Face koleksiyonlarından FP4 Flux modellerini indirerek, TensorRT ile doğrudan dağıtım yapabilirler.

Bu kuantize edilmiş modeller, Black Forest Labs tarafından TensorRT Model Optimizer FP4 iş akışları ve tarifleri kullanılarak üretilmiştir. Blackwell’deki FP4 görsel üretiminin faydalarını göstermek için bir Flux.1-dev modeli, FP16’ya kıyasla saniye başına görsel başına 3 kat hızlanma sağlarken, VRAM kullanımını %5.2 oranında azaltmakta ve görsel kalitesini korumaktadır (Tablo 4).

Sadece Flux.1-dev’deki transformer omurgası FP4’e kuantize edilmiştir, diğer parçalar BF16 formatında kalmıştır. TensorRT’nin düşük VRAM modunda, T5, CLIP, VAE ve FLUX transformer, ihtiyaç duyuldukça yüklenir ve iş tamamlandığında boşaltılır. Bu durum, FLUX’un tepe bellek kullanımı, bu dört farklı modelin boyutlarıyla aynı sınırda kalmasını sağlar; ancak çıkışta yükleme ve boşaltma işlemleri nedeniyle ekstra gecikmelere neden olur.

| VRAM Kullanımı (GB) | VRAM Kullanımı Sıkıştırması | |

| FP16 (Temel) | 51.4 | 1x |

| FP16 düşük-VRAM | 23.3 | 2.2x |

| FP8 | 26.3 | 1.9x |

| FP8 düşük-VRAM | 19.9 | 2.6x |

| FP4 | 19.5 | 2.6x |

| FP4 düşük-VRAM | 9.9 | 5.2x |

Şekil 5, FP4 ile kuantize edilmiş bir Flux modelinin ürettiği görselleri göstermektedir. Görsel kalitesi ve içerik açısından BF16 temel alınan modelle tutarlılığı ortaya koymaktadır. Ayrıca, Tablo 5, FP4 görsel kalitesinin nicel bir değerlendirmesini sunmakta ve 1,000 görsel temelinde kapsamlı bir analiz yapılmaktadır.

Üstteki görselin giriş prompt’u: “İki muazzam yıldız, uzayın enginliğinde dans ediyor ve yoğun çekim alanları onları daha da yaklaştırıyor. Bir yıldız bir kara deliğe çökerken, muhteşem bir enerji patlaması yaratıyor ve kozmik arka planda göz alıcı bir ışık gösterisi oluşturuyor. Gaz ve toz bulutları bu muhteşem görüntüyü çevreliyor, içinde barındırdığı hayal edilemez gücü ima ederek.”

Alttaki görselin giriş prompt’u: “Gerçekçi bir küre, beyaz arka planda yumuşak, peluş bir hayvanın tüyleriyle kaplanmıştır. Kenarlarında hafif hareket eden tüyler görseli zenginleştiriyor ve tüylerin gölgelemeleri etkileyici bir görsel etki yaratıyor. Render, yüksek kaliteli ve akıllı bir görünüme sahip.”

| Görsel Değerlendirme | CLIP-IQA | CLIPScore | |

| BF16 | 1.118 | 0.927 | 30.15 |

| FP4 PTQ | 1.096 | 0.923 | 29.86 |

| FP4 QAT | 1.119 | 0.928 | 29.92 |

Flux.1-dev modeli, 30 adım, 1K görsel. TensorRT Model Optimizer v0.23.0 FP4 tarifesi. NVIDIA H100 GPU’larında simüle edilmiştir. Simülasyon, RTX 5090’daki TensorRT çekirdek seviyeleri ile matematiksel olarak aynıdır. Gerçek sonuçlar biraz farklılık gösterebilir.

TensorRT 10.8 güncellemesi artık yüksek performanslı FP4’de Flux.1-Dev ve Flux.1-Schnell modellerini çalıştırabilmektedir. Düşük gelişmiş hızlarda, bu modelleri GeForce RTX 5070 gibi sınırlı bellek yapılandırmasında çalıştırabilirsiniz. Ayrıca, TensorRT, Black Forest Labs tarafından sağlanan Derinlik ve Canny Flux ControlNet’lerini de desteklemektedir. Bunu hemen denemek için TensorRT demo/Diffusion‘a göz atabilirsiniz.

Blackwell ile Derin Öğrenme Primitifleri

2014’te tanıtılan NVIDIA cuDNN, GPU’larda derin öğrenme iş yüklerini hızlandırmada temel bir rol oynamıştır. Temel derin öğrenme primitiflerinin yüksek düzeyde optimize edilmiş uygulamalarını sunarak, PyTorch, TensorFlow ve JAX gibi çerçevelerin en iyi performans sunmasına olanak sağlamıştır. Bu çerçevelerle sorunsuz entegrasyon ve farklı GPU mimarileri üzerindeki optimize edilmiş performans ile, cuDNN, tümleşik derin öğrenme iş yüklerinden eğitim ve çıkarım süreçlerini güçlendiren bir performans motoru konumundadır.

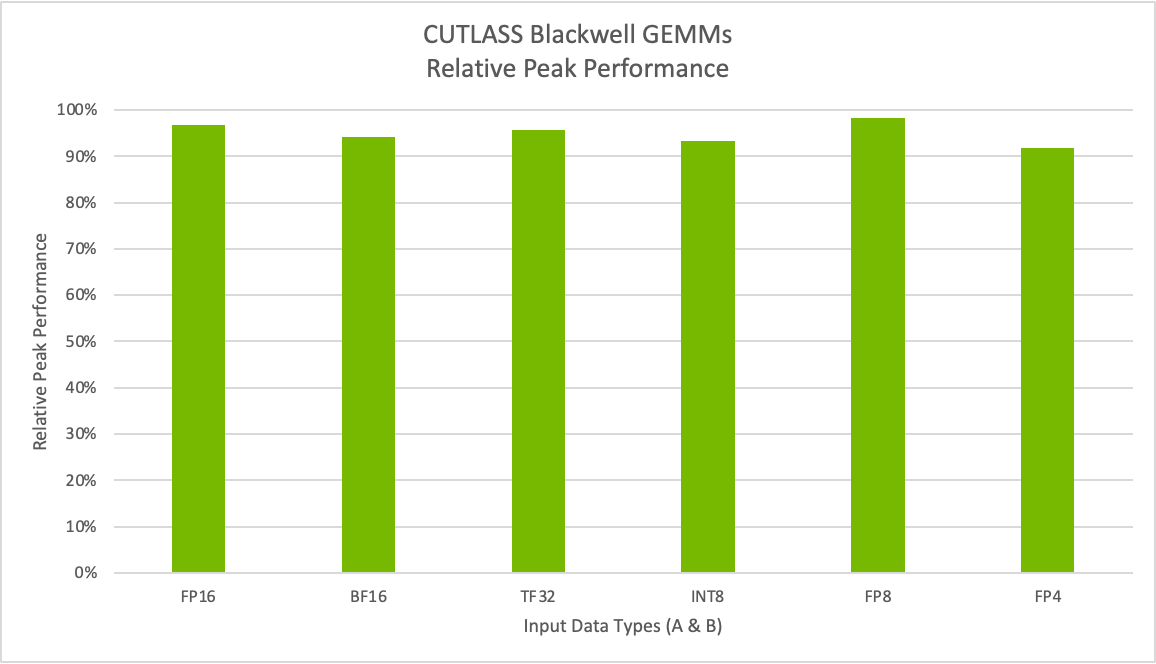

cuDNN 9.7 ile birlikte, hem veri merkezi hem de GeForce ürün grupları için NVIDIA Blackwell mimarisine destek genişletilmektedir. Geliştiriciler, cuDNN uygulamalarını en son Blackwell Tensor Cores’a taşıdıklarında önemli performans iyileştirmeleri bekleyebiliyorlar. Kütüphane, Blackwell’in gelişmiş FP8 ve FP4 işlemlerine yönelik optimize edilmiş genel matris çarpma (GEMM) API’leri sunmaktadır, bu durum geliştiricilerin düşük seviyeli optimizasyon karmaşasıyla uğraşmadan yenilik yapmalarına odaklanmalarını sağlar.

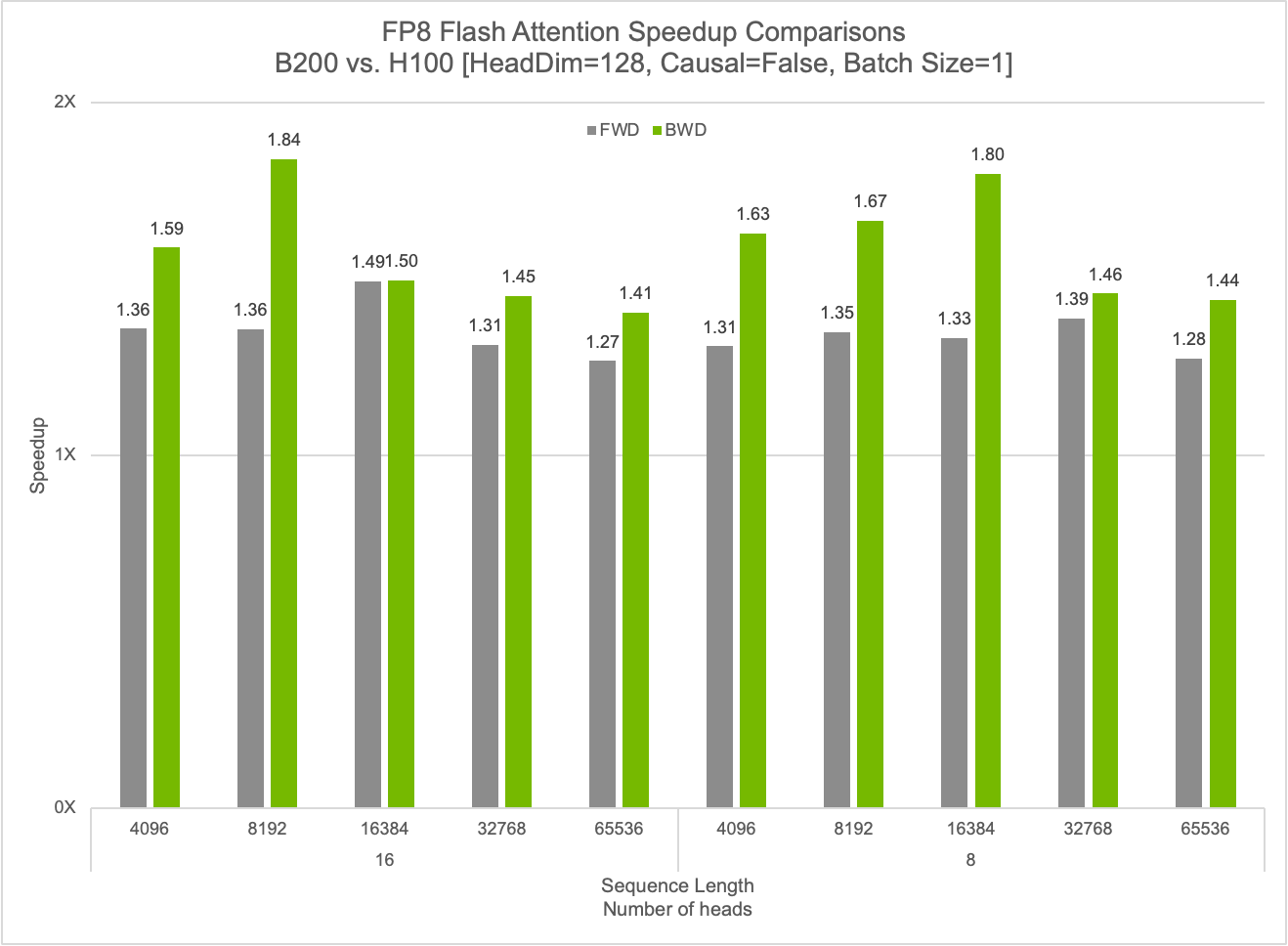

cuDNN, FP8 Flash Attention işlemleri için önemli hızlandırmalar sağlamaktadır; FP8 çekirdekleri ile ileri yayılma sürecinde %50, geri yayılma sürecinde ise %84 oranında hız artışı elde edilmektedir. Kütüphane ayrıca, Blackwell mimarisindeki gelişmiş birleştirme yetenekleri ile birlikte yüksek düzeyde optimize edilmiş GEMM işlemleri sunmaktadır. Gelecekte, cuDNN daha fazla birleştirme desteğini genişleterek derin öğrenme iş yükleri için daha büyük performans kazanımları sağlayacaktır.

Blackwell ile Yüksek Performanslı Çekirdekler

CUTLASS, 2017’deki sunumundan beri, araştırmacılar ve geliştiricilerin NVIDIA GPU’larda yüksek performanslı CUDA çekirdekleri uygulamalarına yardımcı olmuştur. Geliştiricilere, NVIDIA Tensor Cores’a yönelik özel işlemler tasarlama konusunda kapsamlı araçlar sunarak, FlashAttention gibi devrim niteliğindeki algoritmaların gelişiminde kritik bir rol oynamaktadır.

CUTLASS 3.8 ile birlikte, NVIDIA Blackwell mimarisine destek sağlamaktadır. Bu durum, geliştiricilerin en yeni veri türleri ile birlikte en son nesil Tensor Cores’dan yararlanmalarına olanak tanımaktadır. Bu yeni dar hassasiyet MX formatları ve NVIDIA’nın kendine özgü FP4 dahil olmak üzere, geliştiricilerin özel algoritmalarını ve üretim iş yüklerini en son hızlandırılmış hesaplamanın yenilikleri ile optimize etmelerini mümkün kılmaktadır.

Bu kıyaslamalar, B200 sistemi üzerinde gerçekleştirilmiştir. M=K=16384 ve N=17290.

CUTLASS, Blackwell’e popüler özellikler sunarak, Gruplandırılmış GEMM ve Karışık Girdi GEMM işlemlerini getirmektedir. Gruplandırılmış GEMM, MoE modellerini hızlandırmada daha verimli paralel hesaplamalar sunarak önemli avantajlar sağlamaktadır. Karışık Girdi GEMM’leri, LLM’ler için GPU bellek gereksinimlerini azaltarak, model ağırlıkları GPU bellek tüketiminde baskın hale geldiğinde kuantize edilmiş çekirdekleri desteklemektedir.

OpenAI Triton Desteği

OpenAI Triton derleyici şimdi Blackwell desteği sunmakta, geliştiricilerin ve araştırmacıların en yeni Blackwell mimarisi özelliklerinden yararlanmasına olanak tanımaktadır. OpenAI Triton, Blackwell mimarisindeki en son yenilikleri kullanarak birkaç kritik kullanım durumu üzerinde neredeyse optimal performans elde edebilmektedir. Daha fazla bilgi için, OpenAI Triton ile NVIDIA Blackwell Hızlandırıcı AI Performansı ve Programlaması başlıklı yazıya göz atabilirsiniz.

Sonuç

NVIDIA Blackwell mimarisi, çıkarımda büyük hız kazandıran birçok temel yetenek içermektedir. Bu yetenekler arasında, FP4 Tensor Cores ve ikinci nesil Transformer Engine, beşinci nesil NVLink ve NVLink Switch gibi özellikler ile birlikte sunulmaktadır. NVIDIA, 2025 GTC etkinliğinde dünyanın en yüksek DeepSeek-R1 çıkarım performansını duyurdu. Tek bir NVIDIA DGX sistemi, sekiz NVIDIA Blackwell GPU ile kullanıcı başına 250 token/saniye, toplamda 30,000 token/saniye üzerinde çıkarım yeteneğine ulaştı.

Geliştiricilere, günümüz ve yarının AI modelleri için çıkarım performansında önemli artışlar sağlamak üzere optimize edilmiştir ve ayrıca NVIDIA AI Inference platformu hakkında daha fazla bilgi alabilir ve en son AI çıkarım performans güncellemelerinin takibini yapabilirsiniz.

Teşekkür

Bu çalışmanın gerçekleştirilmesi, Matthew Nicely, Nick Comly, Gunjan Mehta, Rajeev Rao, Dave Michael, Yiheng Zhang, Brian Nguyen, Asfiya Baig, Akhil Goel, Paulius Micikevicius, June Yang, Alex Settle, Kai Xu, Zhiyu Cheng ve Chenjie Luo gibi birçok kişinin olağanüstü katkıları olmadan mümkün olamazdı.