Yapay zeka yetenekleri geliştikçe, donanım ve yazılım altyapısı seçimlerinin iş yükü performansı üzerindeki etkilerini anlamak, hem teknik doğrulama hem de iş planlaması için kritik hale geliyor. Kurumların, sadece ham FLOP’ları veya GPU başına saatlik maliyetleri karşılaştırmak yerine, gerçek dünya, uçtan uca AI iş yükü performansını ve toplam sahip olma maliyetini değerlendirmek için daha iyi bir yola ihtiyacı var. Optimum AI performansına ulaşmak, sadece güçlü GPU’lardan ibaret değildir. İyi optimize edilmiş bir platform, altyapı, yazılım çerçeveleri ve uygulama düzeyinde iyileştirmeler gerektirir.

AI performansını değerlendirirken bu kritik soruları sormak önemlidir: Uygulamanız doğru mu, yoksa referans mimarileriyle karşılaştırıldığında sizi yavaşlatan hatalar mı var? Optimal küme boyutu nedir? Hangi yazılım çerçeve seçimleri, pazara sürüş sürenizi optimize edecektir? Geleneksel çip düzeyindeki metrikler, bu görevi yerine getirmek için yetersiz kalıyor, bu da yatırımların yeterince kullanılamamasına ve verimlilik kazanımlarının kaçırılmasına yol açıyor. AI iş yükünüzün ve altyapınızın performansını ölçmek, kritik bir öneme sahiptir.

Bu yazı, AI iş yükleri ve platformları arasında eğitim ve çıkarım performansını değerlendiren NVIDIA DGX Cloud Benchmarking aracını tanıtıyor. Bu araç, sadece GPU’ları değil, altyapı yazılımı, bulut platformları ve uygulama yapılandırmalarını da dikkate alarak performansı değerlendiriyor. Bu yazı, DGX Cloud Benchmarking’in yeteneklerini ve uygulamalarını detaylandırarak, eğitim süresi ile maliyetinde yaşanan iyileşmeleri gösteriyor.

DGX Cloud Benchmarking ile NVIDIA, platform performansını değerlendirmenin standart ve nesnel bir yolunu sağlamayı hedefliyor, bu yaklaşım NVIDIA’nın kendine ait donanım ve altyapısında sağladığı nesnel ve ilgili performansta benzerlik gösteriyor.

TCO Optimizasyonu için Benchmarking Gereksinimleri

Kapsamlı testlerimiz sonrasında topladığımız veriler, GPU sayısı, veri hassasiyeti ve çerçeve ile ilgili olarak zaman ve maliyetle ilgili tutarlı kalıplar gösteriyor. Kurumlar, bu verileri değerlendirerek, aşamaları keşfedebilir ve karar alma süreçlerini hızlandırabilir.

GPU Sayısı

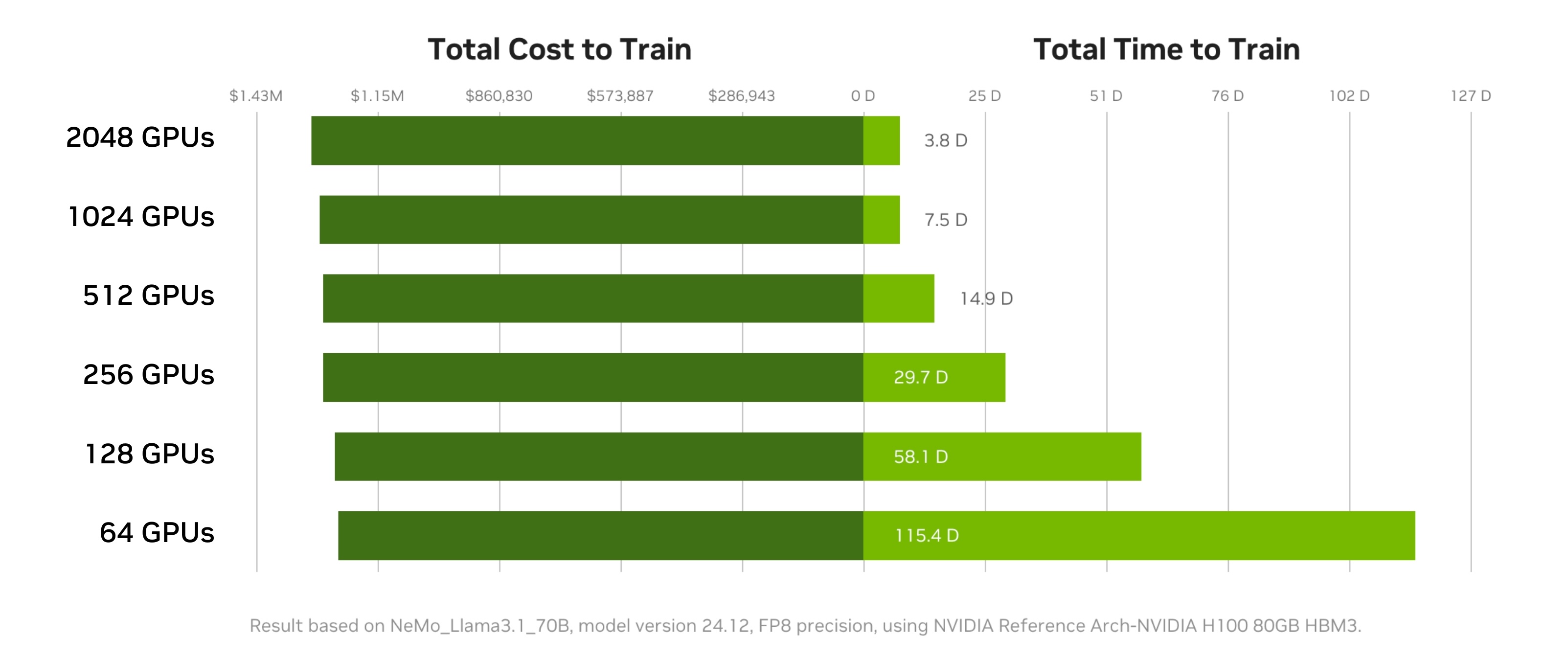

AI eğitim kümelerinde GPU sayısını artırmak, toplam eğitim süresini önemli ölçüde azaltabilirken, maliyetleri mutlaka artırmayabilir. Daha fazla GPU eklemek, AI işlerinin daha hızlı tamamlanmasını sağlarken, ekiplerin ölçeklendirme ve maliyet ile ilgili ilişkileri keşfetmeleri önemlidir. Örneğin, Llama 3 70B’yi eğitirken, 1 trilyon token’ı eğitme süresini %97 oranında azaltabilirsiniz (115,4 gün → 3,8 gün) ve maliyet artışı sadece %2,6’dır.

GPU sayısını artırmak, iş yükü paralelleşmesi konusunda esneklik sunarak daha hızlı iterasyon döngüleri ve hipotez doğrulama süreçlerini hızlandırabilir. Daha büyük ölçekle eğitim yapmak, genel AI geliştirme zaman çizelgelerini ve geliştirici verimliliğini hızlandırabilir. Kurumlar ek GPU’lara erişim sağladıklarında, eğitim işleri daha kısa sürede tamamlanabilir ve bu, toplam maliyet artışı olmadan gerçekleşebilir. Eğitim çalışmalarının daha hızlı tamamlanması, eğitilmiş modelin daha kısa sürede kullanılabileceği anlamına gelir.

Mükemmel lineer ölçekleme pratikte nadiren elde edilir. Ancak, iyi optimize edilmiş AI iş yükleri bu ideale çok yaklaşabilir. Yüksek GPU sayılarında mükemmel doğruluktan sapmalar, genellikle artan iletişim yüksekliğinden kaynaklanmaktadır. GPU sayılarının stratejik olarak artırılmasıyla, ekipler projelerin hedefleri, mevcut kaynaklar ve öncelikler doğrultusunda optimizasyon yapabilirler.

NVIDIA DGX Cloud Benchmarking Performans Keşif Aracı kullanarak, kullanıcılar, toplam eğitim süresini ve maliyetlerini en aza indiren ideal GPU sayısını belirleyebilirler. Amaç, belirli bir iş yükü için maksimum verimlilik ve en düşük masrafı sağlayan doğru GPU sayısını tespit etmektir.

Hassasiyet

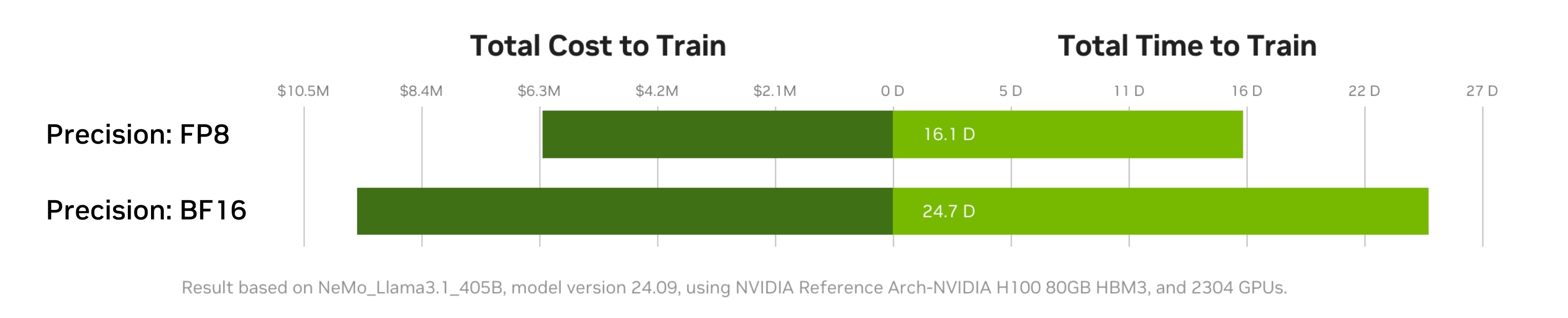

FP8 hassasiyeti kullanmak, BF16 yerine, model eğitimini önemli ölçüde hızlandırabilir ve maliyet verimliliği sağlayabilir. FP8 hassasiyetinin kullanımı, modelin çözüme ulaşma süresini hızlandırarak eğitim maliyetlerini düşürür. FP8, daha yüksek matematik veya iletişim verimliliği ve daha düşük bellek bant genişliği gereksinimleri ile daha büyük modellerin daha az GPU ile eğitilmesini mümkün kılar.

AI iş yüklerini, platformunuz tarafından desteklenen en düşük hassasiyet türüne taşımak önemli tasarruflar sağlayabilir. Şekil 2, NVIDIA Hopper mimarisi GPU’larında FP8’in BF16’ya göre daha yüksek çıkış verimliliği (token/saniye) sağladığını gösteriyor.

FP8 ile eğitim yapmanın bazı zorlukları da vardır; örneğin, dar bir dinamik aralık sunması bu durumu kritik hale getirebilir. Bu belgeler, istikrar sağlamak için FP8 ile çalışabilecek işlemleri tespit etmek için özel teknikler gerektirir. Bununla birlikte, Hopper ve Blackwell mimarilerinde yer alan Transformer Engine gibi özellikler, geliştiricilerin FP8’i seçici olarak her katmanda kullanmalarına yardımcı olabilir. Böylece, doğruluğu olumsuz etkileyebilecek yerlerde daha düşük hassasiyet kullanılabilir.

Ayrıca, FP8’de eğitim yapılan bir model, doğrudan FP8 çıkarımı için dağıtılabileceğinden, çıkarım maliyetlerini azaltabilir. BF16 ile eğitilen modeller daha sonra FP8/INT8’e, kuantizasyon farkındalığı ile eğitim (QAT) veya son eğitim sonrası kuantizasyon (PTQ) kullanılarak dönüştürülebilir ve benzer çıkarım performansı faydaları elde edilebilir.

DGX Cloud Benchmarking Tarifleri, FP8 hassasiyeti ile platform performansını en üst düzeye çıkarmak için en iyi uygulamaları sunar ve karşılaştırma için örnek temel sonuçlar sağlar.

Çerçeve

Doğru AI çerçevesini seçmek, eğitim hızını önemli ölçüde artırabilir ve maliyetleri düşürebilir, hatta aynı modeller ve donanım yapılandırmalarında bile. Çerçeve seçimleri performansı etkileyen farklılıklar içerir:

- İş yükü altyapısı parmak izi: Çerçevenin temel altyapı ile etkileşimi

- İletişim kalıpları: Düğümler arasındaki veri alışverişinin verimliliği

- Sürekli optimizasyon çabaları: Çerçeve geliştiricileri, güncellemeler aracılığıyla performansı sürekli olarak artırıyor.

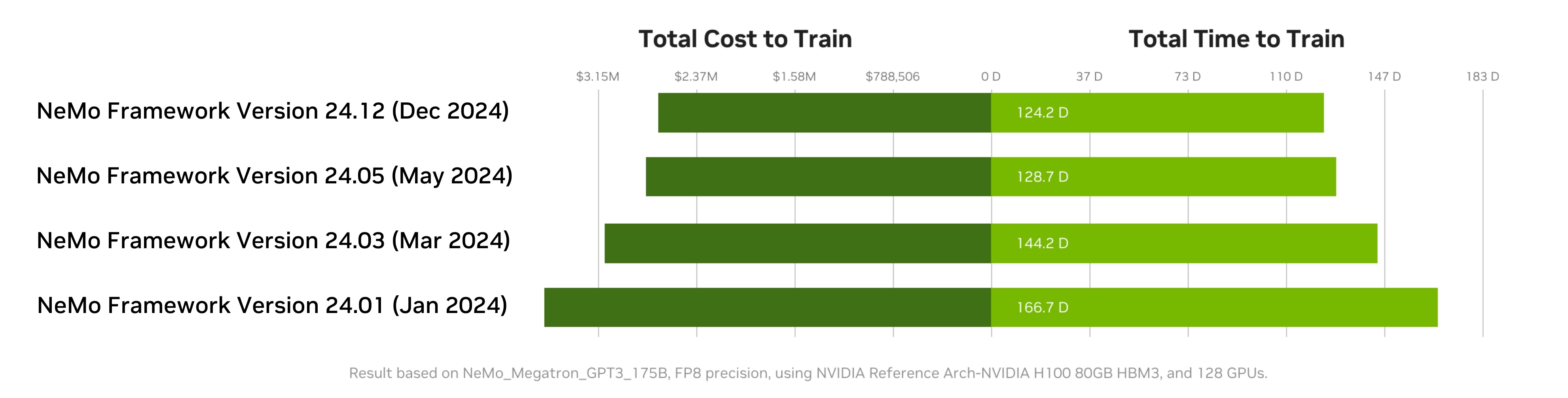

Performansı en üst düzeye çıkarmak için, sürekli gelişen AI ekosistemine uyum sağlayan ve devam eden optimizasyonlardan yararlanan bir çerçeve seçmek kritik öneme sahiptir. Çerçeve optimizasyonu zamanla büyük ölçüde genel platform performansını artırabilir ve toplam sahip olma maliyetini iyileştirebilir.

Şekil 3, en son NVIDIA NeMo Çerçevesi versiyonlarının benimsenmesinin eğitim verimliliğini önemli ölçüde artırabileceğini gösteriyor. Örneğin, 2024 yılında NeMo yazılım optimizasyonu, derin donanım ve yazılım mühendisliği sayesinde toplam platform performansında %25’lik bir artış sağladı ve kullanıcılar için orantılı maliyet tasarrufu sağladı.

NVIDIA, çerçeve yapılandırmalarını optimize etme konusunda uzman rehberliği sunar. NVIDIA Performans Mimarları, ekiplerle iş birliği yaparak DGX Cloud altyapısında iş yüklerini benchmark etmeye, sonuçları analiz etmeye ve belirli iş yüklerine yönelik önerilerde bulunmaya yardımcı olabilir. İş birliğine başlamak için bizimle iletişime geçin.

Eko Sistemi İş Birliği ve Gelecek Görünümü

DGX Cloud Benchmarking Tariflerini kullanarak, NVIDIA gerçek kullanıcı iş yüklerini tanımlar ve optimizasyonların pratik senaryolara dayandığından emin olur. Sürekli performans değerlendirmesi, ilk altyapı doğrulamasının ötesinde, sağlanan çıkarımın teorik spesifikasyonlara yakın olmasını sağlar. Bu performans tariflerini erken benimseyenler arasında başlıca bulut sağlayıcıları olan AWS, Google Cloud, Microsoft Azure ve Oracle Cloud ile NVIDIA bulut ortakları olan CoreWeave, Crusoe ve Nebius bulunmaktadır.

DGX Cloud Benchmarking, hızla gelişen AI endüstrisiyle birlikte evrim geçirecek şekilde tasarlanmıştır. Düzenli güncellemeler yeni modelleri, ortaya çıkan donanım platformlarını ve yenilikçi yazılım optimizasyonlarını içerecek şekilde güncellenmektedir. Bu sürekli evrim, kullanıcıların, teknolojik gelişmelerin benzersiz hızlarla gerçekleştiği bir sektörde, her zaman en güncel ve ilgili performans verilerine erişim sağlamasını garantiler.

Başlayın

DGX Cloud Benchmarking sayesinde, kuruluşlar, AI platform verimliliğini değerlendirmek için standartlaşmış, nesnel metriklere güvenebilir. İster bir AI geliştirme ekibi bir sonraki projesini planlıyor olsun, ister bir IT ekibi altyapı performansını doğrulamaya çalışıyor olsun, DGX Cloud Benchmarking ihtiyaç duydukları araçları sunarak zirve AI performansını açığa çıkartmalarına yardımcı olur.

Platformlarınızı karakterize etmek için DGX Cloud Benchmarking’i keşfedin. Hesaplanabilir Trade-Off’ları niceliklendirmek için LLM Benchmarking Koleksiyonu ile başlayın. NVIDIA GTC 2025‘te bizimle birlikte benchmarking konularını tartışmak ve DGX Cloud Benchmarking’i keşfetmek için katılın.