Yapay Zeka’nın Yenilikçi Gücü

Yapay zeka, geleneksel makine öğrenimi yöntemlerinin oluşturmakta zorlandığı tamamen yeni içerikler yaratma yeteneğine sahiptir. Doğal dil işleme (NLP) alanında, büyük dil modellerinin (LLMs) önü açmasıyla birlikte birçok yenilikçi ve yaratıcı yapay zeka kullanımı ortaya çıkmıştır. Bu kullanımlar arasında müşteri destek chatbotları, sesli asistanlar, metin özetleme ve çeviri gibi, daha önce insanlar tarafından gerçekleştirilen görevler yer almaktadır.

LLM’ler, parametre sayısını artırma ve Mixture of Experts (MoE) gibi yeni algoritmaların benimsenmesi gibi çeşitli yaklaşımlar aracılığıyla gelişmeye devam etmektedir. LLM’lerin uygulama ve uyarlamaları, perakende, üretim ve finans gibi birçok sektörde beklenmektedir.

Ancak, günümüzdeki LLM liderleri arasında yer alan birçok model, Japonca gibi İngilizce dışındaki dillerde yetersiz anlama ve performans sergilemektedir. Bunun bir nedeni, eğitim veritabanının yüksek oranda İngilizce veriler içermesidir. Örneğin, GPT-3 veritabanının yalnızca %0.11’i Japonca verilerdir. Daha az eğitim verisine sahip olan Japonca gibi dillerde iyi performans gösteren LLM modellerinin oluşturulması son derece zorlu bir süreçtir.

Bu yazı, Generative AI Accelerator Challenge (GENIAC) projesi kapsamında 172 milyar parametreye sahip bir yapay zeka modelinin eğitiminden elde edilen bilgileri sunmaktadır. Bu proje, NVIDIA Megatron-LM kullanarak Japonca dil anlama alanında yüksek performanslı modellerin eksikliğini gidermeyi amaçlamaktadır.

GENIAC Projesinde LLM-jp Girişimleri

Ekonomi, Ticaret ve Sanayi Bakanlığı (METI), Japonya’nın platform modeli geliştirme yeteneğini artırmak ve yaratıcı çalışmalar yapılmasını teşvik etmek amacıyla GENIAC’ı başlatmıştır. GENIAC, hesaplama kaynakları sağlamış, şirketler ile veri sahipleri arasında eşleştirme desteği sunmuş, küresel teknoloji şirketleriyle işbirliğini teşvik etmiş, topluluk etkinlikleri düzenlemiş ve geliştirilen platform modellerinin performansını değerlendirmiştir.

LLM-jp projesi, tamamen 172 milyar parametreye sahip açık bir model geliştirmek amacıyla GENIAC girişimi için seçilmiştir. LLM-jp 172B, o tarihlerde (Şubat – Ağustos 2024) Japonya’daki en büyük model geliştirmedir ve bu modelin gelişim bilgisinin geniş bir şekilde paylaşılması oldukça anlamlıdır.

LLM-jp, doğal dil işleme ve bilgisayar sistemleri alanındaki araştırmacılar tarafından, büyük ölçekli modellerin genel performans kazanımını ve öğrenme verimliliğini anlamaya yönelik eğitim ilkelerinin matematiksel aydınlatılmasına dair bilgi birikimi toplamak amacıyla, tamamen açık ve ticari olarak sunulabilen modellerin sürekli geliştirilmesi yoluyla başlatılmıştır.

NVIDIA Megatron-LM İle Model Eğitimi

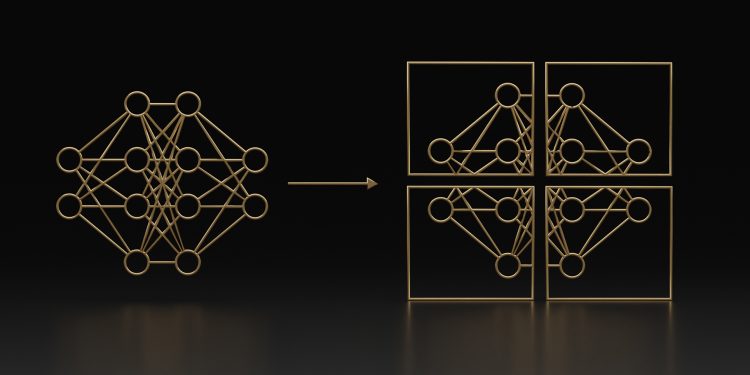

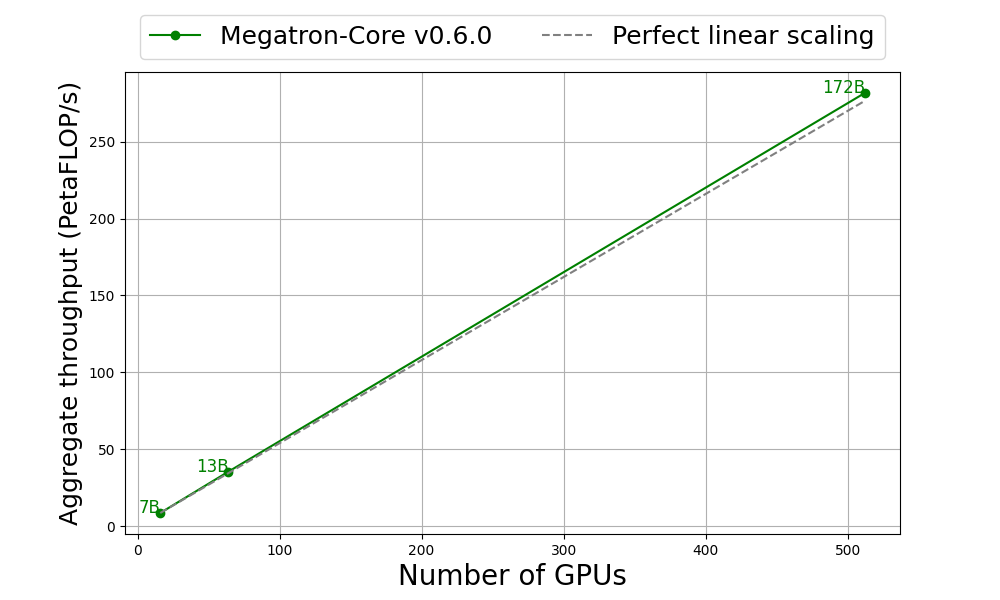

Megatron-LM, büyük dil modellerinin eşsiz hızda eğitimi için Megatron-Core teknolojisini kullanan hafif bir araştırma odaklı çerçevedir. Megatron-Core, büyük ölçekli eğitim için gerekli olan GPU optimizasyon tekniklerini içeren bir açık kaynak kütüphanesidir.

Megatron-Core, tensör, sıra, boru hattı, bağlam ve MoE uzmanı paralelliği gibi bir dizi ileri düzey model paralelliği tekniğini desteklemektedir. Bu kütüphane, özelleştirilebilir yapı taşları, hızlı dağıtılmış kontrol noktası alma gibi eğitim dayanıklılığı özellikleri ve Mamba tabanlı hibrit model eğitimi gibi daha birçok yeniliği sunmaktadır. Tüm NVIDIA Tensor Core GPU’larıyla uyumludur ve Transformer Engine (TE) desteğine de sahiptir.

Model Mimarisi ve Eğitim Ayarları

Bu projenin model mimarisine dair bir genel bakış için Tablo 1’e bakabilirsiniz. Bu mimari, Llama 2 mimarisini takip etmektedir.

| Parametre | Değer |

| Gizli boyut | 12288 |

| FFN ara boyutu | 38464 |

| Katman sayısı | 96 |

| Dikkat başlığı sayısı | 96 |

| Sorgu grupları sayısı | 16 |

| Aktarım işlevi | SwiGLU |

| Pozisyon gömme | RoPE |

| Normalizasyon | RMSNorm |

LLM-jp 172B modeli, proje için geliştirilen multidillli bir veritabanı kullanılarak sıfırdan eğitilmektedir. Bu veritabanı esas olarak Japonca ve İngilizce veriler içermekte olup, eğitim NVIDIA H100 Tensor Core GPU’larla gerçekleştirilmekte ve FP8 hibrit eğitimi ile birlikte Google Cloud A3 Instance üzerinde ilerlemektedir. Deneyde Megatron-Core v0.6 ve Transformer Engine v1.4 kullanılmaktadır.

Eğitim için kullanılan hiperparametre ayarları da Tablo 2’de yer almaktadır.

| Parametre | Değer |

| LR | 1E-4 |

| min LR | 1E-5 |

| LR ISITMA iterasyonları | 2000 |

| Ağırlık çürümesi | 0.1 |

| Grad klip | 1.0 |

| Global toplu boyut | 1728 |

| Bağlam uzunluğu | 4096 |

Bu eğitim sürecinde, PaLM’de kullanılan z-kayıp ve grup-atlama teknikleri eğitim sürecini stabilize etmek için entegre edilmiştir; ayrıca eğitimi hızlandırmak amacıyla flash attention kullanılmıştır.

Diğer eğitim yapılandırmalarını görmek için llm-jp/Megatron-LM‘yi inceleyebilirsiniz.

Eğitim Verimliliği ve Sonuçlar

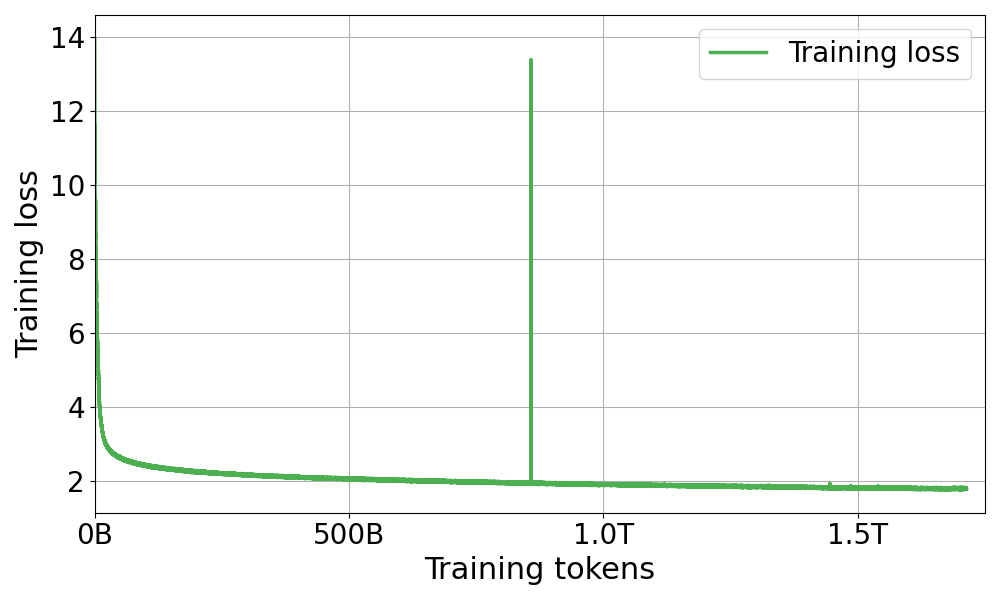

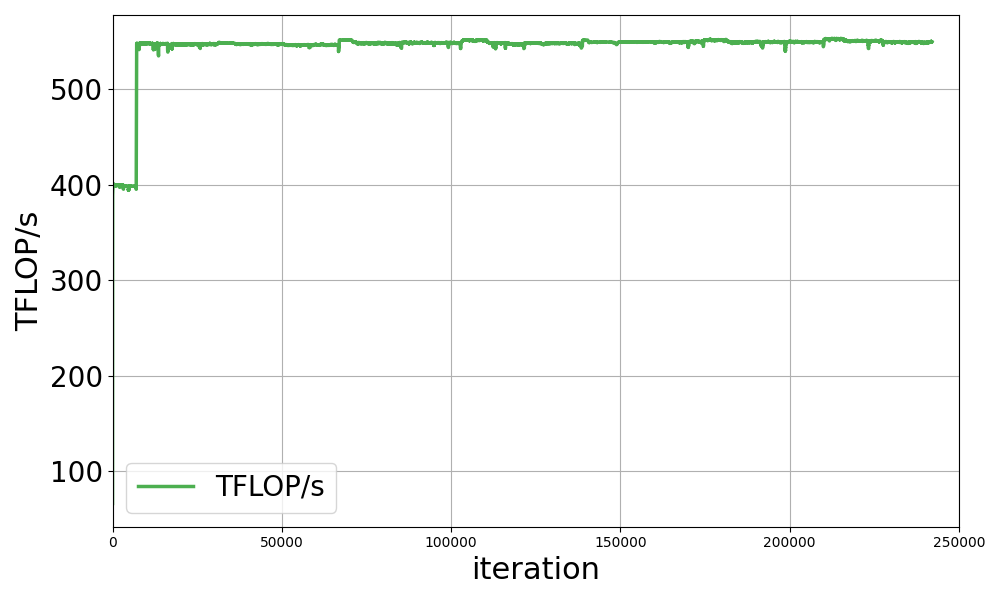

LLM-jp 172B modelinin ön eğitim süreci hâlâ devam etmekte olup, eğitim ilerlemesini izlemek ve Japonca ile İngilizce için aşağıdan yukarıya doğru görevlerde başarılı doğruluk sonuçları sağlamak adına her birkaç bin iterasyonda bir düzenli değerlendirmeler yapılmaktadır (Şekil 1). Şu ana kadar, hedeflenen 2.1 trilyon tokenin %80’inden fazlası tamamlanmıştır.

Özellikle dikkat çekici olan, yaklaşık 7000 iterasyondan sonra TFLOP/s’lerde keskin bir artışın olmasıdır; bu da BF16’dan FP8-hibrit hassasiyete geçiş ile ilişkilidir. Bu deneyde, 7000 iterasyondan önce BF16 ve TE kullanılarak eğitim yapılmıştır; 7000 iterasyondan sonra ise FP8 hibrit ve TE eğitimi uygulanmıştır. Megatron-LM’de, hibrit FP8 eğitimi etkinleştirmek için basit bir seçenek olan –fp8-format ‘hibrit’ kullanılabilir. Bu özelliğin henüz deneysel olduğunu belirtmekte fayda var; daha fazla optimizasyon yakında gelecektir.

Eğitime BF16 ve TE ile başlanıp ardından FP8 hibrite geçilmesinin nedeni, yalnızca BF16 ve FP8 arasındaki token/s performans farkını görmek değil, aynı zamanda başlangıç eğitimini daha kararlı hale getirmektir. Eğitim sürecinin ilk aşamalarında, öğrenme oranı (LR) ısınma nedeniyle artmakta ve bu da instabilite yaratmaktadır.

Bu yüzden, ilk eğitimi BF16 ile gerçekleştirmeye karar verdik. Eğitim kaybı, optimizasyon durumu, gradyan normu gibi değerlerin problem yaratmadığını onayladıktan sonra FP8’e geçerek eğitim sürecini hızlandırdık. FP8 hibrit ile eğitim hızında belirgin bir artış gözlemlendi. Megatron-LM ile 545-553 TFLOP/s arasında eğitim hızları ölçüldü.

Sonuç

Yukarıda belirtilenler doğrultusunda, LLM-jp 172B modelinin eğitimi halen devam etmekte olup Megatron-LM kullanılarak ilerlemektedir. Şu anki kontrol noktası verileri ile gerçekleştirilen aşağıdan yukarıya görevler üzerine yapılan değerlendirme sonuçlarına göre modelin Japonca dil yeteneklerini mükemmel bir seviyeye ulaştırdığı düşünülmektedir; ancak tamamlanmış modelin gelecek yılın başlarında hazır olması beklenmektedir.

Özellikle LLM’lerin ön eğitiminde büyük veri kümeleri gerektiği düşünüldüğünde, eğitim süreleri büyük bir zorluk ortaya çıkarabilmektedir. Bu nedenle, Megatron-LM gibi etkili eğitim çerçeveleri, Üretken Yapay Zeka araştırma ve geliştirmelerini hızlandırmak için kritik bir önem taşımaktadır. 172B modelinin FP8-hibrit eğitimi ile %40 eğitim hızında bir iyileşme sağlayarak 400 TFLOP/s’den 550 TFLOP/s’ye yükseldiğimizi gözlemledik. Bu, FP8-hibritin büyük ölçekli model ön eğitimini geliştirmek için değerli bir yaklaşım olabileceğini göstermektedir.