Llama 4: Yeni Nesil AI Modelleri

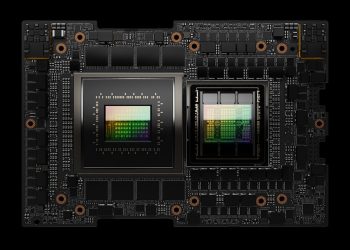

Popüler Llama AI modellerinin en yeni nesli, Llama 4 Scout ve Llama 4 Maverick ile karşımıza çıkıyor. NVIDIA’nın açık kaynak yazılımı sayesinde, bu modeller, NVIDIA Blackwell B200 GPU üzerinde dakikada 40K’ye kadar çıktı token’ı üretme kapasitesine ulaşıyor. Bu modeller, NVIDIA NIM mikro hizmetleri aracılığıyla deneme fırsatı sunuyor.

Multimodal ve Çok Dilli Kapasite

Llama 4 modelleri, karışık uzmanlar (MoE) mimarisi kullanarak artık doğrudan çoklu mod ve çok dilli özelliklere sahip. Bu modeller, ölçek, hız ve verimlilikte büyük gelişmeler sağlayarak daha kişiselleştirilmiş deneyimler yaratmanızı sağlıyor.

Llama 4 Scout ve Maverick’in Özellikleri

Llama 4 Scout, 109B parametreye sahip, token başına 17B aktif ile çalışan bir modeldir. 16 uzmanla yapılandırılmıştır ve 10M bağlam uzunluğu penceresi ile optimize edilmiştir. Tek bir NVIDIA H100 GPU için int4 biçiminde kuantize edilmiştir. Bu, çoklu belge özetleme, geniş kullanıcı aktivitelerinin analiz edilmesi ve büyük kod tabanları üzerinde akıl yürütme gibi çeşitli kullanım senaryolarını mümkün kılar.

Llama 4 Maverick ise 400B parametreye sahip olup, token başına 17B aktif ile çalışır. 128 uzmanlıkla yapılandırılmış ve 1M bağlam uzunluğu kabul etmektedir. Bu model, yüksek performansa sahip resim ve metin anlama yetenekleri sunar.

NVIDIA TensorRT-LLM ile Optimize Edilmiş Performans

NVIDIA, Llama 4 Scout ve Llama 4 Maverick modellerini NVIDIA TensorRT-LLM için optimize etti. TensorRT-LLM, NVIDIA GPU’larındaki en son temel modeller için LLM çıkarım performansını hızlandırmak amacıyla kullanılan açık kaynak bir kütüphanedir.

NVIDIA Blackwell B200 GPU üzerinde, TensorRT-LLM, FP8 biçiminde optimize edilmiş Llama 4 Scout ile dakikada 40K token’dan fazla, Llama 4 Maverick ile de dakikada 30K token’dan fazla throughput sunmaktadır.

Blackwell ile Yenilikçi Performans Artışı

Blackwell, ikinci nesil Transformer Motoru, beşinci nesil NVLink ve FP8, FP6 ve FP4 hassasiyeti gibi mimari yeniliklerle büyük bir performans artışı sunuyor. Llama 4 için bu yenilikler, NVIDIA H200’e kıyasla 3.4 kat daha hızlı bir throughput ve token başına 2.6 kat daha iyi maliyet sunmaktadır.

En son Llama 4 optimizasyonları, açık kaynak NVIDIA/TensorRT-LLM GitHub deposunda mevcuttur.

Meta ve NVIDIA’nın Süregelen İşbirliği

NVIDIA ve Meta’nın açık modelleri ilerletmek için uzun bir işbirliği geçmişi vardır. NVIDIA, verimlilik sağlamak ve maliyetleri düşürmek amacıyla aktif bir açık kaynak katkıcısıdır. Açık kaynak modeller, AI şeffaflığını teşvik eder ve kullanıcıların AI güvenliği ve dayanıklılığı konusundaki çalışmalarını geniş ölçekte paylaşmalarını sağlar.

Bu açılım ve NVIDIA’nın hızlandırılmış hesaplama yetenekleri, geliştiricilere, araştırmacılara ve işletmelere çeşitli uygulama alanlarında sorumlu bir şekilde yenilik yapma imkanı sunar.

Llama Modellerini Yüksek Doğrulukla İnce Ayar Yapma

Llama modellerinin kusursuz bir şekilde ince ayar yapılması için NVIDIA NeMo kullanılabilir; bu araç, büyük dil modellerini kurumsal verilerle özelleştirmek için geliştirilmiş bir uçtan uca çerçevedir.

Yüksek kaliteli ön eğitim veya ince ayar veri setleri oluşturmak için NeMo Curator‘ı kullanarak yapılandırılmış ve yapılandırılmamış verileri büyük ölçeklerde çıkartıp, filtreleyebilir ve yinelenmesini önleyebilirsiniz. Ardından, NeMo kullanarak Llama modellerini verimli bir şekilde ince ayar yapabilirsiniz; bu süreç, LoRA, PEFT ve tam parametre ayarlama gibi teknikleri destekler.

NVIDIA NIM ile Dağıtımları Kolaylaştırma

Kurumsal kullanıcıların bu modellerden yararlanabilmesi için, Llama 4 modelleri, güvenli, veri gizliliği olan ve kurumsal düzeyde güvenlik sunan NVIDIA NIM mikro hizmetleri olarak paketlenecektir. NIM, endüstri standartlarını destekleyerek dağıtım sürecini basitleştirir.

LLM’ler, görüntü modelleri veya çoklu mod AI ile ilgileniyorsanız, NIM, altyapının karmaşıklığını ortadan kaldırarak bulutlar, veri merkezleri ve kenar ortamları arasında sorunsuz ölçeklenmenizi sağlar.

Bugün Başlayın!

Kendi verilerinizi deneyimlemek ve NVIDIA](https://build.nvidia.com/models?filters=publisher%3Ameta tarafından barındırılan API uç noktasını uygulamanıza entegre ederek bir kavramsal kanıt oluşturmak için Llama 4 NIM mikro hizmetlerini deneyebilirsiniz.