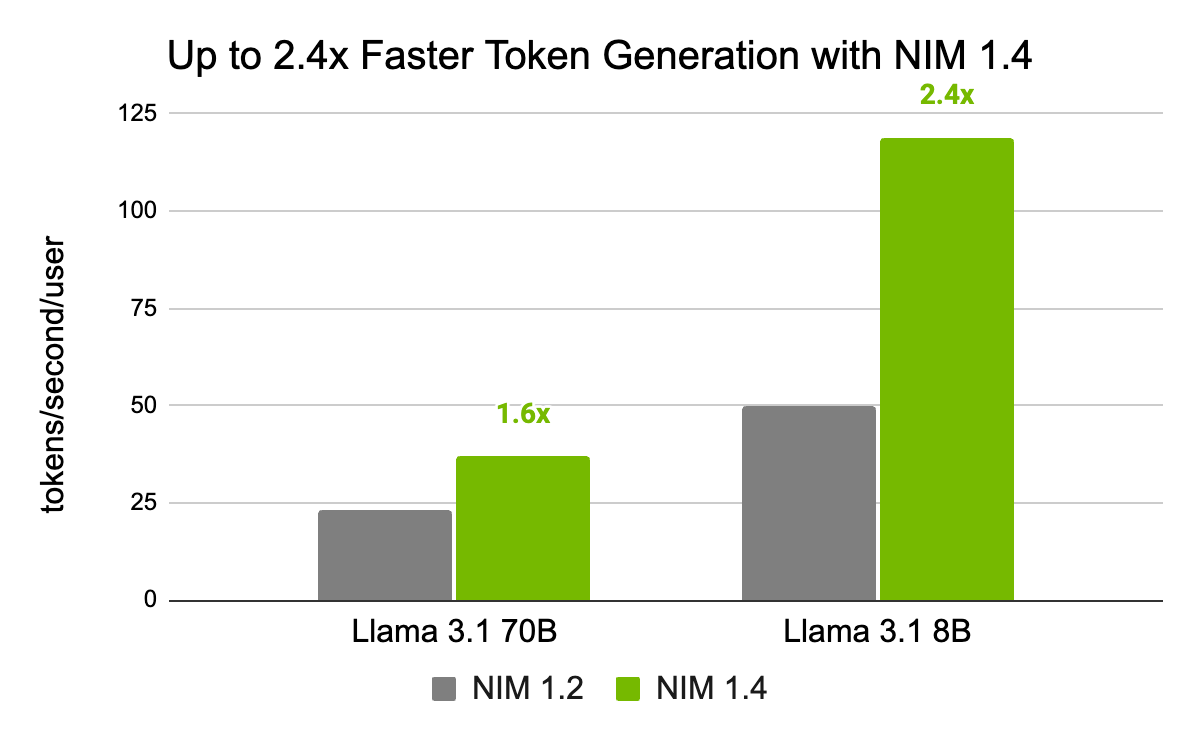

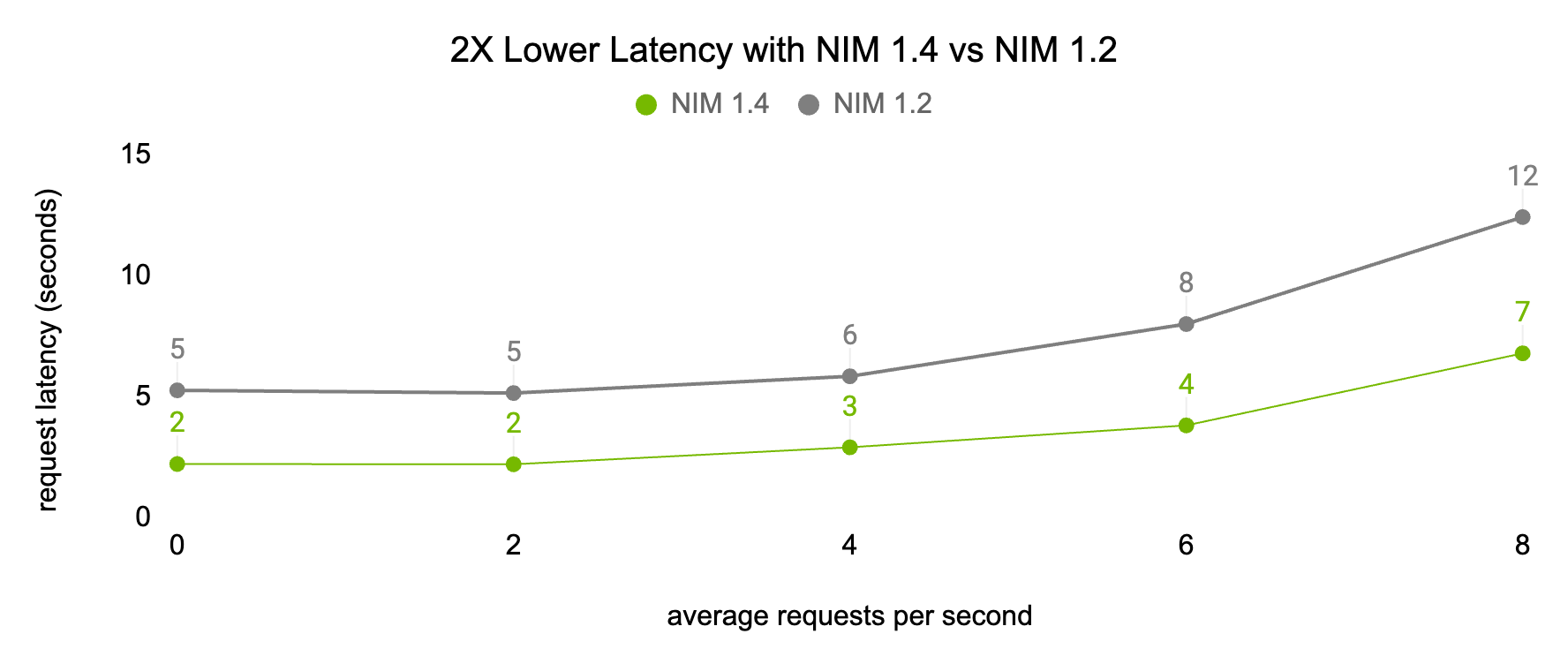

Yüksek performanslı yapay zeka (YZ) tahminleri için hazır çözümlere olan talep, generatif AI‘nın sanayileri dönüştürmesiyle birlikte artıyor. NVIDIA NIM, AI model tahmini için üretim aşamasında hazır mikro servis konteynerleri sunuyor ve kurumsal düzeyde generatif AI performansını sürekli olarak geliştiriyor. Aralık ayının başında piyasaya sürülmesi planlanan NIM sürüm 1.4 ile birlikte, talep performansı kutudan hemen çıkışta %240’a kadar artırıldı ve tek komutla kurulum deneyimi sağlanıyor.

NIM‘in temelinde birden çok büyük dil modeli (LLM) tahmin motoru bulunuyor; bunlardan biri NVIDIA TensorRT-LLM. Bu motor, ışık hızında tahmin performansı elde edilmesine yardımcı oluyor. Her yeni sürümde, NIM, performansı artırmak için bu motorlardan en son çekirdek optimizasyonları, hafıza yönetimi ve zamanlama yeniliklerini entegre ediyor.

NIM 1.4, çekirdek verimliliği, eşzamanlılık ve hafıza ayırma konularında önemli iyileştirmeler içeriyor; bu sayede NIM 1.2’ye kıyasla tahmin süresi %240 oranında hızlanıyor. Bu yenilikler, hızlı yanıtlar ve yüksek throughput’a ihtiyaç duyan işletmeler için oldukça kritik bir öneme sahip.

Tam Yığın Hızlandırıcı Teknolojilerle Sürekli Gelişim

NIM, tam yığın hızlandırılmış hesaplama güncellemelerinden yararlanarak her düzeyde performansı ve verimliliği artırıyor. Bu, en son NVIDIA TensorRT ve NVIDIA CUDA versiyonları için destek içeriyor ve tahmin performansını daha da artırıyor. NIM kullanıcıları, bu sürekli iyileştirmelerden faydalanırken yazılımlarını elle güncellemeye gerek kalmıyor.

Hızlı ve Kolay Dağıtım ile Yüksek Performans

NIM, önceden yapılandırılmış yazılım paketini bir araya getirerek yüksek performanslı YZ tahmini sunuyor. Böylece geliştiriciler, yüksek performanslı tahmin işlemlerine hızlı bir başlangıç yapabiliyorlar. Sürekli bir yenilik döngüsü, TensorRT-LLM, CUDA ve diğer temel hızlandırılmış hesaplama teknolojilerindeki her iyileştirmenin, NIM kullanıcılarını hemen ilgilendirmesini sağlıyor. Güncellemeler, NIM mikro servis konteynerlerine sorunsuz bir şekilde entegre ediliyor ve manuel yapılandırma gereksinimlerini ortadan kaldırarak, yüksek performanslı tahmin çözümlerinin bakımıyla ilişkili mühendislik yükünü azaltıyor.

Bugün Başlayın!

NVIDIA NIM, geleneksel model dağıtımı ve yönetiminin karmaşıklığı olmadan yüksek performanslı generatif AI’ya giden en hızlı yol. Kurumsal düzeyde güvenilirlik ve sürekli performans geliştirmeleri ile NIM, yüksek performanslı YZ tahminini işletmelere ulaşılabilir kılıyor. Daha fazla bilgi edinin ve bugün başlayın.