Büyük dil modelleri (LLM’ler), özerk hareketler, araç kullanımı ve akıl yürütme yapabilen sistemler geliştikçe, işletmeler bu esnekliğe ve düşük çıkarım maliyetlerine ilgi duymaya başladı. Ancak bu artan özerklik, hedef uyumsuzluğu, prompt enjeksiyonu, istenmeyen davranışlar ve insan gözetiminin azalması gibi riskleri de beraberinde getiriyor. Bu nedenle, sağlam güvenlik önlemlerinin uygulanması son derece önemlidir.

Ayrıca, parçalı risk tutumları ve dinamik düzenleyici değişiklikler, yükümlülükleri artırmaktadır. Güvenilirlik sorunları, yanıltıcı cevaplar, prompt enjeksiyonları, veri sızıntısı ve saldırgan model tepkileri gibi bilinmeyen riskleri doğurabilir; bu durum da bir kuruluşun güvenlik, gizlilik, güven ve uyum hedeflerini zayıflatabilir. Tüm bu faktörler, açık modellerin işletme AI ajanlarını destekleme potansiyelini engellemektedir.

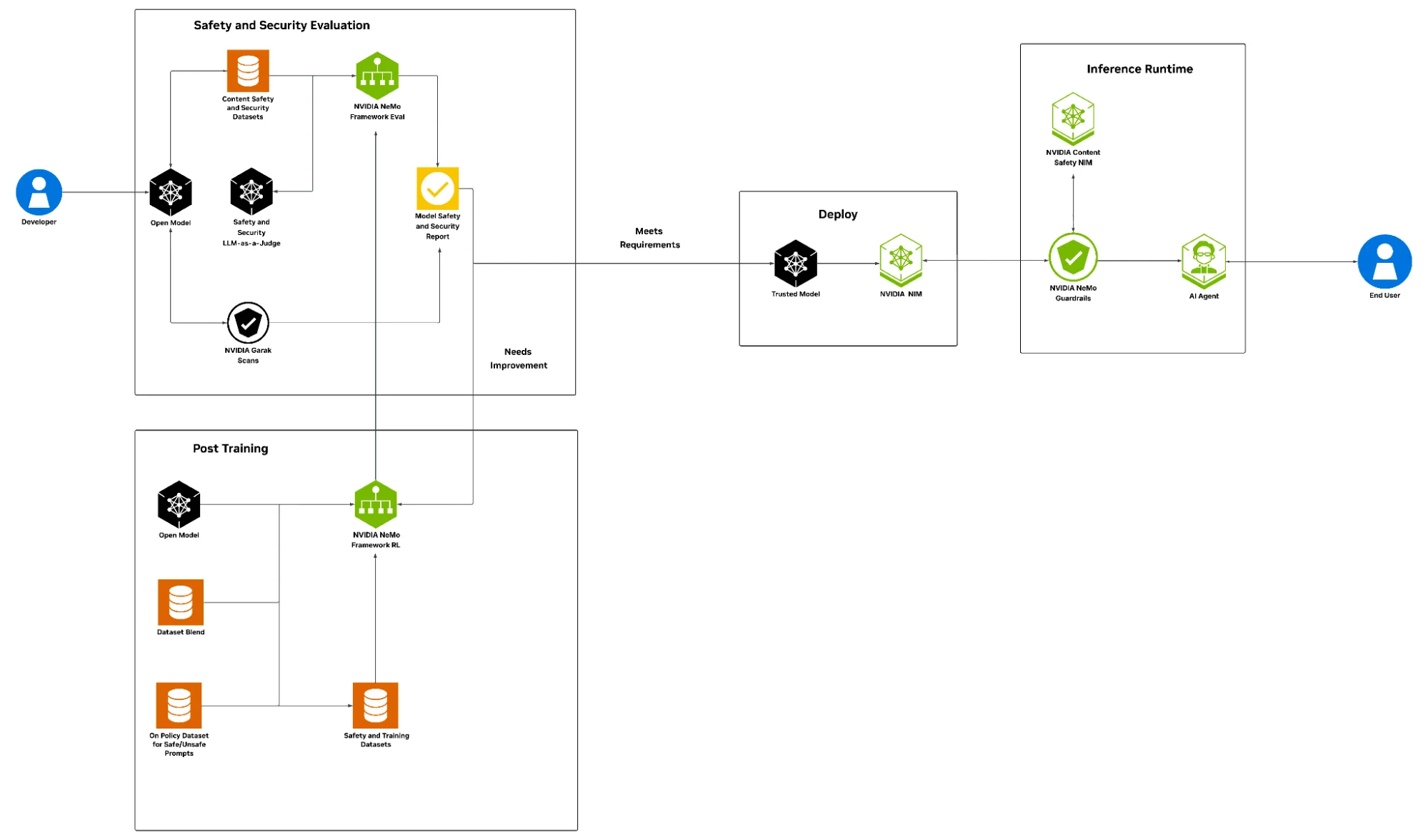

Bu yazıda, NVIDIA’nın AI güvenlik tarifesi tanıtılmaktadır. Bu tarif, NVIDIA’nın açık veri setleri, değerlendirme teknikleri ve sonrasındaki tarifler aracılığıyla AI yaşam döngüsünün her aşamasının güçlendirilmesine olanak tanır. Çıkarma sürecinde, NVIDIA NeMo Guardrails, içerik moderasyonu, prompt enjeksiyon saldırıları ve uyum ihlalleri gibi ortaya çıkan risklere karşı önlem almak için önemli bir yardımcıdır.

Bu bütünsel yaklaşım, politika yöneticilerini, risk sahiplerini – CISO’lar ve CIO’lar gibi – ve AI araştırmacılarını, güvenlik tehditlerini proaktif bir şekilde yönetmeye, kurumsal politikaları uygulamaya ve ajandacı AI uygulamalarını sorumlu bir şekilde ölçeklendirmeye olanak tanır.

Ajandacı İş Akışlarının Güvenlik Tarifesine İhtiyacı Neden Var?

Gelişmiş açık ağırlık modelleri, her zaman bir şirketin güvenlik politikaları ile uyumlu olmayabilir. Ayrıca, değişen ortamlar, geleneksel koruma önlemlerinin – içerik filtreleri ve ölçütler gibi – yeteneklerini aşan riskler ortaya çıkarabilir. Bu durum, AI sistemlerinin gelişmiş prompt enjeksiyon saldırılarına maruz kalmasına ve sürekli, politika odaklı izleme eksikliği ile daha da kötüleşmesine yol açabilir.

Ajandacı AI güvenlik tarifesi, kuruluşların güvenilir ve iç politikaları ile dış düzenleyici taleplerle uyumlu AI sistemlerini inşa etmelerine, dağıtmalarına ve işletmelerine olanak tanıyan kapsamlı bir çerçeve sunmaktadır.

Anahtar avantajlar arasında:

- Değerlendirme: Üretim modelleri ve altyapısındaki tanımlı iş politikaları ve risk eşikleri ile test etme ve ölçme yeteneği.

- Uçtan uca AI güvenlik yazılımı yığını: Kurumsal AI sistemleri için güvenlik politikalarının AI yaşam döngüsü boyunca izlenmesini ve uygulanmasını sağlayan temel yapı taşları.

- Güvenilir veri uyumu: Şeffaf ve güvenilir AI sistemleri inşa etmek için açık lisanslı güvenlik eğitim veri setlerine erişim sağlamak.

- Son teknoloji risk azaltma: İçerik güvenliği ve manipülatif istemlere karşı koruma gibi kritik boyutlarda sistematik güvenlik sunan teknikler.

- İçerik moderasyonu: Şiddet, cinsellik veya taciz edici içeriğin azaltılmasını içeren içerik güvenliğini ele almak.

- Güvenlik: “Do Anything Now” (DAN) gibi manipülatif istemlere karşı sistem direncini artırarak jailbreak ve prompt enjeksiyon saldırılarına karşı koruma sağlamak.

İnşaat, Dağıtım ve Çalışma Aşamasında Savunmaları Uygulama

İnşaat aşamasında, model değerlendirmesi ve uyum, model çıktılarının kurumsal amacına, güvenliğine, güvenilirliğine, kullanıcıların gizlilik beklentisine ve düzenleyici uyum standartlarına uyum sağlaması için kritik adımlardır. NVIDIA, NVIDIA NeMo çerçevesi ile açık veri setleri ve içerik moderatör modelleri kullanarak model değerlendirmesi için bir dizi değerlendirme aracı sunmaktadır.

Nemotron İçerik Güvenliği Veri Seti v2 ve Llama Nemotron Güvenlik Koruma v2 modeli, zararlı çıktıları titizlikle tararken, içerik bütünlüğünü korumakta ve kurumsal politikalarla uyumu arttırmaktadır. Ayrıca, garak LLM güvenlik açığı tarayıcısı, ürün güvenlik açıklarını tespit etmek için ürünü probe eder ve kötü niyetli istemler ile jailbreak girişimlerine karşı dayanıklılık sağlamak için sistemi test eder.

NeMo çerçevesi RL, geliştiricilerin denetimli ince ayar (SFT) ve pekiştirmeli öğrenme (RL) ile son teknoloji sonrası eğitim tekniklerini uygulamalarına olanak tanır. Ayrıca, şeffaf ve güvenilir AI sistemleri inşa etmek için açık lisanslı veri setleri sağlar. Kullanıcılar, güvenlik için on-politik veri seti karışımları hazırlayabilir ve bunları eğitim sonrası modelleri için kullanabilir.

Eğitim sonrası dikkatlice incelenen modelin güvenlik ve emniyet raporları oluşturulmakta ve böylece işletme spesifik politikalarına uygunluğu sağlanmaktadır. Bu aşamada görev spesifik doğruluğun yeniden değerlendirilmesi de önemlidir. Eğitim sonrası tüm değerlendirmelerin iş ve güvenlik eşiklerini karşıladığında, model dağıtım için güvenilir olarak kabul edilebilir. Sonrasında, LLM NIM mikroservisi, bu güvenilir modeli, çoklu ortamlar üzerinde ölçeklenerek çıkarım için dağıtmakta kullanılır.

Gerçek dünyada, tehditler eğitim sonrası son bulmamaktadır; her zaman kalan riskler bulunmaktadır. Garak değerlendirmesi ve eğitim sonrası sürece dair edinilen bilgiler, NeMo Guardrails ile birlikte çıkarım süresi boyunca devamlı, programlanabilir güvenlik ve koruma sağlar.

Llama 3.1 Nemoguard 8B İçerik Güvenliği NIM, önyargılı veya zehirli çıktıları önlerken, Llama 3.1 Nemoguard 8B Konu Kontrolü NIM, etkileşimlerin onaylanan iş veya uyum alanlarında kalmasını garanti eder. Nemoguard Jailbreak Detect NIM, model güvenlik önlemlerini aşmak için tasarlanmış kötü niyetli istem mühendisliğine karşı koruma sağlar.

Önde Gelen Model Güvenliği ve Emniyeti Standartlarına Ulaşma

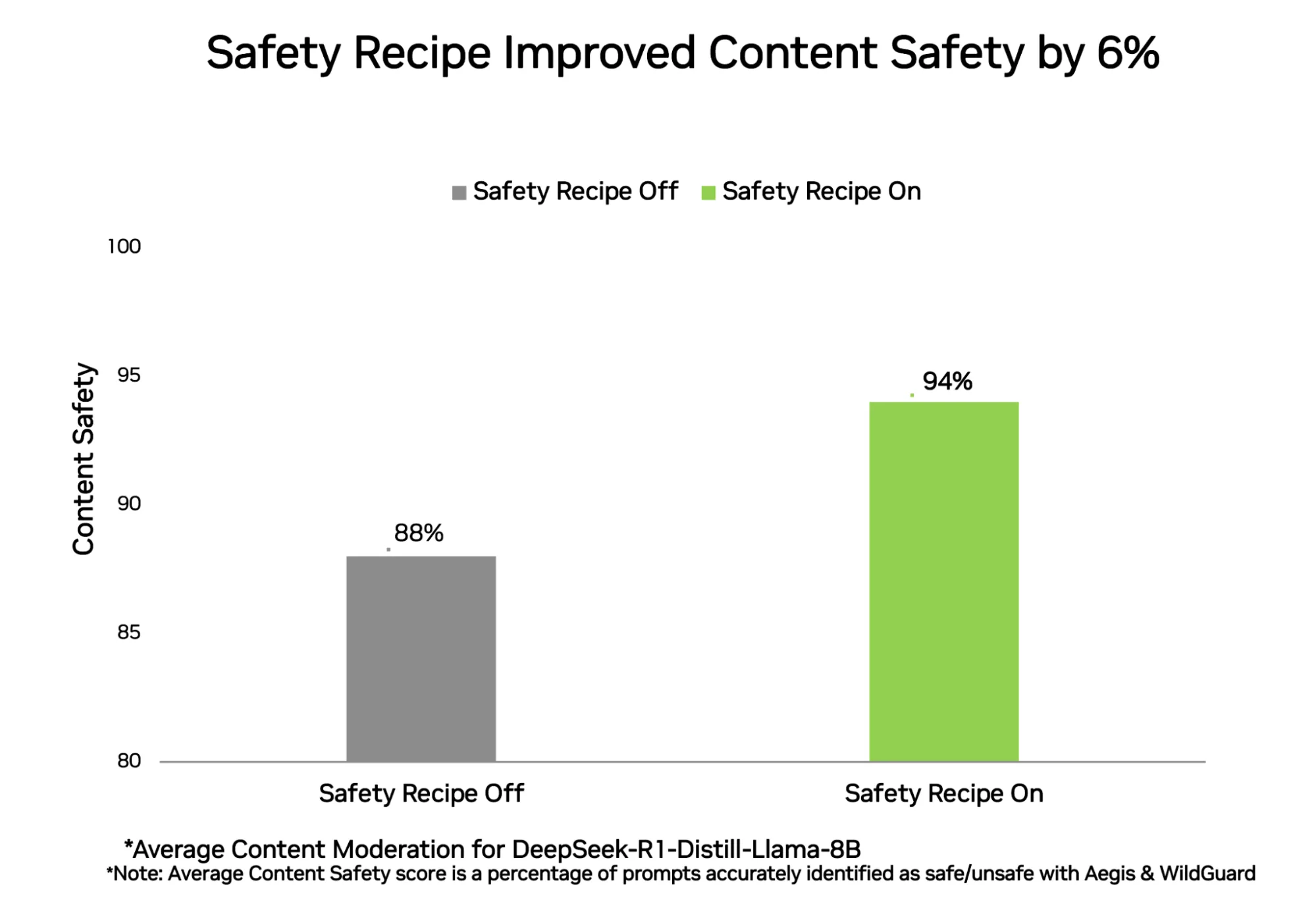

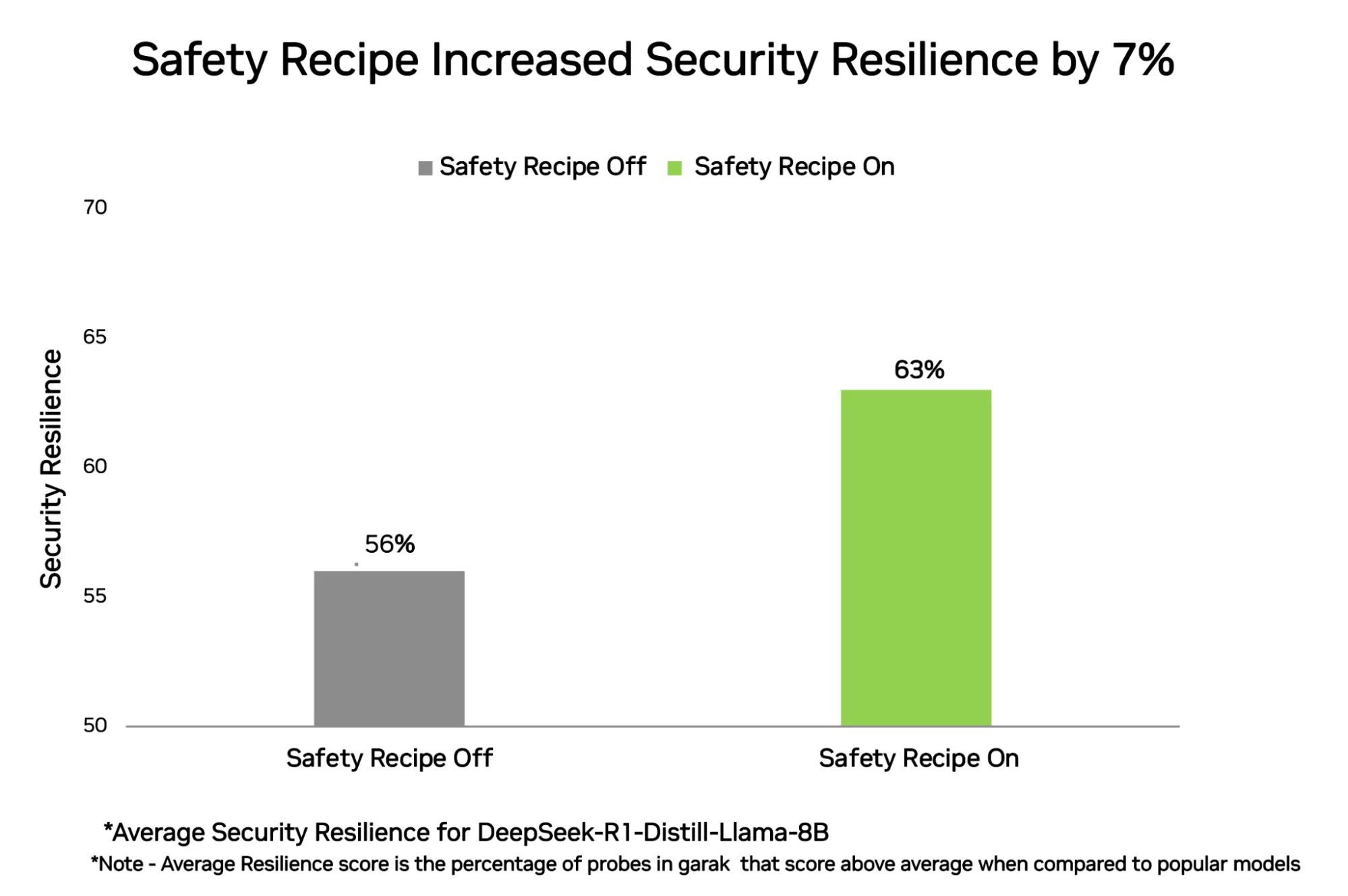

Sektördeki öncü standartlar, temel açık ağırlık modelinin güvenlik ve emniyet açığının, eğitim sonrası güvenlik tarifesi ile iyileştirilmiş model arasındaki farkı göstermektedir.

İçerik güvenliği değerlendirmesi, Nemotron İçerik Güvenliği Veri Seti v2 test seti ve Nemotron Güvenlik Koruma v2 yargı modeli ile birlikte içerik moderasyonu standartlarının kombinasyonu kullanılarak gerçekleştirilmiştir. Ayrıca, WildGuardTest veri setini ve WildGuard yargı modelini kullanan dış bir topluluk standartlarıyla yapılan değerlendirme de içerilmektedir.

Ürün güvenliği, NVIDIA AI güvenlik tarifesi uygulanarak, temel açık ağırlık modelinde %88’den %94’e çıkarak %6’lık bir iyileşme sağlamış, bu süreçte ölçülebilir bir doğruluk kaybı yaşanmamıştır. Bu, yanıtların hedef model veya aynı niyetli davranda uyumlu bir model tarafından üretildiği on-politik güvenlik eğitimi kullanılarak gerçekleştirilmiştir.

Ürün güvenliği, temel açık ağırlık modelinden %56’dan %63’e çıkarak, %7’lik bir güvenlik iyileşmesi ile ölçümlenmiş ve bu süreçte ölçülebilir bir doğruluk kaybı yaşanmamıştır. garak aracılığıyla yapılan ölçümlerde, modelin sürekli bir şekilde daha yüksek performans gösterdiği prob oranının belirlenmesi sağlanmıştır.

NVIDIA AI güvenlik tarifi, kuruluşların açık modelleri geliştirme aşamasından dağıtım aşamasına kadar güvenle kullanmalarına yardımcı olur. Bu, kurumsal düzeyde ajandacı AI sistemlerinin sorumlu benimsenmesini sağlayan güvenlik önlemleri sunmaktadır. Lider siber güvenlik ve AI güvenlik şirketleri, bu NVIDIA AI güvenlik yapı taşlarını ürün ve çözümlerine entegre etmektedirler.

Active Fence, işletmelere gerçek zamanlı güvenlik önlemleriyle ajandacıların güvenli bir şekilde dağıtımını sağlamaktadır.

Cisco AI Savunması, model açıklarını değerlendirmek için NeMo ile entegre çalışmakta ve çalışma uygulamaları için ek güvenlik, emniyet ve gizlilik tedbirleri sunmaktadır.

CrowdStrike Falcon Cloud Security, müşterilerin modellere sürekli izleme ve tehdit istihbarat verilerini entegre etmelerine olanak tanıyarak NeMo eğitim döngüsü ile işbirliği yapmaktadır.

Trend Micro, modeli güvenli bir şekilde ölçeklendirmek için NeMo model geliştirme hattı ile entegre olmaktadır.

AI Sistemi Güvenliğinizi Geliştirerek Başlayın

Ajandacı AI için güvenlik tarifi, açık modelleri erken değerlendirmek ve uyumlu bir iş akışı sağlamak için tasarlanmış yapılandırılmış bir referansa sahiptir. Bu tarif, indirilebilir bir Jupyter defteri olarak veya NVIDIA Brev hizmeti ile bulut üzerinde dağıtım seçeneği ile kullanılabilir.

Teşekkürler

Bu yazıya katkıda bulunan herkesine teşekkür ederiz: Yoshi Suhara, Prasoon Varshney, Ameya Sunil Mahabaleshwarkar, Zijia Chen, Makesh Narasimhan Sreedhar, Aishwarya Padmakumar, Pinky Xu, Negar Habibi, Joey Conway, Christopher Parisien, Erick Galinkin, Akshay Hazare, Jie Lou, Vinita Sharma, Vinay Raman, Shaona Ghosh, Katherine Luna, ve Leon Derczynski.