Günlük ve haftalık bültenlerimize katılarak, sektör lideri yapay zeka haberlerinden en son güncellemeleri ve özel içerikleri alın. Daha Fazla Bilgi Edinin

Stanford Üniversitesi ve Google DeepMind araştırmacıları, karmaşık görevleri çok adımlı akıl yürütme ve araç kullanma becerileri ile ele alabilen büyük dil modellerini (LLM’ler) geliştirmek için Step-Wise Reinforcement Learning (SWiRL) adında yeni bir teknik tanıttılar.

Yapay zeka ajanları ve LLM araç kullanımına olan ilginin arttığı günümüzde, bu teknik, işletmelerin akıl yürütme modellerini uygulamalarına ve iş akışlarına entegre etmesi için önemli avantajlar sağlayabilir.

Çok Adımlı Problemlerin Zorluğu

Gerçek dünya iş uygulamaları genellikle çok adımlı süreçler içerir. Örneğin, karmaşık bir pazarlama kampanyası planlaması; piyasa araştırması, iç veri analizi, bütçe hesaplaması ve müşteri destek biletlerinin gözden geçirilmesini gerektirebilir. Bu, çevrimiçi aramalar, iç veri tabanlarına erişim ve kod çalıştırmayı gerektirir.

Geleneksel pekiştirme öğrenimi (RL) yöntemleri, LLM’leri ince ayar yapmak için sıklıkla tek adımlı akıl yürütme görevlerine odaklanmaktadır. İnsan Geri Bildiriminden Pekiştirme Öğrenimi (RLHF) veya Yapay Zeka Geri Bildiriminden Pekiştirme Öğrenimi (RLAIF) gibi yöntemler, bu tür görevler için optimize edilmiştir.

Step-Wise Reinforcement Learning (SWiRL)

SWiRL, karmaşık problemleri daha yönetilebilir alt görevlere ayırmayı öğretmek amacıyla sentetik veri üretimi ve özel bir pekiştirme öğrenimi yaklaşımını birleştirerek bu çok adımlı zorluğu ele alır.

Araştırmacılar, “Amacımız, modelin karmaşık problemleri bir dizi daha yönetilebilir alt göreve ayırmayı nasıl öğrenebileceğini, aracı ne zaman çağıracağını, araca nasıl bir çağrı yapacağını, bu sorguların sonuçlarını nasıl kullanacağını ve bulgularını nasıl etkili bir şekilde sentezleyeceğini öğretmektir” ifadelerini kullanmaktadır.

Eğitim Verisi Üretimi

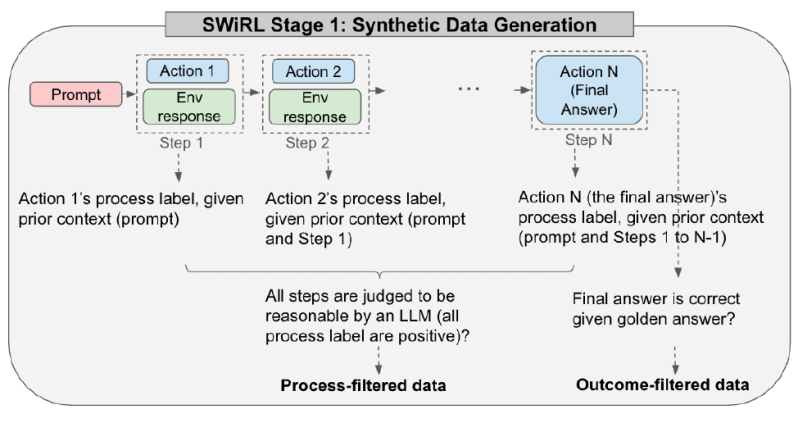

İlk aşama, SWiRL’nin öğrenmesi için sentetik verilerin üretilmesidir. Bir LLM, bir arama motoru veya bir hesap makinesi gibi ilgili bir araca erişerek problem çözmek için bir “trajektori” üretecek şekilde ardışık olarak teşvik edilir. Her adımda, model iç düşüncesini (akıl yürütme zinciri) üretebilir, bir aracı çağırabilir veya nihai cevabı oluşturabilir.

Her tam trajektori, başlangıç uyarısından nihai cevaba kadar olan süreç, birçok örtüşen alt trajektoriye ayrılır. Bu alt trajektoriler, modelin adım adım akıl yürütme sürecini temsil eder. Araştırmacılar, bu yöntemle çok sayıda soru ve problem çözme verisi toplayarak on binlerce trajektori oluşturmayı başardı.

SWiRL ile LLM’leri Eğitme

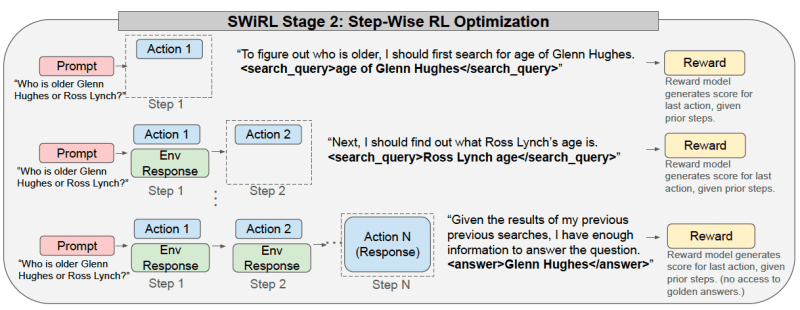

İkinci aşamada, SWiRL, üretilen sentetik trajektoriler üzerinde bir temel LLM’yi eğitmek için pekiştirme öğrenimini kullanır. Bir trajektoride her adımda, model, önceki bağlama dayanarak bir sonraki uygun eylemi (araç çağrısı, akıl yürütme adımı veya nihai cevap) tahmin etmek üzere optimize edilir.

Model, her adımda ayrı bir ödül modeli tarafından geribildirim alır. Bu model, verilen bağlamda modelin ürettiği eylemi değerlendirir.

SWiRL ile eğitilmiş bir model, bir uyarı aldığında, adım adım devam eder. Eğer bir araç çağrısı yapıyorsa (örneğin bir arama sorgusu veya bir matematiksel ifade), bu çağrı analiz edilir, yürütülür ve sonucu modelin bağlamına geri beslenir.

Bu, kullanıcının son cevabı veya belirli bir adım sayısı ile sonuçlanana kadar devam eder. Goldie ve Mirhoseini, “Karmaşık, çok adımlı görevler karşısında geleneksel LLM’lerin zayıflıklarını ele alarak, modelin her an mantıklı adımlar atmasını ve bunu daha anlaşılır bir şekilde yapmasını sağlıyoruz” demektedir.

SWiRL Uygulamada

Stanford ve Google DeepMind ekibi, SWiRL’yi çeşitli zorlu çok adımlı soru-cevap ve matematiksel akıl yürütme görevleri üzerinde değerlendirdi. SWiRL’nın başarısı, önceki önerileri karşılaştırdığında %11 ile %21 arasında anlamlı bir doğruluk artışı gösterdi.

Sonuçlar, SWiRL ile eğitilmiş bir modelin, sonuçları filtrelenmeden sadece süreç filtrelemesi ile en iyi sonuçları elde ettiğini ortaya koydu. Bu, SWiRL’nin, doğru cevaplar yerine mantıklı akıl yürütme süreçlerini öğrenebildiğinin bir göstergesi olarak değerlendiriliyor.

SWiRL aynı zamanda güçlü genel performans sergiledi. Örneğin, bir modelin SWiRL ile metin tabanlı soru-cevap eğitimi alması, matematik akıl yürütme görevlerinde de başarılı sonuçlar elde etmesini sağladı. Bu yetkinliğin farklı görevler arasında geçişkenliği büyük önem taşıyor.