Transformers, dikkat tabanlı mimarileri sayesinde dil modelleri (LM’ler) için en popüler seçim haline geldi. Bu modellerin güçlü performansı, paralelleşme yetenekleri ve anahtar-değer (KV) önbellekleri aracılığıyla uzun vadeli hatırlama kapasiteleri bulunmaktadır. Ancak, kare artan hesaplama maliyetleri ve yüksek bellek gereksinimleri verimlilik konusunda zorluklar oluşturmaktadır. Buna karşın, durum alanı modelleri (SSM’ler) gibi Mamba ve Mamba-2, sabit karmaşıklık ve verimli donanım optimizasyonları sunabilmektedir. Fakat, bellek hatırlama görevlerinde sorunlar yaşamakta, bu durum genel benchmarklardaki performanslarını etkilemektedir.

NVIDIA araştırmacıları, Hymba adında küçük bir dil modeli (SLM) ailesi önerdi. Bu model, verimliliği artırmak ve performansı iyileştirmek amacıyla hybrid-head paralel mimarisi ile transformer dikkat mekanizmalarını ve SSM’leri birleştiriyor. Hymba, yüksek çözünürlüklü hatırlama sağlarken, SSM başlıkları etkili bağlam özetlemesi sunuyor.

Hymba’nın Yenilikçi Mimari Tasarımı

Hymba’nın mimarisi birkaç önemli içgörü sunmaktadır:

- Dikkatteki aşırı yük: Dikkat hesaplamalarının %50’sinden fazlası, daha ucuz SSM hesaplamaları ile değiştirilerek ortadan kaldırılabilir.

- Yerel dikkatin önemi: Global dikkatin büyük çoğunluğu, performanstan ödün vermeden yerel dikkate dönüştürülebilir. Bunu, SSM başlıkları tarafından özetlenen global bilgiler sağlıyor.

- KV önbelleklerinde tekrarlama: Anahtar-değer önbelleği başlıklar ve katmanlar arasında yüksek derecede korelasyona sahiptir, bu nedenle bu önbellek başlıklar arası (grup sorgu dikkati) ve katmanlar arası (çapraz katman KV önbellek paylaşımı) olarak paylaşılabilir.

- Softmax dikkatin sınırlamaları: Dikkat mekanizmaları bir süre toplamını sınırladıkları için seyrekliği ve esnekliği sınırlıyor. Bu nedenle, kritik bilgileri saklamak ve dikkat mekanizmaları ile ilgili “zorunlu dikkat” yükünü hafifletmek için öğrenilebilir meta-tokenlar tanıtıyoruz.

Hymba 1.5B’nin Performansı

Yapılan değerlendirmeler, Hymba 1.5B’nin benzer boyuttaki açık kaynak model olan Llama 3.2 1B, OpenELM 1B, Phi 1.5, SmolLM2 1.7B, Danube2 1.8B ve Qwen2.5 1.5B’ye karşı oldukça başarılı bir performans sergilediğini gösteriyor. Benzer boyuttaki transformer modellerine göre, Hymba daha yüksek çıkış hızına ulaşmış ve önbellek depolamak için 10 kat daha az bellek gerektirmiştir.

Hymba 1.5B şu anda Hugging Face koleksiyonunda ve GitHub’da yayımlanmıştır.

Hymba Modelinin Tasarımı

SSM’ler, transformerların kare karmaşıklık ve büyük çıkarım zamanı KV önbellek sorunlarını çözmek için önerilmiştir. Ancak, düşük çözünürlüklü bellek nedeniyle SSM’ler, bellek hatırlamasında zorluk çekebilir. Bu sınırlamaların üstesinden gelmek için, etkili ve yüksek performanslı küçük LMs geliştirmek için bir yol haritası sunuyoruz.

| Konfigürasyon | Ortak akıl % ↑ | Hatırlama % ↑ | Çıkış hızı (token/saniye) ↑ | Önbellek boyutu (MB) ↓ | Tasarım nedeni |

| 300M model boyutu ve 100B eğitim tokeni üzerine ablamalar | |||||

| Transformer (Llama) | 44.08 | 39.98 | 721.1 | 414.7 | Kesin hatırlama, ancak verimsiz |

| Durum alanı modelleri (Mamba) | 42.98 | 19.23 | 4720.8 | 1.9 | Verimli, ancak hatırlamada hatalı |

| A. + Dikkat başlıkları (ardışık) | 44.07 | 45.16 | 776.3 | 156.3 | Hatırlama yeteneklerini artırma |

| B. + Çoklu başlıklar (paralel) | 45.19 | 49.90 | 876.7 | 148.2 | İki modül arasında daha iyi denge |

| C. + Yerel/global dikkat | 44.56 | 48.79 | 2399.7 | 41.2 | Hesaplama/önbellek verimliliğini artırma |

| D. + KV önbellek paylaşımı | 45.16 | 48.04 | 2756.5 | 39.4 | Önbellek verimliliği |

| E. + Meta-tokenlar | 45.59 | 51.79 | 2695.8 | 40.0 | Öğrenilen bellek başlangıcı |

| 1.5B model boyutuna ve 1.5T eğitim tokenine ölçeklenme | |||||

| F. + Boyut/veri | 60.56 | 64.15 | 664.1 | 78.6 | Görev performansını artırma |

| G. + Uzun bağlam süresi (2K→8K) | 60.64 | 68.79 | 664.1 | 78.6 | Çoklu örnek ve hatırlama görevlerini iyileştirme |

Birleşik Hybrid Modüller

Hymba’nın mimarisi, ardışık yığmadan daha etkili olduğunu gösteren ablamalarla, dikkat ve SSM başlıklarını paralel bir şekilde birleştirmektedir. Hymba, dikkat ve SSM başlıklarını paralel olarak işleyerek her iki başlığın da aynı bilgiyi eş zamanlı işlemesine olanak tanımaktadır. Bu mimari, akıl yürütme ve hatırlama doğruluğunu artırmaktadır.

Verimlilik ve KV Önbellek Optimizasyonu

Dikkat başlıkları görev performansını artırırken, KV önbellek taleplerini artırmakta ve çıkış hızını düşürmektedir. Bu durumu azaltmak için, Hymba hibrit başlık modülünü yerel ve global dikkati birleştirerek ve katmanlar arası KV önbellek paylaşımını kullanarak optimize etmiştir. Bu, çıkış hızını 3 kat artırırken, önbelleği neredeyse 4 kat azaltır.

Meta-tokenlar

Girişlere eklenen 128 önceden eğitilmiş gömme, ilgili bilgilere odaklanmayı artırmak için öğrenilmiş önbellek başlangıcı olarak işlev görmektedir. Bu tokenlar iki temel amaç taşır:

- Dikkat kaybını önlemek için arka plan tokenları olarak işlev görmek ve dikkati etkin biçimde dağıtmak,

- Sıkıştırılmış dünya bilgisini kapsamak.

Model Analizi

Bu bölüm, farklı mimarilerin aynı eğitim ayarları altında karşılaştırılmasını sunar. Ardından dikkat haritalarının görünümü ile SSM ve Dikkatin farklı önceden eğitilmiş modellerde nasıl çalıştığını inceleyeceğiz. Son olarak, Hymba’nın baş önem analizi, budama işlemi ile yapılacaktır.

Doğrudan Karşılaştırma

Hymba, saf Mamba2, Mamba2 ile FFN, Llama3 tarzı ve Samba tarzı (Mamba-FFN-Dikkat-FFN) mimarileri ile aynı eğitim ayarlarında doğrudan karşılaştırılmıştır. Tüm modeller 1 milyar parametreye sahiptir ve SmolLM-Corpus veri kümesinden 100 milyar token ile sıfırdan eğitilmiştir. Tüm sonuçlar lm-evaluation-harness kullanılarak Hugging Face modellerinde sıfırdan öğrenme ayarı ile elde edilmiştir. Hymba, çoğunlukla ortak akıl ile soruları yanıtlama ve hatırlama yoğun görevlerde en iyi performansı göstermektedir.

Tablo 2, farklı model mimarilerinin dil modellemesi ve hatırlama yoğunluk ve ortak akıl görevlerindeki performansını karşılaştırırken, Hymba’nın güçlü sonuçlar elde ettiğini gösteriyor. Hymba, dil görevlerinde en düşük perpleksite‘ye (Wiki için 18.62 ve LMB için 10.38) sahiptir ve hatırlama yoğun görevlerde, özellikle SWDE (54.29) ve SQuAD-C (44.71) ile farklılık göstererek en yüksek ortalama skoru (49.50) elde etmiştir.

| Model | Dil (PPL) ↓ | Hatırlama yoğun (% ↑) | Ortak akıl (% ↑) |

| Mamba2 | 15.88 | 43.34 | 52.52 |

| Mamba2 ile FFN | 17.43 | 28.92 | 51.14 |

| Llama3 | 16.19 | 47.33 | 52.82 |

| Samba | 16.28 | 36.17 | 52.83 |

| Hymba | 14.5 | 49.5 | 54.57 |

Dikkat Haritalarının Görselleştirilmesi

Dikkat haritasındaki öğeleri dört türe ayırdık:

- Meta: Gerçek tokenlardan meta-tokenlara olan dikkat puanları. Bu kategori, modelin meta-tokenlara dikkat etme eğilimini yansıtır. Dikkat haritalarında genellikle ilk birkaç sütunda (örneğin, Hymba’da 128) bulunurlar.

- BOS: Tüm gerçek tokenların başlangıç sekansı tokenına olan dikkat puanları. Dikkat haritasında genellikle meta-tokenlardan hemen sonra ilk sütunda yer alır.

- Kendine ait: Tüm gerçek tokenların kendilerine olan dikkat puanları. Dikkat haritasında genellikle diyagonal çizgide bulunurlar.

- Çapraz: Tüm gerçek tokenların diğer gerçek tokenlara olan dikkat puanları. Dikkat haritasında genellikle diyagonal olmayan alanlarda yer alır.

Hymba’nın dikkat kalıbı, sıradan transformerların dikkat kalıbından belirgin şekilde farklıdır. Sıradan transformerlarda, dikkat puanları genellikle BOS üzerinde yoğunlaşmıştır. Kendi kendine dikkat puanlarının oranı daha yüksektir. Hymba’da, meta-tokenlar, dikkat başlıkları ve SSM başlıkları birbirini tamamlayarak dikkat puanlarının farklı türler arasında daha dengeli bir dağılım göstermesine yol açmaktadır.

Özellikle, meta-tokenlar, BOS’tan dikkat puanlarını yükünü azaltarak modelin gerçek tokenlar üzerinde daha fazla yoğunlaşmasını sağlar. SSM başlıkları, global bağlamı özetlerken, kendini vurgulayan tokenlara (Kendine ait dikkat puanları) odaklanır. Dikkat başlıkları ise, kendine ve BOS tokenlara daha az dikkat ederek, başka tokenlara (yani, Çapraz dikkat puanları) daha fazla dikkat verir. Bu, Hymba’nın hibrit başlık tasarımının dikkati farklı türlerdeki tokenlar arasında etkili bir şekilde dengeleyebileceğini ve potansiyel olarak daha iyi performansa yol açabileceğini göstermektedir.

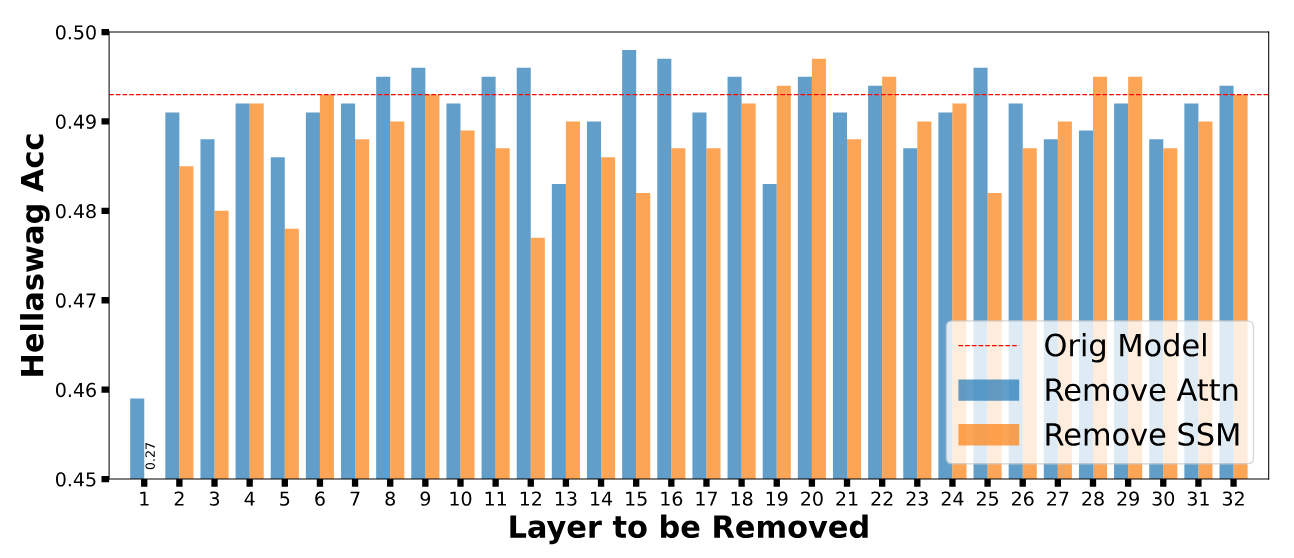

Başlıkların Önemi Analizi

Dikkat ve SSM başlıklarının her katmandaki göreceli önemini analiz ettik. Analizimiz şunları ortaya koymuştur:

- Aynı katmandaki dikkat/SSM başlıklarının göreceli önemi, girişe uyum sağlamakta ve görevler arasında değişkenlik göstermektedir. Bu, farklı girişlerle başa çıkarken farklı roller üstlenebileceklerini öne sürmektedir.

- İlk katmandaki SSM başlığı, dil modellemesi için kritik öneme sahiptir; çıkarıldığında, önemli bir doğruluk kaybı yaşanmaktadır.

- Genel olarak, bir dikkat/SSM başlığını kaldırmak, sırasıyla Hellaswag’da ortalama %0.24/%1.1 doğruluk kaybına neden olmaktadır.

Model Mimarisi ve Eğitim Stratejileri

Bu bölüm, Hymba 1.5B Temel ve Hymba 1.5B Talimat modelleri için önemli mimari kararları ve eğitim metodolojilerini açıklamaktadır.

Model Mimarisi

- Hibrit mimari: Mamba, özetleme konusunda oldukça yeteneklidir ve genellikle mevcut tokena daha yakın odaklanır. Dikkat ise daha hassas olup, kesit bellek işlevi görür. Paralel olarak birleştirilmesi ile bu avantajlar birleştirilmektedir, ancak standart ardışık artırma yapılmamaktadır. SSM ve dikkat başlıkları arasında 5:1 parametre oranı seçilmiştir.

- Sarıp pencere dikkati: Tam dikkat başlıkları, üç katmanda korunmuştur (ilk, son ve ortada), diğer %90 katmanda sarıp pencere dikkat başlıkları kullanılmıştır.

- Çapraz katman KV önbellek paylaşımı: Her iki ardışık dikkat katmanı arasında uygulanmıştır. Bu, başlıklar arasındaki GQA KV önbellek paylaşımına ek olarak gerçekleştirilmiştir.

- Meta-tokenlar: Bu 128 token, denetimsiz öğrenilebilir ve büyük dil modellerinde entropi çöküşü sorunlarına karşı yardımcı olmak ve dikkat sink fenomenini hafifletmeye katkıda bulunur. Ayrıca, genel bilgiyi bu tokenlarda depolayarak işlev görür.

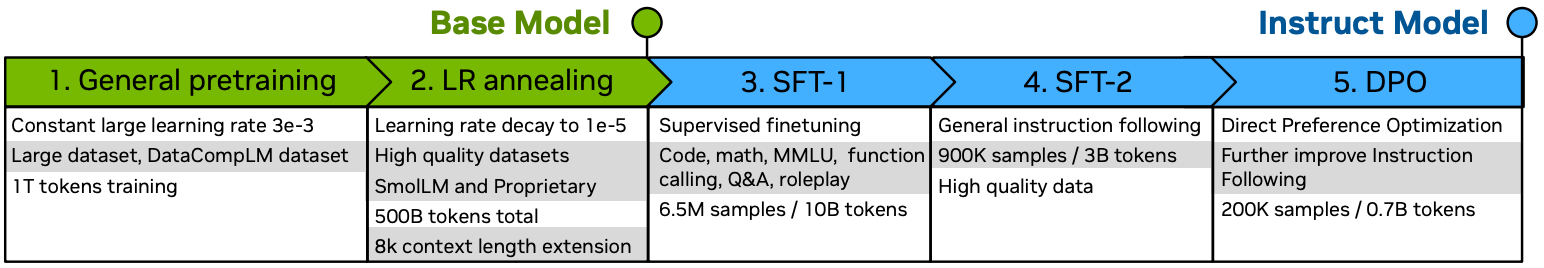

Eğitim Yöntemleri ve İyi Uygulamalar

- Ön eğitim: İki aşamalı temel model eğitimine yöneldik. İlk aşama, büyük bir öğrenme oranını korudu ve filtrelenmiş büyük veri kümesi kullanıldı. Sürekli öğrenme oranı düşürülerek 1e-5’ye ulaşıldı ve yüksek kaliteli veriler kullanılarak devam edildi. Bu yaklaşım, sürekli eğitim ve ilk aşamanın devamını sağlamaktadır.

- Talimatla ince ayar: Talimat modeli ayarlama, üç aşamada gerçekleştirilmiştir. İlk olarak, SFT-1, kod, matematik, işlev çağrısı, rol oynama ve diğer görev odaklı veriler üzerinde eğitim sağlayarak güçlü akıl yürütme yetenekleri kazandırmaktadır. İkinci aşama olan SFT-2, modelin insan talimatlarını takip etmesini öğretmekte ve son aşama olan DPO, modelin insan tercihleri ile uyumlu hale getirilmesine ve güvenliğini artırmasına yardımcı olmaktadır.

Performans ve Verimlilik Değerlendirmesi

Hymba 1.5B modeli sadece 1.5T ön eğitim tokeni ile en iyi küçük LM performansını sergilemekte ve tüm transformer tabanlı LM’lerden daha iyi çıkış hızı ve önbellek verimliliği sağlamaktadır.

Örneğin, en güçlü baz model olan Qwen2.5 ile karşılaştırıldığında, 13 kat daha fazla tokenle ön eğitim almışken, Hymba 1.5B, ortalama %1.55 doğruluk artışı, 1.41x çıkış hızı ve 2.90x önbellek verimliliği elde etmiştir. 2T token eğitim alan en güçlü küçük LM olan h2o-danube2 ile karşılaştırıldığında ise, %5.41 ortalama doğruluk artışı, 2.45x çıkış hızı ve 6.23x önbellek verimliliği sağlanmıştır.

| Model | # Parametre | Token Eğitimi | Token/saniye | Önbellek (MB) | MMLU 5-atış | ARC-E 0-atış | ARC-C 0-atış | PIQA 0-atış | Wino. 0-atış | Hella. 0-atış | SQuAD-C 1-atış | Ortalama |

| Open ELM-1 |

1.1B | 1.5T | 246 | 346 | 27.06 | 62.37 | 19.54 | 74.76 | 61.8 | 48.37 | 45.38 | 48.57 |

| Rene v0.1 |

1.3B | 1.5T | 800 | 113 | 32.94 | 67.05 | 31.06 | 76.49 | 62.75 | 51.16 | 48.36 | 52.83 |

| Phi 1.5 |

1.3B | 0.15T | 241 | 1573 | 42.56 | 76.18 | 44.71 | 76.56 | 72.85 | 48 | 30.09 | 55.85 |

| Smol LM |

1.7B | 1T | 238 | 1573 | 27.06 | 76.47 | 43.43 | 75.79 | 60.93 | 49.58 | 45.81 | 54.15 |

| Cosmo | 1.8B | .2T | 244 | 1573 | 26.1 | 62.42 | 32.94 | 71.76 | 55.8 | 42.9 | 38.51 | 47.2 |

| h20 danube2 |

1.8B | 2T | 271 | 492 | 40.05 | 70.66 | 33.19 | 76.01 | 66.93 | 53.7 | 49.03 | 55.65 |

| Llama3.2 1B | 1.2B | 9T | 535 | 262 | 32.12 | 65.53 | 31.39 | 74.43 | 60.69 | 47.72 | 40.18 | 50.29 |

| Qwen 2.5 |

1.5B | 18T | 469 | 229 | 60.92 | 75.51 | 41.21 | 75.79 | 63.38 | 50.2 | 49.53 | 59.51 |

| AMD OLMo |

1.2B | 1.3T | 387 | 1049 | 26.93 | 65.91 | 31.57 | 74.92 | 61.64 | 47.3 | 33.71 | 48.85 |

| Smol LM2 |

1.7B | 11T | 238 | 1573 | 50.29 | 77.78 | 44.71 | 77.09 | 66.38 | 53.55 | 50.5 | 60.04 |

| Llama 3.2 3B |

3.0B | 9T | 191 | 918 | 56.03 | 74.54 | 42.32 | 76.66 | 69.85 | 55.29 | 43.46 | 59.74 |

| Hymba | 1.5B | 1.5T | 664 | 79 | 51.19 | 76.94 | 45.9 | 77.31 | 66.61 | 53.55 | 55.93 | 61.06 |

Talimatlı Modeller

Hymba 1.5B Talimat modeli, tüm görevlerin ortalamasında en yüksek performansı sergileyerek, önceki en iyi model Qwen 2.5 Talimat modelini %2 oranında geçmiştir. Özellikle, Hymba 1.5B, GSM8K/GPQA/BFCLv2’de sırasıyla 58.76/31.03/46.40 puan alarak diğer modellerin önünde yer almıştır. Bu sonuçlar, Hymba 1.5B’nin özellikle karmaşık akıl yürütme gerektiren alanlarda üstünlüğünü göstermektedir.

| Model | # Parametre | MMLU ↑ | IFEval ↑ | GSM8K ↑ | GPQA ↑ | BFCLv2 ↑ | Ortalama ↑ |

| SmolLM | 1.7B | 27.80 | 25.16 | 1.36 | 25.67 | -* | 20.00 |

| OpenELM | 1.1B | 25.65 | 6.25 | 56.03 | 21.62 | -* | 27.39 |

| Llama 3.2 | 1.2B | 44.41 | 58.92 | 42.99 | 24.11 | 20.27 | 38.14 |

| Qwen2.5 | 1.5B | 59.73 | 46.78 | 56.03 | 30.13 | 43.85 | 47.30 |

| SmolLM2 | 1.7B | 49.11 | 55.06 | 47.68 | 29.24 | 22.83 | 40.78 |

| Hymba 1.5B | 1.5B | 52.79 | 57.14 | 58.76 | 31.03 | 46.40 | 49.22 |

Sonuç

Yeni Hymba ailesi, hibrit başlık yapılandırması ile dikkat başlıklarının yüksek çözünürlüklü hatırlama yeteneklerini ve SSM başlıklarının verimli bağlam özetleme özelliklerini birleştiriyor. Ayrıca, Hymba’nın performansını artırmak için öğrenilebilir meta-tokenlar tanıtılmıştır. Bu, dikkat ve SSM başlıkları için öğrenilmiş bir önbellek işlevi görerek modelin önemli bilgilere odaklanmasına yardımcı olmaktadır. Hymba’nın yol haritası, kapsamlı değerlendirmeler ve ablama çalışmaları ile birlikte, çeşitli görevlerde yeni bir başarılı performans sergileyerek, verimlilikte olduğu kadar doğrulukta da üstün sonuçlar elde etmiştir. Ayrıca, bu çalışma hibrit başlık mimarilerinin avantajlarını öne çıkararak, verimli LM’ler alanında gelecekteki araştırmalar için umut verici bir yön sunmaktadır.

Hymba 1.5B Temel ve Hymba 1.5B Talimat hakkında daha fazla bilgi edinmek için buraya ve buraya göz atabilirsiniz.

Teşekkürler

Bu çalışma, NVIDIA’daki birçok kişinin katkıları olmadan mümkün olmazdı, özellikle Wonmin Byeon, Zijia Chen, Ameya Sunil Mahabaleshwarkar, Shih-Yang Liu, Matthijs Van Keirsbilck, Min-Hung Chen, Yoshi Suhara, Nikolaus Binder, Hanah Zhang, Maksim Khadkevich, Yingyan Celine Lin, Jan Kautz, Pavlo Molchanov ve Nathan Horrocks’a teşekkür ederiz.