Veri Hareketinin Önemi: AI Altyapısında Hız ve Verimlilik

Yapay zeka altyapısında, veriler, işlem motorunu besleyen temel unsurdur. Gelişen özerk AI sistemleri ile birlikte, birden fazla model ve hizmetin etkileşime geçtiği, dış bağlamı çektiği ve gerçek zamanlı kararlar aldığı bu ortamda, işletmeler, büyük miktarda veriyi hızlı, zeki ve güvenilir bir şekilde hareket ettirme zorluğu ile karşı karşıyadır. Modelin sürekli depolamadan yüklenmesi, sorguları desteklemek için bilgiye erişim sağlanması veya özerk araç kullanımının koordine edilmesi gibi işlemlerde veri hareketliliği, AI performansı açısından kritik bir rol oynamaktadır.

North-South ve East-West Ağ İletişimi: Tıkanıklığı Önlemek

GPU’dan GPU’ya (doğu-batı) iletişim uzun zamandır optimizasyonun odağı olmuştur. Ancak, model yükleme, depolama girişi/çıkışı ve çıkarım sorgularını yöneten north-south ağları da kritik öneme sahiptir. Bu tür ağlarda yaşanan performans darboğazları, AI sistemlerinin yanıt verme süresini doğrudan etkileyebilir.

NVIDIA Enterprise Reference Architectures (Kurumsal RA’lar), organizasyonların north-south ağlarını etkin bir şekilde kullanarak AI fabrikaları kurmalarını sağlamaktadır. Bu mimari, organizasyonların ölçeklenebilir, güvenli ve yüksek performanslı AI fabrikaları inşa etmelerine yönelik pratik yollar sunmaktadır. Kurumsal RA’lar, NVIDIA’nın kapsamlı deneyimini eyleme dönüştürerek, sunucu ve ağ yapılandırmalarından yazılım yığınlarına ve operasyonel en iyi uygulamalara kadar ayrıntılı öneriler sunar.

NVIDIA Spectrum-X Ethernet: Verimliliği Artırma

Kurumsal RA’ların birçok bileşeninde, NVIDIA Spectrum-X Ethernet‘in north-south veri akışlarını hızlandırmadaki rolü özellikle dikkat çekicidir. Bu, veri yoğun AI kullanım durumları için NVIDIA BlueField-3 DPU’ları ile birlikte çalışarak önemli faydalar sunmaktadır.

Geleneksel Ethernet depolama ağları, hız, veri akışları ve hızlanmış AI ile HPC iş yükleri için tasarlanmamıştır, bu durum da gecikmelere ve tıkanıklıklara neden olarak performansı olumsuz etkiler. AI modeli, ön eğitim aşamasında ilerlemesini kaydetmek için her checkpoint sırasında büyük veri hacimlerini north-south yolları üzerinden sürekli depolama alanına taşımaktadır. Bu checkpoint dosyaları, günümüzün milyar parametreli modelleri için birkaç terabaytı bulabilmektedir ve sistemler kapandığında ilerlemenin kaybolmamasını sağlar.

Çıkarma iş yükleri de north-south verimliliğine büyük ölçüde bağımlıdır. Bir AI ajanı, örneğin bilgiye dayalı bir çıkarımda bulunurken, dış bağlam çekmek için hızlı ve düşük gecikmeli bir north-south bağlantısına ihtiyaç duyar. İşletmeler, statik tek seferlik çıkarım modelinden dinamik, çok aşamalı, çok ajanlı bir çıkarıma geçtikçe, bu, north-south ağ gereksinimlerini bir kat daha artırmaktadır. Bu durum, ajanların kullanıcılarla, dış kaynaklarla ve bulut hizmetleri ile sürekli etkileşimde bulunarak veri alıp işlediği ve güncellediği bir ortamda gerçekleşmektedir.

NVIDIA Spectrum-X Ethernet kullanarak hızlandırılan veri hareketi ile, bu ağlar kaybı önleyici AI veri depolama ve hareket sistemleri haline gelir. Bu mimari, modern AI iş yüklerinin performans taleplerine uygun bir şekilde optimize edilmiş verilere erişim sağlar ve çağdaş AI iş akışlarının tam potansiyelini ortaya çıkarır.

Birleşik Ağ Yapısı: Kurumsal AI İş Yükleri için Kolaylaştırılmış Temel

Kurumsal AI fabrikaları genellikle belirli bir yapı setini ele almak üzere inşa edilir ve ağlar genellikle 4 ila 16 sunucu düğümü aralığında başlar. Böyle bir ortamda, doğu-batı trafiğini (hesaplama) ve north-south trafiğini (depolama ve dış hizmetler) tek bir anahtar yapısında birleştiren bir birleşik tasarım, operasyonları düzene sokmaya yardımcı olur. Bu tasarım, kablolama ve donanım karmaşasını azaltarak, eğitim, çıkarım ve geri alma iş yükleri boyunca tutarlı yüksek verim sağlar. Ancak, birleşik bir doğu-batı/north-south ağı, her iki trafik türünü desteklemek için yeterli bant genişliği ve hizmet kalitesi (QoS) sunabilen bir ağ önermektedir.

Spectrum-X Ethernet, Kurumsal RA’ların temelinde yer alarak bu noktada önemli bir rol oynamaktadır. İlk olarak doğu-batı GPU’dan GPU’ya ve düğümden düğüme iletişim için optimize edilmişken, north-south ağlarına ve depolama veri yollarına da bant genişliği ve performans avantajları sunmaktadır. Adaptive routing ve telemetry kullanarak tıkanıklığı önler, verimliliği artırır ve AI çalışma süresi ve yoğun veri alma iş yükleri süresince gecikmeyi azaltır.

Spectrum-X Ethernet’in, sanal yönlendirme ve iletim (VRF) hizmet ayrımı ve hizmet kalitesi (QoS) trafik önceliklendirmesi gibi diğer önemli özellikleri de bulunmaktadır. VRF’ler, doğu-batı iletişimini north-south trafiğinden, örneğin kullanıcı giriş veya depolama erişimi gibi, fiziksel ağ ayrımına ihtiyaç duymadan mantıksal olarak ayırmaktadır. QoS, belirli bir trafiğin kullanılabilirliğine göre önceliklendirilmesini sağlamak amacıyla Ethernet çerçevesine veya IP paket başlıklarına etiket ekler (örneğin, depolama trafiği önceliğe göre HTTPS kullanıcı trafiğinden üst sırada yer alır). Bu mekanizmalar, çok sayıda AI ajanı veya iş yükü aynı anda paylaşımda bulunduğunda tutarlı performansı temin eden gürültü izolasyonu gibi gelişmiş özellikler ile pekiştirilmektedir.

Birleşim yapısının kurumsal ölçekli AI fabrikaları için iyi bir seçenek olduğunu vurgulamak önemlidir; ancak bu her duruma uygun bir yaklaşım değildir. NVIDIA Cloud Partners (NCP’ler) gibi büyük ölçekli, çok kiracılı ortamlarda, en yüksek verimli bant genişliğini sağlamak ve kiracılar ile trafik türleri arasında daha sıkı bir izolasyon sağlamak için fiziksel olarak bağlantılı ağları tercih edebilirler. Birleşik ağ yapısı, kurumsal ölçekli kullanımlar, performans ve dedicated AI altyapısının yönetilebilirlik gereksinimleri ile uyumlu bir tasarım tercihi olarak değerlendirilmelidir. Kurumsal RA’lar, belirli kullanım durumları için en uygun ağ mimarisini belirleme görevini, 1k GPU’ya kadar ölçeklenebilen daha büyük dağıtımlara kadar bir dizi talimat sunarak basitleştirir.

NVIDIA Ethernet SuperNIC’lerinin ve BlueField-3 DPU’larının Rolü

AI fabrikalarında ağ trafiğinin nasıl düzenlendiğini anlamak için, NVIDIA Ethernet SuperNIC’leri ve DPU’lar arasındaki farkları belirtmek faydalıdır. NVIDIA SuperNIC’leri, GPU’dan GPU’ya iletişimi yöneten east-west trafiğini işlemek için özel olarak üretilmiştir. Bu, hiperskal AI ortamları için tasarlanmış olup, her biri için saniyede 800 Gb’a kadar bant genişliği sunarak dağıtılmış eğitim ve çıkarım sırasında ultra hızlı veri bağlantısı sağlamaktadır.

BlueField-3 DPU’ları ise north-south trafiğini üstlenmektedir. BlueField-3, depolama yönetimi, veri telemetresi ve ağ güvenliği gibi görevleri ana CPU’dan ayrıştırarak, kıymetli işlem kaynaklarını ana AI işlemleri için serbest bırakır. Etkili bir şekilde bu, AI fabrikası ile dış ekosistem (ağ bağlantılı depolama dahil) arasındaki veri akışının verimli olmasını çevreleyen özel bir bulut altyapı işlemcisidir.

SuperNIC’ler ve BlueField-3 DPU’ları birlikte güçlü bir AI ağ mühendisliği oluşturur. SuperNIC’ler AI fabrikasının iç hesaplamalarını besler ve yönlendirirken, BlueField-3 DPU’ları dış veri akışlarının sorunsuz ve ölçekli bir şekilde gelmesini sağlar. Bu çift yaklaşım, işletmelerin AI altyapılarının tüm katmanlarında performansı optimize etmelerine olanak tanır.

Kurumsal Etki: Vektör Veritabanları ve Gerçek Zamanlı Erişim

North-south ağ trafiğinin bağlı olduğu anlamlı bir örnek, özerk AI ve RAG sistemlerinin artan kabulü ile ortaya çıkmaktadır. Büyük dil modellerini (LLM’ler) dış bilgi ile entegre etmek amacıyla NVIDIA RAG 2.0 Kılavuzu gibi mimariler geliştirilmiştir. RAG Kılavuzu, dış içerikleri gömme, dizinleme ve bu içerikleri vektör veritabanları aracılığıyla çıkarımda daha doğru, bağlamsal olarak daha alakalı yanıtlar sağlamak için NVIDIA NeMo Retriever ve NVIDIA NIM mikro hizmetlerine entegre edilmektedir.

Bir kullanıcı sorgusu gönderdiğinde, LLM, vektör gömülü bir içerik için hızlıca dış depolamada (örneğin, Milvus) sorgulama yapılmasına imkân tanıyan bir vektör gömme işlemi gerçekleştirir. Bu etkileşim, hızlı (düşük gecikmeli) north-south veri akışına dayanır. Sistem, dış bilgiyi daha hızlı alıp entegre edebildiği sürece, yanıtı aynı hızda ve daha hassas bir şekilde oluşturur. Birleşik Spectrum-X Ethernet ağı, bu veri yolunu optimize ederek, modellerin gerçek zamanlı olarak gömülü içerikleri almasını sağlayarak, minimum gecikme ile maksimum verim sağlar.

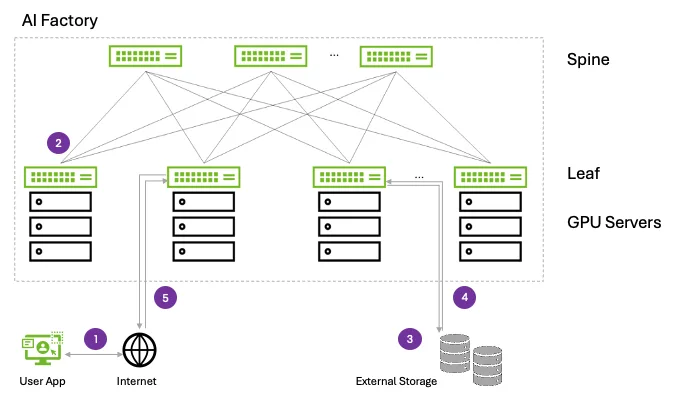

Kullanıcıdan, depolama alanına ve sonra dış dünyaya doğru bir north-south veri akışını inceleyelim:

- Kullanıcı Sorgusu Girişi (kullanıcıdan İnternet’e ve leaf’e): Kullanıcı isteği AI fabrikasına bir giriş geçidi üzerinden akarken, leaf anahtarına ulaşıp kümeye dalar. Kurumsal RA’lar, bu yolu, özellikle dış verilere dayanan uygulamalar için ilk tokene ulaşma süresini (TTFT) azaltacak şekilde Spectrum-X Ethernet ile düzene sokar.

- GPU Sunucusuna Yönlendirme (leaf’ten GPU’ya DPU vasıtasıyla): İstek, leaf anahtarı tarafından GPU düğümüne yönlendirilir ve burada bir BlueField-3 DPU, paket çözümlemesi yaparak, ağ yığınını dışlayarak ve sorguyu doğru çıkarım motoruna (örneğin, NVIDIA NIM) yönlendirir. İstek, leaf-spine Spectrum-X Ethernet ağ anahtarı üzerinden, tıkanıklığı önlemek amacıyla adaptif yönlendirme kullanarak akar. Spectrum-X Ethernet, anahtarın gerçek zamanlı durumu veya kuyruk doluluğuna dayanarak, trafik akışını dinamik olarak yöneterek, trafik sıkışıklıklarını önler.

- Dış Bağlam Elde Etme (sunucudan leaf’e, spine’a ve leaf’ten depolama alanına): Bağlam sorgularında (örneğin, vektör veritabanları) istek, leaf-spine yapısı üzerinden RoCE (Converged Ethernet Üzerinden RDMA) aracılığıyla NVMe tabanlı depolama sistemine akmaktadır. Spectrum-X Ethernet, DDN, VAST Data ve WEKA gibi partner platformlarında veri erişiminde optimize edilmiş performansı ile 1.6 kat daha hızlı depolama performansı sunmaktadır.

- Verilerin GPU’ya Dönmesi (depolamadan leaf’e, spine’a ve leaf’ten sunucuya): İlgili vektörler ve gömülü içerikler, aynı birleşik yapı üzerinden RoCE aracılığıyla geri döner. Spectrum-X Ethernet, bu yolu, tıkanıklık bilinciyle etkin hale getirir, burada DPU paket yeniden sıralamayı yöneterek GPU’nun doğru şekilde beslenmesini sağlar. Özellikle birkaç AI ajanının birden fazla araca yönelik sorgulama yaptığı durumlarda, QoS işaretleri, gecikmeye duyarlı depolama verilerinin önceliklendirilmesini sağlar.

- LLM Çıkarımı ve Son Yanıt (GPU’dan leaf’e ve kullanıcıya): Hem orijinal istem hem de ilgili dış bağlam bellek içerisinde hazır olduğunda, GPU çıkarımı tamamlar. Son yanıt, yukarı yönlü olarak yönlendirilir ve altyapıdan çıkıp kullanıcı uygulamasına döner. VRF tabanlı ağ izolasyonu, depolama, çıkarım ve kullanıcı trafiğinin mantıksal olarak bağımsız kalmasını sağlayarak ölçekle sabit performansı garanti eder.

Birden fazla AI ajanının aynı anda çalıştığı, karmaşık görevleri çözmek için iş birliği yaptığı veya birden fazla kullanıcı sorgusuna hizmet sunduğu ortamlarda etkili north-south ağ trafiği, tıkanıklıkları önleyerek, akıcı ve duyarlı bir sistemi korumaktadır. Bu geri alma süreçlerini hızlandırarak, işletmeler hızlı karar alma ve geliştirilmiş kullanıcı deneyimleri elde etmektedir. İster müşteri destek chatbotları, ister finansal danışmanlık araçları, ister iç bilgi yönetim platformları olsun, özerk AI ve RAG mimarileri, etkili north-south ağlarıyla somut iş değerleri sunmaktadır.

Sonuç olarak, AI iş yükleri artık büyük eğitim kümeleri halinde yalıtılmış ortamlara hapsolmamaktadır. Giderek daha fazla şekilde, günlük kurumsal operasyonların içine entegre olmaktadır, bu durum veritabanları, dış hizmetler ve kullanıcı uygulamalarıyla sorunsuz etkileşim gerektirmektedir. Bu yeni paradigmada, north-south ağları, AI fabrikalarının kahramanları haline gelmektedir. NVIDIA Spectrum-X Ethernet, NVIDIA BlueField ve düşünceli NVIDIA Enterprise RA tabanlı tasarımların birleşimi ile, organizasyonlar AI fabrikalarının dayanıklı, etkili ve AI iş yüklerinin gelişimi için hazır olduğundan emin olabilirler.

Detaylı Bilgi için: